在TensorFlow中实现反卷积(也称为转置卷积或分数步长卷积)是一个涉及多个概念和步骤的过程。反卷积在深度学习领域,特别是在图像分割、图像超分辨率、以及生成模型(如生成对抗网络GANs)等任务中,扮演着重要角色。以下将详细阐述如何在TensorFlow中实现反卷积,包括其理论基础、TensorFlow中的实现方式、以及实际应用中的注意事项。

一、理论基础

1.1 卷积与反卷积的基本概念

- 卷积 :在图像处理中,卷积是一种通过滑动窗口(卷积核)对图像进行局部加权求和的操作,常用于特征提取。卷积操作会导致特征图尺寸减小(如果步长大于1或不进行适当填充)。

- 反卷积 :反卷积并不是卷积的直接逆操作,因为它不能恢复卷积过程中丢失的信息(如绝对位置信息)。然而,反卷积可以通过特定的参数设置(如步长小于输入特征图尺寸),实现特征图尺寸的增加,从而在某些应用场景下模拟“逆卷积”的效果。

1.2 反卷积的实现方式

- 分数步长卷积 :通过设置卷积的步长小于1(在TensorFlow中通常通过插值实现等效效果),可以实现特征图尺寸的增加。

- 转置卷积 :在矩阵运算的视角下,卷积操作可以看作是一个稀疏矩阵与输入特征图的乘积。反卷积则是这个乘积的转置矩阵与输出特征图的乘积,通过调整这个转置矩阵的形状和步长,可以实现上采样效果。

二、TensorFlow中的实现

在TensorFlow中,反卷积通常通过tf.nn.conv2d_transpose函数实现,该函数允许用户指定输出特征图的尺寸、卷积核的大小、步长和填充方式,从而实现反卷积操作。

2.1 函数参数详解

input:输入的特征图,四维张量,形状为[batch_size, height, width, in_channels]。filter:卷积核,四维张量,形状为[height, width, out_channels, in_channels]。output_shape:输出特征图的形状,四维张量,形状为[batch_size, height', width', out_channels]。注意,这里的batch_size可以是-1,表示自动计算。strides:卷积操作的步长,四维列表,通常为[1, stride_height, stride_width, 1]。padding:填充方式,可以是'VALID'或'SAME'。'SAME'表示输出特征图的高度和宽度能被步长整除时,会在边缘进行适当填充以保持尺寸;'VALID'则不进行填充。- 其他参数包括数据格式、卷积核的初始化等,可根据具体需求设置。

2.2 示例代码

import tensorflow as tf

# 假设输入特征图

input_shape = [1, 4, 4, 1] # [batch_size, height, width, in_channels]

input_tensor = tf.random.normal(input_shape)

# 定义卷积核

kernel_shape = [3, 3, 1, 2] # [height, width, in_channels, out_channels]

kernel = tf.random.normal(kernel_shape)

# 设置反卷积参数

strides = [1, 2, 2, 1] # 步长为2,用于上采样

output_shape = [1, 8, 8, 2] # 期望的输出特征图尺寸

# 执行反卷积操作

output_tensor = tf.nn.conv2d_transpose(

input=input_tensor,

filters=kernel,

output_shape=output_shape,

strides=strides,

padding='SAME'

)

print(output_tensor.shape) # 应为(1, 8, 8, 2)

三、实际应用中的注意事项

3.1 棋盘效应

在某些配置下(特别是步长不为1且卷积核大小不是步长的整数倍时),反卷积操作可能会产生明显的棋盘状伪影。这通常是由于卷积核的周期性采样导致的。为了减轻这种效应,可以尝试调整卷积核大小、步长或填充方式。

3.2 参数调整

反卷积的参数调整对于实现高质量的上采样效果至关重要。除了前面提到的步长(strides)和填充(padding)之外,卷积核(filter)的大小和初始化方式也对输出结果的质量有着显著影响。

- 卷积核大小 :卷积核的大小决定了反卷积操作时的感受野大小,进而影响上采样结果的平滑度和细节保留程度。较大的卷积核能够捕获更多的上下文信息,但也可能导致计算量增加和过平滑。相反,较小的卷积核计算效率更高,但可能无法充分恢复细节。

- 初始化方式 :卷积核的初始化方式对于训练过程的稳定性和收敛速度至关重要。在TensorFlow中,可以使用

tf.keras.initializers中的不同初始化器来初始化卷积核,如随机正态分布(RandomNormal)、均匀分布(RandomUniform)或Glorot/He初始化器等。选择合适的初始化器可以帮助模型更快地收敛到较好的解。

3.3 激活函数

在反卷积层之后,通常会跟随一个激活函数来增加模型的非线性。在图像生成和分割任务中,常用的激活函数包括ReLU、LeakyReLU、sigmoid和tanh等。选择合适的激活函数取决于具体任务和模型架构的需求。

- ReLU及其变体 :ReLU(Rectified Linear Unit)及其变体(如LeakyReLU)在大多数深度学习模型中都很常见,因为它们能够加速训练过程并缓解梯度消失问题。然而,在需要输出范围在特定区间(如[0, 1])的任务中,ReLU可能不是最佳选择。

- sigmoid和tanh :sigmoid和tanh激活函数能够将输出限制在特定范围内(sigmoid为[0, 1],tanh为[-1, 1]),这在需要概率输出或归一化输出的任务中非常有用。然而,它们也可能导致梯度消失问题,特别是在深层网络中。

3.4 批量归一化(Batch Normalization)

在反卷积层之后加入批量归一化层可以帮助加速训练过程,提高模型泛化能力,并减少过拟合的风险。批量归一化通过对每个小批量数据的输出进行归一化处理,使得每层的输入数据具有相同的分布,从而加快训练收敛速度。

3.5 实际应用场景

反卷积在多个实际应用场景中发挥着重要作用:

- 图像分割 :在图像分割任务中,反卷积通常用于构建编码器-解码器架构中的解码器部分,以恢复输入图像的空间分辨率并生成分割图。

- 图像超分辨率 :在图像超分辨率任务中,反卷积用于将低分辨率图像上采样到高分辨率,同时保持或增强图像的细节。

- 生成对抗网络(GANs) :在GANs中,生成器通常包含多个反卷积层,用于从随机噪声向量生成逼真的图像。反卷积层帮助生成器逐步增加图像的分辨率和细节。

四、结论

在TensorFlow中实现反卷积是一个涉及多个步骤和参数调整的过程。通过理解反卷积的理论基础、掌握TensorFlow中的实现方式以及注意实际应用中的关键事项,我们可以有效地利用反卷积技术来实现高质量的图像上采样和其他相关任务。未来随着深度学习技术的不断发展,反卷积技术也将继续演进和完善,为更多领域的应用提供有力支持。

-

函数

+关注

关注

3文章

4356浏览量

63368 -

反卷积

+关注

关注

0文章

4浏览量

6313 -

tensorflow

+关注

关注

13文章

329浏览量

60756

发布评论请先 登录

相关推荐

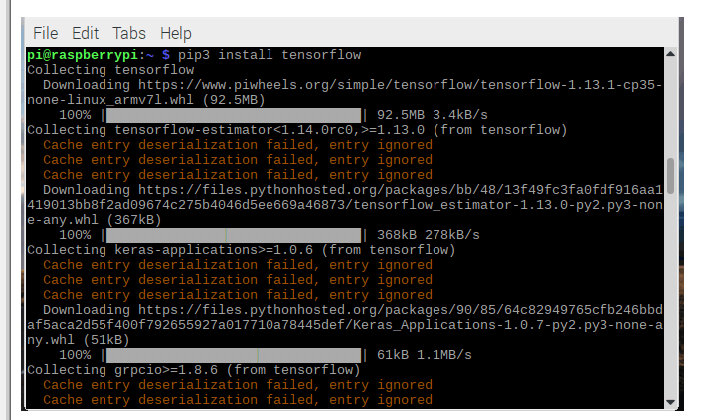

如何在Raspberry Pi上安装TensorFlow

急求用matlab实现卷积的编程

关于对信号的反卷积问题

TensorFlow是什么

反卷积deconvolution引起的棋盘效应及存在的弊端

LED光谱测量值的反卷积

CNN误差反传时旋转卷积核的简明分析

深入理解深度学习中的反(转置)卷积

如何在Tensorflow中实现反卷积

如何在Tensorflow中实现反卷积

评论