构建多层神经网络(MLP, Multi-Layer Perceptron)模型是一个在机器学习和深度学习领域广泛使用的技术,尤其在处理分类和回归问题时。在本文中,我们将深入探讨如何从头开始构建一个多层神经网络模型,包括模型设计、数据预处理、模型训练、评估以及优化等方面的内容。

一、多层神经网络概述

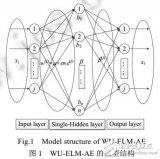

多层神经网络由多个层组成,每一层包含一定数量的神经元(或称节点)。这些层主要分为三类:输入层、隐藏层和输出层。输入层负责接收外部数据,隐藏层负责处理数据(通过非线性变换提取特征),输出层则负责产生最终的预测结果。多层神经网络的强大之处在于其能够学习复杂的数据表示,从而解决复杂的非线性问题。

二、模型设计

在设计多层神经网络模型时,需要考虑以下几个关键因素:

- 层数和每层神经元的数量 :层数越多,模型越复杂,但也可能导致过拟合。每层神经元的数量也应根据问题的复杂性和数据集的大小来合理设定。

- 激活函数 :激活函数用于引入非线性因素,使得神经网络能够解决非线性问题。常用的激活函数包括ReLU、sigmoid和tanh等。

- 损失函数 :损失函数用于衡量模型预测值与真实值之间的差异。对于分类问题,常用交叉熵损失函数;对于回归问题,常用均方误差损失函数。

- 优化算法 :优化算法用于调整模型参数以最小化损失函数。常用的优化算法包括SGD(随机梯度下降)、Adam等。

三、代码实现

以下是一个使用TensorFlow和Keras构建多层神经网络模型的完整Python代码示例。我们将使用MNIST手写数字数据集进行训练和测试。

import tensorflow as tf

from tensorflow.keras import layers, models

from tensorflow.keras.datasets import mnist

from tensorflow.keras.utils import to_categorical

# 加载数据集

(x_train, y_train), (x_test, y_test) = mnist.load_data()

# 数据预处理

x_train, x_test = x_train / 255.0, x_test / 255.0 # 归一化

x_train = x_train.reshape((60000, 28, 28, 1)) # 重塑为(60000, 28, 28, 1)以适配卷积层输入(这里仅为示例,实际为全连接层则无需此步)

x_test = x_test.reshape((10000, 28, 28, 1))

# 对于全连接层,应使用 x_train = x_train.reshape((60000, 28 * 28)) 和 x_test = x_test.reshape((10000, 28 * 28))

y_train = to_categorical(y_train, 10) # 独热编码

y_test = to_categorical(y_test, 10)

# 构建模型

model = models.Sequential()

# 假设我们使用全连接层

model.add(layers.Flatten(input_shape=(28, 28))) # 将图像从二维的(28, 28)转换为一维的(784,)

model.add(layers.Dense(512, activation='relu')) # 第一个隐藏层,512个神经元,ReLU激活函数

model.add(layers.Dropout(0.2)) # Dropout层,减少过拟合

model.add(layers.Dense(128, activation='relu')) # 第二个隐藏层,128个神经元,ReLU激活函数

model.add(layers.Dense(10, activation='softmax')) # 输出层,10个神经元(对应10个类别),softmax激活函数

# 编译模型

model.compile(optimizer='adam',

loss='categorical_crossentropy',

metrics=['accuracy'])

# 训练模型

model.fit(x_train, y_train, epochs=10, batch_size=128, validation_split=0.1)

# 评估模型

test_loss, test_acc = model.evaluate(x_test, y_test)

print(f'Test accuracy: {test_acc:.4f}')

# 使用模型进行预测

predictions = model.predict(x_test)

predicted_classes = np.argmax(predictions, axis=1)

四、模型训练

在上一部分中,我们已经构建了多层神经网络模型并编译了模型。接下来,我们将使用训练数据对模型进行训练,并观察模型在验证集上的表现。

训练过程

在model.fit()函数中,我们指定了训练数据的迭代次数(epochs)、每次迭代中的批量大小(batch_size)以及验证集的比例(validation_split)。训练过程将输出每个epoch的训练损失、验证损失以及训练准确率和验证准确率。

# 训练模型

history = model.fit(x_train, y_train, epochs=10, batch_size=128, validation_split=0.1, verbose=1)

# verbose=1 表示在训练过程中打印进度条

训练过程中的注意事项

- 过拟合与欠拟合 :观察训练损失和验证损失的变化趋势。如果训练损失持续下降而验证损失在某个点后开始上升,这通常意味着模型开始过拟合。此时,可以考虑增加Dropout层、减小模型复杂度或引入正则化技术。相反,如果训练损失和验证损失都很高且不再下降,则可能是欠拟合,此时需要增加模型复杂度或提供更多训练数据。

- 学习率调整 :学习率是优化算法中的一个重要参数,它决定了参数更新的步长。如果学习率太高,可能会导致训练过程不稳定;如果学习率太低,则训练过程可能过于缓慢。可以使用学习率调度器(如

ReduceLROnPlateau)在训练过程中自动调整学习率。 - 批量大小 :批量大小对训练速度和模型性能都有影响。较小的批量大小可能导致训练过程更加不稳定,但有助于模型跳出局部最优解;较大的批量大小则可能加速训练过程,但可能导致内存不足。

五、模型评估

训练完成后,我们需要使用测试集对模型进行评估,以了解模型在未见过的数据上的表现。

# 评估模型

test_loss, test_acc = model.evaluate(x_test, y_test)

print(f'Test accuracy: {test_acc:.4f}')

除了准确率之外,我们还可以使用混淆矩阵来更详细地评估模型性能。混淆矩阵可以展示模型在每个类别上的预测情况,包括真正例(TP)、假正例(FP)、真反例(TN)和假反例(FN)。

from sklearn.metrics import confusion_matrix

# 预测测试集

predictions = model.predict(x_test)

predicted_classes = np.argmax(predictions, axis=1)

# 计算混淆矩阵

cm = confusion_matrix(y_test.argmax(axis=1), predicted_classes)

print(cm)

六、模型优化

在实际应用中,我们通常需要对模型进行多次迭代优化,以提高其性能。以下是一些常见的优化策略:

- 调整模型架构 :尝试不同的层数、每层神经元的数量以及不同类型的层(如卷积层、池化层等)。

- 使用正则化技术 :如L1/L2正则化、Dropout等,以减少过拟合。

- 数据增强 :通过旋转、缩放、平移等方式增加训练数据的多样性,提高模型的泛化能力。

- 集成学习 :将多个模型的预测结果结合起来,以提高整体性能。

七、模型部署与应用

在模型训练和优化完成后,我们需要将其部署到实际应用中。这通常涉及以下几个步骤:

- 模型转换 :将训练好的模型转换为适合部署的格式,如TensorFlow SavedModel、ONNX等。

- 模型部署 :将模型部署到服务器、边缘设备或云平台上,以便进行实时预测。

- 性能监控 :对部署后的模型进行性能监控,包括响应时间、准确率等指标的跟踪。

- 反馈循环 :收集用户反馈,并根据反馈对模型进行持续优化和改进。

当然,我们可以继续深入探讨多层神经网络模型的扩展功能,包括数据增强的实际应用、模型的保存与加载、以及进一步的模型优化和调整。

数据增强的实际应用

虽然上文中提到了ImageDataGenerator用于数据增强的概念,但实际上,在训练多层神经网络时,我们通常会将数据增强集成到训练循环中。以下是一个使用ImageDataGenerator和flow方法在训练过程中实时应用数据增强的示例:

# 假设我们仍然使用MNIST数据集,但这次我们将数据重塑为图像格式

x_train = x_train.reshape((60000, 28, 28, 1)).astype('float32')

x_test = x_test.reshape((10000, 28, 28, 1)).astype('float32')

# 创建数据增强生成器

datagen = ImageDataGenerator(

rotation_range=10, # 随机旋转图片

width_shift_range=0.1, # 随机水平平移

height_shift_range=0.1, # 随机垂直平移

zoom_range=0.1 # 随机缩放

)

# 注意:ImageDataGenerator的flow方法用于生成批量的增强数据

# 这里我们仅为示例,实际训练时应使用fit_generator或fit(TensorFlow 2.x中推荐使用fit配合tf.data)

train_generator = datagen.flow(x_train, y_train, batch_size=32)

# 在模型训练时,我们可以使用train_generator作为输入

# model.fit(train_generator, epochs=10, steps_per_epoch=len(x_train) // 32)

# 注意:上面的fit调用是伪代码,实际中可能需要调整以匹配TensorFlow版本和API

# TensorFlow 2.x推荐使用tf.data进行更灵活的数据处理

# 这里不展开tf.data的详细使用,但它是处理复杂数据管道的强大工具

模型的保存与加载

在训练完模型后,我们通常希望将其保存下来以便将来使用或进一步分析。TensorFlow提供了多种保存和加载模型的方法。

保存模型

# 保存整个模型(包括架构、权重和优化器状态)

model.save('my_model.h5')

# 或者,仅保存模型架构(无权重)

model_json = model.to_json()

with open("model_architecture.json", "w") as json_file:

json_file.write(model_json)

# 保存权重

model.save_weights('my_model_weights.h5')

加载模型

# 加载整个模型

loaded_model = models.load_model('my_model.h5')

# 仅加载模型架构并加载权重

model_arch = models.model_from_json(open("model_architecture.json").read())

model_arch.load_weights('my_model_weights.h5')

进一步的模型优化和调整

在模型部署之前,我们可能还需要进行一系列的优化和调整,以确保模型在实际应用中的性能。

- 超参数调优 :使用网格搜索(Grid Search)、随机搜索(Random Search)或贝叶斯优化(Bayesian Optimization)等技术来找到最优的超参数组合(如学习率、批量大小、层数、神经元数量等)。

- 模型剪枝 :移除模型中的冗余参数或层,以减少模型大小和推理时间,同时尽量保持模型性能。

- 量化 :将模型的权重和激活从浮点数转换为整数,以减少模型大小和加快推理速度,同时可能引入一些精度损失。

- 集成学习 :通过组合多个模型的预测结果来提高整体性能。常见的集成方法包括投票(Voting)、堆叠(Stacking)和装袋(Bagging)等。

- 硬件加速 :利用GPU、TPU等硬件加速技术来加速模型的训练和推理过程。

结论

构建多层神经网络模型是一个涉及多个步骤和考虑因素的过程。从模型设计、数据预处理、模型训练到评估和优化,每一步都需要仔细考虑和不断迭代。通过合理利用TensorFlow等深度学习框架提供的工具和技术,我们可以构建出高效、准确的神经网络模型,并将其应用于各种实际场景中。希望本文的内容能够为您在多层神经网络模型的构建和优化过程中提供一些帮助和启示。

-

神经网络

+关注

关注

42文章

4772浏览量

100793 -

机器学习

+关注

关注

66文章

8419浏览量

132675 -

深度学习

+关注

关注

73文章

5503浏览量

121185

发布评论请先 登录

相关推荐

【产品活动】阿里云GPU云服务器年付5折!阿里云异构计算助推行业发展!

卷积神经网络如何使用

【案例分享】ART神经网络与SOM神经网络

如何设计BP神经网络图像压缩算法?

深度神经网络是什么

如何构建神经网络?

拉普拉斯多层极速学习机

如何构建多层神经网络

如何构建多层神经网络

评论