今日,在 PerfXCloud 重磅更新支持 llama 3.1 之后,其平台再度实现重大升级!目前,已顺利接入被誉为全球最强的 MOE 大模型DeepSeek-V2,已在 PerfXCloud(澎峰云)官网的体验中心对平台用户免费开放体验。

DeepSeek-V2

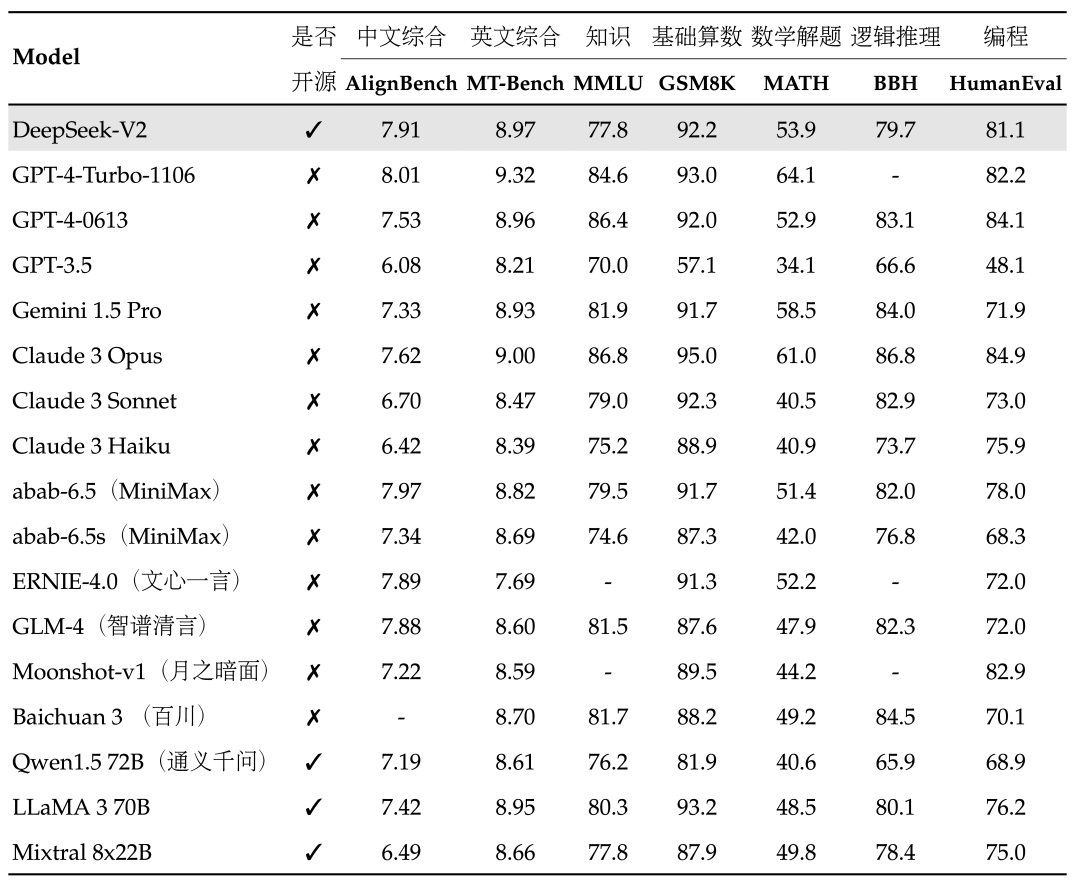

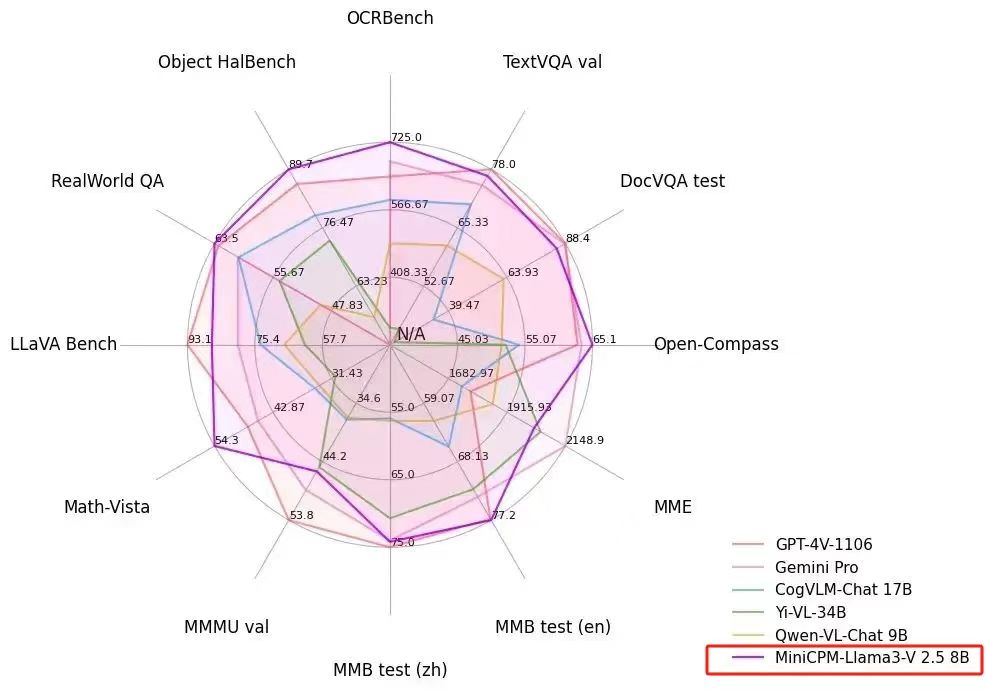

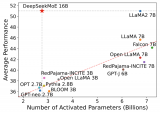

DeepSeek-V2是强大的专家混合(MOE)语言模型,在目前大模型主流榜单中,DeepSeek-V2 综合能力表现出色:

中文综合能力(AlignBench)开源模型中最强,与GPT-4-Turbo,文心4.0等闭源模型在评测中处于同一梯队

英文综合能力(MT-Bench)与最强的开源模型LLaMA3-70B同处第一梯队,超过最强MOE开源模型Mixtral 8x22B

知识、数学、推理、编程等榜单结果也位居前列

支持128K上下文窗口

PerfXCloud

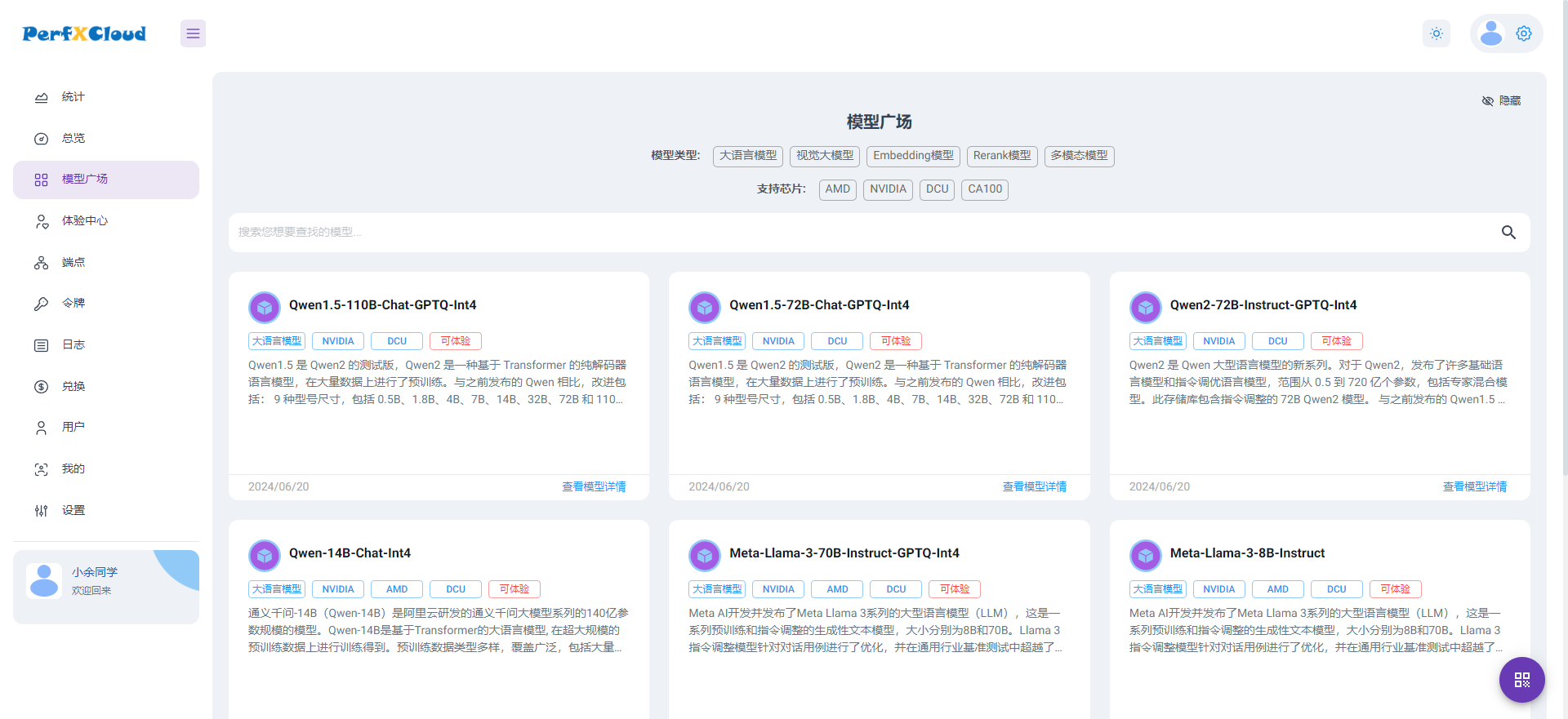

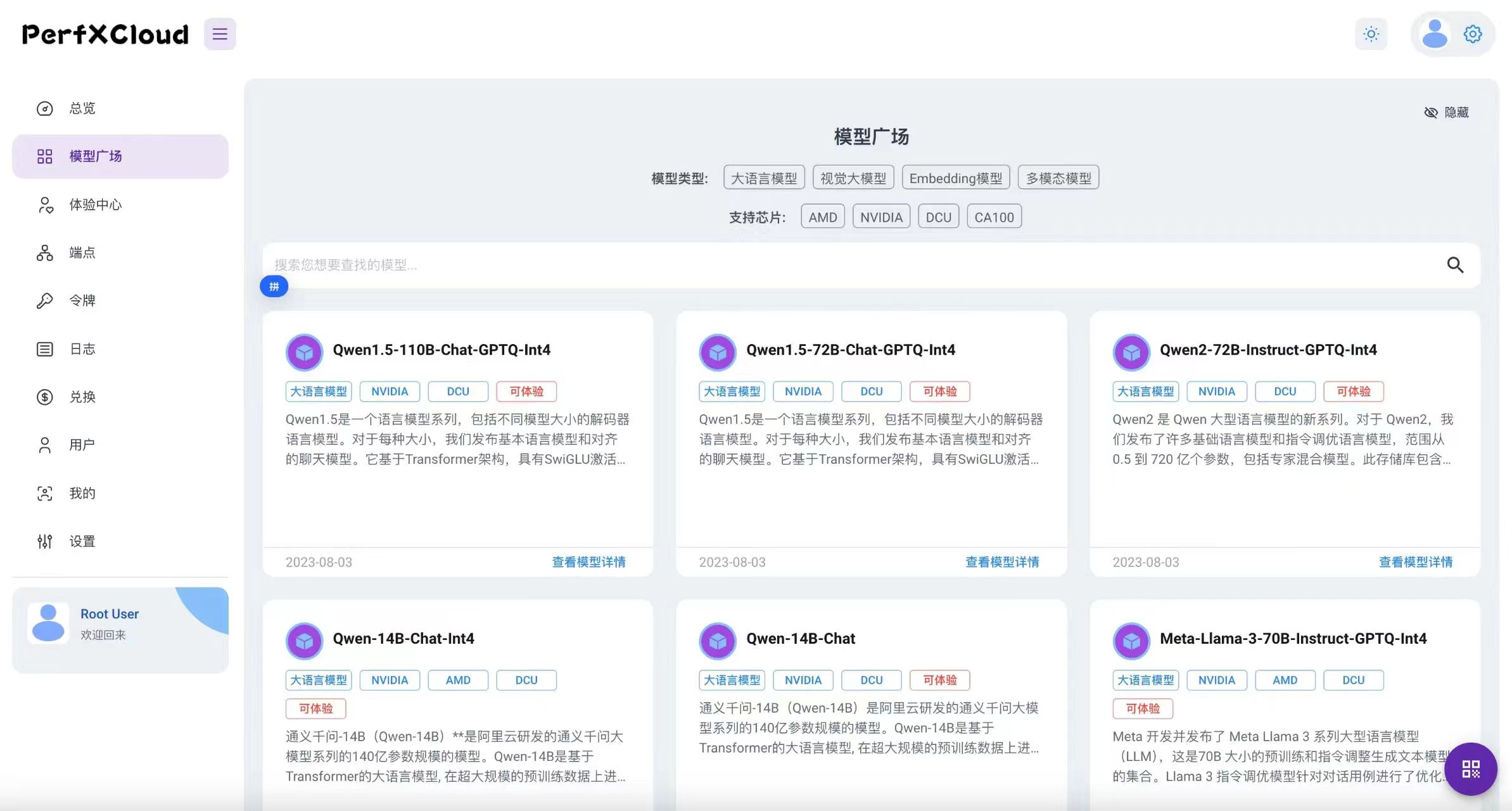

PerfXCloud是澎峰科技为开发者和企业量身打造的AI开发和部署平台。它专注于满足大模型的微调和推理需求,为用户提供极致便捷的一键部署体验。

PerfXCloud为算力中心提供大模型AI科学与工程计算的整体运营解决方案,助力算力中心升级成为“AI超级工厂”

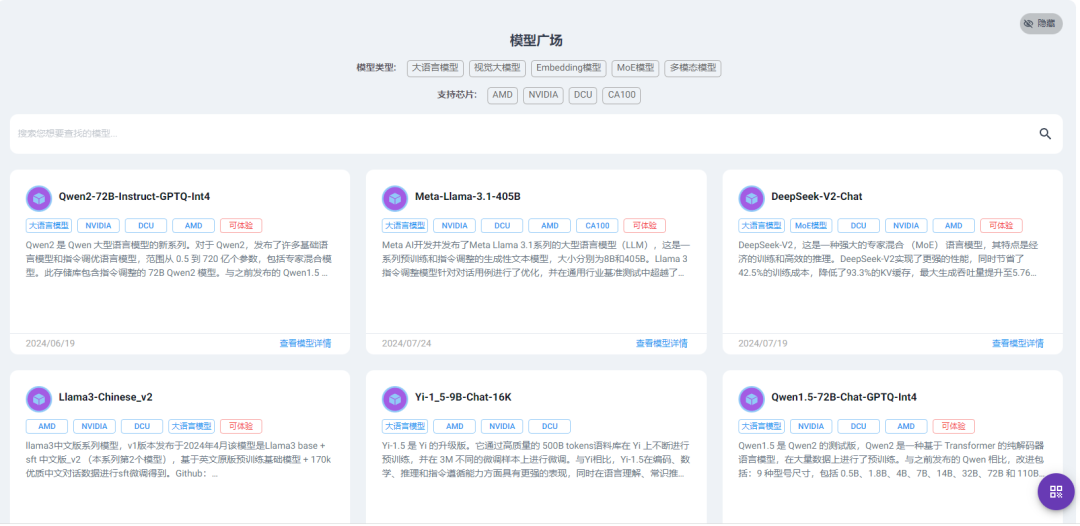

PerfXCloud模型广场

PerfXCloud介绍 目前,PerfXCloud(澎峰云)已面向基石用户免费开放DeepSeek-V2236B的API调用接口。赶快注册申请成为基石用户来体验吧!

-

开源

+关注

关注

3文章

3358浏览量

42516 -

语言模型

+关注

关注

0文章

526浏览量

10277 -

大模型

+关注

关注

2文章

2465浏览量

2749

原文标题:PerfXCloud 再度升级,免费开放体验全球顶尖 MOE 大模型 DeepSeek-V2 236B!

文章出处:【微信号:perfxlab,微信公众号:perfxlab】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

雷军千万年薪挖角95后AI天才少女 DeepSeek开源大模型DeepSeek-V2关键开发者之一罗福莉

猎户星空发布Orion-MoE 8×7B大模型及AI数据宝AirDS

腾讯发布开源MoE大语言模型Hunyuan-Large

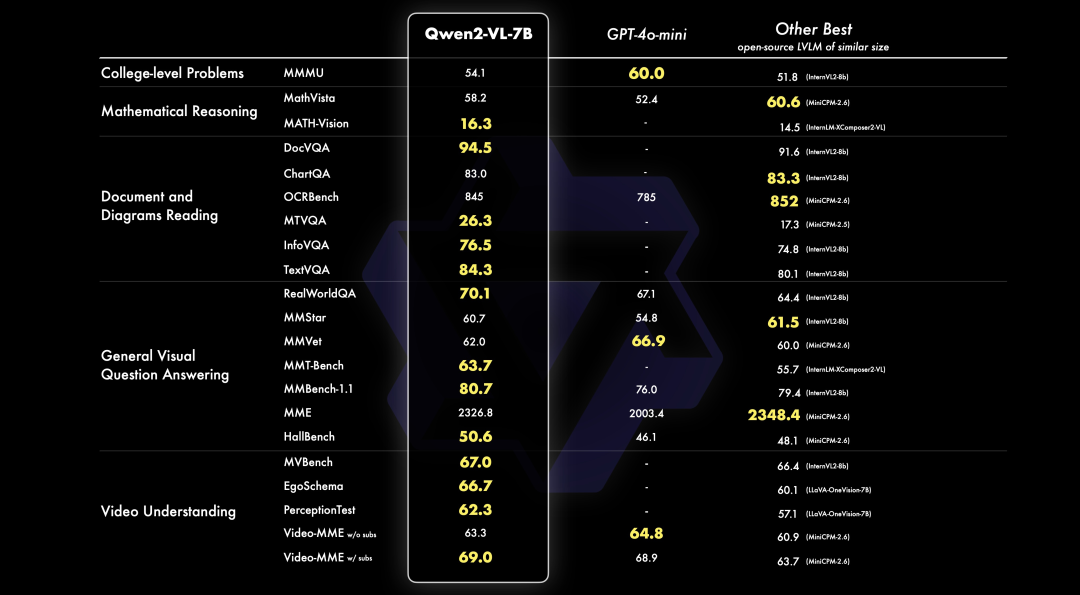

PerfXCloud重磅升级 阿里开源最强视觉语言模型Qwen2-VL-7B强势上线!

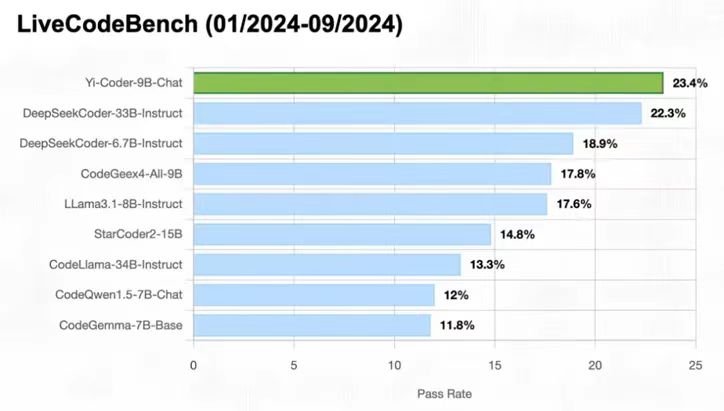

零一万物正式开源Yi-Coder系列模型 PerfXCloud火速支持等你体验!

PerfXCloud 重大更新 端侧多模态模型 MiniCPM-Llama3-V 2.5 闪亮上架

PerfXCloud平台成功接入Meta Llama3.1

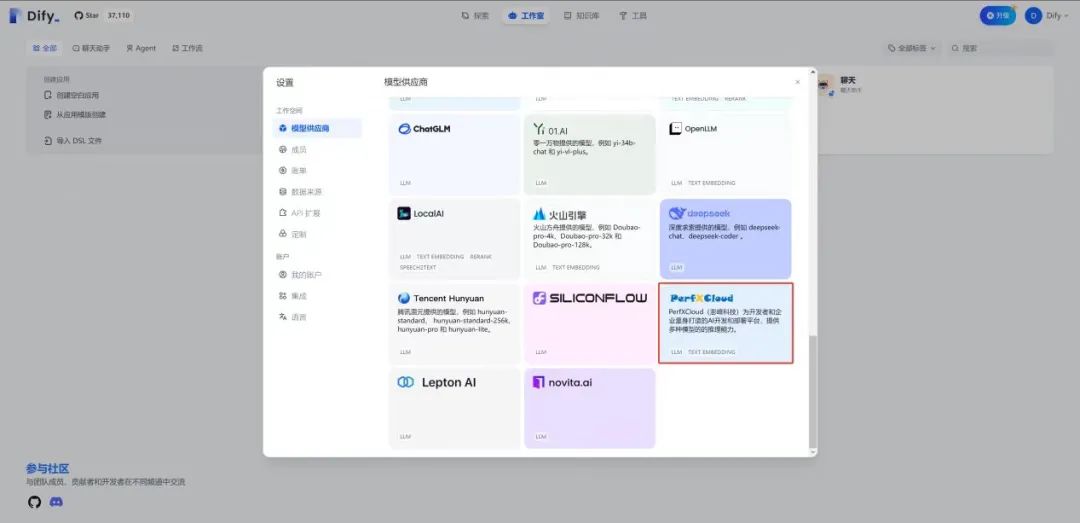

在Dify中使用PerfXCloud大模型推理服务

PerfXCloud大模型开发与部署平台开放注册

昆仑万维开源2千亿稀疏大模型Skywork-MoE

基于NVIDIA Megatron Core的MOE LLM实现和训练优化

昆仑万维发布新版MoE大语言模型天工2.0

对标OpenAI GPT-4,MiniMax国内首个MoE大语言模型全量上线

PerfXCloud顺利接入MOE大模型DeepSeek-V2

PerfXCloud顺利接入MOE大模型DeepSeek-V2

评论