由 NVIDIA RTX 和 GeForce RTX 技术驱动的 AI PC 时代已经到来。在这一背景下,一种评估 AI 加速性能的新方法应运而生,同时还带来了一套新术语,这套术语成了用户选择台式电脑和笔记本电脑的参考标准。

虽然 PC 游戏玩家了解每秒帧数(FPS)及类似的统计数据,但衡量 AI 性能需要新的指标。

TOPS 脱颖而出

TOPS,即每秒万亿次运算是首要的基准指标。“万亿”是这里的关键词:生成式 AI 任务背后的处理运算量是巨大的。您可以将 TOPS 视为原始性能指标,类似于发动机的额定功率。这个数值自然是越大越好。

例如,比较一下微软最近发布的 Windows 11 AI PC,其中就包含每秒至少可执行 40 万亿次运算的神经处理单元(NPU)。40 TOPS 的算力足以胜任一些轻量级 AI 辅助任务,例如询问本地聊天机器人昨天的笔记在哪里。

但许多生成式 AI 的算力需求远不止于此。NVIDIA RTX 和 GeForce RTX GPU 可在所有生成式任务中提供卓越的性能,其中 GeForce RTX 4090 GPU 的算力可达 1177 TOPS。这就是处理 AI 辅助数字内容创作(DCC)、PC 游戏 AI 超分辨率、根据文本或视频生成图像、与本地大语言模型(LLM)交互等任务所需的算力。

以 Token 衡量性能

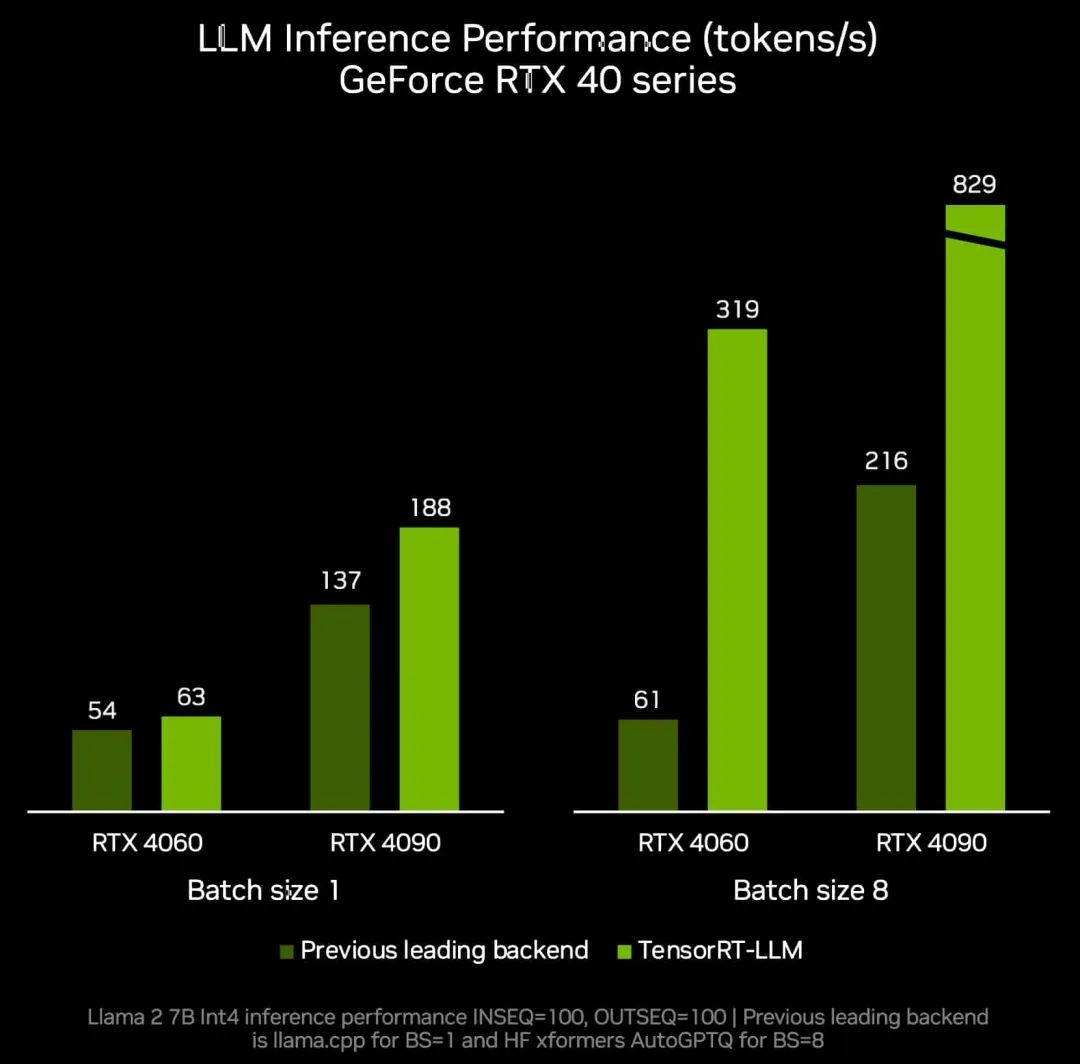

TOPS 只是一项基础衡量指标。LLM 的性能以模型生成的 Token 数量来衡量。

Token 是 LLM 的输出,它可以是句子中的一个词,甚至可以是标点符号或空格这类更小的片段。AI 加速任务的性能可以用“每秒 Token 数”来衡量。

另一个重要因素则是 batch size,也就是在一次推理过程中可同时处理的输入数量。由于大语言模型(LLM)是许多现代 AI 系统的核心,处理多个输入(例如来自单个应用或跨多个应用)的能力将成为关键的差异化因素。虽然较大的 batch size 可以提升并发输入的性能,但也需要占用更多的内存,尤其是运行较大的模型时。

RTX GPU 非常适合 LLM,因为它们拥有大量专用的显存(VRAM)、Tensor Core 和 TensorRT-LLM 软件。

GeForce RTX GPU 最多可提供 24GB 的高速 VRAM,而 NVIDIA RTX GPU 最多可提供 48GB 的高速 VRAM,可支持更大的模型和更大的 batch size。RTX GPU 还可利用 Tensor Core,这是一种专用的 AI 加速器,可显著加速深度学习和生成式 AI 模型中的计算密集型运算。应用在使用 NVIDIA TensorRT 软件开发套件(SDK)的情况下可轻松实现超高性能。该套件可在超过 1 亿台由 RTX GPU 驱动的 Windows PC 和工作站上解锁超高性能生成式 AI。

结合了大显存、专用 AI 加速器和优化的软件,RTX GPU 的吞吐量得到了巨大提升,尤其是在 batch size 增加的情况下。

文本生图像,速度超以往

测量图像生成速度是评估性能的另一种方法。最直接的一个方法是使用 Stable Diffusion,这是一种基于图像的热门 AI 模型,可让用户轻松地将文本描述转换为复杂的视觉画面。

借由 Stable Diffusion,用户可以通过输入关键词快速获得想要的图像相比于 CPU 或 NPU,使用 RTX GPU 运行 AI 模型时可以更快生成所需结果。

在热门的 Automatic1111 界面使用 TensorRT 扩展程序时,相应性能表现甚至会更好。借助 SDXL 模型,RTX 用户通过提示生成图像的速度至多可提升至原来的 2 倍,这可大幅简化 Stable Diffusion 工作流。

另一个热门的 Stable Diffusion 用户界面 ComfyUI 在上周也支持了 TensorRT 加速。现在,RTX 用户文生图的速度可提升多达 60%。RTX 用户还可使用 Stable Video Diffusion 将这些图像转换为视频,在 TensorRT 的助力下,转换速度甚至可提升多达 70%。

全新的 UL Procyon AI 图像生成基准测试现已支持 TensorRT 加速。与最快的非 TensorRT 加速状态相比,TensorRT 加速可在 GeForce RTX 4080 SUPER GPU 上带来 50% 的速度提升。

适用于 Stable Diffusion 3 的 TensorRT 加速近期发布,前者是 Stability AI 备受期待的全新文本转图像模型。此外,全新的 TensorRT-Model Optimizer 可进一步提升性能。与非 TensorRT 加速状态相比,它可带来显著的速度提升,同时减少显存消耗。

当然,眼见方能为实。真正的考验来自于不断迭代提示词这种真实场景。在 RTX GPU 上,用户通过改进提示词来优化图像的速度可得到显著提升,每次迭代只需数秒即可完成。而在 Macbook Pro M3 Max 上,完成相同的迭代需要耗费数分钟。此外,如果在由 RTX 驱动的 PC 或工作站上本地运行,用户可以同时享受到速度和安全性方面的优势,并让所有内容保持私密。

测试结果出炉,相关技术开源

不过,且不要仅听我们的一面之词。开源的 Jan.ai 背后的 AI 研究人员和工程师团队最近将 TensorRT-LLM 集成到了其本地聊天机器人应用中,然后亲自测试了这些优化效果。

研究人员在社区使用的各种 GPU 和 CPU 上,以开源的 llama.cpp 推理引擎为对照,测试了 TensorRT-LLM 的实际表现。他们发现 TensorRT“在相同硬件上比 llama.cpp 快 30-70%”,并且在进行连续处理时效率更高。该团队还提供了测试方法,邀请其他人亲自测试生成式 AI 的性能。

无论是游戏还是生成式 AI,速度才是其致胜法宝。在确定性能冠军时,TOPS、每秒 Token 数和 batch size 均需纳入考量。

-

NVIDIA

+关注

关注

14文章

4792浏览量

102414 -

PC

+关注

关注

9文章

2028浏览量

153517 -

内存

+关注

关注

8文章

2901浏览量

73509 -

AI

+关注

关注

87文章

28791浏览量

266101

原文标题:解码 RTX AI PC 和工作站上的 AI 性能

文章出处:【微信号:NVIDIA_China,微信公众号:NVIDIA英伟达】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

NVIDIA RTX AI套件简化AI驱动的应用开发

宁畅推出自驱式相变液冷AI工作站

AMD Radeon PRO W7900双槽工作站显卡发布上市

技嘉推出全新AMD Radeon PRO W7000系列工作站显卡

AI PC:真正的AI PC,敢于下场

宁畅推出首款专业级AI桌面工作站W350 G50

技嘉科技与英伟达携手打造全新高阶RTX AI PC体验

NVIDIA推出用于支持在全新GeForce RTX AI笔记本电脑上运行的AI助手及数字人

惠普推出多款商用AI PC新品

全新NVIDIA RTX A400和A1000 GPU全面加强AI设计与生产力工作流

惠普推出新一代AI游戏本,并计划推出首个AI PC本地AI解决方案

全面解析CPU和工作站的大比拼

点亮未来:TensorRT-LLM 更新加速 AI 推理性能,支持在 RTX 驱动的 Windows PC 上运行新模型

RTX AI PC和工作站提供强大AI性能

RTX AI PC和工作站提供强大AI性能

评论