来源: NVIDIA

在此次大会期间举行的四场演讲中,NVIDIA 工程师详细介绍了 NVIDIA Blackwell 平台、新的液冷研究成果以及支持芯片设计的 AI 代理。

作为面向产业界和学术界、在处理器及系统架构师领域的深度技术盛会,Hot Chips 已经成为价值万亿美元的数据中心计算市场的一个重要论坛。

在本周举行的 Hot Chips 2024 上,NVIDIA 的高级工程师们展示了为 NVIDIA Blackwell 平台提供动力的最新技术进展,以及新的数据中心液冷研究成果和用于芯片设计的 AI 代理。

他们围绕如下内容展开了介绍:

NVIDIA Blackwell 集合了多种芯片、系统和 NVIDIA CUDA 软件,为跨应用场景、行业和国家的新一代 AI 提供动力。

NVIDIA GB200 NVL72——一个多节点、液冷、机架级扩展解决方案,可连接72个Blackwell GPU 和36个 Grace CPU——提升了AI系统设计的标准。

NVLink 互连技术提供多对多 GPU 间的通信,为生成式 AI 实现创纪录的高吞吐量和低延迟推理。

NVIDIA Quasar 量化系统突破物理极限,加速 AI 计算。

NVIDIA 研究人员正在构建 AI 模型,此模型将协助打造用于 AI 的处理器。

在一场关于 NVIDIA Blackwell 的演讲中,重点介绍了新架构的细节以及在 Blackwell 芯片上运行的生成式 AI 模型的示例。

另外的三场讲座,内容涵盖混合液冷解决方案如何帮助数据中心过渡到能效更高的基础设施,以及包括大语言模型驱动的 AI 代理在内的模型如何帮助工程师设计下一代处理器。

这些演讲共同展示了 NVIDIA 工程师们在数据中心计算和设计的每一个领域都在进行创新,以提供前所未有的性能、能效和优化。

为 Blackwell 做好准备

NVIDIA Blackwell 是全栈计算的极限挑战。它由多个 NVIDIA 芯片组成,包括 Blackwell GPU、Grace CPU、BlueField 数据处理器、ConnectX 智能网卡、NVLink Switch、Spectrum 以太网交换机和 Quantum InfiniBand 交换机。

NVIDIA 架构总监 Ajay Tirumala 和 Raymond Wong 现场首次展示了该平台,并解释了这些技术是如何协同配合,在提高能效的同时为 AI 和加速计算的性能确立新的标准。

多节点 NVIDIA GB200 NVL72 解决方案正是一个恰如其分的例子。LLM 推理需要低延迟、高吞吐量的 token 生成。GB200 NVL72 作为一个统一的系统,为 LLM 工作负载提供最多至 30 倍的推理速度提升,使得实时运行万亿参数模型成为可能。

Tirumala 和 Wong 还探讨了 NVIDIA Quasar 量化系统如何在低精度模型上实现高准确度,并重点介绍了使用 LLM 和视觉生成式 AI 的例子。NVIDIA Quasar 量化系统结合了算法创新、NVIDIA 软件库和工具以及 Blackwell 的第二代 Transformer 引擎。

让数据中心保持“凉爽”

通过风冷和液冷结合的混合冷却,研究人员开发出了更高效和可持续的解决方案,有望让传统风冷数据中心的嗡嗡作响成为历史。

与风冷技术相比,液冷技术能够更高效地为系统散热,从而使计算系统即使在处理大型工作负载时也更容易保持低温状态。液冷设备也比风冷系统占用更少的空间,耗电量更低,从而使数据中心可以在其设施中添加更多服务器机架,以增加更多算力。

NVIDIA 数据中心冷却和基础设施总监 Ali Heydari 介绍了几种混合冷却数据中心的设计方案。

有些设计方案利用液冷单元改造现有的风冷数据中心,为现有机架增加液冷功能提供了一种快速、便捷的解决方案。其它设计方案则需要使用冷却液分配单元,安装管道以直接对芯片进行液体冷却,或者将服务器完全浸入到冷却水箱中。尽管这些设计需要较大的前期投资,但却能够大幅降低能耗和运营成本。

Heydari 还介绍了其团队在 COOLERCHIPS 项目中的工作,这个项目旨在开发先进的数据中心冷却技术。作为该项目的一部分,Heydari 的团队正在使用 NVIDIA Omniverse 平台来创建基于物理的数字孪生,这将帮助他们对能耗和冷却效率进行建模,以优化数据中心设计。

AI 代理助力处理器设计

半导体设计在微观尺度上是一个巨大的挑战。开发尖端处理器的工程师们努力在一个几英寸大的芯片上装进尽可能多的算力,测试物理上可以实现的极限。

通过提高设计质量和生产力、提高人工流程的效率以及自动化处理一些耗时的任务,AI 模型正在为工程师们的工作提供支持。这些模型包括帮助工程师快速分析和改进设计的预测和优化工具,以及可以帮助解答工程师的问题、生成代码、调试设计问题等的 LLM。

NVIDIA 设计自动化研究总监 Mark Ren 在一场讲座中对上述这些模型及其应用进行了总体介绍。在另一场会议中,他还重点介绍了用于芯片设计的基于 AI 代理的系统。

由 LLM 驱动的 AI 代理可以被引导自主完成任务,从而在各行各业解锁广泛的应用。在微处理器设计方面,NVIDIA 研究人员正在开发基于代理的系统,这种系统可以使用定制的电路设计工具进行推理和采取行动,与经验丰富的设计师互动,并从人类和代理积累的经验的数据库中学习。

NVIDIA 专家们不仅正在打造这项技术,也在使用它。Mark Ren 分享了几个例子,包括工程师如何将 AI 代理用于时序报告分析、单元集群优化流程和代码生成。在第一届 IEEE 大语言模型辅助设计国际研讨会(LAD'24)上,这项单元集群优化工作荣膺最佳论文。

【近期会议】

10月30-31日,由宽禁带半导体国家工程研究中心主办的“化合物半导体先进技术及应用大会”将首次与大家在江苏·常州相见,邀您齐聚常州新城希尔顿酒店,解耦产业链市场布局!https://w.lwc.cn/s/uueAru

11月28-29日,“第二届半导体先进封测产业技术创新大会”将再次与各位相见于厦门,秉承“延续去年,创新今年”的思想,仍将由云天半导体与厦门大学联合主办,雅时国际商讯承办,邀您齐聚厦门·海沧融信华邑酒店共探行业发展!诚邀您报名参会:https://w.lwc.cn/s/n6FFne

声明:本网站部分文章转载自网络,转发仅为更大范围传播。 转载文章版权归原作者所有,如有异议,请联系我们修改或删除。联系邮箱:viviz@actintl.com.hk, 电话:0755-25988573

审核编辑 黄宇

-

NVIDIA

+关注

关注

14文章

5107浏览量

104461 -

数据中心

+关注

关注

16文章

4956浏览量

72674

发布评论请先 登录

相关推荐

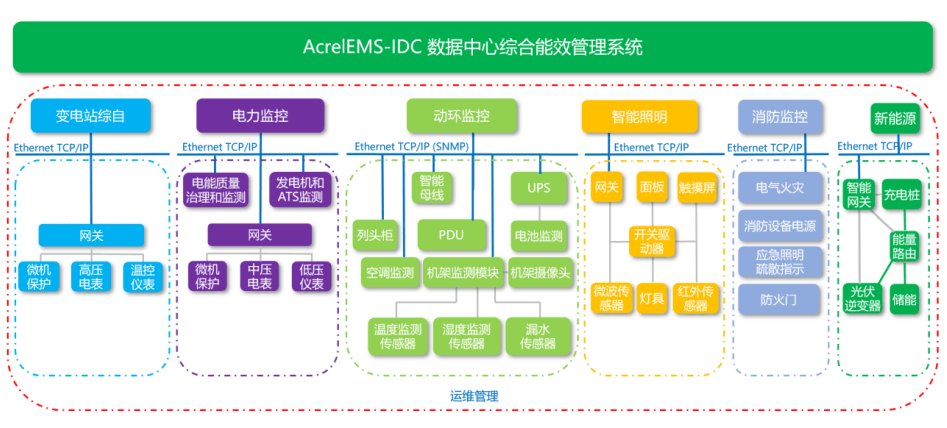

安科瑞:以综合能效管理解决方案,赋能人工智能时代的数据中心可持续发展

亚马逊云科技推出全新数据中心组件,支持AI创新并进一步提升能效

超云亮相2024数据中心标准大会,展示AI全栈推理硬件创新成果

NVIDIA 在 Hot Chips 大会展示提升数据中心性能和能效的创新技术

NVIDIA 在 Hot Chips 大会展示提升数据中心性能和能效的创新技术

评论