如今,安全大模型正在为网络安全行业带来深度变革,在网络安全分析、威胁检测、智能策略制定等方面扮演着重要角色。推动大模型在安全场景落地,不仅需要基于安全领域知识,训练和微调出高质量的安全大模型,还需要面临在用户侧部署所需的性能、成本和灵活性挑战。然而,安全大模型有着巨大的参数规模以及复杂的事务处理逻辑,这对算力也提出了新的需求。

01恒脑 • 安全垂域大模型系统

杭州安恒信息技术股份有限公司(简称:安恒信息)推出了基于英特尔 至强 可扩展处理器的恒脑 • 安全垂域大模型系统(简称:恒脑),依托底层多源异构模型、算法调度引擎及海量安全知识,能够根据业务场景需求切换多种安全角色。

◆ 架构设计:

- 引入模型适配器,使恒脑可平滑接入多种基础模型; - 专项优化的算法调度引擎,使推理任务可跨硬件、跨平台执行;

- 融入海量安全知识,使恒脑具备多业务场景资深安全专家技能。

◆功能开发:

- 研发智能问答、增强检索、研判驾驶舱、智能体等功能,实现安全运营智能化和客户本地知识融合,提升网络安全运营效率,更易于部署在客户私网环境。

◆ 赋能应用:

- 开放接口、插件、原子能力等方式与现有安全产品或系统深度融合,赋能安全运营人员探索更多场景可能性。

恒脑充分秉承“让安全更智能,让智能更安全”的使命,为用户提供了高效、高性价比、灵活的安全大模型部署选项。

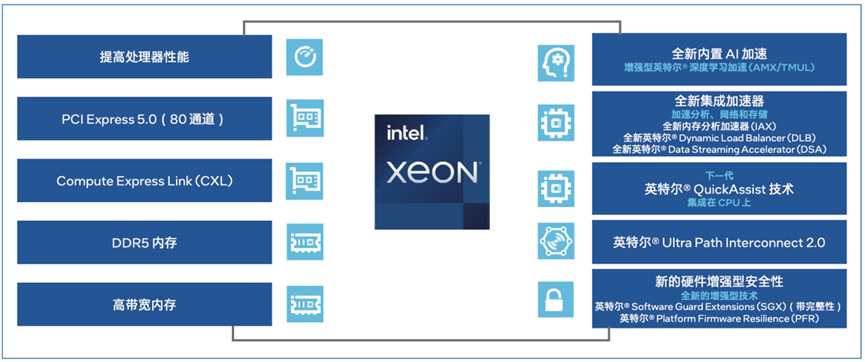

02英特尔 至强 可扩展处理器,

加速恒脑大模型推理

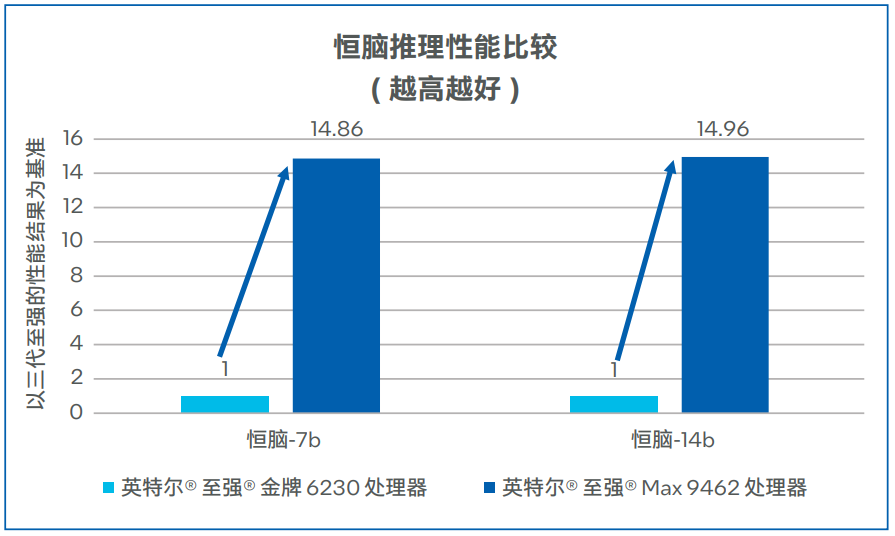

为了兼顾性能、成本等方面的考量,恒脑使用第四代英特尔 至强 可扩展处理器,应对中小规模场景的模型推理需求。

第四代英特尔 至强 可扩展处理器内置了创新的英特尔 AMX加速引擎,在AI性能上更进一步,为恒脑-7b、恒脑-14b模型的推理提供卓越支持。英特尔 AMX针对广泛的硬件和软件优化,通过提供矩阵类型的运算,显着增加了人工智能应用程序的每时钟指令数 (IPC),可为AI工作负载中的训练和推理上提供显著的性能提升。

恒脑推理生成速度测试

恒脑利用英特尔 至强 可扩展处理器进行推理加速,让用户能够获得以下价值:

高效处理百亿级别的安全知识条目,满足智能问答、事件总结报告生成等应用对于性能的需求;

高效利用现有的CPU服务器资源进行推理,降低AI加速器部署与运维带来的成本压力,实现更高的投资收益;

获得由AI扮演的安全运营专家等安全角色,提升安全运营能力,护航网络安全。

目前,采用第四代英特尔 至强 可扩展处理器的恒脑在智能问答、事件总结报告生成、报文研判等实际场景中得到了广泛应用。

通过与英特尔 至强 可扩展处理器进行深度适配和性能优化,可有效加速恒脑推理,助力用户构建起高效能、高性价比的安全垂域大模型系统,有力驱动了网络安全效能的整体跃升与效率改善。

一王欣

安恒信息研究院院长、高级副总裁

未来,安恒信息将与英特尔在安全大模型方面进行进一步合作,进一步释放安全大模型的巨大价值。

-

英特尔

+关注

关注

61文章

9983浏览量

171940 -

网络安全

+关注

关注

10文章

3175浏览量

59909 -

大模型

+关注

关注

2文章

2482浏览量

2848

原文标题:英特尔助力安恒信息加速恒脑大模型推理,实现智能安全运营

文章出处:【微信号:英特尔物联网,微信公众号:英特尔物联网】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

英特尔推出全新英特尔锐炫B系列显卡

英特尔助力百度智能云千帆大模型平台加速LLM推理

开箱即用,AISBench测试展示英特尔至强处理器的卓越推理性能

英特尔IT的发展现状和创新动向

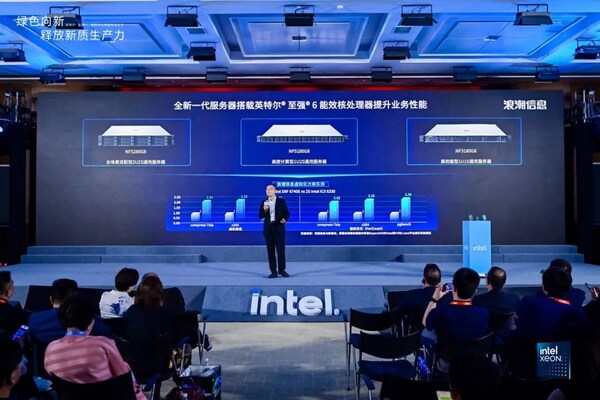

浪潮信息元脑®服务器率先支持英特尔®至强®6处理器

BittWare提供基于英特尔Agilex™ 7 FPGA最新加速板

英特尔AI产品助力其运行Meta新一代大语言模型Meta Llama 3

浪潮信息"源2.0"大模型YuanChat支持英特尔最新商用AI PC

英特尔助力安恒信息加速恒脑大模型推理

英特尔助力安恒信息加速恒脑大模型推理

评论