来源:优维科技UWin

大型语言模型是 2023 年生成式人工智能热潮背后的推动力。然而,它们已经存在了一段时间了。

LLM是黑盒 AI 系统,它使用深度学习对超大数据集进行处理,以理解和生成新文本。现代 LLM 开始成型于 2014 年,当时一篇题为“通过联合学习对齐和翻译的神经机器翻译”的研究论文中引入了注意力机制(一种旨在模仿人类认知注意力的机器学习技术)。2017 年,另一篇论文“注意力就是你所需要的”中引入了 Transformer 模型,这种注意力机制得到了进一步完善。当今一些最著名的语言模型都是基于 transformer 模型的,包括生成式预训练 transformer 系列LLM 和来自 transformer 的双向编码器表示 (BERT)。ChatGPT运行在 OpenAI 的一组语言模型上,在 2022 年发布后仅两个月就吸引了超过 1 亿用户。此后,许多竞争模型相继发布。其中一些属于谷歌和微软等大公司;另一些则是开源的。

以下是当今最相关的一些大型语言模型。它们进行自然语言处理并影响未来模型的架构。

BERTBERT是 Google 于 2018 年推出的 LLM 系列。BERT 是一种基于 Transformer 的模型,可以将数据序列转换为其他数据序列。BERT 的架构是 Transformer 编码器的堆栈,具有 3.42 亿个参数。BERT 在大量数据上进行了预训练,然后进行了微调以执行特定任务以及自然语言推理和句子文本相似性。它被用于提高 Google 搜索 2019 年迭代中的查询理解能力。

Claude

Claude 法学硕士专注于体质人工智能,它以一系列原则为指导塑造人工智能输出,这些原则有助于它所支持的人工智能助手有用、无害且准确。Claude 由 Anthropic 公司创建。Claude 法学硕士的最新版本是 Claude 3.0。

CohereCohere 是一个企业 AI 平台,提供多种 LLM,包括 Command、Rerank 和 Embed。这些LLM 可以根据特定公司的用例进行定制训练和微调。创建 Cohere LLM 的公司是由《Attention Is All You Need》的作者之一创立的。Cohere 的优势之一是它不依赖于单一云——不像 OpenAI 那样依赖于 Microsoft Azure。

Ernie

Ernie 是百度的大型语言模型,为 Ernie 4.0 聊天机器人提供支持。该机器人于 2023 年 8 月发布,已拥有超过 4500 万用户。据传 Ernie 拥有 10 万亿个参数。该机器人最适合普通话,但也能够处理其他语言。

Falcon 40B

Falcon 40B 是一种基于 Transformer 的因果解码器专用模型,由技术创新研究所开发。它是开源的,并基于英语数据进行训练。该模型还有两个较小的版本:Falcon 1B 和 Falcon 7B(10 亿和 70 亿个参数)。亚马逊已在Amazon SageMaker上提供 Falcon 40B 。它也可以在 GitHub 上免费获取。

Gemini

Gemini是 Google 的 LLM 系列,为该公司的同名聊天机器人提供支持。该模型取代了 Palm 为聊天机器人提供支持,在模型切换后,聊天机器人从 Bard 更名为 Gemini。Gemini 模型是多模式的,这意味着它们可以处理图像、音频和视频以及文本。Gemini 还集成在许多 Google 应用程序和产品中。它有三种尺寸——Ultra、Pro 和 Nano。Ultra 是最大、功能最强大的模型,Pro 是中端模型,Nano 是最小的模型,专为提高设备上任务的效率而设计。Gemini 在大多数评估基准上都优于 GPT-4。

Gemma

Gemma是 Google 的开源语言模型系列,使用与 Gemini 相同的资源进行训练。Gemma 有两种规模——20 亿参数模型和 70 亿参数模型。Gemma 模型可以在个人电脑本地运行,并且在多个评估基准上超越了类似规模的 Llama 2 模型。

GPT-3

GPT-3是 OpenAI 于 2020 年发布的大型语言模型,拥有超过 1750 亿个参数。GPT-3 采用仅解码器的 Transformer 架构。2022 年 9 月,微软宣布独家使用 GPT-3 的底层模型。GPT-3 比其前身大 10 倍。GPT-3 的训练数据包括 Common Crawl、WebText2、Books1、Books2 和 Wikipedia。GPT-3 是 OpenAI 公开参数计数的 GPT 系列模型中的最后一款。GPT 系列于 2018 年首次推出,当时 OpenAI 发表了一篇论文《通过生成式预训练提高语言理解能力》。

GPT-3.5GPT-3.5 是 GPT-3 的升级版,参数更少。GPT-3.5 使用来自人类反馈的强化学习进行了微调。GPT-3.5 是支持 ChatGPT 的 GPT 版本。据 OpenAI 称,有几种模型,其中 GPT-3.5 turbo 是最强大的。GPT-3.5 的训练数据延伸到 2021 年 9 月。它也曾被集成到 Bing 搜索引擎中,但后来被 GPT-4 取代。

GPT-4GPT-4是OpenAI 的 GPT 系列中最大的模型,于 2023 年发布。与其他模型一样,它也是基于 Transformer 的模型。与其他模型不同的是,它的参数数量尚未向公众公布,尽管有传言称该模型的参数数量超过 170 万亿。OpenAI 将 GPT-4 描述为多模态模型,这意味着它可以处理和生成语言和图像,而不仅限于语言。GPT-4 还引入了系统消息,让用户可以指定语调和任务。GPT-4 在多项学术考试中表现出了与人类水平相当的表现。在该模型发布时,有人猜测 GPT-4 已经接近通用人工智能(AGI),这意味着它与人类一样聪明甚至比人类更聪明。GPT-4 为 Microsoft Bing 搜索提供支持,可在 ChatGPT Plus 中使用,最终将集成到 Microsoft Office 产品中。

GPT-4oGPT-4 Omni(GPT-4o)是 OpenAI 的 GPT-4 继任者,与之前的模型相比有多项改进。GPT-4o 为 ChatGPT 创造了更自然的人机交互,是一个大型多模态模型,接受音频、图像和文本等各种输入。对话让用户可以像在正常的人类对话中一样参与,实时互动还可以捕捉情绪。GPT-4o 可以在交互过程中查看照片或屏幕并提出相关问题。GPT-4o 的响应时间仅为 232 毫秒,与人类的响应时间相似,比 GPT-4 Turbo 更快。GPT-4o 模型是免费的,将提供给开发者和客户产品。

LamdaLamda(对话应用语言模型)是 Google Brain 于 2021 年发布的 LLM 系列。Lamda 使用了仅解码器的转换器语言模型,并在大量文本语料库上进行了预训练。2022 年,当时的谷歌工程师 Blake Lemoine 公开声称该程序具有感知能力, LaMDA 引起了广泛关注。它建立在 Seq2Seq 架构上。

Llama大型语言模型 Meta AI (Llama) 是 Meta 于 2023 年发布的 LLM。最大版本的大小为 650 亿个参数。Llama 最初发布给经批准的研究人员和开发人员,但现在已开源。Llama 的规模较小,使用、测试和实验所需的计算能力较少。Llama 使用转换器架构,并在各种公共数据源上进行训练,包括 CommonCrawl、GitHub、Wikipedia 和 Project Gutenberg 的网页。Llama 被有效泄露并衍生出许多后代,包括 Vicuna 和 Orca。

MistralMistral 是一个 70 亿参数的语言模型,在所有评估基准上都优于 Llama 类似规模的语言模型。Mistral 还拥有一个经过微调的模型,专门用于遵循指令。其较小的尺寸使其能够实现自托管,并具有出色的业务性能。它是根据 Apache 2.0 许可证发布的。

OrcaOrca 由微软开发,拥有 130 亿个参数,这意味着它足够小,可以在笔记本电脑上运行。它旨在通过模仿 LLM 实现的推理过程来改进其他开源模型所取得的进步。Orca 以明显更少的参数实现了与 GPT-4 相同的性能,并且在许多任务上与 GPT-3.5 相当。Orca 建立在 130 亿个参数版本的 LLaMA 之上。

PathwaysPathways 语言模型是谷歌推出的一款基于 5400 亿参数转换器的模型,为它的 AI 聊天机器人Bard提供支持。该模型在多个TPU 4 Pod(谷歌为机器学习定制的硬件)上进行训练。Palm 擅长推理任务,例如编码、数学、分类和问答。Palm 还擅长将复杂任务分解为更简单的子任务。PaLM 的名称源自 Google 的一项研究计划,该计划旨在构建 Pathways,最终创建一个单一模型,作为多种用例的基础。Palm 有多个经过微调的版本,包括用于生命科学和医疗信息的 Med-Palm 2 以及用于网络安全部署以加快威胁分析的 Sec-Palm。

Phi-1Phi-1 是微软推出的一款基于 Transformer 的语言模型。Phi-1 仅包含 13 亿个参数,在一系列教科书级数据上训练了四天。Phi-1 是使用更高质量数据和合成数据进行训练的小型模型趋势的一个例子。特斯拉前人工智能总监、OpenAI 员工 Andrej Karpathy 在推文中写道:“我们可能会看到更多富有创意的缩减工作量的做法:优先考虑数据质量和多样性而不是数量,生成更多的合成数据,以及小型但功能强大的专家模型。”Phi-1 专注于Python编码,由于规模较小,通用能力较差。

StableLMStableLM 是 Stability AI 开发的一系列开源语言模型,该公司是图像生成器 Stable Diffusion 的幕后推手。截至撰写本文时,已有 30 亿和 70 亿参数模型可用,150 亿、300 亿、650 亿和 1750 亿参数模型正在开发中。StableLM 的目标是透明、可访问且支持性强。

Vicuna 33B

Vicuna 是另一个有影响力的开源 LLM,源自 Llama。它由 LMSYS 开发,并使用 sharegpt.com 的数据进行了微调。根据几个基准测试,它比 GPT-4 更小、功能更弱,但对于其大小的模型来说,它表现不错。Vicuna 只有 330 亿个参数,而 GPT-4 有数万亿个参数。

-

AI

+关注

关注

87文章

30728浏览量

268887 -

人工智能

+关注

关注

1791文章

47183浏览量

238258 -

语言模型

+关注

关注

0文章

520浏览量

10268

发布评论请先 登录

相关推荐

Google Play 2024年度最佳榜单揭幕

安波福苏州荣获“2024大苏州最佳雇主”及“2024最佳HR团队奖”

如何利用大型语言模型驱动的搜索为公司创造价值

小米集团荣获《机构投资者》“2024年亚洲最佳管理团队”多项殊荣

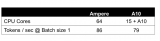

基于CPU的大型语言模型推理实验

2024 年 19 种最佳大型语言模型

2024 年 19 种最佳大型语言模型

评论