缩放法则、龙猫法则、涌现现象;

向量数据库、高质量微调、价值观对齐;

千亿稠密/万亿稀疏、超长序列、多模态……

没错,这些看起来有点拗口的词语,都和AI 大模型有关。

谈到 AI 大模型,你最先想到的是什么?很多人首先关心的还是它的商业变现,而非这些技术术语。AI 大模型训练是一个端到端的复杂系统工程,技术门槛很高,需要强大的算力支撑,尤其是参数量大的模型,资金投入极大。据统计,Chat GPT 一轮训练下来,各种费用加起来达到约 460 万美金,而 Chat GPT-4 一次训练成本为 6300 万美元。不得不感叹一句,AI 大模型真的是一个奢侈品啊!

那么如此奢侈的 AI 大模型,什么时候能实现商业闭环呢?早在 2020 年,有专家就提出一个1:2:4 的商业逻辑,也就是花 100 块钱买硬件,需要在云上实现 200 块钱的营收,在应用上实现 400 块钱的营收,才能实现商业闭环。以 Chat GPT 为例,它需要拥有超过八千万的付费用户,才能实现这个商业闭环。

因此,当前“大模型热潮”迅速席卷全球,国际科技巨头纷纷投入其中,大模型在教育、医疗、金融、娱乐等多个行业中广泛应用,迅速占领垂直市场,以期快速实现商业化落地。然而,人们对于大模型迅速商业化之后的发展路径思考的其实并不多,我们可以看到很多大模型基本上都是浅尝辄止,最后引发了商业化与非盈利之间的矛盾。

由此可见,我们窥见的“大模型狂热”很可能只是冰山一角,而在冰冷的水面下到底隐藏着什么呢?大模型到底是什么?我们为何需要大模型?如何构建一个高效的大模型......找到这些问题的答案,不仅可以帮助我们对大模型进行“祛魅”,在暗流涌动的“大模型狂热”面前保持清醒;也是找到大模型商业变现途径的必由之路,所谓知其然还应知其所以然。

在时习知新上的《AI 大模型技术与发展趋势洞察》这门课程中,你都能找到这些问题的答案,也能找到开头那些术语的解释。课程基于华为在大模型研究中的实践经验,深入剖析 AI 大模型的核心原理、关键技术及未来发展趋势。

无论你是数据科学家、算法工程师,还是 AI 领域的分析师、投资者、创业者、产业政策制定者等专业人士,抑或是企业中高层管理者,研发团队负责人、业务负责人、市场营销人员等外围人士;学习该课程,都能够让你在了解或重温 AI 大模型的基础知识和技术原理之后,更全面地掌握 AI 大模型的建设过程,更深入地洞悉 AI 技术未来的发展趋势及其背后的底层逻辑,从而将其灵活应用于实际工作中,探索以大模型为驱动的业务创新与价值创造之路。

-

云计算

+关注

关注

39文章

7774浏览量

137351 -

AI

+关注

关注

87文章

30728浏览量

268886 -

大模型

+关注

关注

2文章

2423浏览量

2641

发布评论请先 登录

相关推荐

GPU是如何训练AI大模型的

AI 大模型行业应用:企业如何走出一条智能化蜕变之路?

ai大模型和传统ai的区别在哪?

AI大模型与小模型的优缺点

你真的了解驻波比吗?到底什么是电压驻波比?

STM CUBE AI错误导入onnx模型报错的原因?

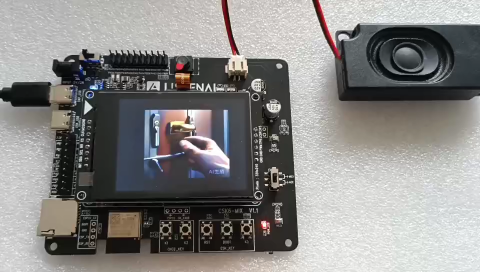

防止AI大模型被黑客病毒入侵控制(原创)聆思大模型AI开发套件评测4

使用cube-AI分析模型时报错的原因有哪些?

GAP!你对AI大模型到底了解多少?

GAP!你对AI大模型到底了解多少?

评论