近日,Intel、AMD、博通(Broadcom)、思科(Cisco)、Google、惠普(Hewlett Packard Enterprise,HPE)、Meta和微软(Microsoft)在内的八家公司宣布他们已经为人工智能数据中心的网络制定了新的互联技术UALink(Ultra Accelerator Link),以打破英伟达NVLink技术垄断的消息受到了广泛的关注。

“本期奇说芯语Kiwi Talks 将从万卡集群大模型算力需求的挑战说起,来解读这场军备赛的背后原理…”

智算网络催生万卡集群

随着大模型的持续爆发,其对算力的需求也在迅猛增长,这促使算力集群不断向万卡以上的规模演进。这一趋势不仅代表着计算能力的飞跃,也对网络提出了前所未有的超高要求。

万卡集群是指由一万张及以上的加速卡(包括GPU、TPU及其他专用AI加速芯片)组成的高性能计算系统,主要用于加速人工智能模型的训练和推理过程。这种集群的构建旨在解决大模型训练对算力需求的巨大增长问题,尤其是现在模型参数量从百亿级、千亿级迈向万亿级。大模型的训练和推理任务需要海量的计算资源和高效的网络连接。

万卡级别的算力集群意味着将有数以万计的高性能计算节点协同工作,它们之间的数据传输和同步必须达到毫秒级甚至微秒级的延迟,以确保模型训练的高效性和准确性。首先,大模型训练对于GPU之间的互联通信要求极高,无论是机内GPU的通信还是服务器之间的GPU通信。特别是在模型并行和数据并行等模式下,通信数据量更是达到了百GB级别。因此,网络必须支持高速互联协议,并且能够提供足够的单端口带宽和总带宽。

我们知道PCIe(Peripheral Component Interconnect Express):它是一种计算机总线标准,用于在计算机内部连接各种设备和组件(例如显卡、存储设备、扩展卡等)。PCIe接口以串行方式传输数据,具有较高的通信带宽,适用于连接各种设备。然而,由于其基于总线结构,同时连接多个设备时可能会受到带宽的限制受限于带宽、延迟、数据传输效率,已成为大规模计算集群的互联瓶颈。

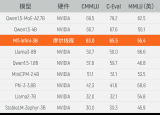

英伟达NVLink的无损网络护城河

英伟达的NVLink是其开发并推出的一种总线及其通信协议。NVLink采用点对点结构、串列传输,用于中央处理器(CPU)与图形处理器(GPU)之间的连接,也可用于多个图形处理器之间的相互连接。与PCI Express不同,一个设备可以包含多个NVLink,并且设备之间采用网格网络而非中心集线器方式进行通信。该协议于2014年3月首次发布,采用专有的高速信号互连技术(NVHS)。目前NVLink已经升级到5.0版本。第五代 NVLink 大幅提高了大型多 GPU 系统的可扩展性。单个 NVIDIA Blackwell Tensor Core GPU 支持多达 18 个 NVLink 100 GB/s 连接,总带宽可达 1.8 TB/s,比上一代产品提高了两倍,是 PCIe 5.0 带宽的 14 倍之多。

NVLink 就是这种“多节点无损网络”的代表,由一个强大的软件协议组成,通常通过印在计算机板上的多对导线实现,可以让处理器以极高的速度收发共享内存池中的数据。NVLink 设计的主要设计目的,就是突破PCIe的屏障,达成GPU-GPU及CPU-GPU的片间高效数据交互。

NVLink虽拥有优秀的性能,但私有协议无法兼容不同来源的产品,这样的封闭生态已成为行业发展掣肘。受到巨大的需求推动,以及为抵抗这种市场挤压 ,AMD、谷歌、微软、英特尔(Intel)、博通(Broadcom)、思科(Cisco)构成联盟建立一个开放的行业互联标准即UALink。UALink将使系统OEM、IT专业人员和系统集成商能够为其人工智能连接数据中心创建一条更易于集成、更具灵活性和可扩展性的途径。

据官方消息,UALink 1.0规范支持连接多达1024个AI加速器,并允许在一个计算集群(Pod)内,让接入的GPU等加速器附带的内存之间实现直接加载和存储。

奇异摩尔赋能万卡集群互联

目前包括各大芯片厂商以及生态内的服务器厂商开始不断提及甚至对标英伟达NVLink,都想要打破其所造的护城河。整个行业生态包括奇异摩尔在内的企业正在积极探索如何解决满足集群通信间通讯,片间互联的高效互联的解决方案。

目前,奇异摩尔基于自身的互联技术优势,较早布局IO Die、Base Die等高性能互联芯粒,并基于Kiwi-Link统一互联架构,提供涵盖集群间、片间、Die间的全链路高性能互联解决方案

GPU片间互联

奇异摩尔的高性能网络加速芯粒 – Kiwi NDSA,内建RoCE V2高性能 RDMA (Remote Direct Memory Access) 和数十种卸载/加速引擎,可作为独立芯粒应用于GPU的传输加速器。奇异摩尔自研的全球首创GPU Link Chiplet “NDSA-G2G”,通过RDMA和D2D技术,在芯片间搭建了高速数据交换网络,可实现近TB/s的超高速数据传输,其性能达到全球领先水平,满足AI芯片对于片间交换不断增长的需求。

集群间通信

奇异摩尔 Kiwi NDSA SNIC是全球首款支持800G带宽的RDMA NIC产品,具备极高的集群扩展能力,可以大幅提升集群节点间的交互效率,使得更大规模的集群设计成为可能。除带宽升级到800G之外,延时也降至纳秒级,并支持数十GB的超大规模数据包,性能媲美目前全球标杆ASIC产品。

业界纷纷提出集群通讯互联的重要性

中国移动研究院网络与IT技术研究所主任研究员陈佳媛在近期公开演讲中提及必须突破GPU卡间互联技术瓶颈,提高卡间互联带宽,提升端口数量以满足集群算力纵向扩展升级需求;低延迟通信,减少GPU通信跳数,优化数据传输路径。 新华三集团高级副总裁、云与计算存储产品线总裁徐润安此前也谈到算力互联。在他看来,过去,大家的目标可能是做更强算力的单颗芯片,现在会从另一个角度努力,怎样将芯片做成更大集群,同时使得集群的通信效果更高,集群的处理能力更强;

浪潮信息高级副总裁刘军发表的观点是,实现更大的算力已经不在芯片,而是在算法层面做创新,比如怎么把算力分布到系统层面上,怎么解决卡间互联问题,怎么让更多的GPU高效协同。

写在最后,数据中心和算力集群是AI的核心,网络则是它的命脉,它们共同构筑了AI大模型底层网络基础设施,实现了数据和智能的无缝传递。然而AI芯片性能及软件生态存在的差距,万卡集群建设存在芯片间、卡之间、集群间的互联问题,这些都需要更开放的平台去持续地解决。

-

英伟达

+关注

关注

22文章

3872浏览量

92455 -

算力

+关注

关注

1文章

1043浏览量

15102 -

奇异摩尔

+关注

关注

0文章

49浏览量

3569 -

大模型

+关注

关注

2文章

2784浏览量

3432

原文标题:Kiwi Talks | 智算网络催生万卡集群,all in通信互联军备赛

文章出处:【微信号:奇异摩尔,微信公众号:奇异摩尔】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

百度智能云点亮昆仑芯三代万卡集群

奇异摩尔分享计算芯片Scale Up片间互联新途径

回顾:奇异摩尔@ ISCAS 2024 :聚焦互联技术与创新实践

智原科技与奇异摩尔2.5D封装平台量产

摩尔线程与羽人科技完成大语言模型训练测试

从千卡集群卡到万卡集群,燧原科技打造更好的AI算力底座

万卡集群解决大模型训算力需求,建设面临哪些挑战

国产GPU可替代!摩尔线程千卡集群点亮新成就

摩尔线程千卡智算集群与滴普企业大模型已完成训练及推理适配

摩尔线程、无问芯穹合作完成国产全功能GPU千卡集群

奇异摩尔携手SEMiBAY Talk 邀您畅谈互联与计算

奇异摩尔赋能万卡集群互联

奇异摩尔赋能万卡集群互联

评论