每一次技术风口,在掀起浪潮的同时也伴生着泡沫,尽管这轮GenAI革命无疑是一次深刻改变人类文明进程的革命,但过去一年,关于AI, 有太多荒谬不实、不负责任的杂音,也有太多为技术而技术的错误应用范式。

近日,昆仑巢联合各路AI领域大咖和组织机构,举办首期人工智能应用实践讨论专场,打造了一场围绕AI应用的线上思辨对谈,旨在促进AI行业的深入思考和建设性对话。云知声算法研发总监王亦宁应邀出席活动并带来主题为《基于山海大模型的领域级RAG技术探索及其实践》的深度演讲。

现场,王亦宁结合其在人工智能领域的丰富经验,深入剖析了RAG技术在大模型中的关键作用,并基于山海大模型的构建与实际落地探索,分享了山海大模型的企业级优化策略,为与会者提供了实现技术深度融合与价值最大化的前瞻性洞见。

以下为分享精华,我们做了整理,谨供学习:

PART 1

RAG:山海大模型的创新应用与实践探索

当前,大语言模型应用主要面临私有部署难、幻觉问题、安全合规以及知识更新局限性等问题。正是在这样的背景下,检索增强生成技术(Retrieval-Augmented Generation,RAG)应时而生,成为大模型时代的一大趋势。

RAG是指检索增强生成(Retrieval Augmented Generation )技术,其在大语言模型生成答案之前,先从广泛的文档数据库中检索相关信息,然后利用这些信息来引导生成过程,极大地提升了内容的准确性和相关性。

尽管RAG技术在提升语言模型的复杂查询处理能力方面具有显著优势,但在实际应用中仍面临一些关键挑战。这些挑战包括保持语义连贯性、过滤无关信息、处理口语化表达、避免生成错误信息以及减少干扰等。王亦宁强调,解决这些问题对于提升RAG性能和应用范围至关重要。

会上,王亦宁向与会观众展示了RAG技术如何与大模型结合,以强化其在特定领域的应用效能。具体来说,首先通过口语改写和Query优化,精确捕捉用户意图。随后,利用向量化技术在向量数据库中高效检索相关信息,并通过多路召回策略全面搜集数据,过滤噪声。在生成阶段,采用关键信息抽取和Prompt工程技术,确保回答的准确性和相关性,避免错误信息的产生。最后,严格的问答校验流程,保证了输出回答的高质量,确保为用户提供更可靠的内容。

整体而言,RAG技术的应用,帮助山海大模型打造了一个高效、准确的问答系统,有效缓解了幻觉问题,提高了知识更新的速度,并增强了内容生成的可追溯性,使得大语言模型在实际应用中变得更加实用和可信。

为了具体展示RAG在山海大模型中的应用,王亦宁以工业问答为例,向与会嘉宾生动展示了如何利用山海模型进行高效的Query Answer Retrieval。通过基于Copy机制的RAG、Query改写、检索精排、候选结果过滤、关键信息抽取和片段校验等技术,山海RAG技术方案在增强大模型回答质量的同时,更确保了在不确定性情况下的可靠性,使得大模型在特定领域的应用更加精准、高效和可信。

PART 2

打造企业级应用范式,山海的六大优化实践路径

演讲后半段,王亦宁分享了山海大模型在企业级应用中的优化实践,包含预训练、指令微调、对齐、Agent、解码策略、提示工程六大策略。

预训练:

利用行业特定的语料库对模型进行进一步的预训练,使其能够更好地理解和适应特定行业的术语、概念和上下文。在医疗行业语料库的加持下,山海大模型于2023年6月的MedQA任务中超越Med-PaLM 2,取得87.1%的优异成绩;在临床执业医师资格考试中提升至523(总分600分),超过99%的考生水平。

指令微调:

在企业级应用中,云知声采用了一系列微调策略以提升其大模型的性能——全量SFT通过大规模标注数据集对模型进行全面训练,以确保模型在特定任务上达到最优表现;LoRA和QLoRA技术通过引入低秩结构和量化方法,高效调整模型参数,使模型能够快速适应新任务,同时降低资源消耗;P-Tuning策略则专注于优化模型的特定部分,以增强模型对新数据的适应性;Adaptor技术通过在模型主体之外添加小型适配器网络,使模型能够在保持原有结构的同时,学习并适应新任务的特征。这些策略的综合应用,使得山海大模型在保持预训练优势的基础上,能够精准满足企业级应用的多样化需求。

对齐:

为确保大模型的输出与用户需求和偏好保持一致,云知声在大模型的企业级优化过程中采用了RLHF、RLAIF、DPO三大对齐策略——RLHF通过分析用户的直接反馈,使用强化学习来优化模型行为,使其生成的答复更加精准和符合期望;RLAIF进一步通过逆向奖励机制增强模型的学习能力,鼓励生成高质量答案并避免不相关输出;DPO则直接针对用户偏好进行优化,通过比较不同输出样本来提升模型输出的满意度。这些策略的结合不仅提升了模型的响应质量,还增强了模型适应不同用户需求的能力,从而在企业级应用中实现更加个性化和更高效的服务。

Agent:

山海大模型通过一系列Agent创新策略,显著提升了企业级应用的效能。Web搜索增强赋予了Agent实时访问互联网信息的能力,确保答复的时效性和准确性;外部检索增强则让Agent深入挖掘企业内部知识库,提供专业且深入的答复;ToolLLM进一步扩展了Agent的功能,集成了多种辅助工具,使得语言模型能够执行更复杂的任务。

解码策略:

解码策略是优化语言模型输出的关键环节,涉及多种技术以适应不同的应用需求。Greedy Search以其简洁性快速选择最可能的词,而Beam Search通过考虑多个最可能的序列来增加找到最优解的几率。Top-k采样通过限制词的选择范围来平衡结果的多样性和准确性。Copy Mechanism允许模型复制输入中的短语,以提高回答的准确性。Restricted Decoding确保输出内容的适当性,而推测性解码Speculative Decoding允许模型生成基于假设的答案,适用于需要创造性的场景。这些策略的综合应用,使得语言模型能够灵活地处理各种复杂的查询,提供高质量、多样化且符合用户需求的回答。

提示工程:

提示工程提升了模型对任务的理解和生成文本的准确性,是提高语言模型在各种应用场景中表现的关键。它包括利用上下文学习(In-context Learning)为模型提供丰富的背景信息,使其能够基于少量示例快速适应新任务;构建思维链(Chain of Thought)和思维树(Thought Trees)以模拟逐步的逻辑推理过程,增强模型解决复杂问题的能力;以及确保自我一致性(Self-consistency),使模型输出在逻辑上连贯无矛盾。

此外,云知声UniDataOps框架通过其综合性的数据处理能力,为大型语言模型的训练和微调提供了一个强大、可靠的数据基础,从而显著提升企业级大模型应用的性能和效果。

演讲的尾声,王亦宁对未来人工智能技术的发展前景表达了积极乐观的态度,他表示,云知声期望通过深化对复杂文本数据的分析和格式处理,提升对视觉信息的解读能力,并实现基于图像的内容问答功能,从而拓展AI在多模态交互和智能理解方面的可能性,为用户带来更加多样化和个性化的应用体验。

-

AI

+关注

关注

87文章

30830浏览量

268995 -

人工智能

+关注

关注

1791文章

47244浏览量

238381 -

云知声

+关注

关注

0文章

185浏览量

8390

原文标题:云知声出席昆仑巢首期人工智能应用实践讨论专场并作主题分享

文章出处:【微信号:云知声,微信公众号:云知声】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

云知声荣登2024大模型企业TOP50榜单

云知声入选创业邦《2024 AIGC创新应用洞察报告》

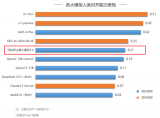

云知声山海大模型多项能力全球领跑

云知声山海大模型的创新应用与实践探索

云知声山海大模型的创新应用与实践探索

评论