通信架构实验室主要是致力于无线通信基础架构的研究,我们主要是采用通信和计算结合的方式打造高效的端到端的通信系统,提升用户体验。今天我给大家介绍的主题主要是汇报我们 5G 和 VR 结合的工作——“通信和计算融合,引领VR未来”。

主要介绍三个部分:

第一,5G 主要面对的数据洪流,从架构上怎么支持 5G 的数据洪流。

第二,介绍研究院对于远程沉浸式互动的愿景。

第三,通信与计算融合解决移动 VR 关键问题。

我们研究工作的重点主要是通信和计算融合的方式,为什么需要通信和计算融合呢?大家如果从互联网厂商的角度可能认为通信系统基本上对我来说是透明的,我不需要知道你通信到底做了哪些事情,只需要把信息从一端传到另一端就可以,为什么通信和计算要结合起来,有什么好处?

5G 如何应对庞大的数据流

主要的出发点是数据,怎么处理数据和传输数据,特别是 5G 将来所要面对的数据洪流。大家肯定都是对摩尔定律非常熟悉,宋院长(英特尔中国研究院院长宋继强)也介绍摩尔定律如何实现每18个月我们芯片的能力翻一番。

今天围绕的主题是VR和5G,为什么VR需要特别大的数据容量,为什么VR在数据洪流里会占据大量的流量呢?目前互联网的最主要的传输内容是视频,将来VR是代表更高质量视频的未来。

举个例子,如果大家看一张很高清的图片,放在手机上或者是放在电视上会觉得现在的清晰度已经超出你的想象,非常的清楚。但是如果你把一个同样的图片放在一个VR眼镜上,同样的分辨率会变得非常模糊,为什么?主要是视角的原因,我们在手机和电视机上看图片的时候,你的视角只有10到30度左右,在VR眼镜上拓展到100度、120度、150度,一下子增加了好几倍,纵向还有增加的倍数。为了达到非常好的高清要求,对VR的显示来说需要25倍到40倍的分辨率增加,这样它的流量会变得非常高。

比如我们要打造一个非常好的VR系统,现在的系统是达不到这个要求,你需要16K到24K超级高清的VR。不压缩的话,容量会达到500Gbps,每个月的容量是1Gbps,如果是500Gbps,可能是十几年的容量一秒钟就过去了,即使压缩之后也达到1Gbps,同时VR对显示的延迟非常敏感,对传输的容错性也是非常敏感。所以对5G来说,特别是高质量的虚拟现实和增强现实,对5G的通信系统和计算系统来说都要着力应对。

我们主要研究系统架构,在5G系统架构里面怎么样满足一个速率洪流的要求,主要是采用计算和网络融合的方式,在端到端的部署、计算和网络系统来满足数据处理和传输的要求。

在3G、4G时代,网络是网络,数据和云计算是云计算功能,对于一个云计算的应用来说,网络基本上是透明的,它的传输容量在接入网端的传输容量和核心网的传输容量,骨干网的传输容量是一致的,你发的任何一个请求都会到云计算中心处理,然后再把结果返回给你,这样在整个容量是一个一致的管道的容量。

大家应该都有亲身的体验,如果你宽带扩容了50兆,然后再扩到100兆或1Gbps,其实你的感觉并不明显,你的容量并不是受限于接入网端,而是在核心网、骨干网或者数据中心里面,没有办法支持那么高速率的应用。如果你的小区里面放一个视频服务器,你去访问视频服务器的时候会感觉看起高清大片来特别流畅,主要是因为内容下沉。

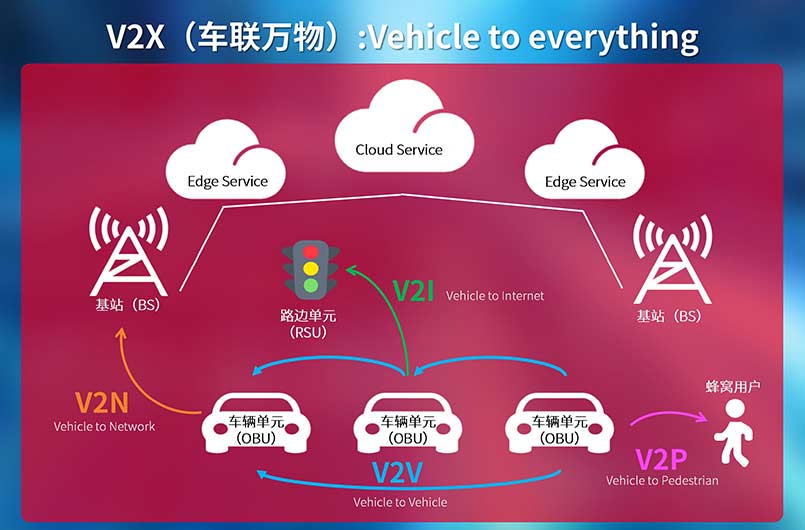

在4G的后半期我们已经引入了边缘计算,边缘计算的目的主要是应对在网络边缘的数据传输和处理的要求。我们加入边缘计算,可以对很多边缘产生的数据进行实时的处理和反馈,比如智能汽车产生的数据,智能工厂产生的数据,这样就不需要把所有的数据传到云计算中心再进行处理。它有两点非常明显的好处,第一是时延非常低,满足物联网的应用。第二是减少核心网的带宽。虽然我们的5G会将边缘的容量扩展得很大,比如说100倍到1000倍左右,核心网不可能扩展到1000倍。

在5G和下一代会是什么样?会发生什么呢?在第三阶段的时候,我们认为它的计算能力会进一步的下移到智能终端。比如,车或者手机实际上就是一个智能终端,家里的传感器和路上的传感器很多都可以连到智能终端上,5G的网络会把整个物联网设备、智能终端和边缘计算的能力、云计算的能力统一起来,所以我们能够打造一个端到端的网络,同时也是一个端到端的计算平台,来应对5G的数据洪流。

沉浸式互动的未来

还有社交的功能,大家回家都非常少,在外地工作的时候,有了我们这个系统可以瞬间转移到你的家里,和你的父母进行聊天,好像你真的回到家里身临其境一样,这是我们设想的远程沉浸式互动的未来。我们用什么样的技术实现呢?下面跟大家介绍一下。

VR最主要的肯定是要做内容,我们刚才也说目前的VR内容2K、4K,它的清晰度还差得很远,我们怎么样产生高质量VR的内容呢。如果你体验过VR的视频可能会有一些体验,目前的VR视频除了是好莱坞制作的大片,基本上VR视频内容都是2D的,因为3D VR视频生成是非常复杂的,制作难度也大。

所以,我们英特尔中国研究院研究的目标聚焦两点:

第一,3D VR视频能实时合成,能够产生高质量的内容。

第二,怎么实时产生内容满足我们对远程沉浸式未来的要求。

我们的设备大家可以看到它有非常多的摄像头,有17个,每个摄像头是2K的分辨率,为什么需要这么多的摄像头,实际上主要是为了在水平方向能够在任意方向差值生成一个3D的内容,需要每个摄像头之间有比较多的重合区域,所以需要非常多的摄像头。

3D VR的合成算法非常复杂,特别是产生一个没有瑕疵的3D视频,你要消除它的鬼影效应,消除拼接的瑕疵,采用非常复杂的光流算法,即使是目前最强大的服务器和最强大的台式机也很难完成实时性的功能。

我们开发了分布式的处理平台,是非常高密度的分布式处理平台,是2.5U高的机箱,在这里可以插入12个至强CPU卡,同时插入12块FPGA卡,中间有600G左右的互联能力。对视频VR处理来说,对实时合成来说一个主要的功能就是怎么样实现精准的同步,从处理的角度实现精准的同步,这个平台也可以支持。通过我们算法的研究,通过实时处理的加强,希望我们能够真正的达到产生一个非常高质量的,比如说现在产生8K的高清的内容,满足将来的要求。

我们有了内容之后,下一个面临的问题是怎么样把这些内容传输到客户端。刚才说了VR的传输要求是非常高,整个的带宽需要是100兆到1Gbps。同时,延迟需要非常低,只有十几毫秒到二十多毫秒。目前的网络基本上是没有办法满足这个要求,所有移动的网络是有接入网,有核心网,有骨干网,所以在任何的两个用户之间传输,即使你是在离得很近的两个用户传输,实际上要走一大圈,中间需要经过非常多的设备,即使优化得很好,最好的效果只能达到50毫秒到100毫秒。

在这种情况下怎么能够满足VR处理实时性的十几毫秒的要求,特别是移动的时候跟上你的显示速度,这只有十几毫秒。我们提出一种方法——边缘计算,通过通信和计算结合的方法,采用边缘计算的能力能够使VR达到实时传输的要求,解决从显示到头显的要求,解决从带宽到时延的要求。

首先,我们生成VR的视频内容之后,把360度的全景视频通过压缩传到边缘服务器,在边缘服务器端有整个全景的内容,可以同时服务多个用户。每个用户会把自己的视角信息,你在看哪个方向传给边缘服务器,边缘服务器把视角信息的内容发给用户。

这样有两个特别显著的好处:

一是通过通信和计算结合的方式,采用边缘服务器能够显著降低从移动到显示的时延,本来是50到100毫秒,现在只是10到20毫秒。

二是能够大大降低无线通信带宽的需求。如果不采用这种方法需要1Gbps带宽,采用这种方法可以降低2到3倍。通过这种方法我们能够打造一个高效的5G网络传输系统。

还有一点比较重要的:可靠性。因为VR的传输它对数据传输的可靠性要求非常高。一个视频如果离得很远,看电视的时候突然有一些瑕疵可能感觉比较明显,但不会感觉特别不舒服,但是如果一个VR眼镜在显示一个视频的时候,如果突然感觉有一帧丢失了,就需要很长的时间才能恢复出来,这时候会感觉到特别的不舒服。

这是我们录的两段视频,左边是英特尔的移动VR系统,右边是第三方的系统。可以看到左边的系统是我们用手机拍摄下来的,是非常流畅,但是右边因为是完全靠这种PC的功能,手机端的功能比较弱,会显得非常卡顿。

还有另外一点最重要的,也是做研究经常容易忽略的一件事情,你的应用在哪里来。如果我们做了一个VR系统,所有的应用要重新写,所有的内容要重新生成,那是没有办法建立起一个生态系统的。

我们做的事情就是怎么把我们的移动VR移植到PC端、边缘服务器端和主流的平台上,我们开发了VR无线适配,可以无缝的接到Steam平台,Steam运行的游戏和内容就可以在移动VR上播放和运行。我们把显示内容从PC或者边缘服务器显示到移动VR端,同时移动VR端的感知信息,比如传感器的信息会发给Steam平台,能够将一个PC VR的体验和基于云计算VR的体验带到真正的移动VR端。

最后总结一下,我们通信架构实验室主要是在5G和VR结合方面的研究,通过通信和计算融合的方式打造一个高效的通信和计算系统,能够将来解决一些移动VR端的关键问题,通往我们所设想的远程沉浸式互动的未来。

-

英特尔

+关注

关注

61文章

9934浏览量

171634 -

vr

+关注

关注

34文章

9637浏览量

150155 -

5G

+关注

关注

1353文章

48400浏览量

563778

原文标题:英特尔详述: 5G 如何助力 VR 的未来发展

文章出处:【微信号:WW_CGQJS,微信公众号:传感器技术】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

移远通信基于高通平台发布可集成边缘计算功能的5G MBB解决方案

美格智能5G车规级通信模组: 5G+C-V2X连接汽车通信未来十年

边缘计算与5G技术的结合

5G RedCap通信网关是什么

5G Advanced技术新突破:高速率体验引领未来应用

2024世界移动通信大会聚焦5G及未来通信技术,爱立信分享5G战略蓝图

新的机遇与挑战:5G与物联网的融合

移远通信闪耀MWC上海:5G前沿技术引领未来

5G 外置天线

5G通信和计算融合 引领VR未来

5G通信和计算融合 引领VR未来

评论