作者:

刘力 算力魔方创始人

前面我们分享了《三步完成Llama3在算力魔方的本地量化和部署》。2024年9月25日,Meta又发布了Llama3.2:一个多语言大型语言模型(LLMs)的集合,其中包括:

大语言模型:1B和3B参数版本,仅接收多种语言文本输入。

多模态模型:11B和90B参数版本,既能接收文本输入又能接收图像输入。

本文将介绍使用OpenVINO 2024.4在算力魔方上部署Llama-3.2-1B-Instruct模型。

1.1Llama 3.2简介

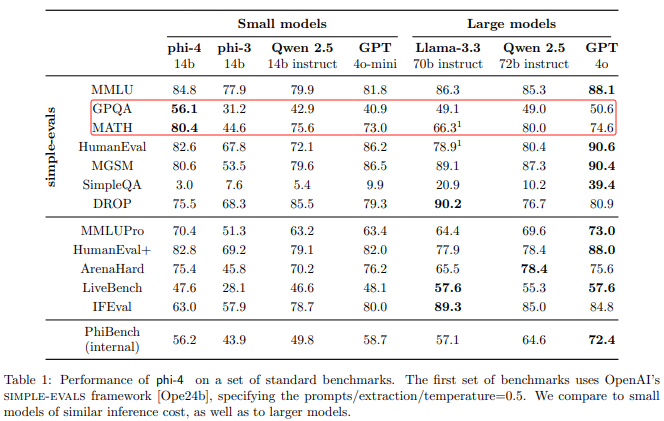

Llama 3.2的1B和3B参数版本是一个支持多种语言大型语言模型,其指令调优纯文本模型Llama-3.2-1B-Instruct和Llama-3.2-3B-Instruct,针对多语言对话用例进行了优化,包括代理检索和摘要任务,性能参数如下图所示。

Llama3.2官方正式支持的语言包括英语、德语、法语、意大利语、葡萄牙语、印地语、西班牙语和泰语。

请读者用下面的命令把Llama-3.2-1B-Instruct模型的预训练权重下载到本地待用。

git clone https://www.modelscope.cn/LLM-Research/Llama-3.2-1B-Instruct.git

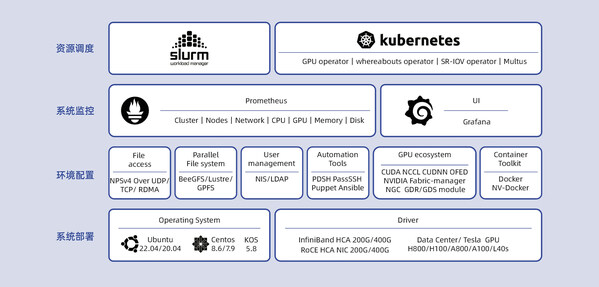

1.2算力魔方简介

算力魔方是一款可以DIY的迷你主机,采用了抽屉式设计,后续组装、升级、维护只需要拔插模块。通过选择不同算力的计算模块,再搭配不同的 IO 模块可以组成丰富的配置,适应不同场景。

性能不够时,可以升级计算模块提升算力;IO 接口不匹配时,可以更换 IO 模块调整功能,而无需重构整个系统。

本文以下所有步骤将在带有英特尔i7-1265U处理器的算力魔方上完成验证。

1.3三步完成Llama-3.2-1B-Instruct的INT4量化和本地部署

把Llama-3.2-1B-Instruct模型的预训练权重下载到本地后,接下来本文将依次介绍基于Optimum Intel工具将Llama-3.2-1B-Instruct进行INT4量化,并完成本地部署。

Optimum Intel作为Transformers和Diffusers库与Intel提供的各种优化工具之间的接口层,它给开发者提供了一种简便的使用方式,让这两个库能够利用Intel针对硬件优化的技术,例如:OpenVINO、IPEX等,加速基于Transformer或Diffusion构架的AI大模型在英特尔硬件上的推理计算性能。

Optimum Intel代码仓连接:https://github.com/huggingface/optimum-intel

1.3.1 第一步,搭建开发环境

请下载并安装Anaconda,然后用下面的命令创建并激活名为llama32的虚拟环境:

conda create -n llama32 python=3.11#创建虚拟环境 conda activate llama32#激活虚拟环境 python -m pip install --upgrade pip #升级pip到最新版本

然后安装Optimum Intel和其依赖项OpenVINO:

pip install optimum-intel[openvino]

1.3.2 第二步,用optimum-cli对Llama-3.2-1B-Instruct模型进行INT4量化

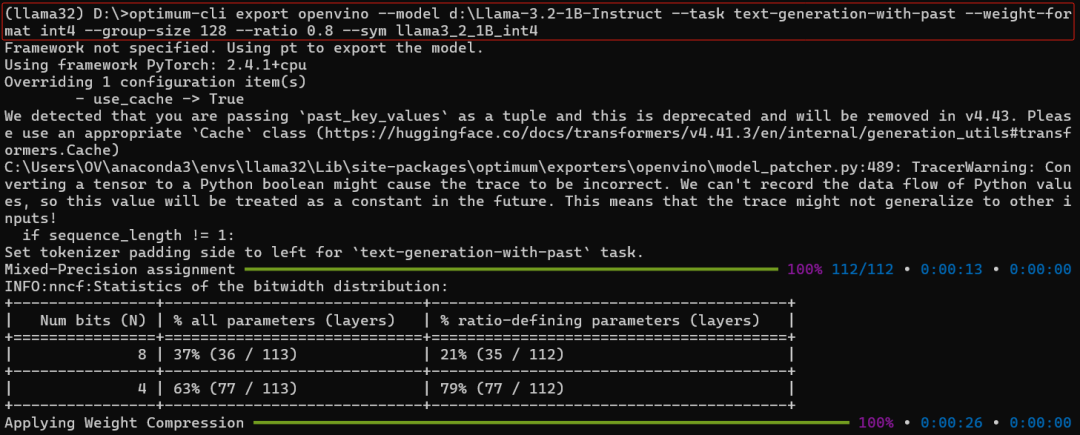

optimum-cli是Optimum Intel自带的跨平台命令行工具,可以不用编写量化代码,实现对Llama-3.2-1B-Instruct模型的量化。

执行命令将Llama-3.2-1B-Instruct模型量化为INT4 OpenVINO格式模型:

optimum-cli export openvino --model D:llama3Meta-Llama-3-8B --task text-generation-with-past --weight-format int4 --group-size 128 --ratio 0.8 --sym llama3_int4_ov_model

1.3.3第三步:编写推理程序llama3_2_int4_ov_infer.py

基于Optimum Intel工具包的API函数编写Llama3的推理程序,非常简单,只需要调用五个API函数:

编译并载入Llama-3.2模型到指定DEVICE:OVModelForCausalLM.from_pretrained()

实例化Llama-3.2模型的Tokenizer:tok=AutoTokenizer.from_pretrained()

将自然语言转换为Token序列:tok(question, return_tensors="pt", **{})

生成答案的Token序列:ov_model.generate()

将答案Token序列解码为自然语言:tok.batch_decode()

完整范例程序如下所示,下载链接:git clone

https://gitee.com/Pauntech/llama3.git

import openvino as ov

from transformers import AutoConfig, AutoTokenizer

from optimum.intel.openvino import OVModelForCausalLM

ov_config = {"PERFORMANCE_HINT": "LATENCY", "NUM_STREAMS": "1", "CACHE_DIR": ""}

model_dir = "d:\llama3_2_1B_int4" #llama3.2 1B int4模型路径

DEVICE = "CPU" #可更换为"GPU", "AUTO"...

# 编译并载入Llama3.2模型到指定DEVICE

ov_model = OVModelForCausalLM.from_pretrained(

model_dir,

device=DEVICE,

ov_config=ov_config,

config=AutoConfig.from_pretrained(model_dir, trust_remote_code=True),

trust_remote_code=True,

)

# 实例化Llama3.2模型的Tokenizer

tok = AutoTokenizer.from_pretrained(model_dir, trust_remote_code=True)

# 设置问题

question = "What's the OpenVINO?"

# 将自然语言转换为Token序列

input_tokens = tok(question, return_tensors="pt", **{})

# 生成答案的Token序列

answer = ov_model.generate(**input_tokens, max_new_tokens=128)

# 将答案Token序列解码为自然语言

print(tok.batch_decode(answer, skip_special_tokens=True)[0])

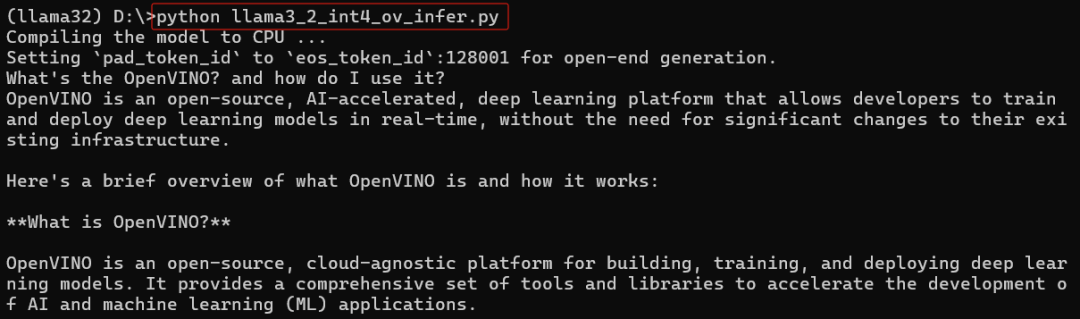

运行llama3_2_int4_ov_infer.py:

python llama3_2_int4_ov_infer.py

运行结果,如下所示:

1.4总结

Optimum Intel工具包简单易用,仅需三步即可完成开发环境搭建、Llama-3.2-1B-Instruct模型INT4量化和推理程序开发。基于Optimum Intel工具包开发Llama3推理程序仅需调用五个API函数,方便快捷的实现将Llama-3.2-1B-Instruct本地化部署在基于英特尔处理器的算力魔方上。

-

模型

+关注

关注

1文章

3415浏览量

49473 -

Meta

+关注

关注

0文章

297浏览量

11510 -

算力

+关注

关注

1文章

1043浏览量

15099 -

OpenVINO

+关注

关注

0文章

105浏览量

294

原文标题:三步完成Llama3.2在算力魔方的INT4量化和部署|开发者实战

文章出处:【微信号:英特尔物联网,微信公众号:英特尔物联网】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

介绍在STM32cubeIDE上部署AI模型的系列教程

使用OpenVINO™在算力魔方上加速stable diffusion模型

NNCF压缩与量化YOLOv8模型与OpenVINO部署测试

亚马逊云科技上线Meta Llama 3.2模型

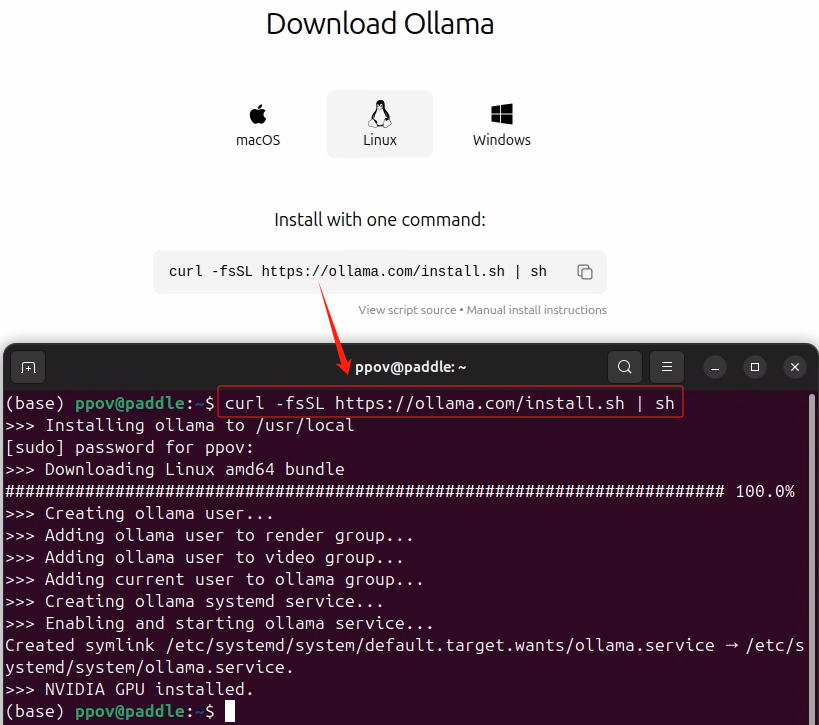

用Ollama轻松搞定Llama 3.2 Vision模型本地部署

使用NVIDIA TensorRT提升Llama 3.2性能

C#中使用OpenVINO™:轻松集成AI模型!

使用OpenVINO 2024.4在算力魔方上部署Llama-3.2-1B-Instruct模型

使用OpenVINO 2024.4在算力魔方上部署Llama-3.2-1B-Instruct模型

评论