10月13日最新消息,NVIDIA的DGX B200 AI服务器近期已在Broadberry上架,标价515,410美元(相当于约364.2万元人民币)。

自发布以来,Blackwell架构就备受业界瞩目,NVIDIA首席执行官黄仁勋对其赞誉有加,微软、Meta等科技巨头也迅速跟进采用。

DGX B200搭载了八块B200 GPU,配备高达1.4TB的GPU内存及64TB/s的HBM3E内存带宽。

据NVIDIA介绍,DGX B200可提供最高72 petaFLOPS的训练性能和144 petaFLOPS的推理性能,相较于前代产品,训练效能提升3倍,推理效能更是高达15倍。

在软件层面,NVIDIA DGX平台内含针对企业级开发和部署的NVIDIA AI Enterprise软件。用户还可利用DGX B200系统构建DGX SuperPOD,以打造一个支持大型开发团队运行多元化作业的AI卓越中心。

此外,值得注意的是,这是NVIDIA的Blackwell AI产品首次以零售方式亮相互联网。不久前,OpenAI还在社交平台上宣布收到了NVIDIA的首批DGX B200工程样机。

-

NVIDIA

+关注

关注

14文章

5087浏览量

103917 -

服务器

+关注

关注

12文章

9342浏览量

86207 -

AI

+关注

关注

87文章

31845浏览量

270674

发布评论请先 登录

相关推荐

英伟达或取消B100转用B200A代替

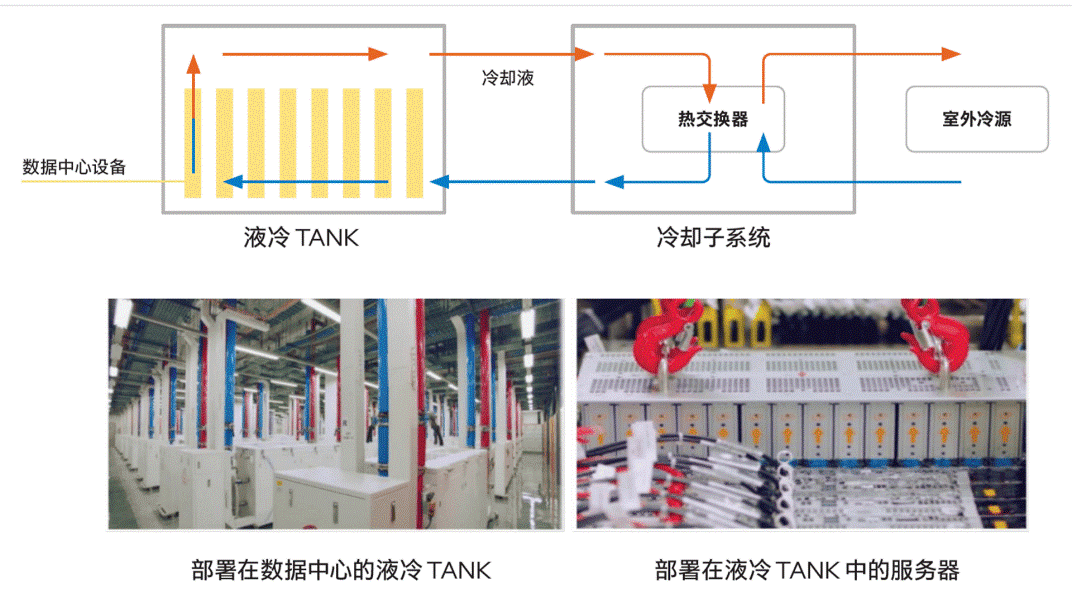

NVIDIA GB200超级芯片引领液冷散热新纪元

英伟达GPU新品规划与HBM市场展望

PUE的拯救者,液冷服务器

特斯拉加码AI布局:xAI将采购30万块英伟达B200芯片

进一步解读英伟达 Blackwell 架构、NVlink及GB200 超级芯片

OpenAI联手Nvidia发布首台Nvidia DGX H200

B200一经面市,就只能做弟弟?Cerebras '巨无霸'能否逆袭成功?

NVIDIA DGX B200首次面向零售市场:配备8块B200 GPU

NVIDIA DGX B200首次面向零售市场:配备8块B200 GPU

评论