深度学习系统很容易受到生成样本的攻击,对输入的参数进行细微的改变会导致网络输出变化,但人类肉眼却看不出什么差别。通常,这些对抗样本只对每个像素做少量调整,或者修改图像中少量像素。也就是说,大部分对抗样本都将重点放在对输入数据极小或不易察觉的改变上。

在这篇论文中,谷歌的研究人员探讨了如果分类器不再仅限于微小的改变,最终输出会是什么结果。他们构建了一个独立于图像的补丁,能让神经网络做出非常明显的反应。这个补丁可以放置在分类器视野内的任何地方,并让分类器输出一个目标类。因为这个补丁是独立于场景的,所以攻击样本无需提前了解光照条件、相机角度、分类器类型以及其他信息。

在VGG16上,用打印出的补丁对分类器进行攻击。分类器先将图片以97%的概率识别为“香蕉”;在下图添加补丁后,分类器以99%的概率将其识别为“烤面包机”

生成对抗补丁之后,补丁可以发布到网上供其他人打印或使用。此外,由于攻击会使用较大的扰动,目前的防御技术主要是针对较小扰动的,面对大扰动也许会不稳定。最近的研究表明,在MNIST上最先进的对抗训练模型仍然容易受到较大扰动的影响。

与以往不同,研究人员将补丁作为图像的一部分作为攻击,它可以变成任意形状,然后训练各种类型的图像,在每个图像上随机变换、缩放并旋转补丁,使用梯度下降进行优化。

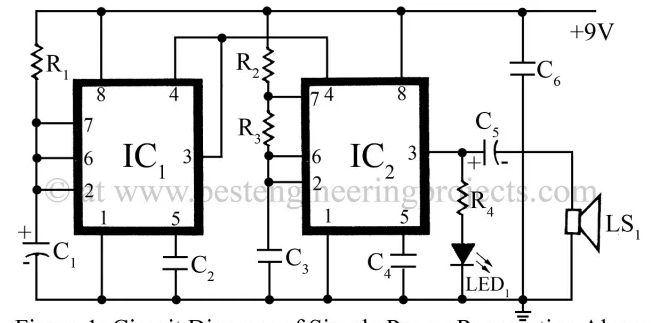

假设图片x∈Rw×h×c,补丁为p,补丁位置l,补丁变换为t,将补丁应用操作器(patch application operator)定义为A(p,x,l,t)。

操作器输入一个补丁、一个图片、一个位置以及任何补丁的变换,然后进行训练,优化识别出正确类别的概率。

为了得到训练后的补丁P^,我们在目标函数上训练:

X表示正在训练的一套图像,T是经过变换的补丁分布,L是图像位置的分布。

研究人员认为这种攻击利用了图像分类任务的构建方式。虽然图像可能包含多个对象,但只有一个目标标签是正确的。所以网络必须学会检测每一帧最“明显”的项目。对抗补丁通过生成比现实世界中的物体更显著的输入来利用这一特征。因此,在目标检测或图像分割模型受到攻击时,我们希望烤面包机补丁能被分类为烤面包机,而不影响图像的其他部分。

不同方法创造出对抗补丁的比较。成功率是将补丁放在图片顶部计算的。每张图片都经历了400张位置不同的补丁测试;同时又经历了400张不同大小补丁照片的测试

伪装成不同类别的补丁比较。研究人员发现他们可以改变补丁的样式,但仍然能骗过分类器

结果表明,这个通用、稳定、有针对性的补丁无论放在图片的哪个位置,都能成功骗过分类器,而且不需要提前了解场景信息。这些补丁还可以打印出来,在许多地方通用。

-

谷歌

+关注

关注

27文章

6211浏览量

106353 -

分类器

+关注

关注

0文章

152浏览量

13274 -

深度学习

+关注

关注

73文章

5524浏览量

121788

原文标题:谷歌推出对抗补丁,可导致分类器输出任意目标类

文章出处:【微信号:jqr_AI,微信公众号:论智】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

TLV5638输出电压在输入改变时钳在某一数值保持不变是什么原因?

ADS805E数字输入信号最小要3.5V,这个仅限于时钟信号CLK还是同时包括了输出使能信号OE?

言必信电源滤波器的适用性:不仅仅局限于用电稳定且消耗小的器材

XTR108电路输出电流永远是2mA左右,改变配置参数会有微小变动,为什么?

连接器的主要材料只有金属材料吗

变频器的分类有哪些

荣耀X40 GT、X40GT竞速版开启MagicOS 8.0公测招募

丰田与比亚迪合作仅限BEV领域,广汽丰田无DMI插混项目

Sabrent发布Rocket nano 2242固态硬盘:PCIe Gen4x4和M.2 2242规格

Windows 11预览版禁用"已连接设备"选项

小鹏P7价格下探至14.09万元,优惠仅限于新车

为什么称重传感器接大地,且系统使用开关电源供电时,AD 值会乱跳?

机器学习多分类任务深度解析

谷歌探讨了如果分类器不再仅限于微小的改变,最终输出会是什么结果

谷歌探讨了如果分类器不再仅限于微小的改变,最终输出会是什么结果

评论