BitEnergy AI公司,一家专注于人工智能(AI)推理技术的企业,其工程师团队创新性地开发了一种名为线性复杂度乘法(L-Mul)的AI处理方法。该方法的核心在于,它用整数加法替代了传统的浮点乘法(FPM),实现了算法上的简化。

尽管L-Mul采用了更简洁的算法,但其运算结果却能与浮点乘法相媲美,同时保持了高精确度和准确性。更为引人注目的是,这一新方法能够显著降低AI系统的功耗,最高降幅可达95%,这对于AI技术的未来发展具有重大意义。

然而,由于L-Mul是一种全新的工艺,目前市场上流行的现成硬件,如英伟达即将推出的Blackwell GPU,并未针对这种算法进行优化设计。因此,即便BitEnergy AI的算法已经证实能够达到与浮点乘法相同的性能水平,我们仍然需要能够处理该算法的系统。这可能会让一些已经在AI硬件上投入巨资的公司感到犹豫。但另一方面,功耗的大幅降低(最高95%)无疑会吸引大型科技公司的关注,尤其是如果AI芯片制造商能够研发出能够充分利用该算法的专用集成电路(ASIC)。

当前,电力已成为制约AI发展的关键因素。仅去年一年,全球售出的数据中心GPU所消耗的电力就超过了100万个家庭一年的用电量。就连谷歌也因AI对电力的巨大需求而调整了气候目标,其温室气体排放量自2019年以来增长了48%,与预期的逐年下降趋势背道而驰。谷歌前CEO甚至提出,通过放弃部分气候目标,转而利用更先进的AI技术来解决全球变暖问题,从而为电力生产开辟新的道路。

但如果AI处理能够变得更加节能,那么人类似乎可以在不牺牲地球环境的前提下,继续享受先进的AI技术带来的便利。此外,能源消耗下降95%还将减轻大型数据中心对国家电网的负担,减少对新能源工厂的建设需求,为未来快速供电提供有力支持。

-

AI

+关注

关注

87文章

30728浏览量

268886 -

人工智能

+关注

关注

1791文章

47183浏览量

238255

发布评论请先 登录

相关推荐

如何在STM32f4系列开发板上部署STM32Cube.AI,

使用全新NVIDIA AI Blueprint开发视觉AI智能体

AI for Science:人工智能驱动科学创新》第4章-AI与生命科学读后感

《AI for Science:人工智能驱动科学创新》第二章AI for Science的技术支撑学习心得

《AI for Science:人工智能驱动科学创新》第一章人工智能驱动的科学创新学习心得

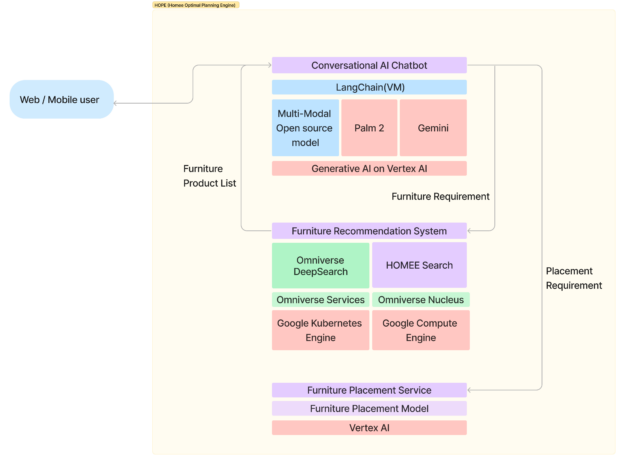

HOMEE AI利用NVIDIA Omniverse开发出“AI即服务”空间规划解决方案

BitEnergy AI公司开发出一种新AI处理方法

BitEnergy AI公司开发出一种新AI处理方法

评论