近日,据TechCrunch报道,麻省理工学院的研究团队展示了一种创新的机器人训练模型,该模型突破了传统模仿学习方法的局限,不再依赖标准数据集,而是借鉴了大型语言模型(LLM)如GPT-4等所使用的大规模信息处理方式,为机器人学习新技能开辟了全新的道路。

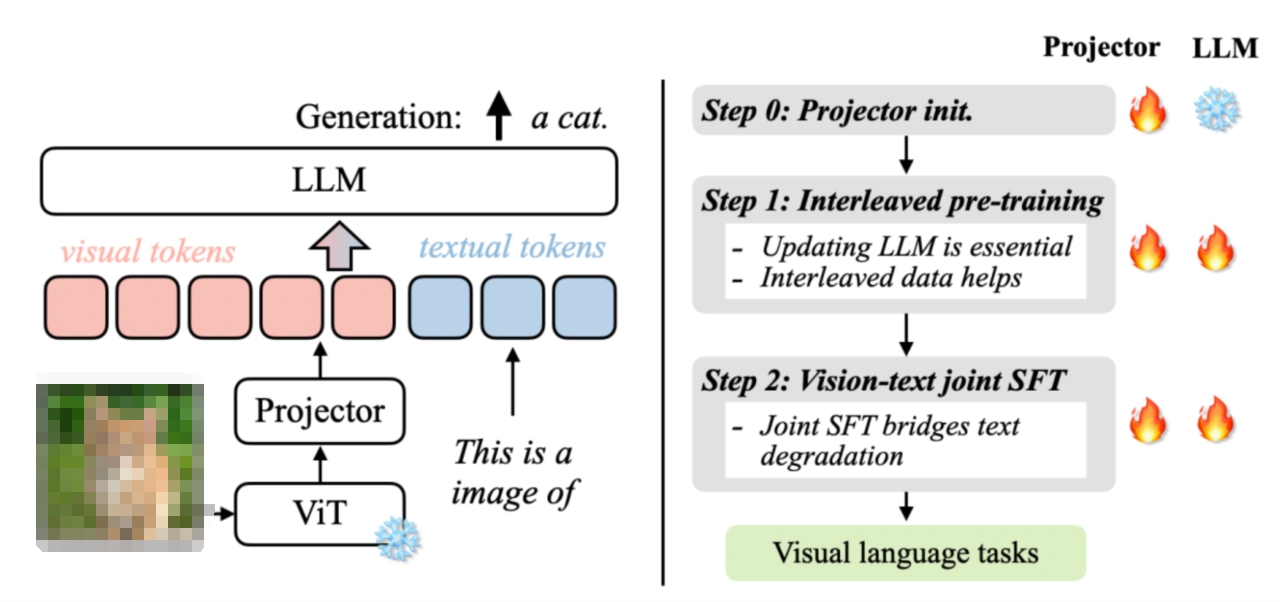

传统的模仿学习方法中,机器人通过观察和模仿执行任务的人类或其他代理进行学习。然而,这种方法在面对诸如照明变化、不同环境或新障碍等小挑战时,往往因为缺乏足够的数据而难以适应。为了克服这一难题,麻省理工学院的研究团队探索了一种新的解决方案,他们借鉴了大型语言模型的强大数据处理能力,并引入了异构预训练变压器(HPT)这一创新架构。

新论文的主要作者王立睿指出,与语言领域的数据以句子形式存在不同,机器人领域的数据具有高度的异质性。因此,如果想以类似语言模型的方式进行预训练,就需要构建一种全新的架构。HPT正是这样一种架构,它能够整合来自不同传感器和环境的多样信息,并利用变压器技术将这些数据汇总到训练模型中。值得注意的是,变压器的规模越大,其输出效果也越好。

在使用该新型训练模型时,用户只需输入机器人的设计、配置以及期望完成的任务,系统便能根据这些信息为机器人提供所需的技能。这一创新不仅提高了机器人学习的效率和灵活性,还为实现更广泛、更复杂的机器人应用奠定了坚实的基础。

卡内基梅隆大学副教授戴维·赫尔德对这项研究给予了高度评价。他表示,我们的梦想是拥有一个通用的机器人大脑,用户可以直接下载并使用它,而无需进行任何额外训练。虽然目前我们还处于这一愿景的早期阶段,但借助规模化的优势,我们有望在机器人策略方面取得像大型语言模型那样的突破性进展。

-

机器人

+关注

关注

211文章

28800浏览量

209108 -

LLM

+关注

关注

0文章

306浏览量

454

发布评论请先 登录

相关推荐

江苏理工学院莅临汉得利BESTAR公司考察交流

麻省理工学院研发全新纳米级3D晶体管,突破性能极限

24M开发出新隔离膜可降低电动汽车电池火灾风险

VILA与其他模型在提供边缘AI 2.0方面的表现

美国佐治亚理工学院一行莅临达实智能调研

贵州理工学院采购南京大展的DZ-STA200同步热分析仪

Al大模型机器人

麻省理工学院研发RoboGrocery系统,杂货店自动化装袋新篇章

感谢东莞理工学院对我司导热系数测试仪的认可

苏黎世联邦理工学院报告:Rowhammer攻击对高端RISC-V CPU的潜在风险

指南车机器人携同南昌工学院参观南京熊猫电子

一种用于化学和生物材料识别的便携式拉曼光谱解决方案

麻省理工与Adobe新技术DMD提升图像生成速度

霍尼韦尔与南方泵业开展战略合作,四川成都一家红外热成像专用图像处理芯片服务商完成A+轮融资

麻省理工学院推出新型机器人训练模型

麻省理工学院推出新型机器人训练模型

评论