在人工智能飞速发展的今天,大语言模型(LLM)为各个行业带来了全新的场景和机遇。诸如客户服务数字人,计算机辅助药物研发的生成式虚拟筛选,基于检索增强生成(RAG)的企业多模态 PDF 数据提取,网络安全流数据过滤、处理和分类优化等工作流,正在无缝集成和运行在定制化的企业 AI 应用,企业还能够基于专有业务数据和用户反馈数据,不断优化 AI 应用。

同时,企业也面临着如何高效、安全地部署 LLM 的挑战。阿里云计算巢基于 NVIDIA 加速计算技术,通过阿里云云市场为企业和开发者提供NVIDIA AI Enterprise软件套件,其包含了NVIDIA NIM Agent Blueprint、NVIDIA NIM和NVIDIA NeMo等企业级 AI 开发工作流和 AI 开发工具链。其中,NVIDIA NIM 提供可靠、高性能的 LLM 推理服务,结合阿里云计算巢实现一站式云上部署,助力企业加速实现 LLM 的 SaaS 化。

本文以 Llama3 为例,介绍该方案的整体架构和部署方式。

NVIDIA NIM:

易于使用的预构建容器工具

NVIDIA NIM 微服务是一套易于使用的预构建容器工具,目的是帮助企业客户在云、数据中心和工作站上安全、可靠地部署高性能 AI 模型。作为 NVIDIA AI Enterprise 的一部分,NIM 具备以下核心优势:

安全、灵活的部署:NIM 在不同环境的 CUDA GPU 加速基础设施和 Kubernetes 发行版中经过严格验证和基准测试,它支持企业在云、数据中心、工作站上安全可靠地部署高性能的 AI 推理,只需 5 分钟即可完成部署。

加速产品上市:企业通过预构建、持续维护的微服务,能够快速将产品推向市场,缩短开发周期。

开发者友好:开发者使用标准 API 和几行代码即可轻松将 NIM 集成到企业级 AI 应用程序中。

优化的推理引擎:NIM 基于Triton 推理服务器、TensorRT、TensorRT-LLM和 PyTorch 等强大的推理引擎构建, 提供行业领先的吞吐率、延迟和 token 生成速度,确保服务响应更快。

企业级支持:NIM 采用企业级基础容器构建,提供严格的验证、定期安全更新,适合企业生产环境部署。

阿里云计算巢:专为服务商

及其客户打造的云集成 PaaS 平台

阿里云计算巢服务是一个开放给企业应用服务商(包括:企业应用服务商、IT 集成服务商、交付服务商和管理服务提供商等)及其用户的服务管理 PaaS 平台,提供软件上云的“一站式”解决方案。

阿里云计算巢能提供软件的交付、部署、运维流程标准化的服务,支持软件和资源的一体化交付,真正实现了软件的开箱即用。

阿里云计算巢服务集成了阿里云一系列底层产品能力,通过通用的应用管控框架、租户管理框架,帮助服务商提升服务的交付效率、管理效率和服务能力,在提升用户满意度的同时降低运营成本;并为用户提供了统一管理多种应用服务的平台,提升用户使用服务的效率和安全性,降低用户获取服务和管理服务的成本。

方案介绍

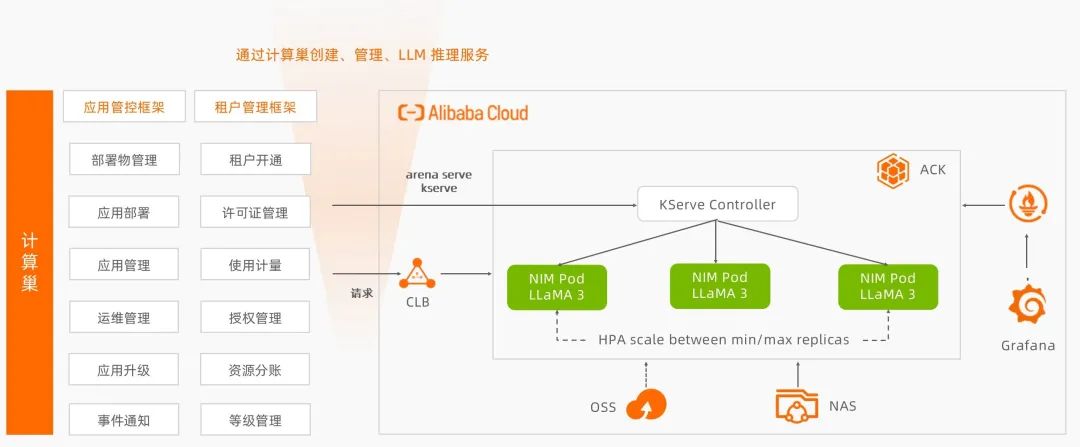

下图展示了通过阿里云计算巢快速部署 NVIDIA NIM 的整体架构。以 Llama3 为例,我们通过计算巢来创建、管理 LLM 推理服务:在阿里云容器服务 ACK (容器服务 Kubernetes 版)集群上,我们使用阿里云 ACK 的云原生 AI 套件,集成开源推理服务框架 KServe,来部署 NVIDIA NIM。

同时,结合 ACK 的 Prometheus 和 Grafana 监控服务,快速搭建监控大盘,实时观测推理服务状态;利用 NVIDIA NIM 提供丰富的监控指标,如 num_requests_waiting,配置推理服务弹性扩缩容策略。

这里列出的云上资源,以及阿里云弹性计算服务(ECS)、专有网络(VPC) 等基础资源,都可以通过计算巢来轻松配置,一键拉起,最终实现一个云上高性能、可实时观测、极致弹性的大语言模型推理服务。用户只需要根据该服务创建实例,便可部署该服务。

图 1. 通过阿里云计算巢快速部署

NVIDIA NIM 架构图

(图片来源于阿里云,如您有任何疑问或需要使用本图片,请联系阿里云)

部署流程

1. 参考 NVIDIA NIM 文档,生成NVIDIA NGC API Key,用于访问需要部署的模型镜像。以本文用到的 Llama-3-8B-Instruct 为例,可以通过NVIDIA NGC 目录来获取。

同时,请阅读并承诺遵守 Llama 模型的自定义可商用开源协议。

2. 在阿里云计算巢服务目录中找到“基于 NVIDIA NIM 快速部署 LLM 模型推理服务”,并进入实例部署页面。

如下图所示,主要配置服务的基本信息和云上资源,以及第一步中获取的 NVIDIA NGC API Key,需要填写在下图相应位置。

图 2. 在阿里云计算巢创建服务实例

(图片来源于阿里云,如您有任何疑问或需要使用本图片,请联系阿里云)

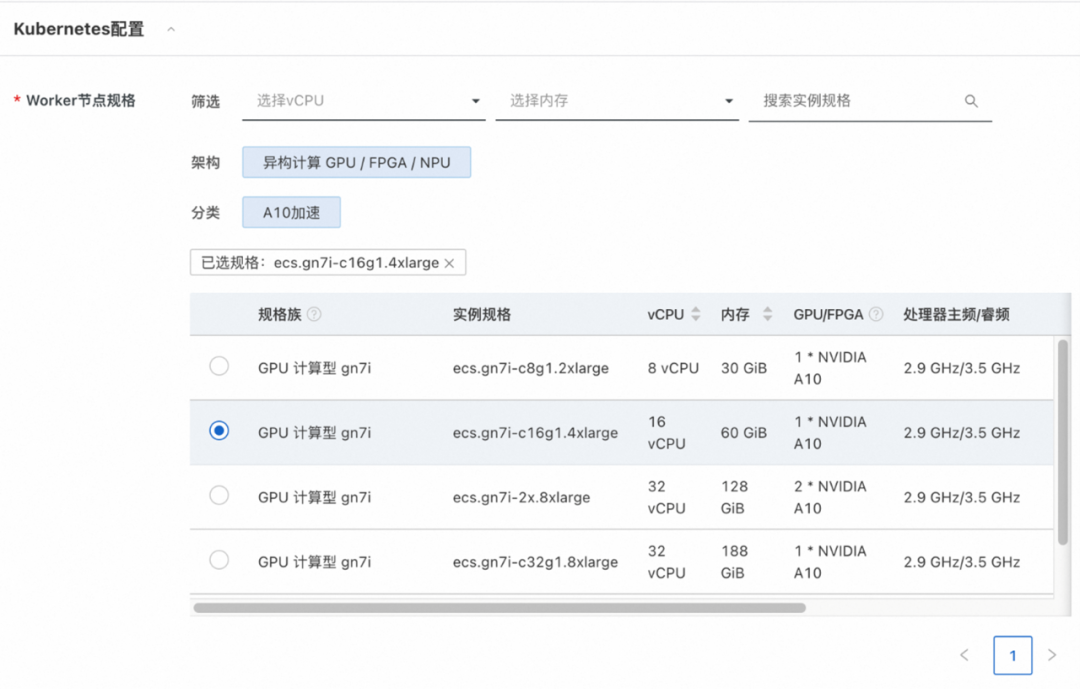

因为服务部署在阿里云 ACK 集群之上,这里也包含了 Kubernetes 配置:

图 3. 阿里云 ACK 集群上 Kubernetes

选项页面

(图片来源于阿里云,如您有任何疑问或需要使用本图片,请联系阿里云)

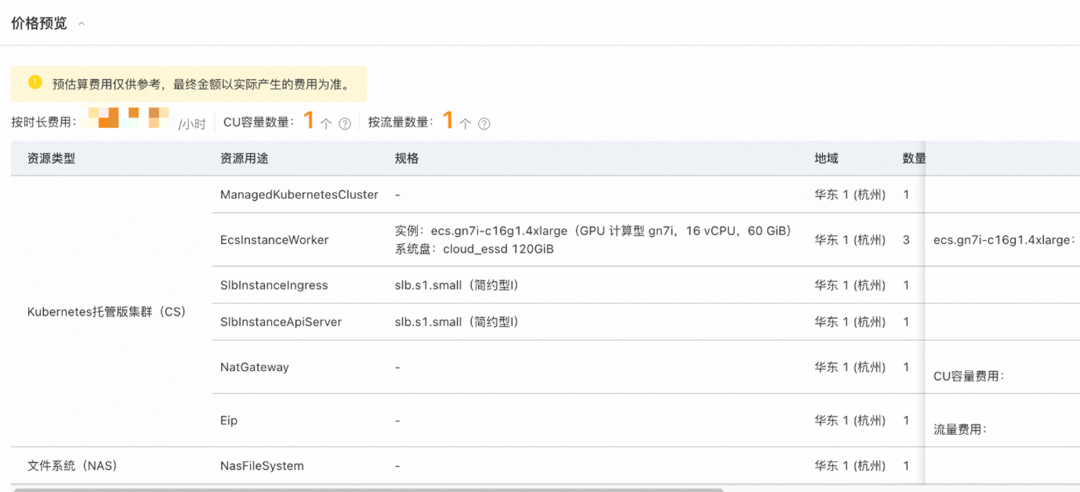

3. 按照页面提示完成所有配置之后,点击下一步:确认订单,在这里确认第 2 步配置的服务实例信息和价格预览。

图 4. 确认服务实例信息和价格预览

(图片来源于阿里云,如您有任何疑问或需要使用本图片,请联系阿里云)

部署过程中,用户需要创建和访问阿里云资源,当阿里云账号属于 RAM 账号时,需要开通以下权限,页面上也有开通这些权限的入口。

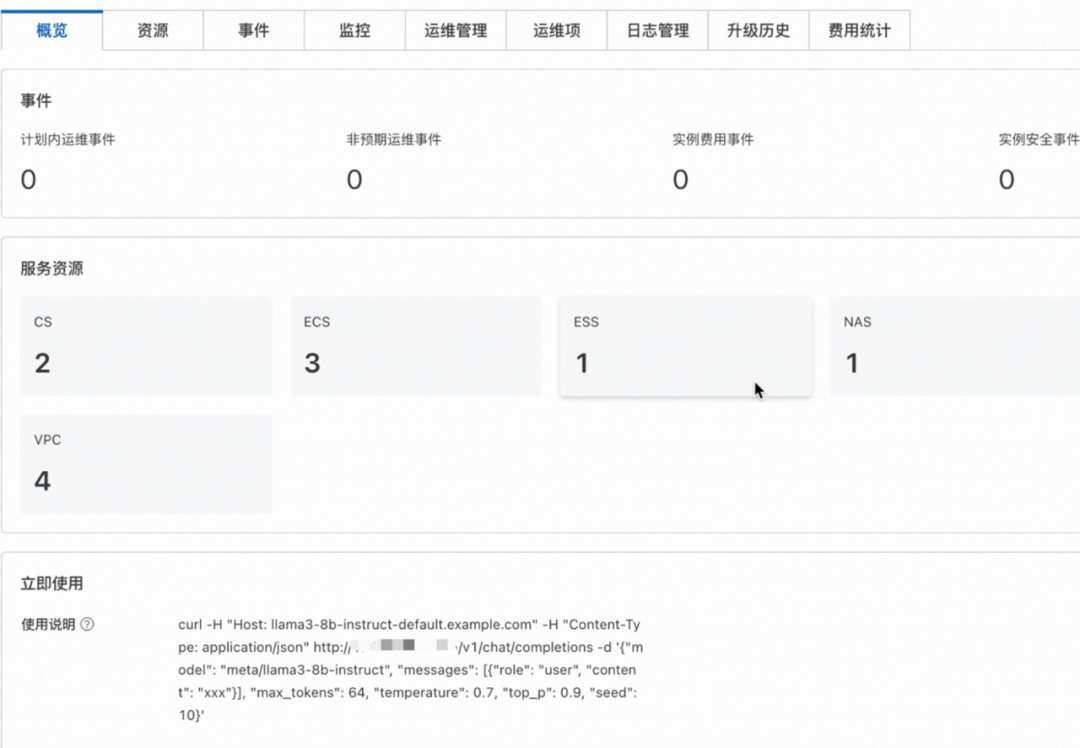

4. 点击立即创建,开始部署。过程中会涉及阿里云资源的创建、NIM 模型镜像的拉取等。拉取过程的日志,可通过”点击资源 tab-> 找到 ACK 集群->页面左侧的工作负载->无状态”来查看。部署完成后,进入服务实例详情查看使用说明。通过 curl 发送 HTTP 请求访问推理服务,修改 content 字段,便可自定义和推理服务交互的内容。

图 5. 服务实例详情页面截图

(图片来源于阿里云,如您有任何疑问或需要使用本图片,请联系阿里云)

通过阿里云的云市场获取

NVIDIA AI Enterprise 使用该方案

NVIDIA NIM 是 NVIDIA AI Enterprise 的一部分,正式使用时须获得 NVIDIA AI Enterprise 的许可证授权。现在,企业用户可以通过阿里云云市场获取 NVIDIA AI Enterprise 来使用该方案。阿里云市场提供了概念验证(PoC)测试服务和购买 NVIDIA AI Enterprise 许可证,共两个下单页面。

PoC 测试服务

提供 90 天 NVIDIA AI Enterprise PoC License,暨 90 天免费试用,而使用时须支付阿里云计算资源的费用。

通过阿里云的云市场购买 NVIDIA AI Enterprise 许可证

该页面提供的信息仅供参考,用户需要通过该页面的“NVIDIA 服务咨询”钉钉来沟通采购,最终通过云市场官网推送下单链接获取 NVIDIA AI Enterprise 许可证。

总结

本文介绍了通过阿里云计算巢快速部署 NVIDIA NIM 的方案收益和部署方式,该方案充分利用了 NIM 的安全与高性能的无缝 AI 推理功能,以及计算巢的软件一站式上云和交付能力,从而打造极致弹性、高性能、可实时观测的云上 LLM 推理服务。

作者信息

毛亦姝

NVIDIA 解决方案架构师,主要负责生成式 AI 模型的训练、推理在云上的落地,多年互联网算法工作经验。

-

NVIDIA

+关注

关注

14文章

4994浏览量

103186 -

AI

+关注

关注

87文章

31000浏览量

269333 -

人工智能

+关注

关注

1792文章

47354浏览量

238811 -

阿里云

+关注

关注

3文章

962浏览量

43100

原文标题:通过阿里云计算巢部署 NVIDIA NIM,加速企业大语言模型 SaaS 化

文章出处:【微信号:NVIDIA-Enterprise,微信公众号:NVIDIA英伟达企业解决方案】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

【产品活动】阿里云GPU云服务器年付5折!阿里云异构计算助推行业发展!

一张图看懂阿里云新发布的物联网设备上云神器——HiTSDB + IoT套件

阿里云弹性高性能计算产品商业化正式发布

AI开发者福音!阿里云推出国内首个基于英伟达NGC的GPU优化容器

阿里云免费使用及手册

阿里云专有宿主机(公测)发布

阿里云HPC助力新制造 | 上汽仿真计算云SSCC

阿里展示“云到端”整体方案

NVIDIA NIM 革命性地改变模型部署,将全球数百万开发者转变为生成式 AI 开发者

借助NVIDIA NIM加速AI应用部署

通过阿里云计算巢快速部署NVIDIA NIM

通过阿里云计算巢快速部署NVIDIA NIM

评论