在数据分析的早期阶段,探索性数据分析(EDA)是一种重要的方法,它帮助我们理解数据集的特征和结构。然而,原始数据往往包含错误、缺失值、异常值和不一致性,这些都可能影响分析结果。因此,在进行EDA之前,进行彻底的数据清洗是必不可少的。

1. 数据预处理

数据预处理是数据清洗的第一步,它包括数据导入、数据类型转换和数据结构调整。

- 数据导入 :将数据从各种来源(如CSV、Excel、数据库等)导入到分析工具中。

- 数据类型转换 :确保数据集中的每个变量都有正确的数据类型。例如,将日期字符串转换为日期类型,将数字字符串转换为数值类型。

- 数据结构调整 :根据分析需求调整数据结构,如将宽格式数据转换为长格式数据,或者合并多个数据表。

2. 数据转换

数据转换是将数据转换成适合分析的形式,包括规范化、标准化、编码类别变量和特征工程。

- 规范化 :将数据缩放到一个特定的范围,如0到1之间,以消除不同量纲的影响。

- 标准化 :将数据转换为均值为0,标准差为1的分布,以消除不同量纲的影响。

- 编码类别变量 :将类别变量转换为数值变量,如使用独热编码(One-Hot Encoding)或标签编码(Label Encoding)。

- 特征工程 :创建新的特征或修改现有特征以提高模型的性能,如从日期中提取年、月、日等。

3. 异常值检测和处理

异常值是那些与数据集中的其余值显著不同的值,它们可能是由于错误或自然变异造成的。

- 异常值检测 :使用统计方法(如IQR方法、Z分数、箱线图等)来识别异常值。

- 异常值处理 :根据异常值的性质和分析目标,选择适当的处理方法,如删除、替换或保留。

4. 缺失值处理

缺失值是数据分析中的常见问题,它们会影响模型的性能和结果的准确性。

- 缺失值识别 :识别数据集中的缺失值,包括完全缺失和部分缺失。

- 缺失值处理 :根据数据的重要性和缺失的模式,选择适当的处理方法,如删除、填充(如均值、中位数、众数填充)或使用模型预测缺失值。

5. 数据一致性检查

数据一致性检查是确保数据集中的值符合预期的格式和逻辑。

- 格式一致性 :检查数据是否符合预定的格式,如电话号码、电子邮件地址等。

- 逻辑一致性 :检查数据是否符合逻辑规则,如年龄不能为负数,日期不能在未来等。

- 数据完整性 :检查数据是否完整,如关键字段是否缺失,记录是否重复等。

6. 数据质量评估

在数据清洗后,进行数据质量评估是必要的,以确保数据清洗的效果。

- 统计摘要 :生成数据的描述性统计,如均值、中位数、最大值和最小值等。

- 可视化检查 :使用图表(如直方图、箱线图、散点图等)来直观地检查数据的分布和关系。

- 一致性测试 :进行逻辑测试和验证,以确保数据的一致性和完整性。

7. 数据清洗的自动化

随着数据量的增加,手动进行数据清洗变得越来越不切实际。因此,自动化数据清洗变得越来越重要。

- 编写脚本 :使用编程语言(如Python、R等)编写数据清洗脚本,以自动化数据预处理、转换和清洗过程。

- 使用数据清洗工具 :利用现有的数据清洗工具和库(如Pandas、OpenRefine等)来简化数据清洗工作。

- 持续监控 :建立数据监控系统,以持续跟踪数据质量,并在数据进入分析流程之前进行清洗。

结论

数据清洗是探索性数据分析中的关键步骤,它直接影响到分析结果的准确性和可靠性。通过遵循上述步骤,我们可以有效地清洗数据,为后续的分析打下坚实的基础。随着技术的发展,自动化和智能化的数据清洗工具将进一步提高数据清洗的效率和效果。

-

数据

+关注

关注

8文章

7134浏览量

89520 -

eda

+关注

关注

71文章

2785浏览量

173774 -

自动化

+关注

关注

29文章

5620浏览量

79612

发布评论请先 登录

相关推荐

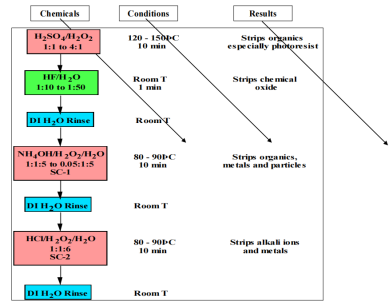

8寸晶圆的清洗工艺有哪些

数据可视化与数据分析的关系

LLM在数据分析中的作用

如何使用SQL进行数据分析

eda与传统数据分析的区别

数据分析有哪些分析方法

卷积神经网络的一般步骤是什么

硅晶片清洗:半导体制造过程中的一个基本和关键步骤

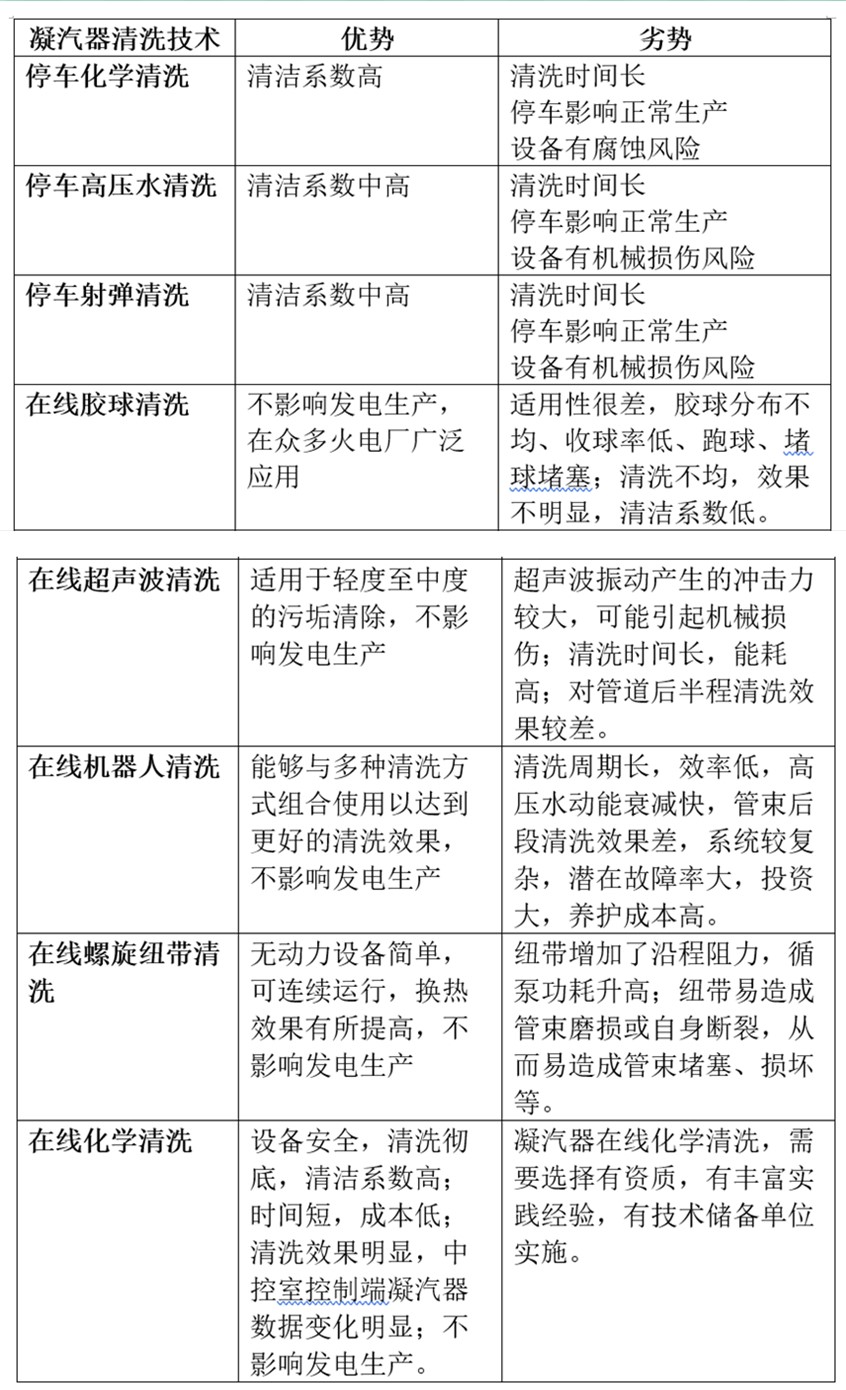

火电厂凝汽器不停车在线清洗与凝汽器停车清洗八种技术对比分析

eda分析中的数据清洗步骤

eda分析中的数据清洗步骤

评论