感谢众多用户及合作伙伴一直以来对NVIDIA TensorRT-LLM的支持。TensorRT-LLM 的 Roadmap 现已在 GitHub 上公开发布!

TensorRT-LLM

持续助力用户优化推理性能

TensorRT-LLM 可在 NVIDIA GPU 上加速和优化最新的大语言模型(Large Language Models)的推理性能。该开源程序库在 /NVIDIA/TensorRT-LLM GitHub 资源库中免费提供。

近期,我们收到了许多用户的积极反馈,并表示,TensorRT-LLM 不仅显著提升了性能表现,还成功地将其应用集成到各自的业务中。TensorRT-LLM 强大的性能和与时俱进的新特性,为客户带来了更多可能性。

Roadmap 现已公开发布

过往,许多用户在将 TensorRT-LLM 集成到自身软件栈的过程中,总是希望能更好地了解 TensorRT-LLM 的 Roadmap。即日起,NVIDIA 正式对外公开 TensorRT-LLM 的 Roadmap ,旨在帮助用户更好地规划产品开发方向。

我们非常高兴地能与用户分享,TensorRT-LLM 的 Roadmap 现已在 GitHub 上公开发布。您可以通过以下链接随时查阅:

https://github.com/NVIDIA/TensorRT-LLM

图 1. NVIDIA/TensorRT-LLM GitHub 网页截屏

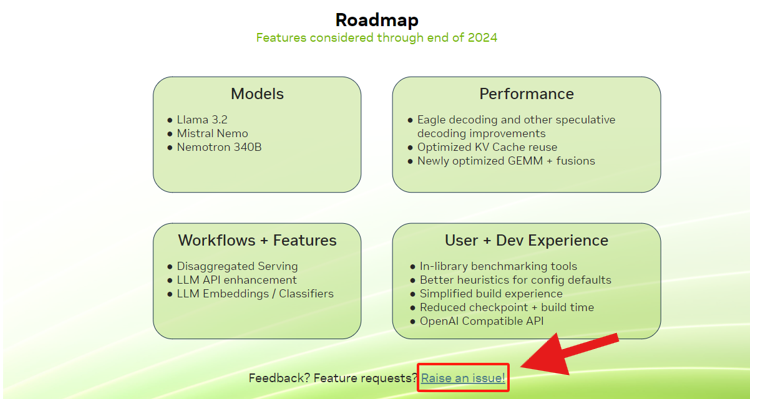

这份 Roadmap 将为您提供关于未来支持的功能、模型等重要信息,助力您提前部署和开发。

同时,在 Roadmap 页面的底部,您可通过反馈链接提交问题。无论是问题报告还是新功能建议,我们都期待收到您的宝贵意见。

图 2.Roadmap 整体框架介绍

利用 TensorRT-LLM

优化大语言模型推理

TensorRT-LLM 是一个用于优化大语言模型(LLM)推理的库。它提供最先进的优化功能,包括自定义 Attention Kernel、Inflight Batching、Paged KV Caching、量化技术(FP8、INT4 AWQ、INT8 SmoothQuant 等)以及更多功能,以让你手中的 NVIDIA GPU 能跑出极致推理性能。

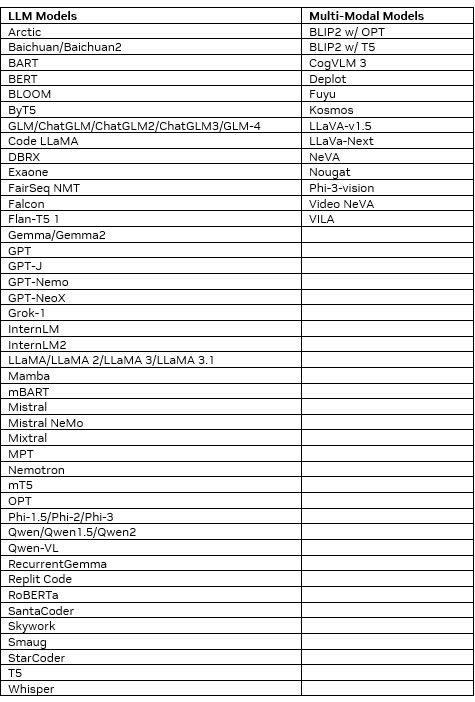

TensorRT-LLM 已适配大量的流行模型。通过类似 PyTorch 的 Python API,可以轻松修改和扩展这些模型以满足自定义需求。以下是已支持的模型列表。

我们鼓励所有用户定期查阅 TensorRT-LLM Roadmap。这不仅有助于您及时了解 TensorRT-LLM 的最新动态,还能让您的产品开发与 NVIDIA 的技术创新保持同步。

-

NVIDIA

+关注

关注

14文章

4991浏览量

103140 -

GitHub

+关注

关注

3文章

471浏览量

16464 -

LLM

+关注

关注

0文章

289浏览量

351

原文标题:NVIDIA TensorRT-LLM Roadmap 现已在 GitHub 上公开发布!

文章出处:【微信号:NVIDIA-Enterprise,微信公众号:NVIDIA英伟达企业解决方案】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

在NVIDIA TensorRT-LLM中启用ReDrafter的一些变化

解锁NVIDIA TensorRT-LLM的卓越性能

TensorRT-LLM低精度推理优化

NVIDIA Nemotron-4 340B模型帮助开发者生成合成训练数据

魔搭社区借助NVIDIA TensorRT-LLM提升LLM推理效率

Mistral Large 2现已在Amazon Bedrock中正式可用

NVIDIA 通过 Holoscan 为 NVIDIA IGX 提供企业软件支持

NVIDIA加速微软最新的Phi-3 Mini开源语言模型

Mistral Large模型现已在Amazon Bedrock上正式可用

基于NVIDIA Megatron Core的MOE LLM实现和训练优化

ServiceNow、Hugging Face 和 NVIDIA 发布全新开放获取 LLM,助力开发者运用生成式 AI 构建企业应用

NVIDIA TensorRT-LLM Roadmap现已在GitHub上公开发布

NVIDIA TensorRT-LLM Roadmap现已在GitHub上公开发布

评论