日前,加州大学的研究人员携手英伟达,共同推出了一款创新的视觉语言模型——NaVILA。该模型在机器人导航领域展现出了独特的应用潜力,为智能机器人的自主导航提供了一种全新的解决方案。

视觉语言模型(VLM)是一种具备多模态生成能力的先进AI模型。它能够智能地处理文本、图像以及视频等多种提示,并通过复杂的推理过程,实现对这些信息的准确理解和应用。NaVILA正是基于这一原理,通过将大型语言模型(LLM)与视觉编码器进行巧妙的结合,从而赋予了LLM“视觉感知”的神奇能力。

这一创新性的结合,使得NaVILA在机器人导航领域展现出了卓越的性能。它能够根据环境中的视觉信息,结合文本指令或描述,为机器人提供精确的定位和导航服务。这一特性不仅提高了机器人的自主性和智能化水平,还为机器人在复杂环境中的应用提供了更加广阔的空间。

NaVILA的发布,标志着视觉语言模型在机器人导航领域取得了重要的突破。未来,随着技术的不断发展和完善,相信NaVILA将在更多领域展现出其独特的价值和潜力,为人工智能技术的发展和应用贡献更多的力量。

-

机器人

+关注

关注

212文章

29061浏览量

210227 -

语言模型

+关注

关注

0文章

551浏览量

10502 -

英伟达

+关注

关注

22文章

3893浏览量

92628

发布评论请先 登录

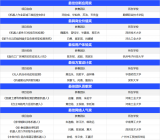

相关推荐

英伟达Cosmos-Reason1 模型深度解读

英伟达发布Nemotron-CC大型AI训练数据库

英伟达Blackwell可支持10万亿参数模型AI训练,实时大语言模型推理

英伟达推出Eagle系列模型

英伟达推出Flextron AI框架:赋能灵活高效的AI模型部署

商汤科技与泰国DTGO集团联合发布泰语大模型

NaVILA:加州大学与英伟达联合发布新型视觉语言模型

NaVILA:加州大学与英伟达联合发布新型视觉语言模型

评论