案例简介

本案例中鲁班系统高性能 CAE 软件利用 NVIDIA 高性能 GPU,实现复杂产品的快速仿真,加速产品开发和设计迭代,缩短开发周期,提升产品竞争力。

本案例主要应用到NVIDIA CUDA技术。

鲁班系统高性能 CAE 软件

落地场景

CAE 仿真在现代制造业中广泛应用,在汽车、船舶、电子等行业是产品研发的核心工具软件。CAE 仿真软件的价值在于用虚拟实验替代真实测试,从而加速研发进程并降低成本。CAE 软件本身的计算速度是 CAE 行业最关键的要素,决定了企业的研发效率,从而影响了企业的产品竞争力。

近十余年的时间,高性能计算的硬件在算力方面获得了飞速的发展,同期在 CAE 力学仿真计算中,软件的计算效率却只获得了有限的提升。CAE 计算效率的停滞成为企业研发能力快速提升的制约因素。

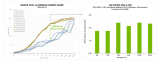

鲁班系统开发了基于 GPU 的超高性能的 CAE 软件,解决了高科技、电子、汽车、机械等行业 CAE 仿真中的效率挑战。鲁班系统科技创新性地提出了双异构物理仿真并行计算框架,充分发挥 GPU 与 CPU 在高性能计算过程中各自的优势。通过利用 GPU 卓越的计算能力和带宽,在复杂物理场景中(如汽车碰撞仿真和电子产品跌落测试)首次实现了相较于原来 50 至 100 倍以上的计算加速。这显著缩短了产品研发设计迭代周期,缩短产品上市时间,提升了制造业企业的商业收益。

在产品仿真方面

面临的挑战

随着先进制造业研发技术的发展和计算机辅助工程(CAE)的广泛应用,企业在产品仿真方面面临诸多挑战。目前大多数 CAE 软件主要依赖 CPU 计算,导致性能较低。为了满足企业大量的 CAE 计算需求,企业往往需要购买大量高性能计算服务器。例如,消费电子企业通常需要投入数以亿计的成本购买 CPU 服务器进行 CAE 仿真计算。但在此种情况下,一个产品设计方案 CAE 分析过程仍然需要经过数十小时的时间。CAE 仿真计算效率成为产品研发迭代的主要瓶颈环节。

为应对这些挑战,必须通过硬件加速、并行计算等技术赋能整个 CAE 软件行业。特别是利用最新的 GPU 加速技术至关重要,以缓解 CPU 计算能力不足的问题。通过建立 CPU+GPU 异构计算环境,制造业企业可以显著提高仿真效率,减少所需服务器数量,降低时间成本。当前阶段,在例如力学仿真等主要的 CAE 软件行业市场鲜少有通用的基于 GPU 实现大幅加速的仿真软件。

使用NVIDIA CUDA 技术解决方案

针对当前 CAE 仿真面临的挑战,鲁班系统科技积极采用 NVIDIA CUDA 技术对 CAE 仿真计算进行加速,通过引入最新的 GPU 硬件技术,显著提高了 CAE 仿真计算效率。这一技术进步不仅大幅提升了仿真计算速度,还极大地优化了系统级产品设计和仿真迭代的效率。借助 GPU 的强大计算能力,鲁班系统能够在大规模复杂仿真场景中实现前所未有的性能提升,使得企业能够在产品研发的早期阶段进行更多轮次的虚拟仿真验证,加快设计优化的进程,从而减少产品上市时间,提升市场竞争力。

在底层求解器方面,鲁班系统科技提出了双异构物理仿真并行计算框架,这一创新性架构充分发挥了 GPU 和 CPU 各自的优势。具体来说,GPU 以其卓越的并行计算能力和高带宽内存,在处理复杂计算任务时能够显著提高计算速度,而 CPU 则在执行逻辑性较强的任务时表现出其独特的优势。通过合理分配任务,鲁班系统能够充分利用两者的优势,实现高效的计算任务分配和并行处理,从而在高度复杂的物理仿真场景中实现 50 到 100 倍的计算加速。这一突破性的进展,使得许多以前需要数天或数周才能完成的仿真任务,能够在几小时内完成,极大缩短了仿真分析的时间。

以数千万网格规模的大型力学仿真计算为例,传统的仿真方法往往需要长时间的计算和分析,且难以在短时间内迭代优化。而通过鲁班系统科技采用的 GPU 加速方案,原本需要一周时间完成的仿真任务,现在仅需几个小时即可完成,这使得企业在产品设计和研发阶段能够更频繁地进行仿真验证。借助鲁班系统的超高速仿真计算能力,客户能够快速识别产品设计中的潜在风险和缺陷,及时调整设计方案,确保产品在上市前达到最佳性能。这样的仿真加速不仅优化了产品设计的准确性,还缩短了仿真迭代周期,显著提高了产品的研发效率和市场响应速度。

基于 NVIDIA CUDA

技术的使用效果与影响

鲁班系统通过结合最新的 GPU 加速技术,突破了传统 CAE 仿真计算的瓶颈,显著提升了企业的研发效率。通过基于 NVIDIA 高性能 GPU 的强大并行计算能力,鲁班系统能够大幅加速仿真任务的计算速度。此外, GPU 加速使得设计优化和虚拟验证更加高效,企业能够在更短时间内完成多轮设计迭代,及时识别潜在风险和缺陷。这样的效率提升不仅缩短了产品从设计到上市的周期,还降低了研发成本,帮助企业更快响应市场需求,增强了市场竞争力。

“以智能手机产品的研发为例,现在高端制造业产品研发的特点是研发活动密集、开发周期短、产品竞争力要求高且设计可继承性差。研发的质量和效率一直是先进制造业企业竞争力和商业成功的关键因素。仿真技术的应用在提升消费电子企业研发能力方面起着至关重要的作用。仿真软件的计算效率在消费电子产品设计迭代中具有决定性作用。鲁班系统应用基于 GPU 计算的高性能仿真计算技术,显著提升了系统级仿真的效率,从而提高了产品研发效率。基于 GPU 的高性能求解技术的成熟应用将改变消费电子行业的产品开发模式,实现更高效的仿真能力,提升消费电子产品的竞争力和企业盈利能力。”鲁班系统科技 CEO 常金涛表示。

NVIDIA 初创加速计划

NVIDIA 初创加速计划 (NVIDIA Inception)为免费会员制,旨在培养颠覆行业格局的优秀创业公司。该计划联合国内外知名的风投机构、创业孵化器、创业加速器、行业合作伙伴以及科技创业媒体等,打造创业加速生态系统。能够提供产品折扣、技术支持、市场宣传、融资对接、业务推荐等一系列服务,加速创业公司的发展。

-

NVIDIA

+关注

关注

14文章

4986浏览量

103050 -

gpu

+关注

关注

28文章

4739浏览量

128945 -

仿真

+关注

关注

50文章

4082浏览量

133602 -

CAE

+关注

关注

0文章

77浏览量

23444

原文标题:初创加速计划 | 利用 NVIDIA 高性能 GPU,鲁班系统重新定义 CAE 计算效率

文章出处:【微信号:NVIDIA_China,微信公众号:NVIDIA英伟达】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

《CST Studio Suite 2024 GPU加速计算指南》

AMD与NVIDIA GPU优缺点

魔搭社区借助NVIDIA TensorRT-LLM提升LLM推理效率

NVIDIA全面转向开源GPU内核模块

借助NVIDIA超级计算机加速量子计算发展

利用AI和加速计算提升天气预报效率和能效

NVIDIA 通过 Holoscan 为 NVIDIA IGX 提供企业软件支持

进一步解读英伟达 Blackwell 架构、NVlink及GB200 超级芯片

利用NVIDIA组件提升GPU推理的吞吐

NVIDIA 发布全新交换机,全面优化万亿参数级 GPU 计算和 AI 基础设施

NVIDIA RTX GPU助力打造城市新区绿化

利用NVIDIA产品技术组合提升用户体验

如何选择NVIDIA GPU和虚拟化软件的组合方案呢?

借助NVIDIA GPU提升鲁班系统CAE软件计算效率

借助NVIDIA GPU提升鲁班系统CAE软件计算效率

评论