作者:算力魔方创始人/英特尔边缘计算创新大使 刘力

前面我们分享了《在算力魔方上本地部署Phi-4模型》,实现了在边缘端获得Llama 3.3 70B模型差不多的能力。还分享,《如何在边缘端获得类似GPT4-V的能力:MiniCPM-V 2.6 》。本文将分享在本地运行能与OpenAI-o1 能力相媲美的DeepSeek-R1模型。

[编者注]:OpenAI-o1是OpenAI 于2024年9月12日发布的针对复杂推理问题的全新大模型,也就是Sam一直说的“草莓”。该模型一经发布就引起了巨大关注,它能在回答问题之前能够进行更长时间的“深度思考”,且思考时间越长,推理质量越高。

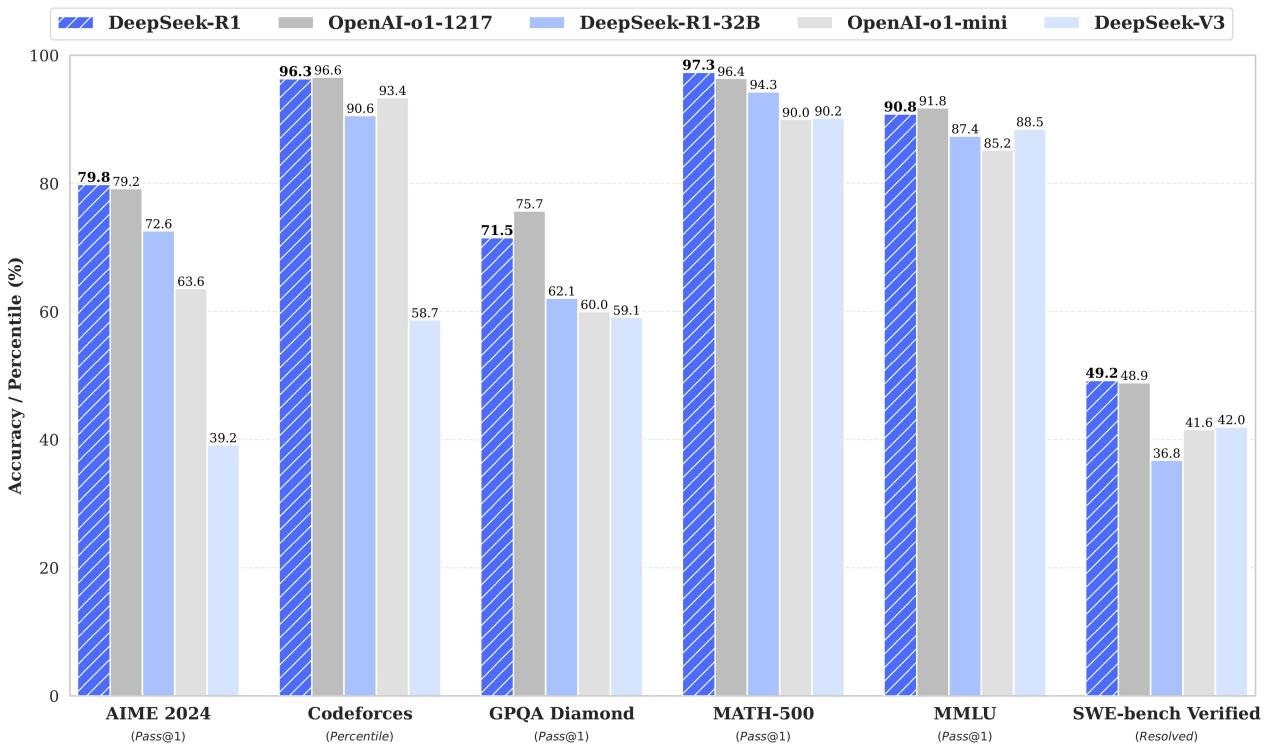

2025年1月20日,DeepSeek 正式开源 DeepSeek-R1 推理模型,其能力跟OpenAI-o1正式版差不多,另外还提供经过蒸馏,能在本地运行的小模型,其能力跟 OpenAI-O1-mini 近似:

参考链接:https://github.com/deepseek-ai/DeepSeek-R1

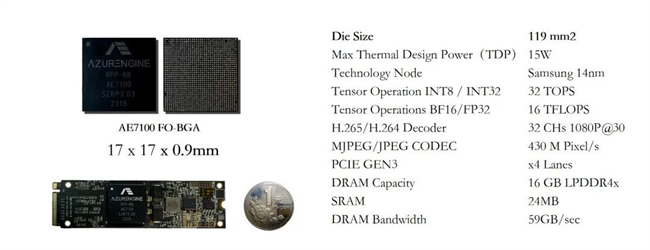

本文将分享DeepSeek-R1-Distill-Qwen-7B模型在算力魔方®4060版上的部署过程。

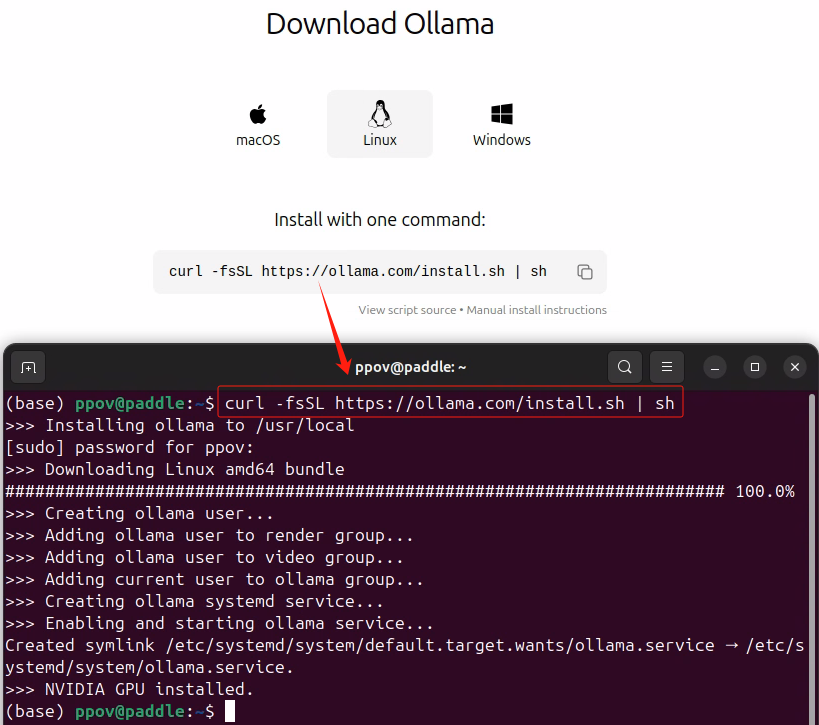

一,安装Ollama

请按照《Gemma 2+Ollama在算力魔方上帮你在LeetCode解题》安装Ollama。

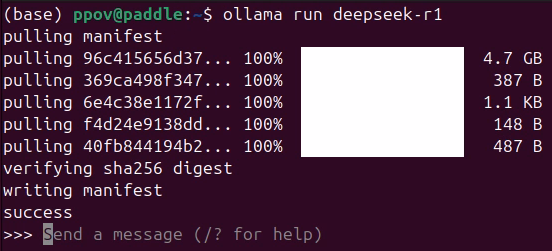

二,运行DeepSeek-R1-Distill-Qwen-7B

使用下面的命令完成运行DeepSeek-R1-Distill-Qwen-7B:

ollama run deepseek-r1

三,体验DeepSeek-R1的数学、代码和推理能力

输入下面的提示词,体验DeepSeek-R1的数学、代码和推理能力:

忒修斯之船悖论测试推理能力:“如果一艘船的所有部件都被替换,它还是原来的船吗?请从哲学、物理和逻辑学角度分别分析,并尝试提出一个自洽的解决方案?”

高阶数学推理测试数学能力:“证明:在三维欧几里得空间中,不存在五个两两正交的非零向量。请分步骤说明逻辑推导过程,并检查是否存在拓扑学或线性代数视角的替代证明方法。”

极端场景处理测试编程能力:“编写C程序实现高精度温度传感器数据处理,要求:1,在内存<2KB的嵌入式设备运行;2,能处理传感器噪声(Kalman滤波)。给出防止整型溢出和浮点误差的具体策略。”

视频链接如下:

https://live.csdn.net/v/460546

四,总结

使用Ollama可以方便快捷的将DeepSeek-R1模型本地化部署在算力魔方®上,让您获得强大的数学、代码和推理能力。

如果你有更好的文章,欢迎投稿!

稿件接收邮箱:nami.liu@pasuntech.com

更多精彩内容请关注“算力魔方®”!

审核编辑 黄宇

-

AI

+关注

关注

87文章

33258浏览量

273527 -

OpenAI

+关注

关注

9文章

1193浏览量

7236 -

DeepSeek

+关注

关注

1文章

730浏览量

831

发布评论请先 登录

相关推荐

如何使用OpenVINO运行DeepSeek-R1蒸馏模型

了解DeepSeek-V3 和 DeepSeek-R1两个大模型的不同定位和应用选择

RK3588开发板上部署DeepSeek-R1大模型的完整指南

对标OpenAI o1,DeepSeek-R1发布

芯动力神速适配DeepSeek-R1大模型,AI芯片设计迈入“快车道”!

deepin UOS AI接入DeepSeek-R1模型

超星未来惊蛰R1芯片适配DeepSeek-R1模型

OpenAI O3与DeepSeek R1:推理模型性能深度分析

香橙派发布OrangePi 5Plus本地部署Deepseek-R1蒸馏模型指南

赶紧在本地运行与OpenAI-o1能力近似的DeepSeek-R1模型

赶紧在本地运行与OpenAI-o1能力近似的DeepSeek-R1模型

评论