Hugging Face平台于1月23日发布博文,推出了两款令人瞩目的轻量级AI模型——SmolVLM-256M-Instruct和SmolVLM-500M-Instruct。

其中,SmolVLM-256M-Instruct仅有2.56亿参数,是有史以来发布的最小视觉语言模型,可在内存低于1GB的PC上运行并提供卓越性能。SmolVLM-500M-Instruct有5亿参数,主要针对硬件资源限制,帮助开发者应对大规模数据分析挑战。

这两款模型具备先进的多模态能力,可执行图像描述、短视频分析以及回答关于PDF或科学图表的问题等任务。其开发依赖于The Cauldron和Docmatix两个专有数据集。The Cauldron包含50个高质量图像和文本数据集,侧重于多模态学习;Docmatix专为文档理解定制,将扫描文件与详细标题配对以增强理解。

此外,模型采用了更小的视觉编码器SigLIP base patch-16/512,通过优化图像标记处理方式,减少了冗余,还将图像编码速率提升至每个标记4096像素,相比早期版本的每标记1820像素有了显著改进。

Hugging Face此次推出的最小AI视觉语言模型,为AI在低资源设备上的应用开辟了新的道路。

-

人工智能

+关注

关注

1796文章

47643浏览量

240107 -

语言模型

+关注

关注

0文章

538浏览量

10339 -

AI视觉

+关注

关注

0文章

66浏览量

4506

发布评论请先 登录

相关推荐

AI大语言模型开发步骤

NaVILA:加州大学与英伟达联合发布新型视觉语言模型

大语言模型开发语言是什么

谷歌全新推出开放式视觉语言模型PaliGemma

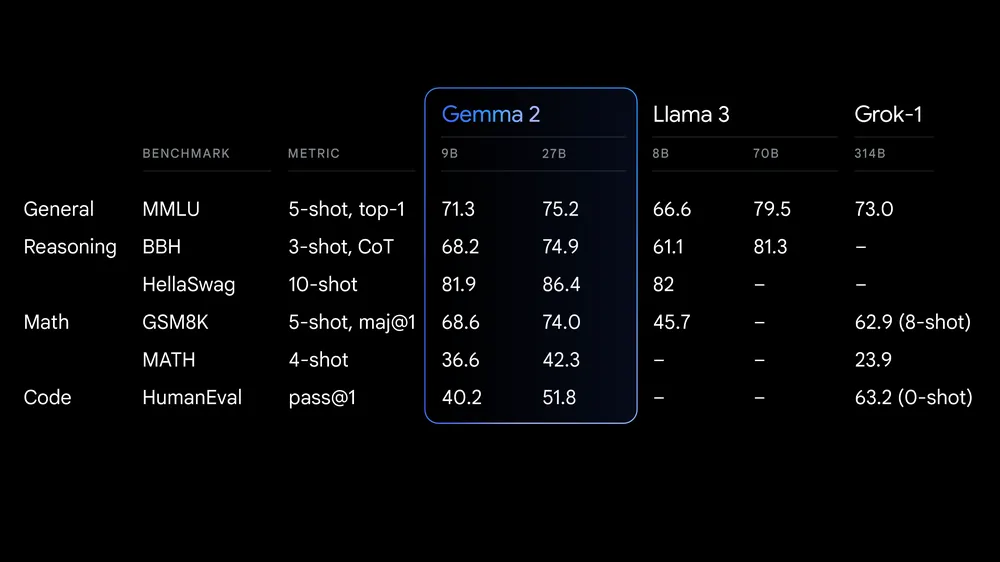

谷歌推出效率与性能跃阶的全新开放模型标准

借助Arm Neoverse加速Hugging Face模型

Hugging Face科技公司推出SmolLM系列语言模型

亚马逊云携手AI新创企业Hugging Face,提升AI模型在定制芯片计算性能

Hugging Face提供1000万美元免费共享GPU

Hugging Face推出开源机器人代码库LeRobot

Snowflake推出面向企业AI的大语言模型

【大语言模型:原理与工程实践】大语言模型的基础技术

Stability AI发布Stable Code Instruct 3B大语言模型,可编译多种编程语言

ServiceNow、Hugging Face 和 NVIDIA 发布全新开放获取 LLM,助力开发者运用生成式 AI 构建企业应用

Hugging Face推出最小AI视觉语言模型

Hugging Face推出最小AI视觉语言模型

评论