日前,为了使 deepin 和 UOS AI 更加开放,我们正式开放了 UOS AI 的模型接入接口。这意味着,所有符合 OpenAI 接口格式的大模型,都可以无缝接入 UOS AI。大家可以根据自身需求,自由接入心仪的大模型,让 UOS AI 成为更具个性化的智能伙伴。

在上一篇文章中,我们为大家详细介绍了 UOS AI 如何离线或在线接入 DeepSeek-R1 模型。今天我们将进一步深入,为大家详细讲解如何借助 Ollama 在本地部署并运行 DeepSeek-R1 模型。

* 感谢社区用户「Feelup」提供的教程,本次本地部署在 deepin 25 Preview 环境中通过Ollama 完成。

1

Ollama 部署

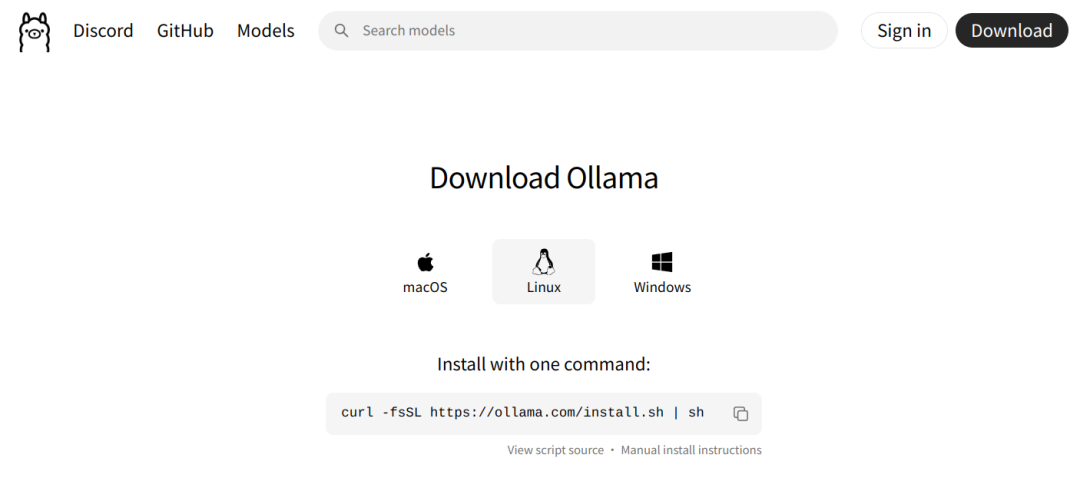

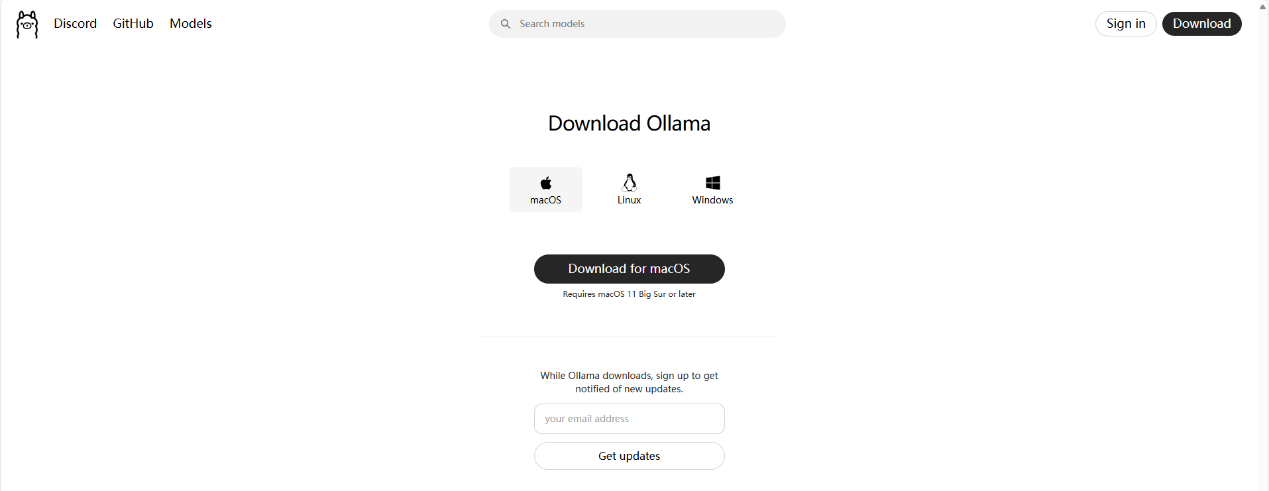

进入 Ollama 网站并复制 Linux 下需要使用的命令,并粘贴到终端中执行。

Ollama下载完成后,通过以下命令可查看当前 Ollama 版本

ollama --version

2

Ollama 服务配置

说明1:若您只希望简单使用,可跳过此处服务配置。 说明2:此处 Ollama 服务配置主要调整了 Ollama 下载模型文件的保存位置和服务访问限制调整。

sudo vim /etc/systemd/system/ollama.service默认的配置文件内容

[Unit] Description=Ollama Service After=network-online.target [Service] ExecStart=/usr/local/bin/ollama serve User=ollama Group=ollama Restart=always RestartSec=3 Environment="PATH=/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/sbin:/bin:/usr/games:/usr/local/games:/snap/bin" [Install] WantedBy=default.target

非 deepin 25 服务修改参考

该 Ollama 服务配置适用于 Ubuntu、RedHat、deepin 23 等大多数 Linux 系统

[Unit] Description=Ollama Service After=network-online.target [Service] ExecStart=/usr/local/bin/ollama serve User=nano #此处为当前的用户名(可选:如果调整了模型的下载保存位置的话,可解决权限问题) Group=nano #此处为当前的用户名(可选:如果调整了模型的下载保存位置的话,可解决权限问题) Restart=always RestartSec=3 Environment="PATH=/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/sbin:/bin:/usr/games:/usr/local/games:/snap/bin" Environment="OLLAMA_MODELS=/media/nano/Date/Ollama_Models" #可选:设置模型的下载位置 Environment="OLLAMA_HOST=0.0.0.0:11434" #可选:设置可访问ollama服务的地址与端口(此处表示任意IP地址都可以从端口11434访问此ollama服务) [Install] WantedBy=default.target

deepin 25 服务修改参考

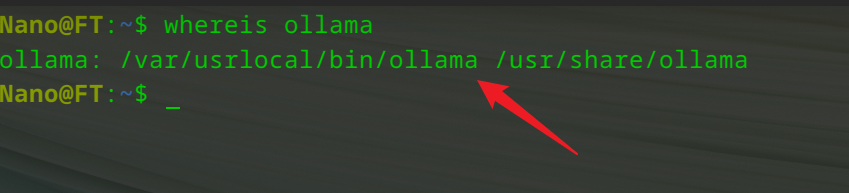

由于 deepin 25 采用了不可变系统设计,Ollama 安装完成后,程序的执行文件位置出现了一些变化。

在进行 Ollama 服务配置时也需要做相应的修改(否则可能会出现服务运行异常)

[Unit] Description=Ollama Service After=network-online.target [Service] ExecStart=/var/usrlocal/bin/ollama serve #此处调整了ollama程序的位置 User=nano #此处为当前的用户名(可选:如果调整了模型的下载保存位置的话,可解决权限问题) Group=nano #此处为当前的用户名(可选:如果调整了模型的下载保存位置的话,可解决权限问题) Restart=always RestartSec=3 Environment="PATH=/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/sbin:/bin:/usr/games:/usr/local/games:/snap/bin" Environment="OLLAMA_MODELS=/media/nano/Date/Ollama_Models" #可选:设置模型的下载位置 Environment="OLLAMA_HOST=0.0.0.0:11434" #可选:设置可访问ollama服务的地址与端口(此处表示任意IP地址都可以从端口11434访问此ollama服务) [Install] WantedBy=default.target

3

Ollama服务启动

更新服务配置:

sudo systemctl daemon-reload重启 Ollama 服务:

sudo systemctl restart ollama.service查看 Ollama 服务运行状态:

systemctl status ollama.service

4

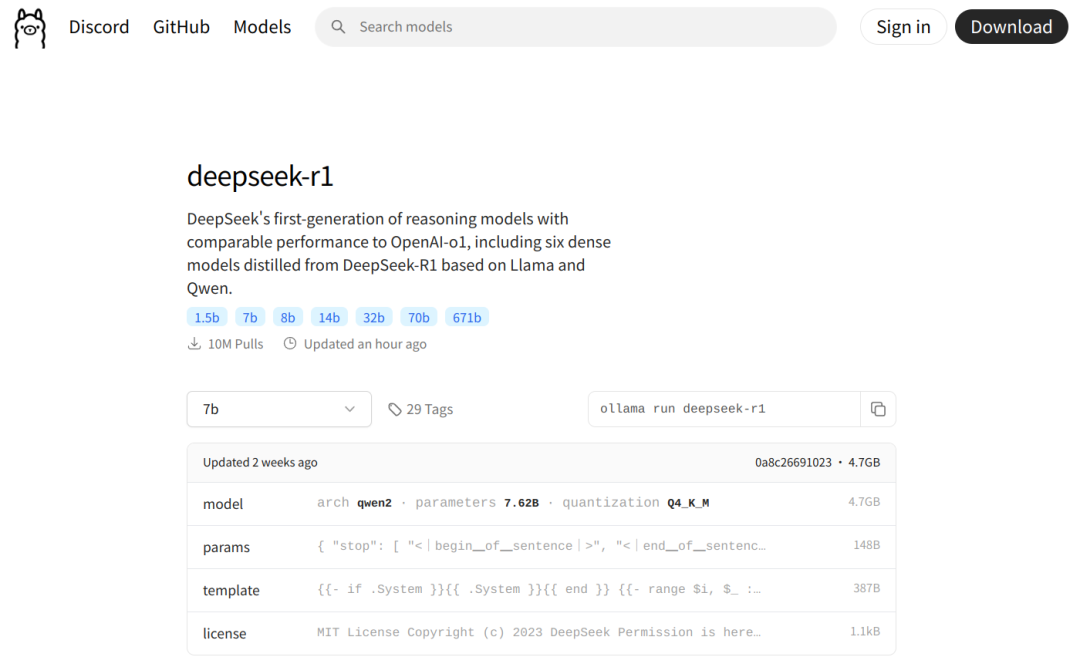

DeepSeek-R1模型下载

在 Ollama 站内检索您所需要下载的模型名称关键字,根据个人电脑配置选择合适大小的参数模型,点击复制模型下载命令,并将命令粘贴到终端中进行下载即可。

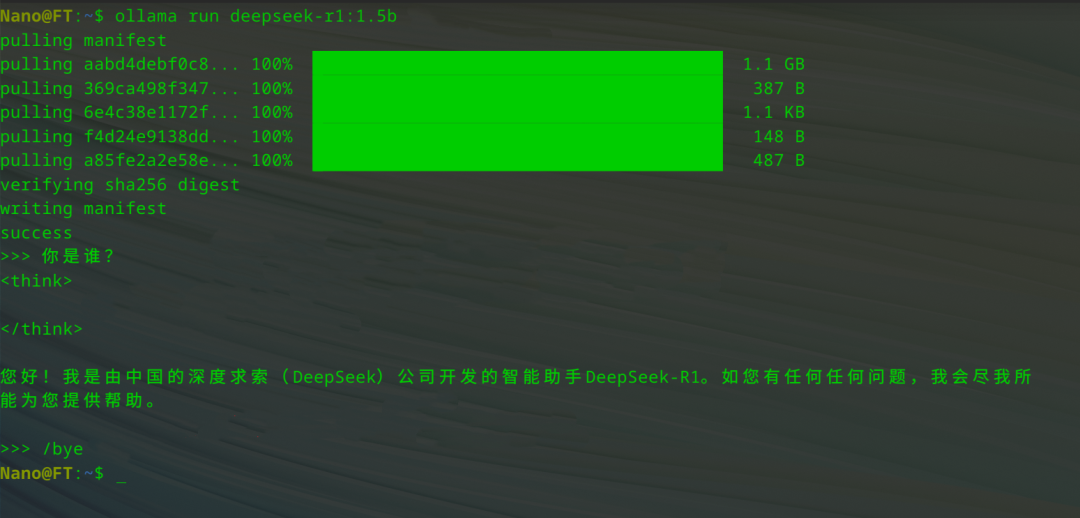

本例选择下载 1.5b 参数量大小的模型,模型下载完成后将自动运行,此时可以使用如下命令在「终端」中与它进行对话:

ollama run deepseek-r1:1.5b下面是一个简单的运行示例

5

在 UOS AI 中添加 DeepSeek-R1

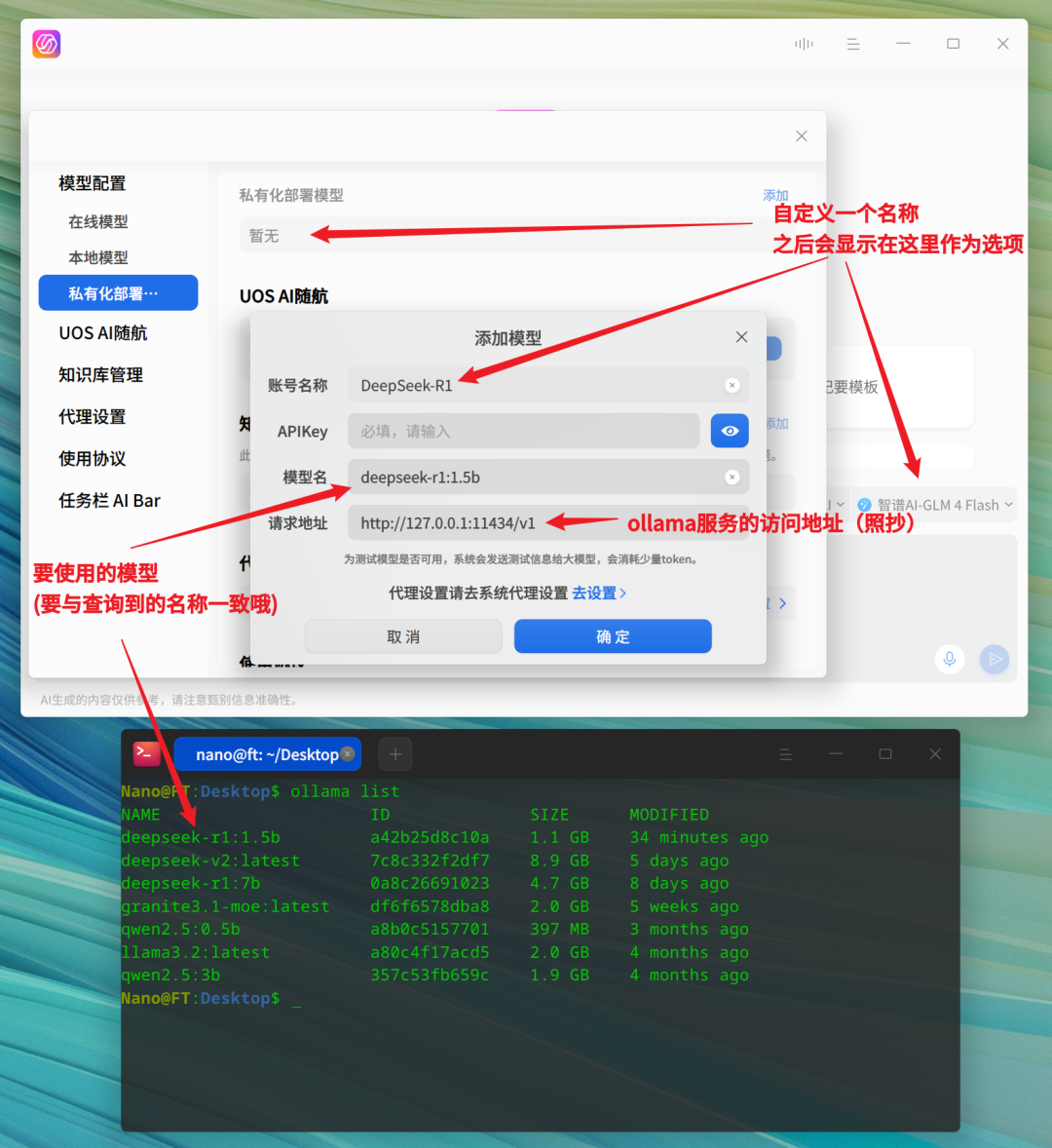

打开 UOS AI 的「设置」选项,在「模型配置」中选择「私有化部署模型-添加」,进入 UOS AI 的模型添加界面。

完成添加窗口中的内容填写,并点击确定即可,本例中使用到的信息参考如下:

账号名称:DeepSeek-R1 模型名:deepseek-r1:1.5b 请求地址:http://127.0.0.1:11434/v1

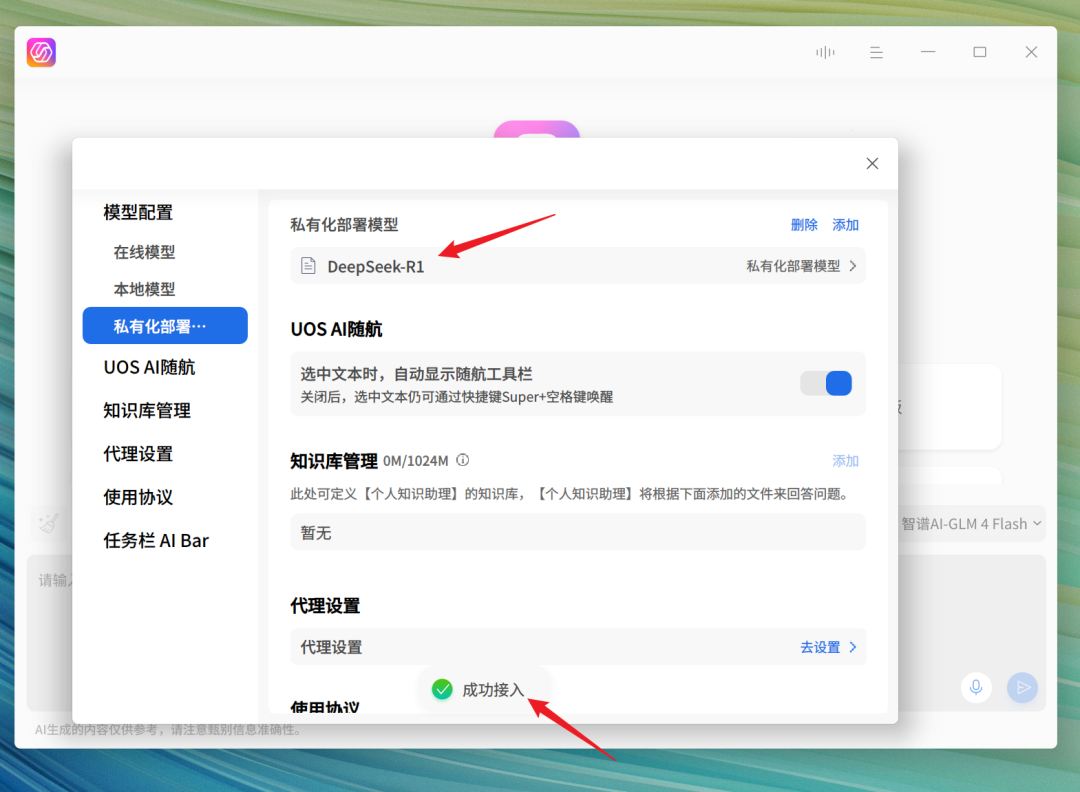

填写完毕并提交确定后,程序会验证对应的大模型是否可用,验证成功后,DeepSeek-R1 便被添加至本地模型。

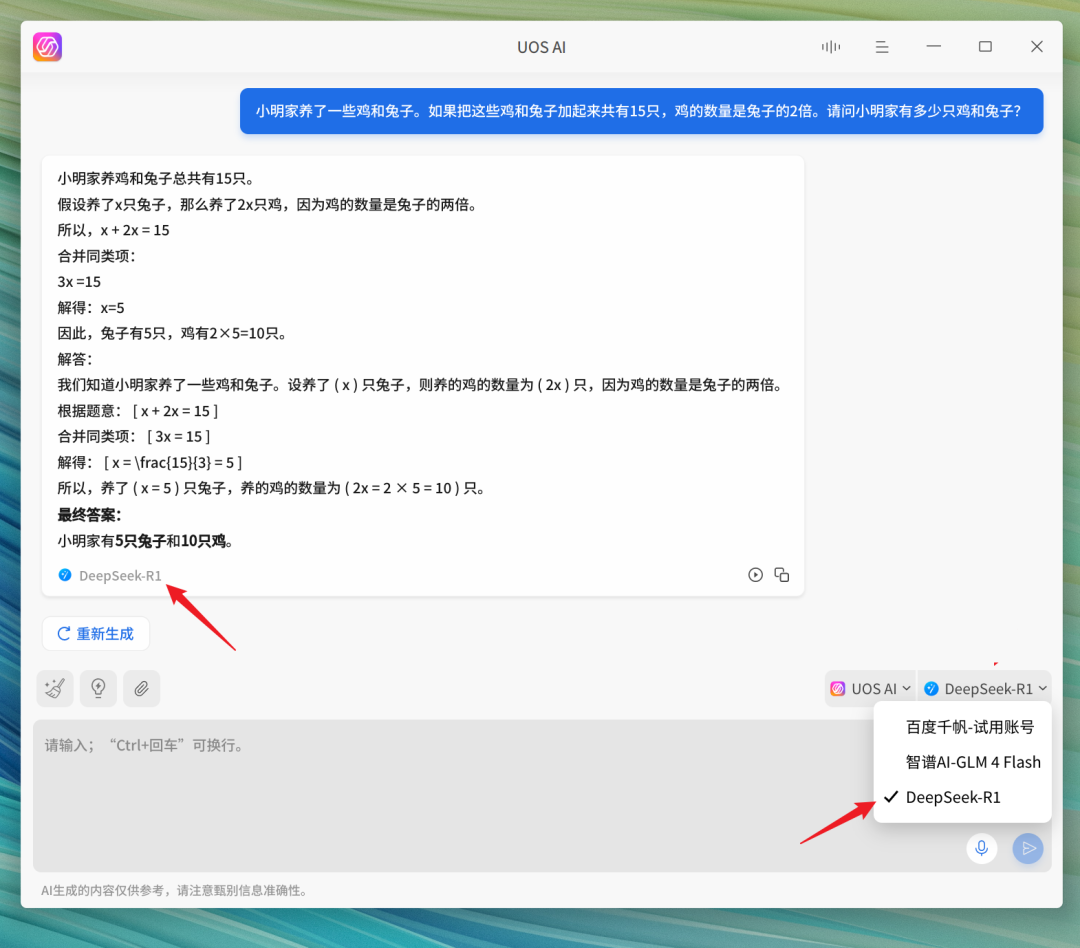

随后即可在 UOS AI 中选择 DeepSeek-R1 模型进行使用。

注:以上本地部署流程不仅仅适用于 DeepSeek-R1 模型,同样也适用于其它模型的本地部署。

附录:

[1]deepin UOS AI 离线、在线接入 DeepSeek-R1 教程 [2] deepin UOS AI 如何配置自定义模型

-

AI

+关注

关注

87文章

32929浏览量

272562 -

UOS系统

+关注

关注

0文章

8浏览量

2238 -

DeepSeek

+关注

关注

1文章

696浏览量

572

原文标题:deepin 25 + DeepSeek-R1 + Ollama 本地搭建全流程

文章出处:【微信号:linux_deepin,微信公众号:深度操作系统】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

如何在RakSmart服务器上用Linux系统部署DeepSeek

在MAC mini4上安装Ollama、Chatbox及模型交互指南

技术融合实战!Ollama携手Deepseek搭建知识库,Continue入驻VScode

RK3588开发板上部署DeepSeek-R1大模型的完整指南

9.9万元用上“满血”DeepSeek R1一体机,本地部署成新商机?引发外媒热议

行芯完成DeepSeek-R1大模型本地化部署

了解DeepSeek-V3 和 DeepSeek-R1两个大模型的不同定位和应用选择

【实测】用全志A733平板搭建一个端侧Deepseek算力平台

实战案例 | 眺望RK3588 RKLLM部署DeepSeek-R1全流程

AIBOX 全系产品已适配 DeepSeek-R1

DeepSeek-R1本地部署指南,开启你的AI探索之旅

deepin 25+DeepSeek-R1+Ollama本地搭建全流程

deepin 25+DeepSeek-R1+Ollama本地搭建全流程

评论