互连 IP可以有效地快速整合数十个或数百个异构神经网络硬件加速器

经过实际验证的商用系统芯片(SoC)互连IP的创新供应商ArterisIP今天宣布,在过去两年中,有十五家公司已经批准使用ArterisIP的FlexNoC互连(FlexNoC Interconnect)或者Ncore缓存一致互连IP(Ncore Cache Coherent Interconnect IP),作为新的人工智能(AI)和机器学习系统芯片的关键元件。

有九个ArterisIP的客户公开宣布,它们已经针对数据中心、汽车、消费类产品和移动应用,设计了或者正在开发机器学习和AI 系统芯片。这九家公司是:

一、Movidius (英特尔) –Myriad™超低功耗机器学习视觉处理器(VPU)

二、Mobileye (英特尔) – 自从2010年起,高级驾驶辅助系统(ADAS)EyeQ®3、EyeQ®4 和 EyeQ®5使用了多个异构处理元件进行视觉处理和机器学习

三、恩智浦–多种ADAS和自主驾驶系统芯片在缓存一致性和功能安全机制的基础上实现了机器学习

四、东芝(Toshiba)–在汽车ADAS 系统芯片中使用缓存一致性和功能安全机制

五、海思 (华为) – 自2013年起,包括含有神经处理单元(NPU)的新型麒麟970移动AI处理器

六、Cambricon(寒武纪)–含有多个处理单元的神经网络处理器

七、Dream Chip Technologies –ADAS图像传感器处理器,其中含有多个数字信号处理器(DSP)和单指令多数据(SIMD)硬件加速器

八、Nextchip –含有多个处理器的视觉 ADAS系统芯片

九、Intellifusion(云天励飞)–机器学习视觉智能,其中含有多个异构片上硬件引擎

除了上述九家客户已经公开宣布之外,还有六家公司也在使用ArterisIP的产品来实现新的AI和机器学习硬件架构。这六家公司是:

两家针对自主驾驶的主要半导体和系统供应商

一家针对消费电子的主要半导体供应商

一家主要的自主飞行器供应商

一家在新型汽车传感器技术方面领先的公司

一家在数据中心分析领域从事创新的公司

所有这些在创新方面领先的公司所设计的系统芯片,都用了多个异构处理元件来加速机器学习和神经网络算法。每种系统芯片的片上互连都是针对具体的任务而配置的,各种系统芯片的架构,都是在这个基础上,根据目标市场的需要专门设计的。这些公司之所以都批淮使用ArterisIP互连技术,是因为:

它简化了这些不同处理引擎在芯片上的整合,同时设计团队可以精细调整电源管理和服务质量(QoS)特性,例如路径延迟和带宽;

它支持系统中关键部分的缓存一致性,从而简化了软件开发并且支持定制的数据流处理。因而系统能够在共享高速缓存中重复使用数据并利用本地累加功能,从而减少裸片面积并增大内存带宽,同时减少处理延迟和功耗;

保护传输中的数据和静止数据,从而提高功能安全性诊断的覆盖率,这样大型超级计算机系统芯片能够达到汽车ISO 26262规范的严格要求。

ArterisIP技术总监Ty Garibay说:“要在商业上可行的系统中有效地实现机器学习和可视化计算,硬件团队需要使用多种类型的硬件加速器来加速神经网络功能,而加速器的类型和数量则根据性能、功耗、面积及成本方面的要求。"他表示,“ArterisIP的技术为这些团队提供了将这些处理元件快速有效地整合到系统中的方法,确保他们能够满足进度安排和功能安全的要求。”

ArterisIP总裁兼行政总监K. Charles Janac说:“机器学习已经成为我们高级互连IP的‘杀手锏',它所需要的服务质量(QoS)、功耗和性能,与FlexNoC和Ncore互连所提供的功能是完全一致的。”他表示,“我们的团队很高兴能够在推动新一代神经网络、机器学习和人工智能芯片方面起到关键的作用。”

-

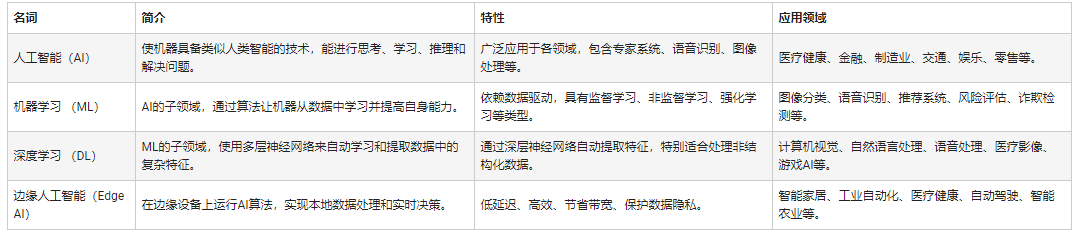

人工智能

+关注

关注

1796文章

47643浏览量

240103 -

机器学习

+关注

关注

66文章

8438浏览量

133028

发布评论请先 登录

相关推荐

ArterisIP推动十五家芯片公司的人工智能和机器学习创新

ArterisIP推动十五家芯片公司的人工智能和机器学习创新

评论