人工智能应用场景众多,认同AI安防优先落地,有些场景需要在终端实现,对芯片功耗、效率,运算能力要求较高,这是当前AI芯片发展方向,也是制约AI终端应用大范围落地的瓶颈。深鉴科技就在朝着这个方向努力,从基于FPGA和ASIC芯片的硬件定制化架构,到算法压缩,深鉴致力于提供高效、低能耗的处理器。当前已有标准化模组产品,助力图像识别、结构化算法加速,测试结果表明深鉴产品与其他终端处理器相比,在性能、效率方面等均有优势。

人工智能场景:应用场景众多,复杂程度不一。主要典型场景如下:

阿尔法狗下围棋场景:行为较为单一,任务其实相对简单。

机器人运动场景:人的行走相对复杂,考虑因素众多,相对复杂。

自动驾驶场景:更为复杂,需要考虑社群行为。即除了自动驾驶行为决策外,还要考虑其他行驶者行为的影响。

行业应用落地场景:认同AI落地第一个场景-AI安防的观点。

当前AI安防已经有大量需求,2016年安防监控出货量:1亿4千万个模组和传感器。安防主要部署在终端,对处理器的成本、带宽,延时等性能都有较高要求。

其他终端应用场景:机器人和无人机

要求:时延低,功耗低,价格敏感,是AI具有挑战性场景。

目前市场上已经有消费类产品:家庭陪伴机器人,扫地机器人,家庭语音聊天机器人等。主要是通过云端进行语音识别进行人机交互。

还有提升空间,核心处理转移到前端将会带来市场空间。

AI处理器现状,目前尚处于早期,效率,功耗等均有待提高。阿尔法狗战胜李世石用了2千个CPU,3千个GPU,同时还花费电费3千美元,难以在现实场景应用。AI真实场景应用,对计算能力,功耗,开发门槛要求较高。终端应用对功耗要求更高,无论是终端还是云端都面临成本压力:降低前期投入成本和后期运维成本。

AI三个关键因素:数据,算法,硬件。当前许多AI处理都在是云端完成,因为需要计算集群提供强大运算能力,短时间完成算法优化、数据清洗、适配,训练数据,快速迭代。但是有些场景不适用云端场景:延时要求较高的场景。终端设备无需连接服务器、延时较低,可以适用这些场景。预计未来终端应用将会增加,数据也越来越多,形成数据量和处理能力之间的剪刀差。这是阻碍AI大范围应用的主要因素。

当前大量公司开发硬件,基本所有AI相关公司都有想法或已经付诸行动,部署相应加速硬件。未来趋势,未来AI大规模应用落地,高效、合适的计算平台是必要条件。

深度学习处理器:大公司都在做,比如谷歌,百度,英伟达为典型。

创业公司主要有:寒武纪、深鉴科技、地平线机器人等等。

大家共同的目标:便宜高效完成AI计算。

深鉴科技主要擅长:

1.硬件加速:基于赛灵思的FPGA硬件和ASIC专为深度学习定制,设计专门AI硬件架构。

2.算法压缩和量化:人类神经元数量连接数量3-5岁达到最高峰,十几岁人脑功能达到稳定,连接数减少到2/3-3/4。这一阶段是学习最快的阶段,大脑会自动砍掉无效连接。算法压缩就在做同样的事,在不损失精度情况下压缩网络。对模型进行剪枝、压缩、量化,在不损精度情下,可以将运算速度提升数倍至数十倍。

测试1.分类网络压缩:

对分类网络做压缩前后,两类不同对象处理性能对比:可以在将模型压缩到51%神经元的情况下,达到同样精度,大大提高处理速度。

测试2.SSD网络压缩:

测试表明:可以在实现相同精度情况下,将网络缩小至10%。也就是原来一秒1张图片,现在可处理10张图片。

功耗需求:

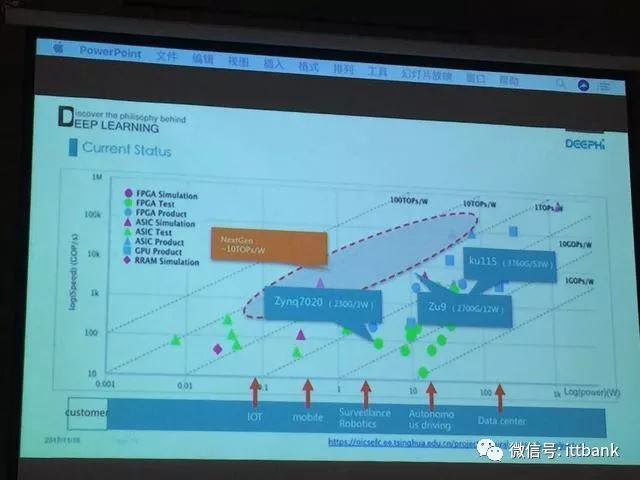

面向AI终端定制芯片的目标功耗是:1-10W区间,这一领域尚处空白,各公司均向这方向努力。

横坐标:功耗,纵坐标:运行速度,斜率越高效率越高。

1-10w的红圈区域:空白区。当前IOT功耗是几十-几百W,需要大规模量产化才能降低成本,并且几十W难以作为应用端芯片。其他性能强大的芯片过高功耗,需要的成本较高。

测试3.效率比较:

衡量芯片两个关键指标:峰值性能:取决于公司的技术水平以及财力,较高工艺需要较大成本。

效率:取决于公司技术情况。

效率定义:运行时工作芯片单元占总芯片单元数比重,即100个计算单元,每个时钟周期有多少在工作。

深鉴科技可达50%以上;iphone8可以达到20-40%;Kirin970:20%左右。

深鉴科技产品:

当前市场主流AI应用场景:安防,数据中心,机器类相关。深鉴科技也都在做。

深鉴目前标准量产化产品:前端智能模组,可以提高前端运算能力。可以通过增加硬件的方式,实现支持多路、实时视频处理,可以辅助进行人脸识别,结构化模型处理。

-

人工智能

+关注

关注

1797文章

47867浏览量

240853 -

神经元

+关注

关注

1文章

368浏览量

18526 -

AI芯片

+关注

关注

17文章

1914浏览量

35271

原文标题:全球人工智能AI芯片有望提前在安防领域落地

文章出处:【微信号:ittbank,微信公众号:ittbank】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

伟立机器人入选2024年浙江省人工智能应用场景名单

主线科技荣获全国人工智能应用场景创新挑战赛一等奖

航天宏图荣获全国人工智能应用场景创新挑战赛一等奖

模块化仪器的技术原理和应用场景

嵌入式和人工智能究竟是什么关系?

便携式示波器的技术原理和应用场景

《AI for Science:人工智能驱动科学创新》第一章人工智能驱动的科学创新学习心得

智能IC卡测试设备的技术原理和应用场景

RISC-V适合什么样的应用场景

FPGA在人工智能中的应用有哪些?

FPGA与MCU的应用场景

AIOT是什么意思?AIOT的应用场景和作用

人工智能场景:应用场景众多,复杂程度不一

人工智能场景:应用场景众多,复杂程度不一

评论