编者按:“趋势”表现了事物发展的动向,它的目标可以是模糊的,但这种持续的前进反映到数据上是明确的。去年4月,特斯拉AI总监Andrej Karpathy发表了一篇A Peek at Trends in Machine Learning,揭示了机器学习论文总数(arxiv)、深度学习框架、CNN模型、优化算法及研究人员的发展趋势。而就在几天前,他又更新了一波数据,并从中看到了一种非常有趣的变化。

注:本文已更新论文总数与流行框架排名,其余内容仍为2017年4月数据。

好像少了点啥

不知道各位读者有没有用过Google Trends,这是一个很cool的工具——输入关键词,你就能查看相应Google搜索结果随时间发生的变化。而现在,我们也已经有了一个机器学习论文库arxiv-sanity,它在过去6年内积累了43108篇(arxiv)相关论文,所以我们为什么不落落俗套,也来看看6年来机器学习研究的演变情况呢?

注:该论文库由Andrej Karpathy创建,由于机器学习涉及内容过广,文中很大一部分都围绕深度学习展开,尤其是Andrej Karpathy熟悉的领域。

arxiv奇点

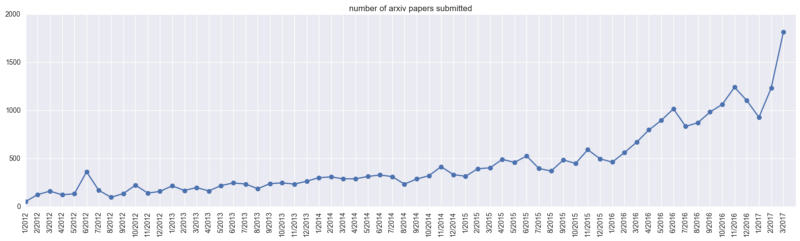

首先我们先来看看arxiv-sanity上的论文总数(cs.AI,cs.LG,cs.CV,cs.CL,cs.NE,stat.ML)。截至去年4月,arxiv-sanity共收录28303篇机器学习论文,其中仅在2017年3月,数据库就突增近2000份新论文,机器学习学术成果迎来爆发期。

arxiv上ML论文提交量变化

而就在短短一年后,arxiv-sanity上的论文总数已经突破43000篇,考虑到近年来机器学习国际顶会的热门程度,我们先来看看几个主要会议(去年4月后)的“吸金”能力:

虽然参与会议投稿的论文未必都会提交给arxiv,但可以看出,2017年以前,arxiv-sanity上收录的论文总量尚不足3万篇,而去年光这几个会议就吸引了近2万篇投稿,另外还有其他的顶会数据未计入其中,机器学习的热度可见一斑。

当然,这也带来了一个问题,就是学者需要通过阅读大量论文才能从中筛选出真正有价值的内容,这也是许多人开始诟病顶会“灌水”严重的一个要因。但本文只关注发展趋势,因此这些论文总数将作为分母,用来分析一些有趣的关键词“现象”。

深度学习框架

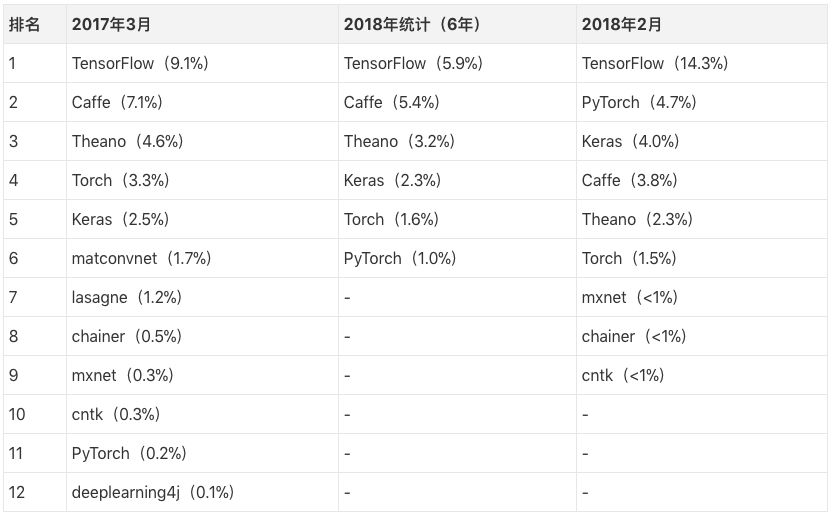

谈及机器学习,一个不可避免的热门关键词是深度学习框架,那么学术界更偏好哪种框架呢?我们汇总了去年和今年的统计结果,请结合表格对比感受:

需要注意的是,这里我们的分母是统计的论文总数,以2017年3月为例,TensorFlow(9.1%)指在去年3月投到arxiv的机器学习论文中,有将近10%提到了TensorFlow,当然这也意味着该月的大多数论文并没有介绍自己使用的框架。但如果我们假设论文指出使用框架的现象遵循某种固定的随机概率,那么经过粗略估计,我们可以猜测大约有40%的实验室正在使用TensorFlow。而今年2月TensorFlow的比例提升到了14.3%,再算上把TF作为后端的各类框架,毫无疑问,TensorFlow确实是大多数学术界人士的首选框架。

而Caffe和Theano由于“历史悠久”,已经积累了数量可观的老用户和论文基础,因此它们的占比仍然很突出。

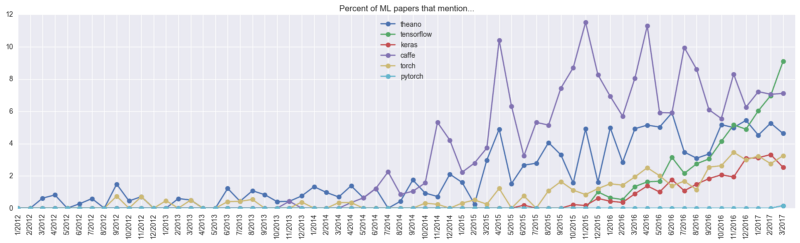

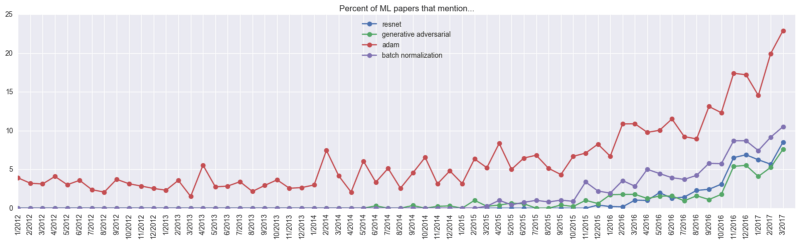

2017年4月前各框架发展情况

为了更直观地感受各框架的发展趋势,我们来看看去年和今年的这两幅图。上图中紫色的Caffe和深蓝色的Theano在很长一段时间内深受学界欢迎,而绿色的TensorFlow在2016年异军突起,只用一年时间就超越了“前辈”,增长势头显著。当时Andrej Karpathy曾预测Caffe和Theano的市场占有率会缓慢下降,同时TensorFlow的增长也会减缓,他更看好当时几乎没有存在感的PyTorch。

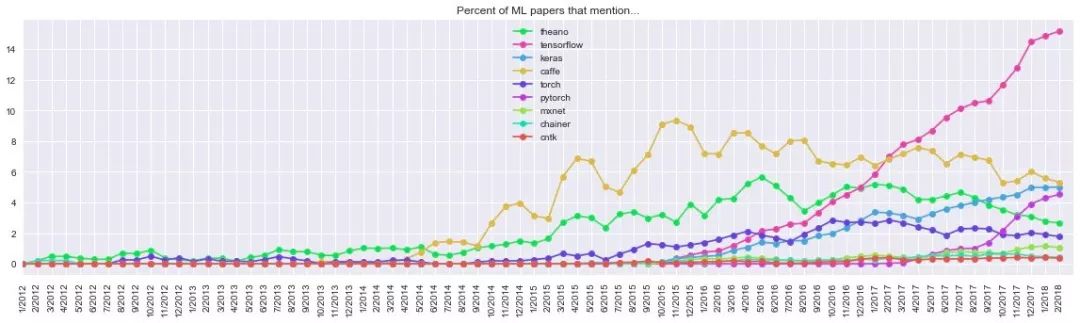

2018年3月前各框架发展情况

果不其然,最近的这幅统计图显示,粉色的TensorFlow经历了两年增长,至2017年年末开始趋向平稳,而Caffe和Theano的曲线几乎同步下降,后者的占有率已跌至第五位,还在第二位苦苦挣扎的Caffe也被“后起之秀”Keras和PyTorch赶上。其中最亮眼的是PyTorch,这个在2017年3月不足0.2%的框架到2018年2月已经达到4.7%,考虑到近年来论文的爆炸式增长,PyTorch前景可期,拿原twitter下的留言来说,就是:

PyTorch is on fire! ( PyTorch要火!)

CNN模型

CNN最初是为解决图像识别等问题设计的,当然其现在的应用不仅限于图像和视频,也可用于时间序列信号,比如音频信号、文本数据等。在处理上述这些问题时,除了特殊情况,通常我们不会从头新建一个CNN,而是在已有模型的基础上调整参数。那么,哪个是最受欢迎的CNN模型呢?Andrej Karpathy没有更新模型的相关数据,所以我们仍以去年的数据为准。

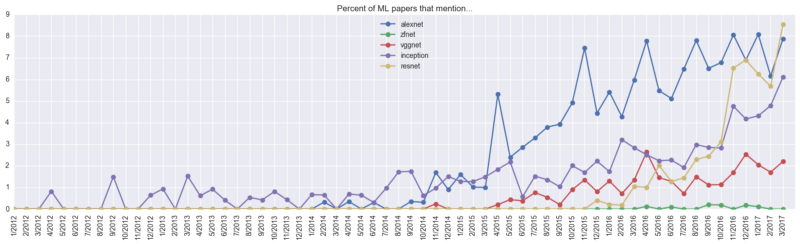

CNN有四大经典模型:AlexNet、VGGNet、Google Inception Net和ResNet。从上图我们可以看到,在关于AlexNet的论文开始大量出现前,Inception在较长时间内一枝独秀,2014年年末,AlexNet迎来快速增长,并长期稳定在高水平位置。而就在一年后,ResNet也迎来爆发期,到2017年3月占比9%,跃升至第一位。

优化算法

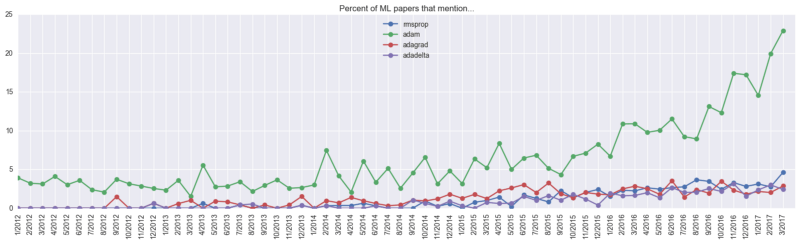

就优化算法而言,Adam是毫无疑问的“掌门人”。截至去年4月,约23%的机器学习论文都提到了它。当然我们很难估计它的实际使用占比:它可能高于23%,因为一些论文没有介绍使用的优化算法,其中的大部分甚至根本没有提及神经网络优化;它也可能需要在23%的基础上减去5%,因为这个关键词不是手动提取的,所以不排除论文里的Adam其实是个人名,而且作为一个优化算法,Adam的提出时间是2014年12月。

研究人员

虽然现在大家对Deep Learning热情高涨,业界也有大量被追捧的专家偶像,但这些偶像真的适合每个人吗?你追的偶像是不是真正的专家?从论文实际引用情况来看,哪些人的论文“含金量”更高?Andrej Karpathy也用数据给了我们一点启示。

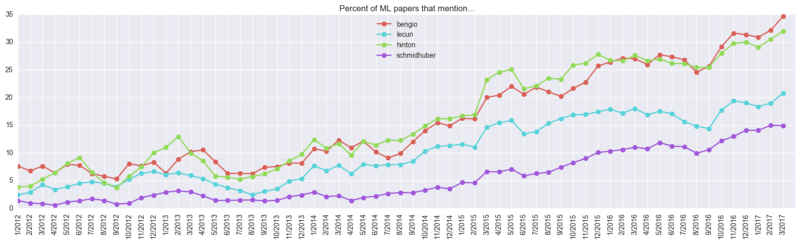

上文中由上往下的四个人分别是Bengio、Lecun、Hinton、Schmidhuber,他们是业内公认的对深度学习贡献最大的四名活跃学者。可以发现,Bengio在论文中的出现次数和Hinton齐头并进,以35%位列首位,而Hinton则以30%排名第二。但考虑到Yoshua Bengio的弟弟Samy同样在机器学习领域有不错的成就,35%这个占比含有一定水分。

另外需要提的一位是LSTM之父Jürgen Schmidhuber,他的论文引用量也颇为可观。Schmidhuber现任瑞士人工智能实验室主管,因为喜欢自己独立研究,可能国内对他的关注度不高,但这不妨碍业界对他的肯定。这里介绍一篇他的新作One Big Net For Everything,除了标题看得让人害怕,引用的文献都有将近一半是他参与写的,感兴趣的读者可以参考着体会下大神的脑回路。

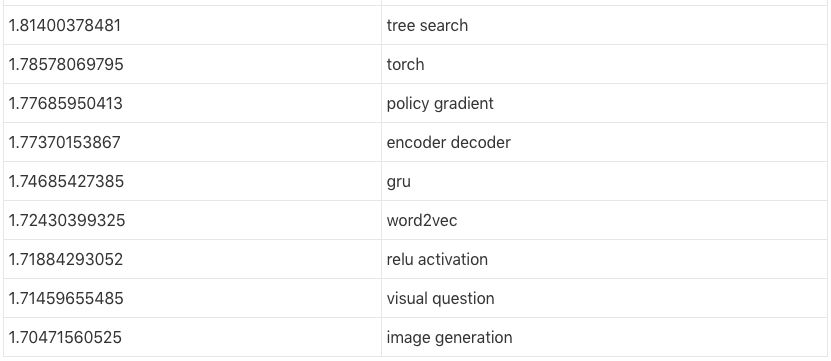

热门/冷门的关键词

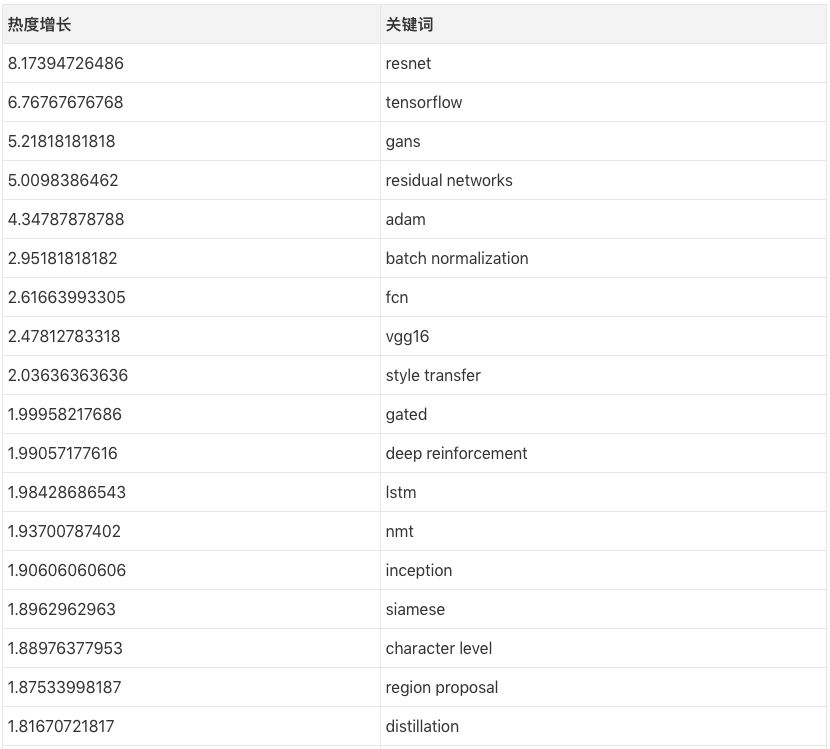

Andrej Karpathy同样爬取了论文中的一些关键词,并观察了它们的热度情况。

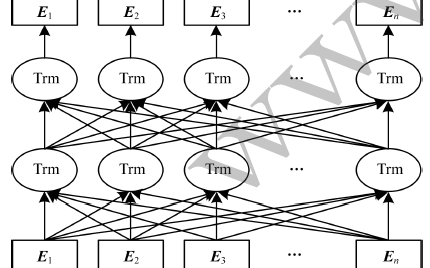

以上数值是这样计算的:以resnet为例,2016年3月前它的出现频率只有1.044%,而它在2017年3月的出现频率是8.53%,因此它的热度增长为8.53/1.044〜=8.17。这样对比下来,去年最热门的论文关键词依次是ResNets、GANs、Adam、BatchNorm,而最受欢迎的研究领域则是风格迁移、深度强化学习、神经机器翻译、图像生成,热门架构的排名则是FCN、LSTM/GRU、连体网络和编码-解码网络。

另外,一些关键词也被研究人员们“无情”地抛进了角落。虽然不清楚排名第一的fractal具体指什么,但估计是贝叶斯参数那一块的内容。

小结

看完全文,你的“将基于全卷积编码-解码批规范化架构、经Adam优化处理的ResNet GAN用于风格迁移”这篇论文准备得怎么样了(英文名字都帮你想好了,就叫Fully Convolutional Encoder Decoder BatchNorm ResNet GAN applied to Style Transfer, optimized with Adam),这个选题听起来也不怎么离谱嘛:)

-

机器学习

+关注

关注

66文章

8421浏览量

132710 -

深度学习

+关注

关注

73文章

5504浏览量

121214

原文标题:PyTorch要火!Andrej Karpathy更新机器学习趋势窥探

文章出处:【微信号:jqr_AI,微信公众号:论智】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

科普:12大关键词让你了解机器学习

[讨论]提高网站关键词排名的28个SEO小技巧

TF-IDF测量文章的关键词相关性研究

亚马逊代运营 amazon Search term 关键词填写的“神技”

HanLP关键词提取算法分析详解

关键词优化有哪些实用的方法

#2023,你的 FPGA 年度关键词是什么? #

IT产业2012热点趋势:智能化成关键词

基于强度熵解决中文关键词识别

基于关键词的最优路径查询算法

基于自动关键词抽取方法

三大“关键词”来了解AI

2020年云计算发展六大关键词,以及六大关键词背后的重要趋势

融合BERT词向量与TextRank的关键词抽取方法

根据关键词了解机器学习的趋势窥探

根据关键词了解机器学习的趋势窥探

评论