如果您看过NVIDIA创始人兼首席执行官黄仁勋在GPU技术大会的主题演讲,一定会被其中提到的成果震撼,这背后离不开NVIDIA研究人员的努力。

黄仁勋在GTC 2018上披露了两项深度学习发现,有可能颠覆传统计算机图形技术。两者都可以帮助游戏开发商以更少的时间和更低的成本创造更丰富的游戏体验。其中一项可以通过轻松创建数据,训练车辆适应更广泛的道路状况、环境和地点,加速自动驾驶车辆的开发。

一直以来,NVIDIA致力于将深度学习引入计算机图形领域以推动行业发展。这两个研究项目正是我们的最新成果。NVIDIA的研究团队有200多人,分布在全球11个地点,致力于推动机器学习、计算机视觉、自动驾驶汽车、机器人、图形处理、计算机架构以及编程系统等领域的前沿技术发展。

黄仁勋表示:“这个团队的生产力简直不可思议。他们横跨整个计算领域进行基础研究。”

这两幅图是同一噪声图像的清晰版本。左边的去噪图像由神经网络经过训练从对应的清晰图像和噪声图像生成。右边的去噪图像由研究人员使用单纯噪声图像训练模型生成。

噪声图像清晰化

你可能不知道噪声图像是什么,但你可能已经见过它了。当用摄像头对焦光线昏暗的场景时,图像会呈现颗粒、异常的彩色斑点、或像萤火虫一样的白色斑点。

去除图像噪声是很困难的,因为这个过程本身可能会受人为因素影响或使图像更模糊。深度学习实验可以提供解决方案,但也存在一个重要缺点:实验需要配对的清晰图像和噪声图像来训练神经网络。

普通的AI去噪需要配对的清晰图像和噪声图像。但是,对于MRI和其他医学图像,通常无法获得清晰图像。有了“噪声到噪声”技术,将不再需要清晰图像。

只要有好的照片就可以去噪,但要达到理想效果也可能很难,甚至不可能达到。NVIDIA在芬兰和瑞典的研究人员开发了一种称为“噪声到噪声”(Noise2Noise) 的解决方案,解决了这个问题。

基于噪声图像生成清晰图像成为可能

如何生成清晰的图像是医学成像检测(如MRI)和远程恒星或行星天文图像中的共同问题,因为这些场景根本没有足够的时间和光线来拍摄清晰图像。

时间在计算机图形技术中也是一个问题。生成清晰的图像数据来训练降噪器的任务可能需要几天或几周的时间。

“噪声到噪声”看起来似乎不太可能。因为它不是基于配对的清晰图像和噪声图像来训练网络,而是基于配对的噪声图像来训练网络,并且只需要噪声图像。然而,“噪声到噪声”产生的结果却等同于或几乎等同于老方法可实现的网络训练结果。

NVIDIA研究部门副总裁David Luebke表示:“我们发现,通过正确建立网络,可以做到一些看似不可能的事情。搞清楚整个过程后,会发现这是一个非常令人惊喜的事情。”

通过语义操作轻松改变图像

黄仁勋演示的第二个项目代表了构建虚拟世界的全新方法。它利用深度学习,从繁重且高代价的游戏3D建模任务中抽离出来,并为自动驾驶汽车捕获训练数据。

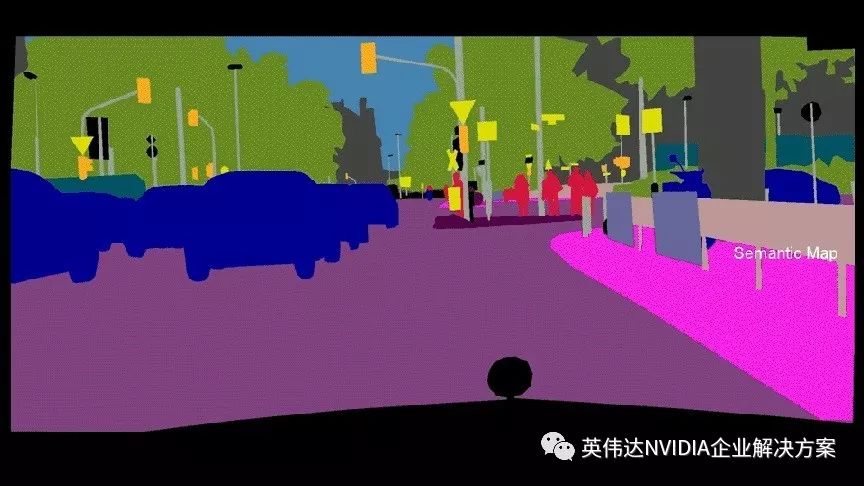

这种被称为“语义操作”的技术就好像乐高积木,孩子们可以搭建出任何想要的东西。

在语义操作中,用户可以从一张带标签的地图开始操作。每一个场景中的像素都相当于一张带有标签的蓝图,切换图上的某些标签就能改变图像。还可以编辑对象的样式,例如选择不同类型的汽车、树木或道路。

NVIDIA研究人员的深度学习图像合成技术可以通过改变语义标签轻松改变道路的外观。

加速游戏开发

研究团队所采用的方法依靠生成式对抗网络(GAN)技术。这是一种深度学习技术,通常用于在数据匮乏时创建训练数据。

虽然GAN通常难以生成逼真的高分辨率图像,但NVIDIA研究员能够通过改变GAN架构使之成为可能。

目前,为了创建计算机游戏的虚拟环境,美术师需要数千小时的时间来创建和更改模型,每个游戏的花费可能高达上亿美元。这些模型经过渲染,转换为我们在屏幕上所看到的游戏。

如果能减少所需要的工作量,游戏美术师和工作室就可以创建更多角色、更多故事情节和更复杂的游戏。

优化自动驾驶汽车训练

获取数据训练自动驾驶汽车同样很麻烦。通常需要在道路上投放配备传感器和摄像头的车队。汽车采集的数据必须手动标注,用于训练自动驾驶汽车。

采用NVIDIA的方法,可以在旧金山收集数据,然后应用于另一个山地城市,例如巴塞罗那。甚至可以把一条鹅卵石街道变成一条石砌路,或者把一条林荫大道变成停满汽车的道路。

这样可以更有效地训练汽车处理不同情况。还可以开发图形渲染引擎,用现实世界的数据进行训练,并用生成模型渲染。

黄仁勋表示:“我为NVIDIA研究团队感到骄傲。欢迎与我们一起探讨,共同取得更大进步。“

-

NVIDIA

+关注

关注

14文章

5087浏览量

103948 -

gpu

+关注

关注

28文章

4798浏览量

129516 -

AI

+关注

关注

87文章

31877浏览量

270706 -

自动驾驶

+关注

关注

785文章

13958浏览量

167272 -

深度学习

+关注

关注

73文章

5521浏览量

121672

原文标题:GTC 2018 | 开创性深度学习研究在GTC上大放异彩

文章出处:【微信号:NVIDIA-Enterprise,微信公众号:NVIDIA英伟达企业解决方案】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

NVIDIA加速全球大多数超级计算机推动科技进步

NVIDIA助力丹麦发布首台AI超级计算机

ARMxy ARM嵌入式计算机搭载 1 TOPS NPU支持深度学习

NVIDIA将深度学习引入计算机图形领域以推动行业发展

NVIDIA将深度学习引入计算机图形领域以推动行业发展

评论