有一部分AR头显为了美观或者设计的因素,选择把眼镜和处理器分开,比如让传感器收集的数据通过蓝牙发送给电脑处理,然后又把处理后的图像发送回眼镜显示。这样做当然有很多好处,比如解决了头戴显示器过重,对处理器的限制,处理器过热等等很多问题。

然而,这种做法也引起了其它的困难,一般的视频传输过程中,传输方首先会对视频进行编码压缩,随后接收方再进行处理,解码得到完整的视频。这样的传输方式可以保证传输的文件数量不大,但中间的过程需要耗电的硬件组件以及与相机连接的视频编解码器、算法和通信模块,这对头显来说就不是个好消息了,头显应该要求有足够的续航,这个过程就成了阻碍。

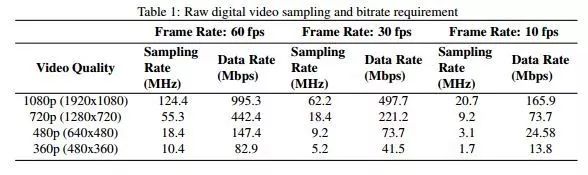

一般传输的采样率和数据速率要求

最近,一篇叫做Towards Battery-Free HD Video Streaming的论文提出了一个方法,表示可以很大程度上节约能耗,甚至节约能耗能够达到一万倍,这对前面提到的AR眼镜可能会大有好处。

论文中提出了一种新的视频体系结构,在低功耗设备上进行流式传输,而不是独立优化成像和通信模块,这样可以极大地降低系统功耗。

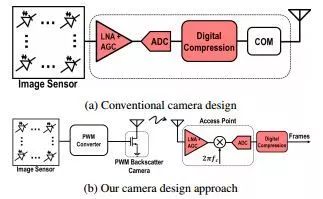

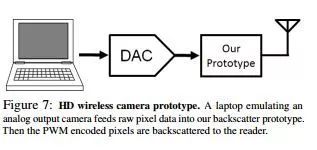

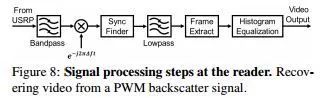

基于这个想法,论文创建了第一个“模拟”视频反向散射系统,把来自光电二极管的模拟像素直接发射到反向散射天线;因此,消除了耗电比较大的ADC,放大器,AGC和编解码器模块。将ADC转换过程分为两个阶段,一个阶段在摄像机上进行,一个完成在读者。在传感器位置,把模拟像素电压转换为连续的脉冲信号,该信号通过反向散射从传感器发送到处理器,从而提供更好的噪声免疫。处理器根据它接收到的脉冲信号产生一个二进制数值再进行之后的处理。

具体来说,论文的设计有三个关键方面。首先,论文展示了一种像素直接连接到没有使用ADC的反向散射硬件。即将模拟像素值转换为不同的脉冲信号,并使用无源斜坡电路把这些脉冲映射入反向散射天线中与像素一起传输至处理器。

其次,论文实现了帧内通过利用固有的冗余来压缩典型的图像。直观上,信号所需带宽和相邻像素之间的变化率是成比例的,由于视频往往留存冗余的信息,模拟信号数量与冗余度成反比。因此,通过连续发送像素信号,可以隐式执行压缩并显著减少对带宽的需求。

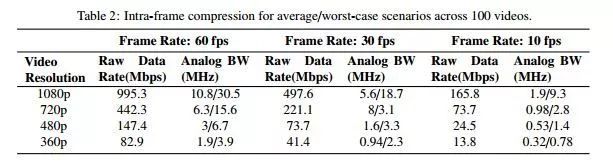

跨100个视频的平均/最差情况下帧内压缩结果

最后,要实现帧间压缩,论文设计了一个“减少的分布式算法”,传感器传输数据,同时将大多数帧间压缩功能委托给处理器。摄像头取得某块区域中的像素平均值,并将信号传输至反向散射硬件。处理器将这些平均值与以前的平均值进行比较并且只处理块平均像素值的可见的显著变化,从而减少后续视频帧之间的传输。图3显示了一个样本框架从使用我们的反向散射相机流式传输的高清视频。

那么这种方案的效果如何呢?论文的成果有:

以每秒10帧的速度传输720p高清视频距阅读器最远16英尺,并且得到的结果与源高清视频的质量相同。

与原始视频相比,论文提出的帧间和帧内压缩算法将总带宽需求减少了两个数量级数量。例如,对于720p高清视频速度为10 fps,我们的设计使用无线带宽在平均情况下仅为0.98 MHz和2.8 MHz最坏情况的场景视频。模拟的结果显示, 720p、30 fps高清视频流的功耗仅为252μW ,在 60 fps下高清视频流的功耗仅为321μW; 1080p全高清在60 fps下功耗为806μW,在30 fps下为561μW。从运行射频功率采集实验来看,这种方法可以支持1080p全高清视频流以30 fps的速度传输8英尺的距离。这样的结果足以证明这种方案的优越性。

需要说明的是,现在论文只是提供了一种可行的方法,还有很多问题没有考虑到,比如安全,论文中说明的的传输方案很容易被解码,所以安全性存在较大隐患,虽然论文中提出了给每个传感器分配一个的伪随机安全键的加密方法,但并没有进行测试,所以我们也不知道具体效果到底如何。要等到本文提供的方法投入使用,应该还需要很长一段时间。

-

传感器

+关注

关注

2550文章

51004浏览量

752969 -

Ar

+关注

关注

24文章

5093浏览量

169451

原文标题:视频传输新方案可节省能耗一万倍,去掉头显的笨重电池显的

文章出处:【微信号:ARchan_TT,微信公众号:AR酱】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

显示器HDR认证

显示器低蓝光(ChinaMark)认证

工业级触摸显示器的分类与应用分享

内置扬声器和麦克风的显示器区别

VR显示器的优缺点

如何选择工业液晶显示器和消费类显示器?

工业显示器和普通显示器的区别有哪些?

等离子显示器特点 等离子显示器的工作原理

什么是oled显示器 oled属于液晶屏幕吗

节省能耗一万倍,解决头戴显示器问题

节省能耗一万倍,解决头戴显示器问题

评论