触觉感知和发展的模型

触觉感知模型是数学结构,试图解释触觉积累关于环境中的物体和试剂的信息的过程。 由于触觉是一种主动的感觉,即感觉器官在感觉过程中被移动,所以这些模型经常描述优化感知结果的运动策略。

触觉发展的模型试图从更基本的原则来解释感知的出现和伴随的运动策略。 这些模型通常涉及到对探索策略的学习,旨在解释行为的发生发展。

这些模型有两个互补的用法。 首先是试图解释和预测动物和人类的行为。 为此,啮齿动物的触须系统经常被使用,因为它是一个在神经科学中被充分研究的系统。Vibrissae(触须)行为,即啮齿动物的面部毛发的运动策略,在不同的感知任务中被模拟,试图揭示潜在的共同原理,以及触觉感知和发展的神经机制。 同样的模型也被用于人造结构,例如机器人,试图既验证触觉感觉运动策略的出现,又尝试和优化新型机器人平台中的触觉感知。

介绍

触觉是指在环境中的触觉物体上收集的信息。该信息可以是对象的位置,形状,材料或表面纹理。因此,触觉感知的模型旨在解释这些信息如何积累,整合和用于触觉任务,如歧视和本地化。

触摸是一种主动的感觉,即感觉器官通常被移动以感知环境。因此,建模触觉感知涉及对导致触觉信息积累的感觉运动策略建模。换句话说,这些模型描述了感觉器官与触觉物体相互作用时的行为或运动。 模型试图描述在动物和人类中观察到的触觉导向行为,或者导出最佳的感知策略,然后将它们与观察到的行为进行比较。

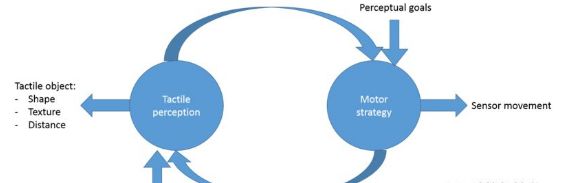

图1: 主动触觉感知模型架构

由于触摸,而不是视觉、听觉和嗅觉,是近端感,即感官必须与物体接触才能感知,运动通常是触觉策略描述的一部分。 在许多啮齿动物等夜间动物中,触感系统(一系列可移动的面部毛发)被用于在黑暗中感知环境。 因此导航和物体识别主要是通过触觉来完成的。 已经开发了几种触觉引导运动的模型来解决这种跨模态的整合。

从其他意义上讲,基于代理人的经验和与环境的相互作用,触觉知觉在本体论发展过程中发生变化。 这一变化的一部分是探测触觉物体的感觉运动触觉策略的出现。 例如,幼仔的触须在成熟到成年时就表现出不同的方式( Grant et al。2012 )。 发展模式试图用感官指导运动学习的基本原理和内在动机探索来描述这种探索行为的出现。

模型类型

触觉感知建模通常由两个主要组成部分组成,即感知和行动。 知觉部分试图描述触觉信息整合到一个凝聚力感知。 动作组件试图描述为了移动感觉器官而使用的动作策略,以便它可以获取这个信息。

触觉感知通常通过人工神经网络或贝叶斯推断来建模。 使用人工神经网络(ANN)来描述感知任务期间的学习过程。 它们与生物神经系统更密切相关,并有许多计算有效的工具来实施它们。 人工神经网络通常以监督学习的方式使用,其目的是通过标记的训练集来学习触觉辨别,或者捕捉整个感觉运动因子 - 环境相互作用的连续变量前向模型。 贝叶斯推理模型捕获新的观察到的信息到感知更新的单一框架的最佳整合。 来自可能的嘈杂环境的每个新证据被用于以最佳方式更新当前任务中的触觉感知。 这些模型具有较少的自由参数来调整,并且近年来已经显示出很好地描述人类和动物中的许多感知任务。

触觉感知的运动策略通常通过最优控制理论或强化学习来建模。 最优控制理论是一种数学形式主义,其中定义了一个成本函数,然后使用已知的数学技术来找到最小化成本的最佳轨迹或策略。 在触觉感知任务中,成本函数通常是感知错误的组合,例如歧视歧义和移动感官的能量成本。 因此,最优控制解决方案可以给策略或最佳行为,使感知最大化,同时使能量成本最小化。 强化学习是一个计算范式,试图找到最大化未来累积奖励的政策或行为。 这是一个循序渐进的学习过程,与环境的重复交互导致收敛到最佳策略。 在触觉感知任务中,奖励是任务的完成,并且该模型导致融合感觉触觉触觉策略。 最优控制和强化学习的主要区别在于前者是解决“离线”问题,而后者是一种考虑到与环境相互作用的学习算法 。 虽然两者都有最佳的策略或政策,但形式主义和数学技术是不同的。

模型应用

触觉和发展模式可以用几种方式使用。 第一个是试图描述,解释和预测动物和人的触觉行为。 在每个触觉任务中,观察到的行为被记录和分析。 然后构建模型来尝试和重新捕获相同的行为,然后对新任务中的行为进行预测。 然后在这些新的预测任务中验证模型。

触觉模型的第二个应用是对基础神经元机制的理解。 例如,啮齿动物的触须系统已经研究了数十年,并且已经产生了对导致触觉感知的潜在神经元网络的深刻理解。 将描述触觉的模型组件连接到特定的大脑区域或功能可以增加对这些区域的理解,并可能尝试解释模型和神经学术语中的异常行为。

触觉模型的另一个应用是它在人造代理中的实现,例如机器人。 具有触感的机器人平台受到对生物触觉感知模型的新理解的启发。将电机集成到感官中,例如人造晶须机器人或触觉传感器覆盖的机器人手指,使得物体感知的新能力成为可能。 然而,控制这些机器人平台变得不平凡,因为在这些以感知为导向的领域中已知的以运动为导向的控制策略失败。 实施生物启发的感觉运动模型会导致更好的表演机器人。

主动感应

生物应用

为了正确理解啮齿动物在众所周知的称为极点定位的感知任务期间使用的触觉感觉运动策略,人类被用作啮齿动物的模型( Saig 等 ,2012 )。 受试者在他们的指尖配备了人造晶须,并被要求定位一个垂直杆,即确定哪个杆更后,只使用他们从晶须得到的信息,因为他们的视力和试镜被阻止。 力和位置传感器被放置在手指须连接上,这使得能够充分访问进入“系统”(即,人类对象)的信息。 结果表明,人类自发采用类似于啮齿类动物的策略,即通过同步移动双手并根据极点位置感知时间差异来与人造晶须“搅动”。 换句话说,他们通过将双手合在一起并且首先检测哪一只手触摸了一根杆来确定哪一根杆更后。 虽然还有其他可能的非主动策略来解决这个任务,例如通过将他们的手放在杆子上并感应手部之间的角度差异,参与者选择采用主动感知策略。

为了对这种行为进行建模,贝叶斯推理方法被选择用于触觉感知,而最佳控制理论方法被选择用于运动策略分析。 然后把这个任务描述成一个简单的二元区分任务,即哪个极点更后验,并且通过整合两手之间的感知时间差异来建模贝叶斯更新规则。

高斯噪声模型被假定为感知的时间差异,引入时间噪声的参数,即两个刺激仍然可以被认为是不同的。 在贝叶斯推断模型中引入的另一个重要参数是置信概率,在该置信概率之上的主题决定报告他们的知觉答案。 换句话说,在与极点重复接触之后,一个极点更后的概率增加; 超过这个门槛的主体停止互动,并报告的感知结果?

所选择的这种触觉感知任务的贝叶斯推理模型只导致了两个参数,即时间噪声和置信概率,并且允许基于拟合到实验结果的估计。 报告之前的联系人数量显示随着任务难度的增加而增加,这是通过减少两极之间的距离来衡量的,正如贝叶斯模型预测的那样。 312ms84%将模型预测拟合到实验结果使得估计参数:时间噪声被评估为312ms 和置信概率84% 。 时间噪声稍高于先前报道的纯粹触觉时间区分阈值,这是由于这个实验装置是一个主动感测装置,其也引入了电机噪声。 置信概率与许多其他心理实验相当,在这些实验中,受试者在累积信息之后必须报告其感知结果。 因此,触觉的贝叶斯推理模型雄辩地描述了触觉信息的积累和整合。

受试者所采用的运动策略也是结构化的,展现出初始更长,更大幅度的运动,然后是越来越短和更小幅度的运动。 为了对这种行为进行建模,采用了最优控制理论方法,其中定义了成本函数,其次是优化技术,从而产生了使成本最小化的最优策略。 成本函数有三个组成部分:表示任务的感知误差项; 能源成本期限代表费力行动的惩罚; 以及感知成本项,与能源项对称相同,代表太多信息的成本。 该模型捕捉了主体所表现的行为,并导致一个简单的原则,即维持一个不变的信息流。 换句话说,最优控制模型将复杂的触觉感知驱动行为“蒸馏”成单一指导原则。

机器人应用

受到啮齿动物触须系统的启发,构建了一个完全控制移动人造晶须的机器人平台( Sullivan, et al。 ,2012 )。 该机器人被用于与啮齿类动物相似的任务,即表面距离和纹理估计。 换句话说,机器人通过生物启发的运动策略移动了晶须,并通过位于晶须底部的传感器收集关于表面的信息。 机器人采用基于对生物触须系统的理解而设计的触觉感知和运动策略模型。

使用朴素贝叶斯方法对触觉感知进行建模,其中在训练期间,机器人收集关于每种类型的表面和距离表面的每个距离的感官信息,为每个表面构建标记的概率分布。 然后,在验证过程中,机器人在表面上whis,,收集信息,并根据最有可能的类别,根据训练的分布对纹理和距离进行分类。

运动策略采用在啮齿动物中观察到的行为,即快速停止牵引(RCP),这意味着啮齿动物在与物体初始接触后以较小振幅拂动。 这个策略的结果是在第二次拂动之后和表面上的“轻触”。 在机器人啮齿动物中建模和执行相同的行为,在最初感知到与表面接触之后,搅动的幅度减小。 任务的目标和具体模型是确定啮齿动物可能有利用这样一个战略的好处。

研究结果表明,与未调制的搅拌相比,当使用快速停止甩动(RCP)策略时,机器人对表面的质地和距离进行更高效和准确的分类。 对结果的进一步分析表明,使用RCP导致较少噪音的感官信息,这反过来导致改善的分类。 因此,这个模型表明,啮齿动物采用RCP策略不仅保持了晶须的完整性,而且还提高了信噪比和触觉感知。 它还可以开发更强大,更精确的人造代理,并配备移动的触觉传感器 。

触觉导航

生物应用

由于触觉是一种近端感,所以与环境中的物体的直接接触对于触觉是必需的( Gordon 等 ,2014b , Gordon 等 ,2014c )。 为了了解啮齿动物的探索行为,构建了一个模型,试图捕捉它们的探索模式的复杂性和结构。 当啮齿动物被允许自己探索一个新的黑暗竞技场时,他们在舞台上移动,并使用他们的胡须来感知它的墙壁。 他们展示了一个复杂的探索模式,他们首先探索竞技场的入口,然后沿着竞技场的周围墙走,然后才能探索竞技场中心的空地。 他们的探索是由出境探索组成的游览和快速撤退部分组成的,他们回到家里。

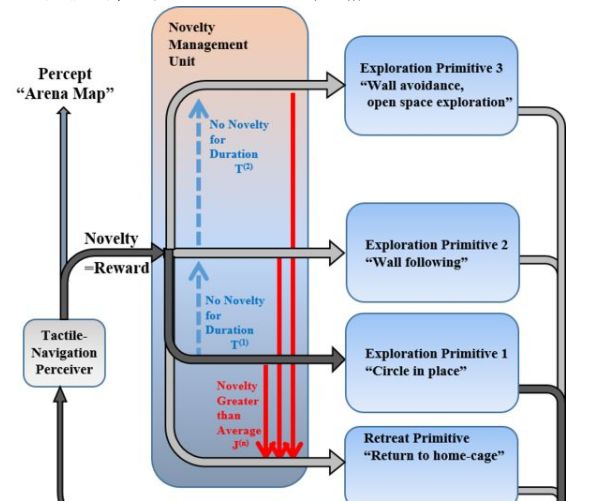

这种触觉驱动的探索策略是使用基于新颖性的方法来模拟的,该方法结合舞台的触觉感知表示和在探测电机基元和退路之间平衡的电机策略。 对于舞台的触觉感知,采用贝叶斯推理方法来表示运动的前向模型。 xo换句话说,竞技场被表示为在给定的位置和方向上的感觉信息的预测,例如,墙被表示为“在位置x 和方位o ,左晶须被预测经历触摸” 。 只要动物在任何位置使用贝叶斯(Bayes)规则感知到新的触觉,并假设感觉噪声,即感知的触觉不一定是正确的,则更新该表示。

采取勘探运动的策略是在勘探运动基元和撤退之间取得平衡,其中新颖性被用作阈值因子。 探索运动基元是根据其感觉触觉来确定啮齿动物的机车行为的策略,例如,跟随的基元是“如果左颊感应到墙壁,向前”的策略,而避开墙壁的原始是策略“如果右颊感觉到一堵墙向左转“。 对三个电机原型进行了建模,即现场循环,墙体追踪和避免墙体。 另外一个“退缩原始”被模拟为:在竞技场目前估计的情况下,采取从当前位置到家笼的最短路径。

图2:触觉驱动导航的新颖性管理模型架构( Gordon 等 ,2014c )。

这些运动基元之间的平衡是基于新颖性来决定的,测量是在竞技场模型被更新的每个时间步骤中的信息增益。 换句话说,无论何时更新竞技场的触觉正向模型,更新的比特数量通过先验分布和后验分布之间的Kullback-Leibler散度量化,代表了新颖性。 每当新颖性高于一定的阈值时,就采用退缩原始。 每当新颖度在一定的时间内低于一定的阈值时,就采用下一个勘探运动基元。 这种生成模型捕获了许多在触觉驱动的探测啮齿动物中观察到的行为,并表明新颖性管理的基本原理可用于建模复杂和结构化的探索行为。

机器人应用

一个机器人平台与致动的人造晶须被用来研究基于触觉的同时定位和映射(tSLAM)模型( Pearson 等 ,2013 )。 在这个设置中,感知任务是双重的,即机器人既需要在空间中定位本身,也要映射环境中的对象。 与许多其他的SLAM模型相反,该模型仅使用晶须阵列的测距和触觉作为其输入,即没有视觉。

触觉驱动的环境探索包括基于占位映射粒子滤波的触觉感知模型和基于注意的“定向”运动策略。 触觉感知模型由占有图组成,其中模拟的环境网格中的每个单元具有被对象占据的概率。 机器人上的人造晶须的每一个刷子都在机器人的估计位置上更新了这个占用图,即如果一个晶须与一个物体接触,那么该单元中占用的可能性就增加了。 为了优化位置和映射的同时估计,使用粒子滤波算法,其中每个粒子具有其自己的占用图,其根据来自晶须的“信息流”而被更新。 为了估计,采用后验概率最高的粒子。

所采用的运动策略控制可移动晶须阵列的运动,并基于执行定向行为的注意模型。 换句话说,基于显着的晶须信息构造了基于显着性的注意图,导致机器人的整个“头部”朝向显着的触觉对象的定向行为。 因此,一旦与环境中的物体接触,机器人就会更详细地探索该物体。 这增加了tSLAM算法所需的信息收集。

研究结果表明,这个机器人在几个几何形状的竞技场中进行了几次探索性的较量,它已经进行了一个同时定位和环境的映射,与高空摄像机测得的地面实况有着令人印象深刻的一致。 该模型显示了来自其他感官的已知和良好建立的模型如何能够适应触觉领域的独特性质,并告知探测啮齿动物可能的感知特征,并且提高基于触觉的机器人平台的性能。

触觉的发展

生物应用

发展模式试图从更基本的原则( Gordon和Ahissar,2012a )解释触觉和其伴随运动策略的出现。 后者假定代理人与其环境之间的反复交互,从而积累了感官知觉的基本机制的统计表示。 此外,在这些发展模型中学习了最大化感知可信度的最佳感觉运动策略,而不是假定或预先设计的。

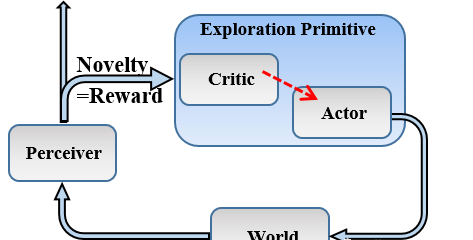

图3:内在奖励强化学习模型架构( Gordon 等 ,2014c )。

一种发展模式框架是人为的好奇心,其中强化学习范式被用来学习最优策略,而奖励功能是内在的,与感官知觉的学习进度成正比。 在这个框架的一个实例化的触觉领域,一个人工神经网络被用来模型的触觉正向模型,即网络预测下一个感官状态根据当前状态和行动执行。 更具体地说,该网络是在触觉系统上进行的,其中感觉状态由晶须角度和二元接触信息组成,并且作用是伸长(增加的胡须角度)或缩回(减小的胡须角度)。 因此,人工神经网络学会了映射在晶须场中的物体,例如,如果晶须长时间会引起接触(有物体),那么给定当前的晶须角度并且不接触。 通过移动胡须,触觉感知模型了解到环境。

发展模式试图回答的问题是,如何最大限度地提高映射环境的效率,最好的方法是移动晶须? 为此,使用内在奖励强化学习,其中奖励与感知ANN的预测误差成正比。 因此,预测误差越多,奖励就越高,体现“以错误学习”的概念。 政策收敛了,把胡须往更不为人知的地方转移。

这种发展模式的结果显示了搅动行为的趋同性 ,从随机运动开始并结束于在成年啮齿动物中观察到的行为,例如用于学习自由空间和触觉诱导泵的周期性搅拌( Deutsch 等人 ,2012 )定位晶须领域的触觉物体。 该模型表明,这些行为是在发展中学习,并不是先天的啮齿动物的大脑。 此外,该模型建议发育特异性的大脑连接性 ,感知学习大脑区域,例如桶形皮层和奖励系统,例如基底节 ,使得前者向后者提供奖励信号 。

机器人应用

在一个手指机器人平台与触觉传感器的人工好奇心原则的研究也进行了( Pape 等 ,2012 )。 目标是研究触觉手指运动的出现,优化表面纹理的触觉感知。 2×2对于机器人平台,使用了一个机器人手指,该机器人手指具有两个基于肌腱的致动器和尖端的三维微电子机械系统(MEMS)触觉传感器。 手指能够弯曲以便触摸具有变化纹理的表面。

0.33s对于触觉感知,在0.33textrms 期间使用聚类算法来区分MEMS记录的结果频谱。 这种无监督的学习模式代表了将触觉感觉信息抽象为不连续的触觉感知。 然而,聚类仅在最近的观察中进行,并且因此取决于手指的移动,例如,自由移动而不接触产生与在表面上轻敲不同的光谱。 在这项研究中提出的问题是:“通过固有的动机机器人手指学习不同的触觉,学习哪些技能?”。

为此,开发了一种奖励机制,以便在各方面的探索中获得内在的回报:鼓励探索的手指位置的未开发状态的奖励是高的; 奖励结束在触觉感知状态,从而驱动对特定触觉的感觉,体现主动感应原理; 奖励技能仍然在变化,从而注重技能的稳定。 这种复杂的奖励机制确保了出现一些内在动机稳定的技能,旨在达到特定的触觉感知。 每一个开发的技能都以一种可重复的方式产生了独特的感觉。

这项研究导致出现了几个具有内在动机的技能:

1.避免导致自由空气触觉的表面的自由运动;

2.轻敲动作,导致表面独特的光谱;

3.滑动运动导致纹理特定的光谱。

这些众所周知和记录的人类手指驱动的触觉感知的触觉策略从内在动机出现并且未被预先设计。 因此,发展模式导致学习与独特的触觉感知相关的触觉技能。

-

触觉

+关注

关注

0文章

19浏览量

9455 -

RCP

+关注

关注

0文章

24浏览量

9018

原文标题:触摸心灵-触觉感知和发展的模型

文章出处:【微信号:AItists,微信公众号:人工智能学家】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

触觉传感器的发展,对机器人产业有什么影响?

人形机器人感知变化的未来

多层感知机模型结构

AI大模型的发展历程和应用前景

华中科技大学研发微型传感器,索尼预测其图像传感器市场份额明年将突破 60%

触觉智能EVB3588实测运行大模型,效果nice!

LeddarTech和Immervision达成合作,加速ADAS和AD感知模型训练

LeddarTech 和 Immervision 联合宣布 合作加速 ADAS 和 AD 感知模型训练

触觉传感器新进展:从传感器制造到高级应用

一种基于摩擦电传感器并集成量子棒增强功能的新型触觉感知系统

触觉感知和发展的模型

触觉感知和发展的模型

评论