多传感器前融合是否是无人驾驶的必由之路?近日,Roadstar.ai首席科学家周光主讲,主题为《多传感器融合,无人驾驶的必由之路》,给出了答案。

近日,Roadstar.ai首席科学家周光主讲,主题为《多传感器融合,无人驾驶的必由之路》。本文为周光的主讲实录。一起了解周光的主讲提纲:

主讲实录

周光:大家好,我是Roadstar.ai的首席科学家周光。很高兴能跟大家交流多传感器融合。

经过一年的时间,现在在设计无人驾驶中大家都普遍认同多传感器融合这一方案。我还记得一年以前,当我们刚出来创业的时候,市面上其实没有任何一家企业是认同这个方案的。经过这一年的技术攻关,我们Roadstar最终向所有人证明了这套方案的先进性以及可行性。我们现在能够做到在深圳,硅谷等地的复杂场景实现单次高达数小时的无人驾驶。从今年2月份在中国上路测试到今天,我们测试了大概有几千公里距离,没有发生过一起事故,同时我们的接管率也是几乎接近于零。

跟大家介绍一下我们公司的创始团队。我们公司的三位创始人,我和佟显乔、衡量都是在百度认识的。在这里我要感谢百度作为中国无人驾驶的黄埔军校,为大家提供了各式各样的人才。

今天我要讲的内容分为四个方向。首先我会跟大家大概介绍一下全球无人驾驶的格局以及技术方案;之后会讲解一下多传感器融合的基本原理以及一些简单的算法;然后我会讲基于前融合的技术方案的优势以及在具体场景下做一些解析;最后讲解一下基于前融合技术如何加快落地以及商业化。

Part1

这幅图简要地介绍了无人驾驶的历程。无人驾驶是源于美国的DARPA比赛,分为两届,一届是2005年,一届是2007年。在此之后,Google把DARPA中斯坦福团队收编,并于2009年由塞巴斯蒂安·特伦(Sebastian Thrun)开启了无人驾驶这个计划。在这之后很长的一段时间里,全球只有Google这一个玩家,直到2014年新的玩家Uber以及百度入局。之后由于深度学习的发展,给了无人驾驶一个可能看清楚事件的眼睛。

此后,无人驾驶开启百家争鸣,形成科技公司主导的无人驾驶方案和由主机厂主导的无人驾驶方案二个流派。由于基因不同,科技公司和主机厂有着明显不同的技术方案。

传统主机厂多数都是以摄像头和毫米波雷达为主,主打L2、L3的无人驾驶方案。而科技公司由于没有量产的压力,是采用激光雷达的方案。

在这些主机厂中,也有着明显的不同。美国主机厂是依靠并购,比如Cruise被GM收购,Argo AI被福特收购。日本和德国的公司则是采用一种自研的方式。

下面我跟大家讲解一下无人驾驶的四代系统:

第一代无人驾驶系统——也是今天在国内广泛应用的无人驾驶系统,最明显的特点是头上有一颗Velodyne的64线激光雷达,这是源于2007年的DARPA无人驾驶挑战赛。该方案在国内有百度、腾讯、Pony和景驰等公司在继承。这种技术方案是单一传感器不融合的方案,也即是说不同的传感器做不同的任务,比如用64线激光雷达做人的检测,用相机做红绿灯的识别等。

第二代方案由Waymo以及Cruise等公司在继承,主要特点是整个车辆采用多颗低线束激光雷达融合Camera以及各种传感器的技术方案。

第三代无人驾驶系统是2018年年初由丰田在CES上展出的基于全固态前装的无人驾驶方案。可以看到这一代方案有两个不同:一是用多颗固态激光雷达,二是做到了车辆的前装车规级。

第四代方案是移动空间这个概念。在这个移动空间的方案中,车辆不再具有方向盘,整个车的概念和品牌也都不再重要,车只是为人类提供一个移动的空间。其实这也是今天所有公司,不管是互联网巨头还是主机公司都在追求的终极目标。

这幅图具体展现了前两代的一些代表公司。在下面的是2012年采用64线激光雷达方案的谷歌以及其他公司。上面的是最新的Waymo、Cruise、Drive.ai以及Roadstar.ai。Waymo采用了一颗高线束加6颗低线束的融合;Cruise采用了两颗32线以及两颗16线;Drive.ai采用了六颗16线;Roadstar采用了一颗32线加4颗16线的方案。

Part2

下面简单讲一下多传感器融合的基本原理和算法。多传感器融合分为两块,第一块是传感器同步技术,第二块是基于融合数据开发的算法。

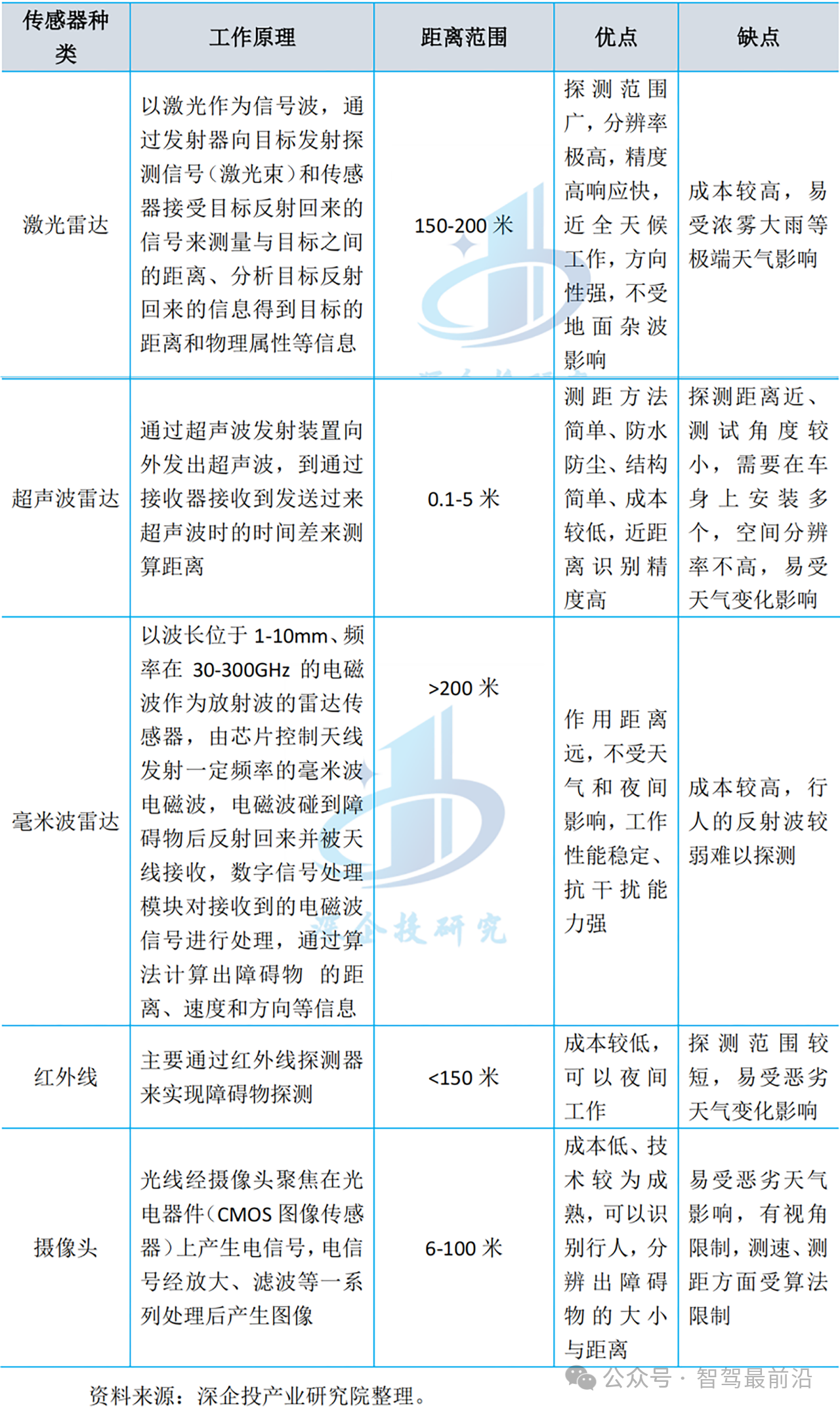

简单的传感器融合,我相信大家也不陌生,不外乎就是每个传感器的数据能大致在空间跟时间上能得到对齐。而整个多传感器融合技术的核心就在于高精度的时间以及空间同步。精度到什么量级呢?举个例子,比如时间上能得到10的-6次方,空间上能得到在一百米外3到5厘米的误差,这是一个典型的技术指标。当然,多传感器同步技术的难度与时间和空间的要求是一个指数级的增加。在百米外能得到3cm的空间精度,换算成角度是0.015度左右。大家也知道在无人驾驶当中,毫米波雷达、相机、激光雷达和超声波都是完全不同的传感器,让他们在时域跟空域上得到这样的精度是非常难的,需要对机器人技术以及机器学习优化技术有非常深的理解。

Roadstar的多传感器技术不仅仅在国内得到了认同,在国际上也得到了广泛的认同。我们之前去过丰田的日本总部,也见到了他们负责研发的老大。他们也知道多传感器融合做前融合很重要,对系统的提升很大,但是他们老大认为这东西不可能被实现。但是当我们展示出Roadstar的多传感器融合视频,他们当时就被震惊了。整个丰田在东京的负责人都过来看我们的传感器融合方案。

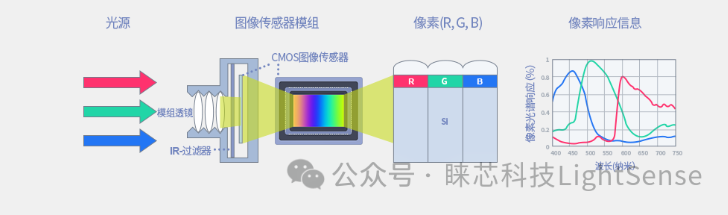

当有了异构多传感器同步技术之后,我们针对这个数据集开发了自己的感知以及定位算法。这个数据集是一个8维的数据集,其中包含了X,Y,Z的空间数据以及R,G,B的颜色数据、激光反射值数据和多普勒速度数据。

这是一个比较简单的calibration的算法,我大概讲一下。

第一个算法,本质上是在事件坐标系中,你得到相机以及手的Pose信息,然后根据它转换的几何限制,最终可以解算出你的X。

第二个算法,对应的是在事件坐标系以及机器人自己的坐标系中,你分别知道传感器的运动轨迹、手的移动轨迹以及两个坐标系中的转换等信息,然后通过这个反算出你的X。

上面这个视频是做了完美的前融合之后的效果。这也是当初我们呈现在日本丰田总部让研发老大所震惊的视频。

大家可以看到,这是一个270度环视摄像头。彩色的点是激光雷达的点,当时车速大概是60到80km/h。不管是在极远处还是在极近处,所有激光雷达的像素点和图片的像素点都达到了像素级别的误差。

整个Sensor Fusion的视频是可以实时显示在我们车上的。我相信做过机器学习的同学,很快就能get到,如果能有这样一套完美的系统,那对感知的提升是非常非常Significant的。

做Machine Learning的朋友都知道PCA算法,但PCA算法跟传感器融合是完全相反的方法。在Deep Learning产生之前,由于传统的Machine Learning并不能够高效地学出数据中的信息,因此才诞生了PCA算法。而在今天深度学习技术得到极大提高的情况之下,PCA算法也就再没有人提了。

在传感器融合提供的8维数据中,每个通道都是没有任何冗余信息,能够极大的提高整个系统的可靠性以及稳定性。相比于传统的方法,我们能够非常容易地提高十个点以上表现。

这是我们从网上搜集到另外一些无人驾驶公司融合失败的案例。大家可以看到,这个无人驾驶汽车是静止地停在一个测试场地,前面是有一个车在绕圆圈或者是八字,但是点云跟相机的信息是差了半个车头的距离,这个误差是随着距离呈线性增加的。目前这个距离大概是十米,可以想象在100米或者50米开外的时候,车和车已经是完全分离的。因此,这种融合效果是不能为系统增加额外的可靠性以及稳定性的。

这个例子能够比较形象地解释为什么高维数据会更好。左边是平面的2D信息,大家可以想象一下,如果想分割出里面红色的元素,是需要做非常复杂的曲线能分开。其实原始的信息是在右边。右边的信息,可以通过简单的一些平面就能分开。

下面我跟大家介绍一下前融合算法和后融合算法的区别。左边的方法对应的是后融合算法。在后融合算法中,每个传感器都有自己独立的感知,比如激光雷达有激光雷达的感知,摄像头有摄像头的感知,毫米波雷达也会做出自己的感知。在最终的Objectlist结果汇总里面,它会通过一些人工算法过滤或者合并掉一些物体。

在前融合过程中,我们只有一个感知的算法。我们在原始层把数据都融合在一起,融合好的数据就好比是一个Super传感器,而且这个传感器不仅有能力可以看到红外线,还有能力可以看到摄像头或者RGB,也有能力看到三维信息,也有能力看到LiDAR信息,就好比是一双超级眼睛。在这双超级眼睛上面,我们开发自己的感知算法,最后会输出一个结果层的物体。

这样讲可能大家还不太清楚为什么前融合更好,我在这里举一个例子。假设在你手上有一个手机,激光雷达只能看到手机的的一个角,摄像头只能看到第二个角,而毫米波雷达可以看到第三个角,那么大家可以想象,如果使用后融合算法,由于每个传感器只能看到它的一部分,这个物体非常有可能不被识别到,最终会被滤掉。而在前融合中,由于它是集合了所有的数据,也就相当于可以看到这个手机的三个角,那对于前融合来说,是非常容易能够识别出这是一台手机的。

除了以上提到的优点,多传感器融合还有另外的一个优点。

我们相信,前装的固态是真正无人驾驶的未来。但是每个固态雷达有它的特性,尤其是MEMS雷达。MEMS雷达是基于谐振反算出一个角度,从而得到这个点云在空间中的位置。由于这并不是直接测量,而是间接测量的角度,从而导致固态雷达的点云分辨率很低,对温度也很敏感。

同时每一个固态雷达都只能有有限的Field of view,这就导致要想使用固态激光雷达,你必须得是多颗融合在一起。之前我跟大家介绍的四代技术当中,第一代技术是不能直接跳跃到第三代技术的,因为第一代技术不能够做到低线束的融合;另外由于点云质量的降低,对于第一代单一传感器的技术,感知效果会更差;如果没有加入Camera信息,那么它的感知是没法在常用场景上开的。这就是为什么到今天为止,就我们公司能够做到在极端复杂的场景下实现完美的感知,同时车能够开得非常的好。

这一页是重复讲我之前提到的后融合的缺点,大家可以再看一下。

对于DeepFusion技术,由于它的信息中每个通道的不冗余性,最终导致算法对数据的依赖会极大的降低。在我们的数据集中,我们做了一个简单的测试,DeepFusion采用前融合的算法,我们大概采用1万帧左右的算法,能得到传统算法10万帧的效果。除了Corner Case以及数据集的远远减少以外,DeepFusion还有其他的一些Benefits。比如采用DeepFusion的数据集是可以当做来L2、L3的Ground Truth,你在出去标注的过程中,需要标注一次,那么你会完成对所有数据的标注。

Part3

接下来我跟大家讲一下Roadstar基于前融合技术所开发的无人驾驶系统。

上图是我们Roadstar使用的机顶盒,是第二代传感器平台,我们称之为One cable solution。在这个机顶盒上有着5颗低线束激光雷达,加上6颗摄像头、3颗毫米波雷达和GPS&IMU系统。所有的传感器都会在这个机顶盒中做处理,包含异构多传感器同步技术。处理好的数据会通过一根Cable输入到我们的电脑当中,电脑接入这个数据后进行检测、决策、定位算法,最终会通过Control来控制这个车。

相比于大多数公司的方法,我们的硬件平台非常的稳定,到今天为止我们没有发生过由于硬件Failure导致系统宕掉的情况。讲个小插曲,在硅谷的那段时间,我们曾经有过3颗激光雷达坏掉,但是我们的车依然完成了无人驾驶,安全地把乘客送回我们的公司,乘客当时也是非常地惊讶。

这是Roadstar 的L4系统架构。这个架构相信做无人驾驶的人应该也不是太陌生。最左边是传感器模块,最右边是Perception + Decision+Control模块,以及中下的定位模块。

在整个架构中,中间蓝色部分的HeteroSync和DeepFusion是Roadstar的核心技术。基于这个技术,我们的感知和定位都能得到一个量级的提升。

这是Roadstar采用的神经网络。中间网络的具体架构部分被我省略了。大家可以看到我们的Input是来自于八维的高位数据,Output是3D Bounding Box。

这是Roadstar Daytime的Perception。在每个Bounding Box中,左上角是ID,右下角的是车速,可以看到我们准确地识别出路上的所有车以及行人。整个视频我们是做了3倍速的加速。

从上面我们知道基于前融合的感知是如何的强大。在整个路测当中,在80米内的人和车基本都是没有被miss掉的,我们得到一个非常高的Perception Recall。

大家可以看到,Roadstar在深度学习上有非常强的功底。我们在CITYSCAPES数据集上,目前在语义分割上是排第一。我们基于单一传感器的激光雷达的感知目前在KITTI上也是居于前三。在我们前融合的内部Benchmark上,easy我们有接近99%的average precision,在Moderate和Hard基于前融合上能够达到接近90%的水平。我觉得完美的感知是无人驾驶真正实现的前提。但我也知道多数公司其实并不敢把自己的感知显示给客人看。但在Roadstar,任何过来试车的人都能看到完全跟上面视频一样的感知画面以及感知体验。

DeepFusion技术除了能够在Perception上极大地提高感知,在地图定位上也能够极大地提高系统的鲁棒性。对于传统定位,比如今天阿波罗上用的是2D反射值定位,有着很大的缺陷。由于天然2D的特性,它在高架桥上以及在多层停车库里面都是不工作的。另外,反射值地图的定位,在对车的Hidden上,它无法做z和heading上的修正。Roadstar用了整个三维点云的信息以及Camera的信息,极大地提高了定位的效果。

这个视频是我们在多层停车场中的定位效果。大家可以仔细看一下,整个停车场是没有GPS信号的,整个车辆的定位是完全按照imu以及LiDAR的feature来做到的。

在这个视频的右下角是Camera的View,也可以看到这是一个完全封闭的停车场,没有任何的GPS信号,而且我们的车也长时间地停在车库当中。

定位技术在中国特色的路况下是极其重要的。相比于美国的简单场景,不少相当于中国的大农村,建筑一般都是不超过三层的。GPS在这种场景之下是不会有多次反射的影响,单靠GPS&IMU定位是足够的。但中国城市化高,高楼大厦会极大地影响着GNSS系统的稳定性,如果没有一套良好的设备,而Demo测试的场地往往都是在开放的场地上进行的,比如在政府大厅的一个开放路段上进行。待会我们会给大家放出,Roadstar在深圳的路测场景,整个都是在特别高的树木遮挡下进行的。

Part4

最后讲一讲, Roadstar如何利用我们先进技术来加快商业落地以及商业化。

去年10月到11月份,我们就在硅谷实现了四小时长时间的无人工干预的测试。当时在苹果总部等交通繁忙路段实现了完全的无人驾驶,包含非常常见的场景,比如红灯右拐、换道汇入等等,整个车速应该是60迈/每小时。

今年2月份,我们在深圳西丽实现了高达50Km/h的路测,其中包含了中国特色的测试场景,比如紧急加塞、送外卖小哥逆行、中国式过马路、翻栏杆等等几个场景。现今为止,我们是唯一一家能够做到在这种场景下测试的公司。

大家应该看完了刚才的视频,中间有一些场景我们都做了解释。最后可以看到有一个行人是紧急加塞,我们的车也做了准确的识别,并且做到减速避让。

这是Roadstar的发展历程。从去年5月份成立到今天还不到一年时间,Roadstar就实现了在中美两地最复杂路况上的测试,而且我们是采用一个完全不同于第一代无人驾驶的解决方案。

之后我们会做无人车队运营。在2018年,我们在深圳会铺20辆乘用车,每个车辆配备一名安全员做一些数据的收集以及技术的验证,向政府证明Roadstar可以安全地做到车辆的运营;2019年我们会跟车厂或者是Tier1进行合作,生产100台无人车,同时跟出行公司或者是自己开发打车软件,提供比较大范围的出租车或专车服务。当然,在2019年我们依然会配备安全员,保证用户的体验。

经过这两年的数据收集,Roadstar会配备1500台车以上,然后做一个大范围,比如深圳一个区或者是深圳市以上,这时车辆将不再配备安全员,并且使用远程干预来实现运营。

-

传感器

+关注

关注

2551文章

51163浏览量

754133 -

无人驾驶

+关注

关注

98文章

4067浏览量

120567

原文标题:多传感器前融合是无人驾驶的必由之路?Roadstar.ai首席科学家给出了答案 (附课件)

文章出处:【微信号:IV_Technology,微信公众号:智车科技】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

测速雷达与无人驾驶技术的结合 测速雷达故障排除技巧

东华软件:多地无人驾驶项目成功落地

UWB模块如何助力无人驾驶技术

特斯拉推出无人驾驶Model Y

无人驾驶汽车应用晶振TSX-3225

中国或支持特斯拉测试无人驾驶出租

如何利用无人机物联卡实现无人驾驶飞行

用于自动驾驶,无人驾驶领域的IMU六轴陀螺仪传感器:M-G370

32.768K晶振X1A000141000300适用于无人驾驶汽车电子设备

5G车载路由器引领无人驾驶车联网应用

多传感器融合,无人驾驶的必由之路

多传感器融合,无人驾驶的必由之路

评论