上周,Apollo美研在桑尼维尔举行了关于Apollo 2.5的Meetup。会上,Apollo美研团队的技术大牛与来自硅谷众多的在校学生、车企等自动驾驶爱好者共同分享交流了Apollo 2.5相关的深度技术。没能到达现场的国内开发者可以通过以下视频资料回顾相关技术干货。

Apollo 2.5 Platform Overview

Jingao Wang

首先,Apollo平台负责人王京傲为大家做了关于Apollo 2.5平台的Overview,让国外开发者进一步了解Apollo 2.5。

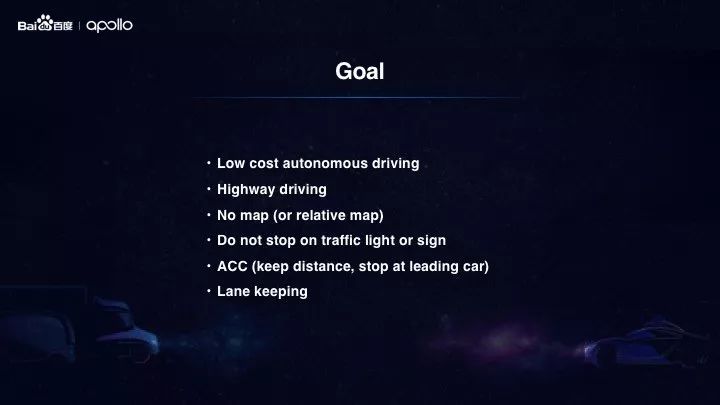

Apollo 2.5 解锁了限定区域视觉高速自动驾驶,为开发者提供了更多场景、更低成本、更高性能的能力支持,开放了视觉感知、实时相对地图、高速规划与控制三大能力以及更高效的开发工具。

目前在GitHub上有9000+开发者推荐Apollo,超过2000家合作伙伴使用Apollo,开发者在Apollo上已经贡献了20w+行代码,越来越多的开发者通过Apollo搭建了属于自己的自动驾驶系统。

此外,在场景应用方面,Apollo 还可支持包括乘用车、卡车、巴士、物流车、扫路车等多种车型和应用场景。

Vision-Based Perception forAutonomous Driving

Tae Eun

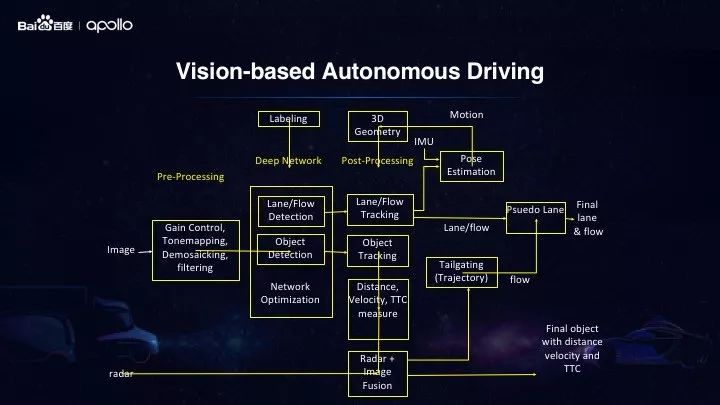

在Apollo 2.5中,基于摄像头的感知,简化了传感器方案,增强了感知能力。在此次Meetup中,来自Apollo美研团队的高级架构师Tae Eun分享了关于摄像头的低成本视觉感知方案。

Apollo2.5 提供了多个集成式广角摄像头配合激光雷达,毫米波雷达的方案。其中以单目广角摄像头和毫米波雷达的低成本方案,相比之前2.0中64线激光雷达+广角摄像头+毫米波雷达的硬件配置方案,成本降低了90%。这种大幅度的成本节省,加上高效率的感知算法,将大大有助于测试有限区域的高速公路驾驶。

此外,传感器的减少并不会降低感知的性能。在Apollo 2.5中我们使用了基于Yolo的多任务深度学习神经网络来进行障碍物和车道线的检测及分类。

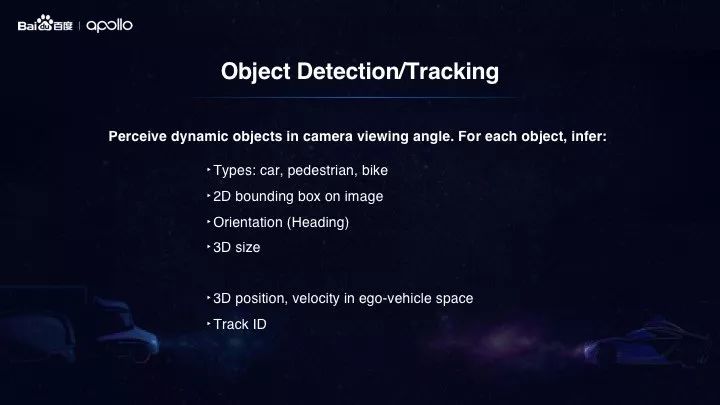

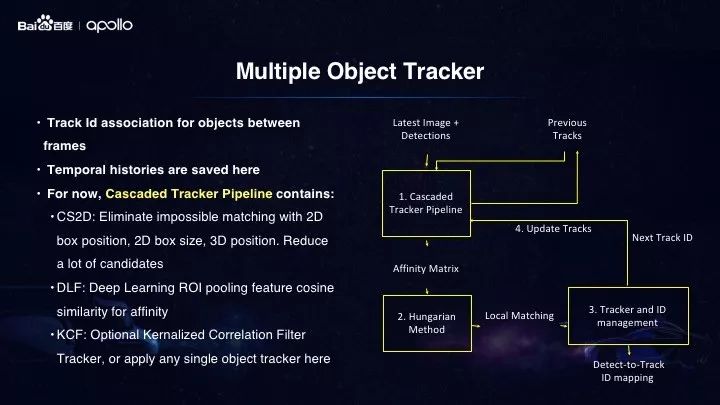

感知输入是从摄像头捕捉的视频帧,我们可以将其视为一系列的静态2D图像,所以如何从这些视图中计算出障碍物的3D属性便是关键问题。在我们的方法中,我们首先使用深度学习神经网络来识别2D图像中的障碍物,通过获得的边界框和障碍物的观察角度。然后,我们可以使用line-segment算法,用摄像头射线和摄像头的校准来重建3D障碍物。整个过程可以在小于0.1毫秒内完成。

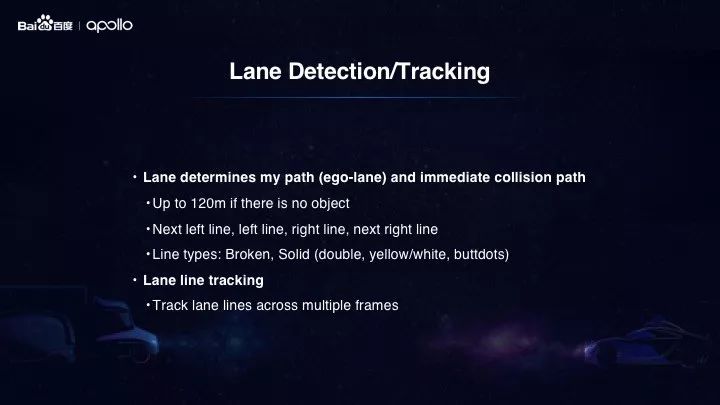

最后,我们来看看处理后的车道线逻辑。首先,用深度学习神经网络扫描2D图像的每个像素以确定它是否属于行车道,以便生成像素化的车道线。然后,使用连接分析,我们可以将相邻的车道线像素连接起来完成整个车道线段的连接,通过多项式拟合确保车道线的平滑性。根据当前车辆的位置,我们可以推导出车道线的语义含义:无论是左,右或相邻的车道线。然后将车道线转换到车辆坐标系中,发送给其他需要的模块。

-

神经网络

+关注

关注

42文章

4773浏览量

100877 -

自动驾驶

+关注

关注

784文章

13846浏览量

166575 -

Apollo

+关注

关注

5文章

342浏览量

18472

原文标题:Apollo Meetup | Apollo 2.5平台解析与自动驾驶视觉感知分享

文章出处:【微信号:Apollo_Developers,微信公众号:Apollo开发者社区】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

FPGA在自动驾驶领域有哪些应用?

【话题】特斯拉首起自动驾驶致命车祸,自动驾驶的冬天来了?

自动驾驶真的会来吗?

3天造出自动驾驶汽车的百度Apollo,背后竟有50多个后台

UWB主动定位系统在自动驾驶中的应用实践

自动驾驶系统要完成哪些计算机视觉任务?

基于视觉的slam自动驾驶

自动驾驶系统设计及应用的相关资料分享

自动驾驶技术的实现

浅析Apollo 2.5限定场景低成本技术方案

百度Apollo完成国内首例自动驾驶上高速测试

Apollo开发套件加速自动驾驶研发

百度Apollo自动驾驶科技教育华西区域示范基地落地重庆永川

Apollo 2.5解锁了限定区域视觉高速自动驾驶

Apollo 2.5解锁了限定区域视觉高速自动驾驶

评论