关于人工智能的争论已经激烈到了一个临爆点。想要寻找一个戏剧化的冲突场景?不妨追一追正在播出的《西部世界》、《真实的人类》等美剧。

乐观主义者对AI的热情更盛,他们渴望将日常生活中的更多事物自动化。怀疑论者对AI的态度更加谨慎,他们认为AI对人类社会带来的颠覆可能不全是有益的,并且刻意减少对AI工具的使用。

拒绝AI赋能,或许会使一大群人在未来的社会竞争中处于劣势。因为对AI信任的程度可能导致就业机会的差异,从而影响每个人社会经济地位的变化。AI追随者和AI否定者之间的冲突可能最终会迫使政府出台不利于创新的政策。想让AI充分发挥其潜力,我们必须找到让人们信任它的方法。

每期监测和精编中文视野之外的全球高价值情报,为你提供先人一步洞察机会的新鲜资讯,为你提供升级思维方式的深度内容,是为[ 红杉汇内参 ]。

三个方法缓解

AI信任危机

除非你过着隐居生活,否则你的生活中一定充斥着关于机器学习和人工智能的各式新闻。人工智能的一系列突破性进展,似乎已经让它具备了预测未来的能力。警察利用人工智能来确定犯罪活动可能发生的时间、地点;医生用它来测算病人什么时间最可能心脏病发作或是中风;研究人员甚至尝试着赋予人工智能想象能力,让其能够预测未来。

当然,我们生活中的许多决定需要基于准确的预测,而AI一般都比人类能作出更好的预测。但是,尽管取得了如此的技术进步,人们似乎对AI的预测结果依然充满不信任。

想让AI给人类带来实在的好处,我们必须要找到一种方式,使其获得人类的信任。

我们应该信任机器人医生吗?

利用世界上最强大的超级计算机系统,IBM推出的针对癌症的人工智能软件Watson可以给医生提供最好的癌症治疗建议。该软件声称可为12种癌症提供高质量的治疗建议,这包括了世界上80%的癌症病例。目前,已有超过14000名患者接受了它计算出的治疗建议。

然而,当医生们开始和Watson人机互动的时候,他们发现自己陷入了相当尴尬的境地。一方面,如果Watson提供了符合他们观点的治疗建议,医生就不觉得它的建议有价值。

计算机只是告诉了医生们已经知道的东西,这些建议也没有改变目前采用的疗法。它可能作为定心丸,让医生们对自己的决定更加自信。但是IBM目前还没提供Watson真的可以提高癌症患者存活率的证据。

另一方面,如果Watson的建议正好跟专家的意见相左,医生们则会认为它能力不足(或是将这一不权威的解决办法归咎于系统故障)。更多的情况是,机器无法解释为何其治疗方法很可能是有效的,因为其机器学习算法过于复杂,人们没法完全理解。结果,这又导致了更大的不信任,让很多医生直接无视了看起来有点古怪的人工智能建议。

信任问题的根源在于人类自身

很多专家认为未来社会将建立在有效的人机合作上,但是人类对机器缺乏信任是阻碍这一未来实现的最重要因素。

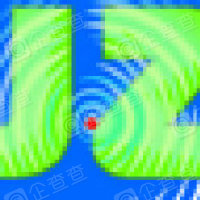

Watson存在的问题在于医生的不信任。人类的信任往往是基于其他人怎么想,以及拥有关于其可靠性的经验。这两者都可以帮助人们建立心理上的安全感。而人工智能目前对大多数人而言仍是相对较新颖的东西。它采用复杂的系统性分析,从大量数据中识别出潜在模式和虚弱信号。

即使技术上可以解释得清楚(但情况往往并非如此),人工智能的决策过程对很多人而言依然过于难以理解。与我们不能理解的事物互动,则可能会导致焦虑和失控的感觉。很多人并不熟悉人工智能真正起作用的情况,因为这往往发生在幕后,但是他们却能十分清醒地看到人工智能发生重大错误的情况:

▨将有色人种视为大猩猩的谷歌算法;

▨在圣弗朗西斯科闯红灯的Uber自动驾驶汽车;

▨自动生成的、将广告投放于反犹太和恐同视频旁的YouTube广告宣传活动;

▨某个搭载了亚马逊语音助手Alexa的设备给儿童提供成人内容;

▨游戏“口袋怪物”的算法再次出现种族隔离问题,使其火上浇油;

▨微软聊天机器人变成了白人至上主义者;

▨自动驾驶模式的特斯拉汽车发生了一起致命事故。

这些不幸的事件收获了过多的媒体关注度,再次强调人类不能总是依靠技术这一信息。最后,所有的一切都会回到机器学习也会出错这一简单事实上。

《终结者》的观影影响:

被AI分裂的社会?

人类对AI的感情可谓复杂。但是为什么有些人能接受AI,而另一些人却对其深表怀疑呢?

2017年12月有一组实验,要求各种不同背景的实验对象观看一些关于AI的科幻电影,并在观影之前和之后分别邀请他们填写关于他们对自动化看法的调查问卷。询问的内容包括他们对互联网的总体态度、他们在AI技术方面的体验、将日常生活中某些任务自动化的意愿:哪些任务是乐意用假想的AI助手实现自动化的、以及哪些任务是想要坚持自己执行的。

令人惊讶的是,像《终结者》《云端情人》或《机械姬》这类电影,为我们描绘的是一个乌托邦还是反乌托邦的未来都并不重要。实验发现,无论人们观看的电影是以积极还是消极的角度去描绘AI,只是单纯的在电影世界里观看到高科技未来,就能使参与者的态度变得极端化。乐观主义者会对AI的热情变得更盛,他们渴望自动化日常生活中的更多事物。相反,怀疑论者对AI的态度就变得更加谨慎,他们质疑AI的潜在益处,并且更愿意积极抵制朋友和家人使用AI工具。

从这些发现中得到的启示是令人担忧的。一方面,这表明人们带着偏见使用AI相关证据来支持他们现有的态度,这是一种根深蒂固的人性趋势,被称为“确认性偏差”。这种认知偏差是在研究中观察到的极端化效应背后的主要推手。

另一方面,由于技术进步的步伐不减,拒绝接受AI所能带来的优势,可能会使一大批人处于严重的不利地位。随着人工智能在大众文化和媒体中的出现频率越来越高,它可能会促成严重的社会分裂,使其分裂为两拨人,一拨是AI的信仰者(并因此受益的人),一拨是拒绝AI的人。

更中肯地来讲,拒绝接受AI提供的优势,或许也会使一大群人处于严重的劣势。这是因为AI信任上的差异可能导致就业机会的差异,从而导致社会经济地位的差异。AI追随者和AI否定者之间的冲突可能会促使政府采取无情的监管措施,从而遏制创新。

缓解AI信任危机

因此,要想让AI充分发挥其潜力,我们必须找到让人们信任它的方法,特别是当AI提出的建议与我们习惯采取的建议截然不同时。幸运的是,隧道的尽头总有光——我们已经有提高对AI信任的方法了。

▨体验:一种解决方案是在日常环境下为自动化应用程序和其他AI应用程序提供更多的实际操作体验(例如一个可以从冰箱为你拿啤酒的机器人)。这对于那些对这项技术没有很深入了解的公众来说尤其重要。

▨洞见:另一种解决方案或许就是打开机器学习算法的“黑匣子”,让其运作方式稍微变得透明些。Google、Airbnb和Twitter等公司已经开始定期发布透明度报告,对AI系统采取类似做法可以帮助人们更好地理解算法决策是如何做出的。

▨控制:最后,协作决策过程的建立将有助于信任的建立,并让AI能从人类经验中学习。宾夕法尼亚大学的一组研究人员最近发现,给予人们对算法的控制可以帮助人们增加对AI预测的信任。在他们的研究中,被赋予了稍微修改算法的权利的人会对AI感到更满意,更有可能相信它的卓越性,并且更有可能在未来使用它。

人们并不需要了解AI系统复杂的内部运作,但如果他们至少能得到一些如何执行的信息,并能对执行过程拥有一定的控制权,他们就会更乐于接受人工智能。

2000万欧元

5月25日,欧洲“史上最严”的数据保护条例——通用数据保护条例(GDPR)生效。对于违规收集个人信息的互联网公司,最高可罚款2000万欧元或全球营业额的4%(以较高者为准)。“GDPR正将必要的意识引入到生态系统中,并通过提醒公司在隐私领域承担多大的责任来引导它们。”牛津大学教授Sandra Wachter如此评论。

#原来,创业者爱玩德扑是有道理的#

扑克牌中蕴含的商业原理

▨耐心和纪律。玩牌时经常一坐数小时并一丝不苟坚持游戏规则,同样地,商业成功也没有捷径可走。

▨评估风险。能够识别机遇和投入资金是成功企业家的关键素质,无论是否拥有王牌,都不能害怕承担输牌的风险。

▨控制情绪。我们不会总赢——无论是扑克还是商业,不要让情绪化的回应把你踢出局。

#来自贝佐斯的建议#

CEO如何应对排山倒海的批评?

2017年,安德玛的股价大幅下跌45%。首席执行官凯文・普兰克受到了大量批评,导致他向重量级企业家求助。杰夫・贝佐斯给出的建议初听起来有悖直觉,但却绝妙:

▨这些批评是正确的吗?80%或90%的批评可能是不正确的,但如果有值得思考的地方,至少要以谦虚、耐心和成熟的心态去接受。

▨不为自己辩护。你知道你的公司经历了种种困难才走到今天,一两个人对小错揪住不放并不意味着你已有的成就不值一提。

▨筛选批评者。过于认真地看待每一条批评会陷入自我怀疑的困境,选择你愿意接受或考虑接受其意见的批评者及他们的有益批评。

-

机器人

+关注

关注

211文章

28772浏览量

209015 -

AI

+关注

关注

87文章

31948浏览量

270773 -

人工智能

+关注

关注

1797文章

47928浏览量

240994

原文标题:信AI还是信自己?这是一个问题|红杉汇内参

文章出处:【微信号:Sequoiacap,微信公众号:红杉汇】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

电动自行车如何玩转ADAS

嵌入式学习路线,大学四年规划:从大一小白到嵌入式大佬

AMD股价分析:AMD股价能否再次反弹至200美元?以下是你该知道的!

为什么有些TINA-TI仿真可以实现稳态求解法分析,而有些不行?

Al大模型机器人

【《软件开发珠玑》阅读体验】2 经验教训 好记性不如烂笔头

面试中的高频问题:指针函数与函数指针,你能完美应对吗?

AI人工智能机器人产业--政府真正应承担的责任与角色

电源滤波器:不可或缺的电磁干扰抑制器

【大规模语言模型:从理论到实践】+A【书籍开箱】

我们经常见到的电路板的“黑疙瘩”是啥?知不知道它是怎么做出来的?

PADS Layout的bug那么多,为什么还是有些人特别喜欢用?

为什么有些变频器使用刹车电阻,而有些变频器没有使用?

以及为什么有些人能接受AI,而有些人却深表怀疑?

以及为什么有些人能接受AI,而有些人却深表怀疑?

评论