人工智能也许已经破解了某些通常需要人类智慧的任务代码,但是为了学习,这些算法需要海量人类产生的数据。

算法根据数据中发现的模式来进行分类或者做出预测。但这些算法的聪明程度只能跟训练它的数据相比。这也就意味着我们的限制——我们的偏见,我们的盲点,我们的疏忽也会变成那些算法的。Danielle Groen详细解释了算法是如何产生偏见的,并且介绍了一些可能的解决方案。

算法的歧视

2010年秋天的一个早晨,Safiya Umoja Noble正坐在伊利诺斯州家中的餐桌上往Google里面输入了几个词。她正准备给自己14岁的继女以及5位侄女准备一次sleepover(在朋友家过夜的晚会)。既不想让孩子们碰手机,又担心女孩们会直奔她的笔记本,Noble决定自己先查查看她们会发现些什么。她说:“我原先想搜搜‘黑人女孩’,因为这是我喜欢一群黑人小女孩。”

但这次无伤大雅的搜索出来的东西令人警醒:结果网页整整一页都是明显色情的网页。当时任何人搜索黑人女孩都会得到一样的东西。Noble说:“几乎所有有色人种女孩的搜索结果都是超级色情的内容,哪怕退一步说这也非常的令人失望。”现在是南加州大学传播学教授的Noble说:“我只好把计算机也收起来,希望女孩子们不会提出要玩电脑的要求。”

大概与此同时,在另一个地方,Joy Buolamwini也发现了另一个表示问题。这位父母来自加纳、在加拿大出生的女计算机科学家意识到一些先进的热恋识别系统,比如微软使用的那些系统,在检测她的黑皮肤方面有很大的困难。有时候程序根本就不知道她的存在。当时是乔治亚理工学院一名学生的她正在做一个机器人项目,结果发现本该要跟人类用户玩躲猫猫的那个机器人没法把她给辨认出来。后来她只有靠室友的浅肤色的脸才完成了项目。

2011年,在香港的一家初创企业那里,她又用另一个机器人去试试自己的运气——结果还是一样。4年后,身为MIT硕士研究生的她发现最新的计算机软件仍然看不到她。不过当Buolamwini敷上一种万圣节用的白色面具时,技术识别就很顺利了。她靠化装才完成了自己的项目。

脸部识别和搜索引擎只是人工智能的两个应用而已。这是一个训练计算机执行通常只有人脑才能处理的任务的学科,牵涉到数学、逻辑、语言、视觉以及运动技能等。(就像色情一样,智能这东西很难定义,但是当你看到时你就会知道。)无人车可能还没那么快可以上路,但虚拟助手,比如Alexa等已经可以帮你在喜欢的咖啡厅预定中午会议了。语言处理的改进意味着你可以在手机用英语看一张翻译过的俄罗斯报纸。推荐系统极其擅长根据你的品味选择音乐或者建议Netflix系列片供你度过周末。

这些评估会影响我们的生活,但这并不是AI系统介入的唯一领域。在某些情况下,要紧的只是我们的时间:比方说,当你打电话给银行请求支持时,你在等待列表中的位置未必是顺序的,而是要取决于你作为客户对银行的价值如何。(如果银行认为你的投资组合更有前途的话,你的等待时间也许就只有3分钟而不是11分钟)但是AI也日益影响到我们的就业、我们对资源的使用以及我们的健康。

申请跟踪系统扫描简历,寻找关键字以便为招聘经理排出一个短名单。算法还在评估谁有资格拿到贷款,数倍追究欺诈责任。风险预测模型识别哪一位病人更有可能在45天内再次入院并且能从免费照顾与延续服务中受益最大。

AI还告诉当地警方和安全部门该去哪里。2017年3月,加拿大边境服务局宣布将在最繁忙的国际机场实现人脸识别软件;好几个地方的报摊现在开始用这套系统来确认护照身份,“提供自动化的旅行者风险评估”。自2014年开始卡尔加里警方已经运用人脸识别将视频监控与面部照片进行比对,去年秋天,多伦多警察服务局宣布将用部分拨款实现类似技术。

跟传统警方仅对已发生事件作出反应不同,预测性治安维护会依靠历史模式和统计建模在某种程度上预测哪一个街区的犯罪风险更高,然后引导巡逻车去到那些热点。美国的主要辖区已经推出了这一软件,去年夏天,温哥华成为加拿大推出类似举措的首座城市。

这些技术因其效能、成本效益、可伸缩性以及有望带来中立性而受到重视。AI初创企业Integrate.ai的产品副总裁Kathryn Hume说:“统计系统有一层客观性与权威性的光环。”人类决策有可能会混乱、不可预测,并且受到情绪或者午饭过去多少小时的影响,而“数据驱动算法却展现了一个不受主观性或者偏见影响的未来。但情况其实没那么简单。”

人工智能可能已经破解了通常需要人类智慧的某些任务的代码,但为了能学习,这些算法需要人类产生的大量数据。它们大量吸收各种信息,仔细搜查以便找出其中的共性和关联,然后基于检测出的模式提供分类或预测(是否癌症,是否会拖欠还款)。但是AI的聪明程度智能跟训练它们的数据一样,这就意味着我们的限制——我们的偏见、盲点以及疏忽,也会变成它们的。

今年早些时候,Buolamwini跟一位同事一起发表了对三项领先的脸部识别程序(分别由微软、IBM和Face++开发)进行测试的结果。测试要验证的是识别不同肤色种族性别的能力。超过99%的时间内,系统哦欧能都能正确识别出浅肤色的人。但是考虑到数据集严重向白人男性倾斜,这个成绩就不算什么了。

在另一个受到广泛使用的数据集里,那个用于训练识别的照片是一个78%为男性,84%为白人的照片集。当Buolamwini用黑人女性的照片测试这些程序时,算法的出错率接近34%。而且肤色越黑,程序的表现越差,错误率一直都在47%左右——这几乎跟抛硬币差不多了。系统看到一位黑人女性时并不能死别出来。

因为这些程序都是公开的,所以Buolamwini可以计算出这些结果,然后她可以用自己的1270张照片去测试他们。她的照片集由非洲政治家和办公室女性占比很高的北欧国家组成,为的是看看程序表现如何。这是一个评估某些情况下为什么技术会预测失败的难得机会。

但是透明性是例外,不是规则。商用应用(我们用来找工作、评信用和贷款等服务)使用的绝大部分AI系统都是专有的,其算法和训练数据是公众看不到的。所以个人要想质询机器的决定或者想了解用带人类偏见的历史例子训练出来的算法何时不利于自己是极其困难的。想证明AI系统违反了人权?研究伦理、法律及技术的加拿大首席研究员Ian Kerr说:“大多数算法都是黑箱。”因为公司会利用政府或商业机密法律来保守算法的模糊。但他补充道“即便组织提供完全透明,算法或AI本身也是不可解释或者不可理解的。”

最近出版了新书《压迫的算法》的Noble说,大家过去也主张过自身权利,反对歧视性的贷款行为。“现在我们又遇到了类似歧视性的决策,只不过它是由难以理解的算法做出的——而且你还没法呈堂证供。我们正日益陷入到那些系统的包围之中——它们做出决定,给我们打分,但其实他们也是人类的产品,只不过我们越来越看不清楚那背后的人。”

从专家系统到深度学习

如果你想造一台智能机器的话,从挖掘一位聪明人的知识开始不算坏主意。1980年代,开发者在AI方面就取得了一些早期突破,也就是所谓的专家系统,由有经验的诊断医生或者机械工程师帮助设计代码去解决特定问题。可以想想看恒温器是如何工作的:它可以按照一系列的规则将房子保持在恒定的温度或者当有人进入时排出暖气。听起来似乎很不错,但其实这只是规则和传感器的小花招罢了——如果[温度低于X]则[加热到Y]。恒温器既不识天象也也不知道你下班后的安排,它没法适配自己的行为。

机器学习则是人工智能的另一个分支,它通过分析模式而不是系统应用规则来教计算机执行任务。这通常是通过所谓的有监督学习实现的。这个过程还需要人类的参与:程序员必须整理数据,也就是输入,给它分配标签,也就是输出,这样一来系统就知道要找什么了。

比方说我们的计算机科学家想开发一套能够区分草莓和香蕉的水果沙拉对象识别系统。那么他就得选择特征——姑且定为颜色和形状——这跟水果是高度关联的,靠这两个机器就能识别水果。他给红色圆形的对象的图片打上草莓的标签,把黄色长条的图片打上香蕉的标签,然后他写了一些代码分配一个值来表征颜色,另一个来归纳形状。他把大量的草莓和香蕉图片喂给机器,后者从而建立起对这些特征关系的理解,从而可以对自己要找什么样的水果做出有根据的猜测。

一开始的时候系统表现不会太好;它需要通过一组有力的例子去学习。我们的监督者计算机科学家知道,这个特别的输入是草莓,所以如果程序选择了香蕉的输出,他会因为给出错误答案而惩罚计算机。根据这个新信息,系统会调整自己做出的特征之间的连接从而下次改进预测。由于一对输出并不是什么难事,很快机器就能够正确识别出自己从未见过的草莓和香蕉了。

贵湖大学机器学习研究小组负责人GrahamTaylor说:“一些东西很容易概念化并且编程实现。”但是你可能希望系统能够识别比水果更复杂的对象。也许你希望在海量的面孔中识别出一张脸。Taylor说:“于是就引出了深度学习。它扩展到非常庞大的数据集,迅速解决问题,并且不受定义规则的专家知识的限制。”

深度学习时机器学习的一个极其热门的分支,它的出现其实是受到了我们人脑机制的启发。简而言之,大脑是一个数十亿神经元用数万亿突触连接起来的集合,而那些连接的相对强度——比如红色与红色水果之间,以及红色水果与草莓之间的连接——都是通过逐渐的学习过程进行调整的。

深度学习系统依靠的是这种神经网络的电子模型。深度学习领域的先驱之一Yoshua Bengio说:“在你的大脑里,神经元会发送信息给其他神经元。”一对神经元之间的信号强弱叫做突触权重:当权重很大时,一个神经元就会对另一个神经元产生强大影响;而当它很小时,影响力也会很小。他说:“通过改变这些权重,不同神经元之间的连接强度也会改变。这就是AI研究人员想到的用来训练这些人工智能网络的点子。”

这就是AI能够从对草莓香蕉分类进展到识别面部的办法之一。一位计算机科学家提供标签化的数据——所有那些跟正确名字挂钩的脸部。但是他不是要求也是告诉机器照片中哪些特征对识别很重要,计算机就会完全靠自己来析取出那些信息。Taylor说:“在这里你的输入是面部的照片,然后输出就是关于这个人是谁的决定。”

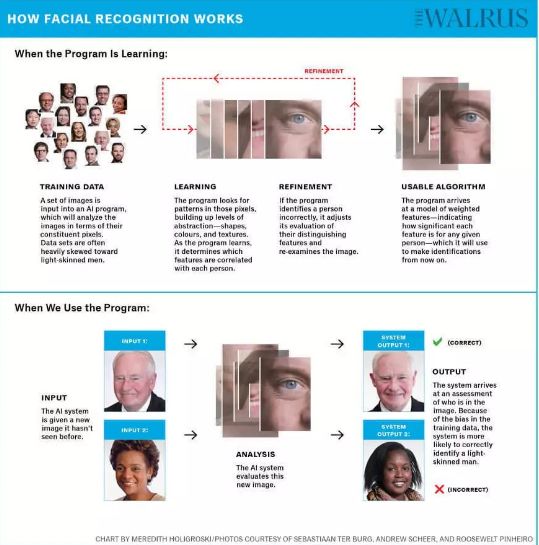

人脸识别的机制:1)机器学习时:训练数据——学习——调整——形成有用的算法;2)使用程序时:输入——分析——输出

为了从输入走到输出,图像要经过几次转换。他说:“图像首先要转换成非常低级的表征,只是枚举边的类型和位置。”接下来可能是那些边线的边角和交叉点,再就是形成形状的边线的模式。几个圆圈可能最后会成为一只眼睛。Taylor解释说:“在特征方面每一层的表示都是不同程度的抽象,这样一直到你得到非常高级的特征,那些开始看起来代表着身份的东西——比如发型和下巴轮廓——或者像面部匀称性这样的属性。”

这整个过程是怎么发生的呢?数字。数量多到令人难以置信的数字。比方说,一套人脸识别系统会按照像素级别来分析一张图像。(百万像素级摄像头使用1000x1000像素的网格,每一个像素都有红绿蓝三基色的值,每个值的范围在0到255之间,所以这里面的信息量有多大可想而知)系统通过这些表示层分析像素,构建抽象,直到最后自己做出识别。

不过请等一下,尽管这张脸很显然是Christopher Plummer,但机器却以为它是Margaret Trudeau。Taylor说:“模型一开始的时候表现非常糟糕。我们可以从给它看图片然后问谁在里面开始,但在经过训练或者完成任何学习之前,机器会一直给出错误的答案。”这是因为在算法见效之前,网络上人工神经元之间的权重是随机设定的。

经过一个逐步试错的过程之后,系统调整了不同层之间的连接的强度,所以当它看到另一幅Christopher Plummer的图片时,它表现得稍微好点了。小的调整稍微改善了一下连接,把错误率稍微降低了一点,直到最后系统可以用很高的准确率识别出脸部。正是因为这项技术,Facebook会在一张图片中有你时向你发出提醒,哪怕你还没有被打上标签。Taylor说:“深度学习很酷的一点是,我们不需要在有人说‘哦,这些特征对识别特定的脸很有用’的情况下析取出一切。这都是自动发生的,这就是它的神奇之处。”

带偏见的数据

这里有个小花招:往Google Images里面输入CEO你会变出一堆几乎难以分辨的白人男性面孔。如果你是在加拿大,你会看到剩下起到点缀作用的大部分都是白人女性,以及少数有色人种,还有神奇女侠的盖尔·加朵。去年在加州举行的一场机器学习会议上,一名演讲者必须在一堆穿着深色西装的白人男性中向下翻滚了很久之后才找到了第一位女侠。CEO芭比。

数据对于AI系统的运作必不可少。系统越复杂——神经网络的层数就越多,要想翻译语音或者识别面部或者计算某人拖欠贷款的可能性——需要收集的数据就越多。程序员可能要依靠图库或者危机百科条目、归档的新闻文章或者音频记录。他们可能会看大学招生的历史和假释记录。它们想要临床研究和信用评分。McGill计算机科学学院的Doina Precup教授说:“数据非常非常重要,(数据越多,)解决方案越好。”

但并不是每个人都能够公平地得到那些数据的表示。有时候,这是由来已久的排斥的结果:2017年,女性在财富500强中的占比仅为6.4%,但这已经比上一年的数字增长了52%。

直到1997年之前加拿大卫生部都没有明确要求女性纳入到临床试验里面;据中风基金会的《2018心脏报告》,2/3的心脏病临床研究仍然以男性为主,这帮助解释了为什么最近的一项研究发现超过一半女性并没有那些心脏病的症状。既然我们知道女性被排除在那些高层和试验之外,说她们的缺席会令任何用这些数据训练的系统的结果产生扭曲就是安全的假设了。

有时候,就算有充足的数据,那些建立训练集的人仍然不会采取审慎的举措去保证多样性,这导致了人脸识别程序在面对不同人群时会出现差异很大的错误率。其结果就是所谓的取样偏差,这是由于缺乏代表性数据导致的。算法优化是为了尽可能少犯错;其目标是降低错误数。但是数据的构成决定了算法将注意力引导到哪里去。

多伦多大学计算机科学教授Toniann Pitassi的研究重点是机器学习的公平性,他提供了一个招生计划的例子。Pitassi说:“比方说你有5%的黑人申请,如果这所大学95%的申请都是白人的话,则几乎你所有的数据都将是白人的。在决定谁应该进入大学这件事情上算法试图在整体上考虑将自己的错误最小化。但是它不会投入太多的努力到那5%上面,因为这对总体错误率的影响很小。”

犹他大学计算学院的Suresh Venkatasubramanian教授解释说:“很多算法是通过看在训练数据中自己得到了多少正确答案来进行训练的。这很好,但如果你只是把答案累计的话,就会有一部分小群体总是会有问题。这么做对你的伤害不太大,但是因为你系统性的对那一小群人的全体犯错,错误决定的影响就要比你的错误分散到多个群体的影响严重多了。”

正是因为这个原因,Buolamwini人肉干发现IBM的脸部识别技术准确率为87.9%。当一个系统识别浅肤色女性的准确率为92.9%,识别浅肤色男性的准确率为99.7%时,黑人女性的识别率仅为35%就无关紧要了。微软的算法也一样,她发现其预测性别的准确率为93.7%。但Buolamwini发现,那些性别错误中几乎有同样的比例——93.6%是发生在深肤色受试者的脸上。但是算法并不需要关心这个。

垃圾进,垃圾出

在跟人工智能专家花费了足够多的时间进行了足够深入的对话之后,到了一定时候,他们都会得出一条公理:垃圾进,垃圾出。绕开样本偏差确保系统基于丰富的均衡数据而进行训练是有可能的,但如果数据受到我们社会的偏见和歧视困扰的话,则算法也好不到哪里去。Precup说:“我们想要的是忠于现实的数据。”而当现实存在偏见时,“算法别无选择,只有反映那种偏见。算法就是这么做出来的。”

偶尔,所反映出来的偏见在预测性方面几乎是很滑稽的。Web搜索,聊天机器人,给图像加字幕程序,机器翻译等日益依赖于一种叫做词嵌入的技术。这是通过把单词之间的关系变成数值,然后让系统已数学的方式表示语言的社会背景。通过这项技术,AI系统了解到了巴黎和法国之间的关系,以及东京与日本之间的关系;它能觉察到东京与巴黎之间的不同联系。

2016年,波士顿大学和微软研究院的研究人员把来自于Google News文字的超过300万个英语单词提供给一个算法,他们先是提供一段使用得最多的话,然后让算法填空。他们问道:“男人之于计算机程序员正如女人之于什么?”机器在那堆单词里面折腾了半天之后给出的答案是家庭主妇。

这些统计关联就是所谓的隐含偏差:这就是为什么一所人工智能研究机构的图像收集将烹饪与女性招聘关联起来的可能性会增加68%的原因,这也解释了Google Translate在使用性别中立的代词的语言时为什么会遇到麻烦。

土耳其语的句子不会指明医生是男性还是女性,但是英语翻译会假定,如果屋子里有个医生的话,那他一定是个男的。这种推测延伸到了网上到处跟踪我们的广告身上。2015年,研究人员发现,在许诺薪水高于20万美元的Google工作岗位广告里面,男性出现的机率比女性高6倍。

Kathryn Hume说,系统的威力在于其“识别性别与职业之间的关联的能力。其不好之处在于系统背后是没有目的性的——只是由数学来选择关联。它并不知道这是个敏感问题。”这种技术存在着未来主义和陈旧作风的冲突。AI的演进速度要比它要处理的数据的演进快得多,所以这注定了它不仅折射和反映出过去的偏见,而且还延长并加强了它们。

因此,当判断被移交给机器之后,那些曾经是包括警察、法院在内的机构系统性歧视目标的群体并不能得到更好的对待。多伦多大学犯罪学和社会法学研究中心的Kelly Hannah-Moffat教授说:“那种认为可以制造出公平客观的AI工具的看法是有问题的,因为你会把犯罪发生的背景简化成是或否的二元性。

我们都知道种族跟盘查政策、梳理以及更严格的警方检查相关,所以如果你正在研究跟警察的接触或者之前的逮捕率时,其实你看的已经是一个带偏见的变量。”一旦那个变量被纳入到机器学习系统里面,偏见就被嵌入到算法评估之中。

两年前,美国调查新闻机构ProPublica仔细审查了一个使用广泛的程序,其名字叫做COMPAS,这个程序被用来确定被告再犯的风险。记着收集了超过7000名在佛罗里达州被捕的人的分数,然后评估其中有多少人在随后2年实施了犯罪——使用的是跟COMPAS一样的基准。他们发现,算法存在很大的缺陷:黑人被告被错误地标记为存在再犯的高风险的机率是实际的2倍多。相反,被标记为低风险的白人被告在随后被指控犯罪的情况是其估计的2倍。

美国已经有5个州靠COMPAS来进行刑事司法判决,其他辖区也已经有其他的风险评估程序就位。加拿大因为仍然沿用过时的体系,所以还没有受到有问题的算法之影响。

实现算法公平

要想实现算法的公平性,程序员可以简单地摒弃种族和性别这样的属性。但根深蒂固的历史关联——那种将女性与厨房关联,或者将一部分人口跟特定邮编关联的做法,使得系统很容易就能弄清楚这些属性,哪怕这些属性已经被移除了。所以计算机科学家弄出的这种解决方案令人想到管弦乐世界的盲听:为了掩饰某人的身份,他们竖起了一道幕布。

深度学习先驱Yoshua Bengio说:“假设我们考虑到种族是歧视的因素之一,如果我们在数据里面看到这个的话,我们就可以衡量它。”可以往神经网络里面添加另一个约束,强迫它忽视有关种族的信息,不管这种信息是不是隐含的(比如邮编)。Bengio说,这种方案无法对这些受保护的特征建立完全的不敏感性,但是还是做了相当好的工作。

其实现在已经有越来越多的研究在设法用算法性解决方案来解决算法性偏见问题。其中反设事实可能是手段之一——让算法分析如果女性获得贷款的话会发生什么,而不是简单地去梳理过去发生的事情。这可能意味着要给算法它增加约束,确保它在犯错时这些错误是均匀分布到每一种代表群体里面的。给算法增加不同的约束来降低阈值是有可能的,比方说对特定群体的大学录取率,从而保证达到代表性的百分比——姑且称之为算法性平权行动。

尽管如此,算法干预也只能到此为止;解决偏见还需要训练机器的程序员的多样性。McGill教授Doina Precup说:“这甚至还不是说意图不好,只是那些没有来自特定背景的人完全就没意识到那种背景会是什么样的,也不了解这会如何影响着一切。”如果数据集汇编进来的时候Joy Buolamwini在场的话,她当场就能发现那尖端的脸部识别技术在黑肤色的表现太过糟糕。

《压迫的算法》作者Safiya Noble补充说:“我们对种族主义和性别歧视的理解不够深入时可能会出现的风险远不止是公关混乱以及偶尔的新闻头条。这不仅意味着公司失去了更深入更多元化的消费者参与的可能性,而且有可能他们也没有意识到自己的产品和服务已经成为了会对社会造成破坏的权力体系的一部分。”

对算法性偏见认知的增强不仅是干预我们AI系统开发方式的一个机会。这也是一个质询的好机会,质询为什么我们创建的数据会像这样,质询还有哪些偏见在继续塑造一个允许这些模式在数据中出现的社会。毕竟,算法只是一组指令罢了。Bengio强调:“我们使用的算法是中立的。不中立的是(神经)网络,只要用带偏见的数据对它进行过训练之后,涡轮就不再中立了。我们充满着各种偏见。”

这正是为什么我们要非常非常当心自己收集的数据的原因。今年3月,微软领导的一群研究人员参加在旧金山举行的一场会议时提出了一个可能的解决方案。因为识别数据集创建方式缺乏标准,也没有警示可能存在偏见的警告标签,他们提出做一张包含有公共数据集和商用软件的数据表。文档将明确说明训练数据集是什么时候在哪里以及如何汇编出来的,并且提供使用的受试者的人口统计信息,提供必要的信息给研究人员和组织,从而确定如何利用数据集以及在和背景下加以使用。

在欧洲,已经出台了一部全新的隐私法律,General Data Protection Regulation(GDPR,通用数据保护条例)规定要限制对敏感数据的手机,要求对算法决策进行解释,并且保护个人不会被机器唯一来决定。

当然,还有一种优雅简洁且公平公正的解决方案:获得更好的数据。这就是Joy Buolamwin的发现指责IBM的人脸识别系统在性别和肤色平衡上做的不够之后发生的事情。这家公司目前正在提高用于训练的图片集的广泛性。后来拿瑞典、芬兰、南非、塞内加尔等过议员的照片去测试这套新系统时,算法执行得很好,这一点并不奇怪。可喜的是对所有人都是。

虽然不够完美:深肤色的女性错误率依然是最高的,3.46%。但这比之前已经改进了10倍——这已经远远足以证明改变是有可能的,只要你把它当作优先事项。哪怕是不彻底的智能机器都知道这一点。

-

人工智能

+关注

关注

1791文章

47208浏览量

238301 -

深度学习

+关注

关注

73文章

5500浏览量

121118

原文标题:本应公平公正的 AI,从数据中学会了人类的偏见

文章出处:【微信号:AItists,微信公众号:人工智能学家】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

人类智慧水平AI即将到来,AI芯片已提前布局

AI智能体逼真模拟人类行为

AI大模型的伦理与社会影响

AI for Science:人工智能驱动科学创新》第4章-AI与生命科学读后感

《AI for Science:人工智能驱动科学创新》第二章AI for Science的技术支撑学习心得

《AI for Science:人工智能驱动科学创新》第一章人工智能驱动的科学创新学习心得

平衡创新与伦理:AI时代的隐私保护和算法公平

智谋纪 AI+Multi LED 打开人类健康新宝藏

水库大坝安全监测系统的组成与功能

通过增强一致性训练,有效缓解CoT中的偏见问题

富士通发布最新的人工智能(AI)战略,聚焦深化人类与AI之间的协作

没有10年工作经验,我猜你都不会用电磁场来分析高速问题吧?

公平公正的AI也学会了人类的偏见

公平公正的AI也学会了人类的偏见

评论