生物学研究已经证明了,大多数动物的眼睛都是复数是有其道理的。其主要好处来自从两个点出发,生物可以更准确的对焦,从而理解空间、动态等视觉信息。

而这两年的手机似乎在说:我们支持仿生学,我们都有两只眼。

现在的手机厂商开始把双摄像头作为中高端产品的标配,其中包括作为行业领军者的苹果。而在今年,双摄像头似乎已经可以普及到中低端机型。随着相对保守的三星也加入双摄家族,两颗摄像头比一颗好似乎已经没有什么可争论的。

但总是要搞事情的谷歌似乎不满意这种认知。谷歌的Pixel 2依旧那么坚定,还是那孤零零的一颗摄像头,似乎在表达跟风绝不是我们“谷哥”的作风。

而更加让手机圈打脸的是,Pixel 2继承了一代的拍摄优势,在权威评测机构DxOMark的报告中拿到了98 分的综合得分,成为拍照能力最强的手机之一。

宣布全面进入AI first战略后,在手机拍摄领域谷歌也叠加了豪华的人工智能大礼包。似乎谷歌在传达这样一个理论:别人必须两颗摄像头解决的工作,我们可以用AI加一颗就搞定。

从硬件上看,Pixel 2的摄像头搭载了1/2.6 英寸1220万像素传感器,搭配F/1.8 大光圈镜头。只能说是行业中很普遍的硬件。所以其刷高评分的主要来自于算法方向的加持。我们来看看谷歌用了什么“黑科技”。

PDAF相位对焦技术通常被其它厂商用来加快对焦速度,但在谷歌Pixel 2中,该技术却被用来计算深度映射。

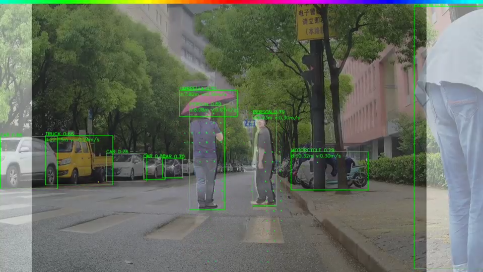

人眼之所以能感知景深,正是由于两眼之间有着差距。而谷歌Pixel 2只有一个镜头,但工程师却将图像传感器上的每个像素分割成两个较小的并排像素,这相当于将手机的后置镜头强行分为两半,那么相机左侧的视角和右侧的视角就会略有不同。这种角度差异甚至不足1mm,但却足以被芯片识别出来计算出立体程度,并生成深度映射。(如上图所示)

此外谷歌还在Pixel 2中集成了一颗专用图像处理协处理器——IPU。IPU可以用来加速HDR,减少HDR的处理时间。

所谓HDR,就是高动态范围摄影。手机不像专业单反那样有着高宽容度,如果遇到正中午大光比强反差的情况,既不可能通过后期手段来弥补,也不可能通过各种滤镜来辅助,便只能通过HDR的方式,以不同的曝光拍摄几张图片,然后通过算法合成出一张高光不过曝,暗部不死黑的图片。

除了硬件,谷歌还通过人工智能算法对前景背景进行区分,以强化背景虚化能力。

谷歌训练了一个用 TensorFlow 编写的神经网络,它负责检查照片,并估算哪些像素属于人,哪些不属于。谷歌用了几乎 100 万张人物照片(人物随身戴着帽子、太阳镜以及拿着冰淇淋蛋卷)进行训练。

有了这个神经网络的加持,谷歌可以很好的合成出拥有完美“景深”的人像照片。

以上这些黑科技被完美整合后,其拍照能力就提升到一个非常高的水平。

未启用人像模式(左)和启用人像模式(右)的 HDR+ 照片

能通过HDR做到暗光下也具备良好的成像水平,这足以说明后置黑白双摄可以被替代。能通过FDAF双像素自动对焦+AI算法做到自然的背景虚化,这足以说明后置景深双摄可以被替代。

诚然,目前还做不到通过算法来实现无损变焦,但随着手机内置传感器的日益增多,双摄也许真的不需要了。

-

摄像头

+关注

关注

60文章

4851浏览量

95908 -

HDR

+关注

关注

4文章

278浏览量

32046

原文标题:AI等黑科技加持,摄像头会回归单摄吗?

文章出处:【微信号:MEMSensor,微信公众号:MEMS】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

前10月舱内监控摄像头安装量达478.2万颗

用8颗DAC161S997或者两颗DAC8775做8路采集,单电源供电时,芯片共地是否可行?

ADS122C04IPWR,ADS1248IPW两颗IC同用SKSPS的采样率,他们的精度分别为多少?

HiSpark IPC AI摄像头(Hi3518E)串口能输入输出吗?

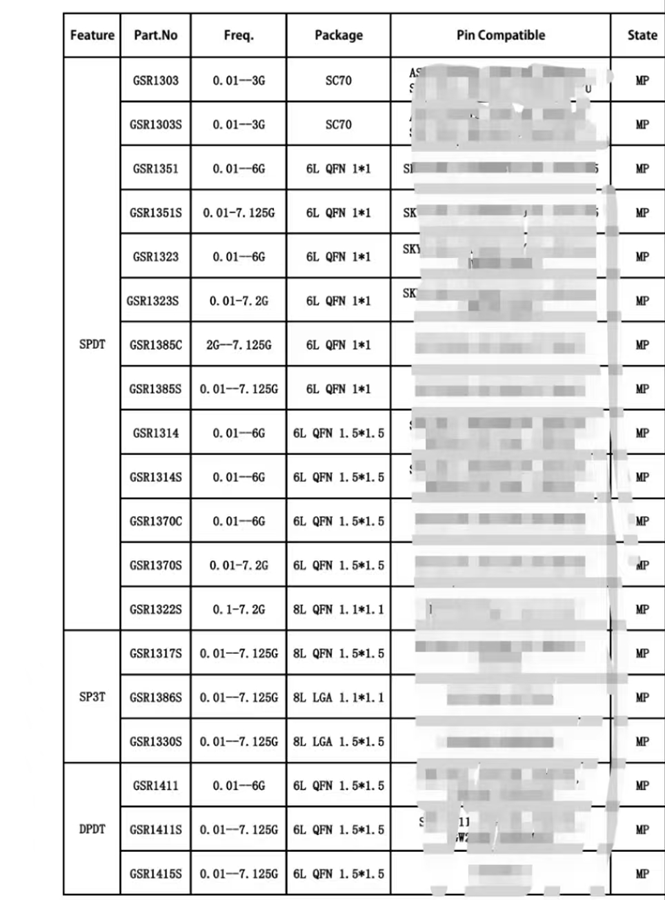

一颗射频开关的独白

两颗TAS5711,一颗作2.0输出,一颗作PBTL输出,共用一个I2S_DATA时发现失真增大,为什么?

OPA197如果使用多阶,用一颗跟随器提供基准电压是否可行?

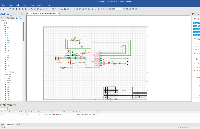

原理图设计里两颗重要的树(国产EDA)

智能摄像头抄表器是什么?

电梯物联网AI摄像头:物联网时代下的智能安全新篇章与技术发展|梯云物联

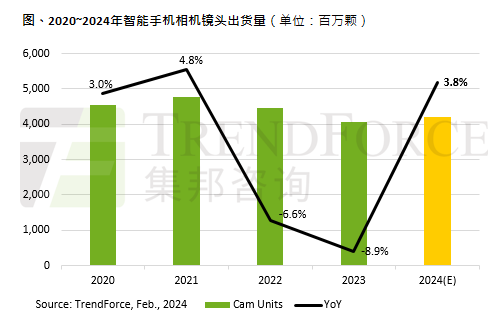

2024年全球智能手机摄像头出货量将增长3.8%

DK8718AD东科集成两颗氮化镓功率器件AC-DC功率开关电源

两颗摄像头解决的工作,能用AI加一颗就搞定吗?

两颗摄像头解决的工作,能用AI加一颗就搞定吗?

评论