机器学习正快速成为物联网(internet of things;IoT)装置的一项确定特色。家电现在开始支援语音驱动介面,能够智能地因应自然语言模式。现在,透过在智能型手机相机上向机器人示范流程,就能向机器人展示如何在工厂现场四处搬移材料,并为其他机器编程,同时智能型手机的功能也变得更聪明了。这些应用程序是利用至今最成功、能处理复杂、多面向数据的人工智能结构:深度学习网路(deep neural network;DNN)。

到目前为止,应用DNN科技作为嵌入式系统的议题向来是电脑效能的期望。尽管运算量比训练时少,但在输入数据变成受过训练之辨识与分析DNN的推论阶段期间,仍必须有每秒数十亿的运算流量数据,如语音及影片。因此,在许多情况下,会将处理转移至可提供大量动力的云端,但对于边缘装置还是没有理想的解决方案。

关键任务运用案例,如自动驾驶车辆与工业机器人,会利用DNN的即时辨识物体能力,并改善情境感知。不过,延迟、频宽与网路可用性的问题并不适合云端运算。在这些情境中,执行者承担不起云端无法即时反应的风险。

隐私则是另一个问题。尽管消费者很欣赏装置中如智能扬声器等语音协助的便利性,但他们也渐渐会担心当定期将对话内容录音档转移到云端时,自己的个资可能会不慎遭到公开。随着搭载相机镜头的智能扬声器,以及能启用视讯的机器人助理出现,这种担忧也跟着加剧。为了让顾客消除疑虑,制造商正在研究如何在最终装置中将更多DNN处理移动至边缘。主要的问题就在于DNN处理不适合传统嵌入式系统的结构。

传统嵌入式处理器不足以应付DNN处理

以CPU与GPU为主的传统嵌入式处理器,无法有效率地为低功率装置处理DNN工作量。IoT与行动装置对功率及面积有非常严格的限制,而必须有高性能才能进行即时的DNN处理。功率、效能与面积三者的组合就称为PPA,必须为了手上的任务进行最佳化。

解决这些问题的一个方法,就是为DNN处理提供可存取晶载暂存记忆体配置的硬体引擎。这个作法的问题在于,开发者必须具备高度灵活性,每个DNN执行的结构都需要依其目标应用做调整。专为语言辨识设计及训练的DNN,将会混合不同于影片专用之DNN的卷积、池化及全连结层。由于机器学习尚未成熟,还在持续发展,因此为了设计能因应未来的解决方案,灵活性就至关重要。

另一个常用方法是为标准处理单元增加一个向量处理单元(VPU)。这个作法能更有效率地计画,并能灵活操控不同类型的网路,但这样还是不够。读取来自外接DDR记忆体的数据是与DNN处理相关,极为耗电的工作。因此,数据效率及记忆体存取也必须经过详细检查,以作为完整的解决方案。为加强效率、可扩充性与灵活性,VPU只是AI处理器里其中一个必要的重要模组。

启用最佳化频宽与传输量

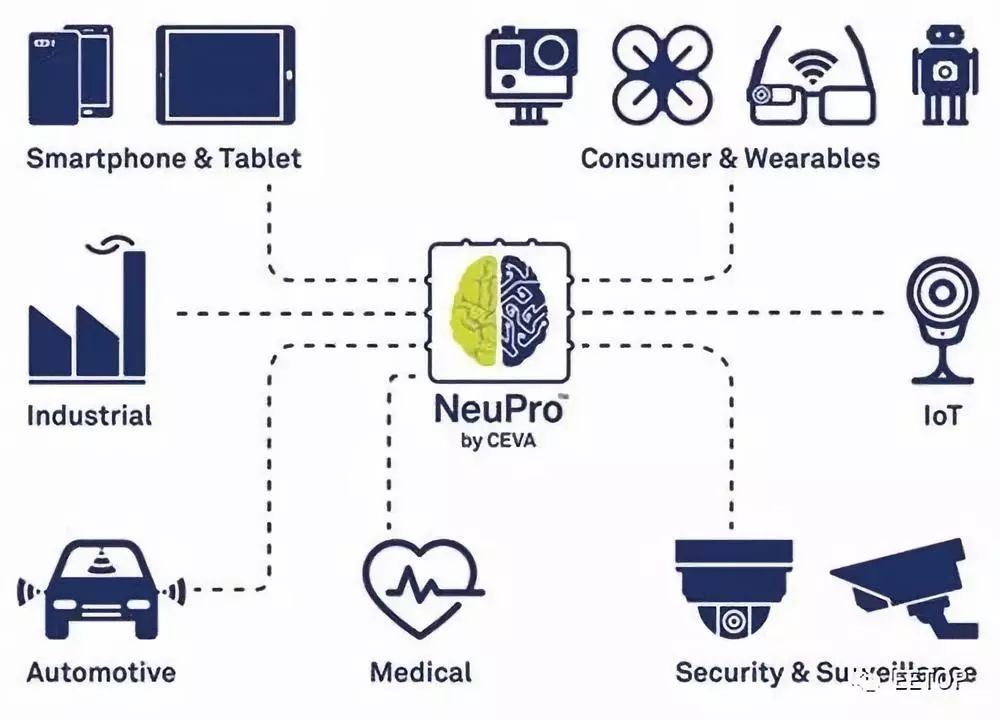

例如CEVA建立了一个结构,能同时满足DNN的效能挑战,以及保留处理最广泛多样内建式深度学习应用程序所必要的灵活性。NeuPro AI处理器包含了一个专业、最佳化的深度神经网路推论硬体引擎,以处理卷积、全连结、活化与池化层,另外还利用了高效、可编程的VPU进行未支援的其他层与推论软体执行。这个结构搭配了CEVA深度神经网路(CDNN)软体架构,能启动最佳化绘图编译,并能在运行时执行。

NeuPro的可扩充与灵活结构适合各种不同的AI应用程序

透过支援8位元与16位元算术,就能达到进一步的性能最佳化。对于一些运算来说,必须有精确的16位元计算,而在其他情况下,使用8位元计算就能取得几乎相同的运算结果,如此就能明显减少工作量,进而减少功率的消耗。NeuPro引擎能让这些混合操作达到平衡,因而让各层都达到最理想的执行。

依不同层选择8位元或16位元计算,就能提供最理想的精确性与效能

结合最佳化后的硬体模组、VPU,以及有效率的记忆系统,就能提供可扩充、灵活且极具效率的解决方案。除此之外,CDNN也能利用按键网路转换与现成的程序库模组,将开发变得简化。最后的成果就是一个功能完整,并让物联网装置设计师有能力在下一代产品中充份运用本地化机器学习的AI处理器。

-

物联网

+关注

关注

2914文章

45022浏览量

378074 -

机器学习

+关注

关注

66文章

8455浏览量

133186 -

dnn

+关注

关注

0文章

60浏览量

9102

原文标题:将深度学习引进IoT边缘装置

文章出处:【微信号:eetop-1,微信公众号:EETOP】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

边缘计算:连接智能世界的变革之力

AI赋能边缘网关:开启智能时代的新蓝海

晶片边缘蚀刻机及其蚀刻方法

物联网优势和物联网边缘

硬件帮助将AI移动到边缘

【HarmonyOS HiSpark Wi-Fi IoT HarmonyOS 智能家居套件试用 】基于鸿蒙OS系统的边缘计算

毫米波传感器实现边缘智能的方法

中国移动边缘计算的实践进展介绍

借助AI,边缘计算正在向智能边缘过渡

什么是边缘人工智能_边缘人工智能应用

移动边缘计算中延迟和能量约束任务卸载的最优拍卖

移动边缘计算MEC学习笔记

移动边缘计算概述

智能向边缘装置移动

智能向边缘装置移动

评论