裁员!最近,人工智能健康领域的老大哥 IBM沃森健康(Watson Health)传来了裁员达70%的消息,备受业内关注,甚至有金融分析师称这个部门是烧钱的无底洞。

那么,在AI热潮之下,你该如何构建一个更理性更纯粹的思考框架?这一次,邢波教授可谓将AI的边界问题讲透了。

✦我们去人为的制造一个谎言,最后这个谎言被戳穿以后,反而是那些诚实工作的人,去承担惩罚。这对研发人员很不公正。

——邢波

邢波,师从机器学习泰斗级学术大咖Michael Jordan,卡耐基梅隆大学机器学习和医疗中心主任,同时,他还是生物化学与计算机科学的双料博士,创立了通用机器学习平台Petuum,并获得了软银投资。

挑战Facebook的1亿用户

一次不“体面”的经历

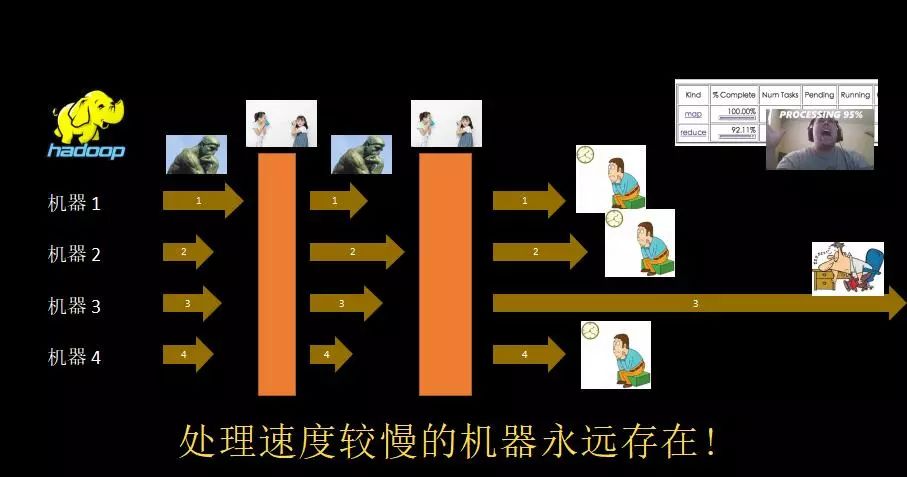

现在的人工智能,正在面临一个非常非常实际的工程问题——规模瓶颈:

你的算法可以在实验室的单机上实现,可到了现实环境中,就可能不行。

我讲下在Facebook的经历。

大概2011年左右,我们做了一个比较成功的社交建模——

依靠拥有100万人的好莱坞影星数据库,可以实现对人进行分类和精准推荐。

但当我把这个模型部署在Facebook里1亿规模的用户上时,结果相当让人失望:

原则上,6分钟能算完100万个,如果有1000台机器,那么,0.6分钟就可以算完,但结果呢?

不要说0.6分钟了,1星期都没有算完,中间就卡了。

>>>>

算法也没有错,建模也没有错,机器也有,但为什么还是卡了?

指挥1000人的部队和指挥一个人是不一样的,当你把算法放在1000台机器上时,涉及到一个机器之间通讯的问题。

比如,机器学习需要不断递归迭代,每次迭代需要握一次手,告诉我,迭代完了,或者还没迭代完,你得等一下,等一次就是一个门槛。当你有好几台机器迭代的时候,他们的速度是不一样的,每一次,你都要等到最后一个机器完成以后,才能往前走。

所以,这就涉及一个非常关键的问题:

机器学习作为算法理论工具,作为模型,跟它的计算设备,有着重要关联,新的AI程序需要新的AI引擎,就像新的飞机设计必须有新的引擎来助推。

作为一个成熟的人工智能学者,不仅仅是要成为一个算法专家或者建模专家,你不能把活扔给程序员,让他们实现,而是要对任务和工作环境,有更深刻的理解。

举个例子,人工智能在工程实现上,目的性非常强,而操作方式,实际上是次要要素。

比如,你要飞行表演,队形完整即可,不必飞的太快,即可以损失效率;但如果飞机是去救火,飞行姿态其实不必特别精准同步,以换回效率。

掘金AI

AI架构者必须要思考9个关键问题

>>>>

如何把握AI的未来机遇?

先说个故事,美国早期,很多人去加州淘金,但实际上靠淘金致富的真不多,最后真正的巨富,我记住的是这样两个人:

造牛仔裤的李维·斯特劳斯,当时,他给一些工人制作装备和衣服;

造工具铁锹的萨姆·布瑞南,因为每个挖金人的都需要铁锹。

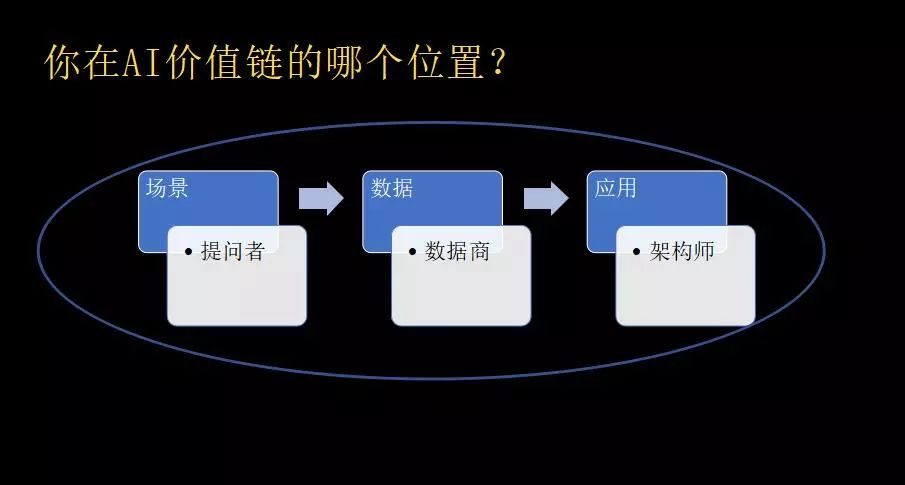

同理,AI 也有很多落地场景:你可以从数据里生成产品或是生成服务,也可以为AI的研发者或者使用者,提供他们所需要的工具。

所以,你可以好好思考一下,你的机会是在AI价值链的哪一端呢?

现今,科技公司的人工智能解决方案面临的最大瓶颈是:无法像商品一样,以可控的成本,进行大量的创造和复制。

所以,要实现靠谱的,有用的,可用的AI,必须要跨越手工坊制作,采用标准化的工业量产模式。就好比造车,先把零件弄好,然后产生一个供应链,最后做一个组装。

我们希望通过这样的尝试,把人工智能从独门秘笈、黑科技,往工程的方向做一个推动:

使它对于语言的依赖、设备的依赖和对于界面依赖弱化,让不同的人,像我们使用电或者使用微软的文字工具一样,各取所需,而不是说非要雇一个Chief AI Officer,或者雇一大堆博士,做手工作坊式的研发。

>>>>

总之,一个成熟的AI架构者要学会思考以下9个关键问题:

①建立一个完整的,工程上可信的解决方案,而不是一个玩具或是Demo;

而且,这个体系可插入可拔出,是一个插件式的平台,就像你做一个汽车生产线一样,产品升级,更换零件或者更换局部就可以,不必拆掉整个产品线重来。

②可复制性;

别人也可以用,而且也可以做出来。

③经济可行性;

④适用于各种用户的特殊状况;

举个例子,比如波音公司生产飞机,要为每一个用户造一家不同的飞机吗?不用,提供基本的飞机引擎、机身、操作软件等就可以。

换句话说,用户的个性需求和生产商提供的解决方案,两边应该在中间相遇,而不是在某一端相遇,这是现在人工智能还比较缺少的设计思路。

⑤结果可重现;

⑥理解解决方案是如何建构起来的;

⑦可解释性,尤其是出现意外结果时知道哪儿出了问题;

⑧能交流结果,让大家也能重现你宣称的结果;

⑨清楚什么能够做到,什么不行。

举个例子,我可以告诉你,我在5年之内不准备坐自动驾驶车,或者我强烈要求自动驾驶车有方向盘,我自己得握着,为什么呢?

因为作为一个研发者,我很清楚,现在很多算法包括深度学习算法里的因果性,还没有搞清楚。

人工智能会超越人类吗?

要警惕对学科的伤害

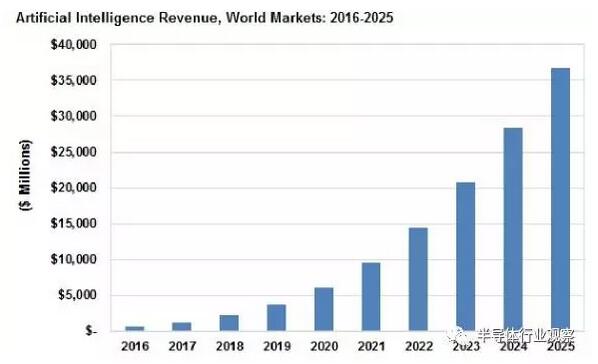

很多人认为,人工智能的发展,会像摩尔定律一样,实现指数型爆炸,但现实是,摩尔定律有坚实的数据基础,人工智能没有。

人工智能的发展是有边界的,并且最终会收敛,而且,它收敛的地方并不是在人类智能,甚至还可能会出现倒退。

比如最近,一向热衷激进部署机器人工厂的埃隆·马斯克,在Facebook上承认,工厂自动化了以后,效率没有提高,反而下降了。

>>>>

那么,人工智能不能做什么呢?有以下3个方面:

①机器无法提出问题;

人是很善于挑战未知,去提出问题的,但对于机器来说,提出一个未知问题(不是根据书本的内容知识,来提测验问题),发现一个新的物理定理和数学定理,这一点非常非常难,我不相信在可预见的将来,有任何的算法或者模型能够做到这一点。

②机器也无法知道未知的问题;

有一种说法,对人的修养和学识的衡量标准之一是,你是否知道未知,这一点,机器也不知道。

因为机器对边界没有感觉,它并不知道在它的知识范围之外,还有什么东西它不知道,这是不能被设置的功能。

③机器难以从小数据学习,依然需要人工架构和调教。

人的学习都是通过小数据来开始学,依靠环境、先验知识和逻辑思维的综合方法,从不同的数据里面来获得知识,然后他们还能综合、成长。

这也是人工智能相当弱的地方,而且即便可以实现,到了工程层面,其性能也是相当不稳定。

它需要有非常非常激进的调参,非常非常神秘的独门暗器,各种各样的秘诀敲门,这都妨碍了人工智能的商业化、规模化。

>>>>

另外一个问题,人工智能会超越人类吗?

实际上,人工智能和人类智能是两条不一样的路。

成功的人工智能体现的是机械或者工程美学,而人类智能是自然的美学,或者是一种生物、哲学上的美。

所以,我的观点是:

①在有限规则的特定任务下,机器超越人类的水平只是时间问题。

比如算数学题、下围棋、打扑克,规则一清楚了以后,结果就确定了,不必吃惊。

②在非结构化的场景下,即使简单的情感识别问题,机器仍然没有突破人类。

比如,这位女生到底是高兴了还是难过了?这样的程序其实是写不出来的。

总之,在可预期的将来,人机协作才是真正的方向,人类不应该害怕人工智能或者机器学习,而真正应该担忧的是什么呢?

人别到时候跟机器一样,变得冷酷或者完全没有人性,这是值得关注的。

小结

最后,我想为人工智能的从业者,那些沉默的大多数,不太在网上出声,也不太会获得相应运作利益的那些人,说几句话:

由于资本的驱动、人性的弱点,或者由于其他的一些因素,我们看到了人工智能被追捧,但由于并没有跟现实来匹配,结果就产生了一个预期和现实的落差,最后的受害者是谁呢?

对学科的伤害。我是相当痛心的。

因为在前两个人工智能的低谷期,其实有大量的天才和非常非常诚实、踏实的研究者,由于这样的误解,得不到经费、支持、和理解,他们最后不得不离开这个行业。

这样的现象正在发生。

我们去人为的制造一个谎言,最后这个谎言被戳穿以后,反而是那些诚实工作的人,去承担惩罚。这对研发人员很不公正。

所以,希望大家对待人工智能,能够更理性更纯粹一些。

-

AI

+关注

关注

87文章

30665浏览量

268827 -

人工智能

+关注

关注

1791文章

47146浏览量

238118 -

机器学习

+关注

关注

66文章

8401浏览量

132535

原文标题:AI热潮之下,这些“谎言”,让人痛心

文章出处:【微信号:rgznai100,微信公众号:rgznai100】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

『深思考』打造人工智能机器大脑,让AI更懂你!

《AI概论:来来来,成为AI的良师益友》高焕堂老师带你学AI

ArkUI框架,更懂程序员的UI信息语法

深度学习发展的5个主力框架

在AI热潮之下,你该如何构建一个更理性更纯粹的思考框架?

在AI热潮之下,你该如何构建一个更理性更纯粹的思考框架?

评论