在本周于法兰克福召开的国际超算大会上,NVIDIA推出9个新的HPC和可视化容器。至此,用户可在NGC上使用35个深度学习、高性能计算和可视化容器。NVIDIA GPU Cloud(NGC)自去年推出以来,提供的容器数量已增加了两倍多。

NVIDIA一直努力推动部署GPU加速的高性能计算和人工智能。在过去三年中,尤其是对于从事AI工作的研究人员和数据科学家而言,容器已成为在共享集群上部署应用并加速其工作的关键工具。

深度学习框架也是深度神经网络设计、训练和验证的构建模块,这些容器使深度学习框架的部署能够更快更轻松。框架的设置是一个非常复杂又耗时的过程,容器简化了这一流程,因此用户可通过简单的拖动和运行指令就能访问最新版的应用程序。

复杂的部署挑战也存在于HPC计算和可视化应用中。

进展迅速:全新NGC容器包括CHROMA、CANDLE、PGI和VMD

在去年超算大会推出的包括NAMD、GROMACS和ParaView在内的八个容器基础上,NGC新增了9个HPC和可视化容器,包括CHROMA、CANDLE、PGI和VMD。

NGC上提供的PGI编译器容器将助力开发者构建面向多核CPU和NVIDIA Tesla GPU的HPC应用。有了PGI编译器和工具,就能通过OpenACC、OpenMP和CUDA Fortran并行编程,开发具有性能可移植性的HPC应用。

NGC容器对于用户的价值显而易见,现已有超过27000名用户注册访问NGC容器注册。

容器必然会让HPC应用的部署变得更加轻松且快速。

容器加速发现过程

对容器的需求不仅局限于深度学习。超级计算也亟需简化所有细分市场的应用部署,这是因为几乎所有的超算中心都采用环境模块来构建、部署和启动应用。

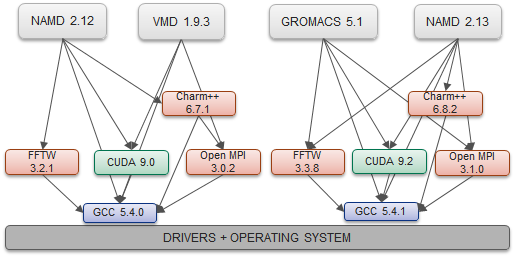

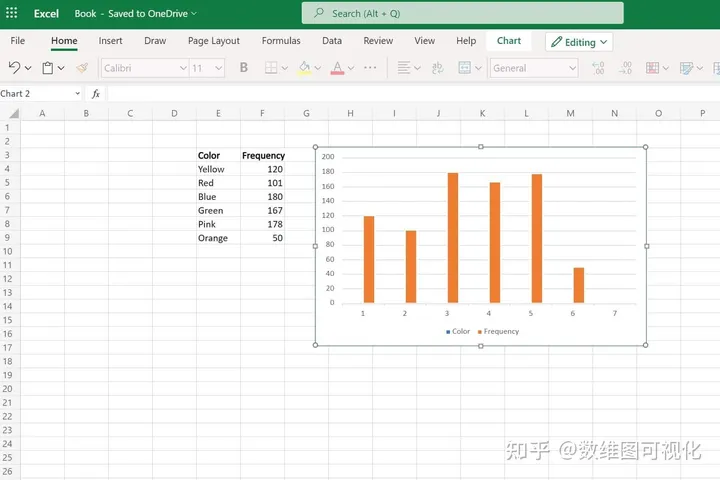

如果没有容器,应用的更新就会相当复杂,如上图所示。

这种方法可能需要几天的时间,所以非常耗时且生产效率低下。这对系统管理员和最终用户来说都是一种非常低效的方式。

在超算领域中,这种安装的复杂性就限制了用户访问最新功能并享受优化的性能,继而延迟发现进程。

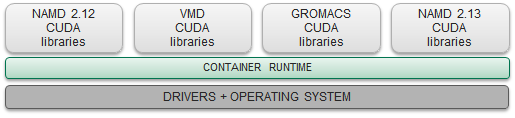

容器简化共享系统上的应用部署

容器是一个很好的选择。无需安装意味着无需跟踪或担心打破环境模块链路。

用户只需拖动并运行容器即可部署应用

用户可自行提取容器,并在几分钟内完成应用部署,而无需因为走审批流程而等待好几天。

系统管理员现可专注于任务关键型的工作任务,而非服务和维护应用。

容器的其他主要优点还包括提供了可重复性和可移植性。用户可在不安装应用的情况下,在各种系统上运行工作负载并获得等效的模拟结果。这对验证研究论文的结果尤其有帮助。

NGC提高生产力并加速发现进程

NGC容器内的应用是GPU加速的,比CPU系统具有更好的性能。

用户可访问最新版本的HPC应用,且NVIDIA每月都会在整个软件堆栈范围内对深度学习框架容器进行更新和优化,以提供基于NVIDIA GPU的最佳性能。

最后,这些容器还将在支持的云服务提供商(包括AWS、谷歌云平台和Oracle云基础设施)的各种系统上(包括基于GPU的工作站、NVIDIA DGX System和NVIDIA GPU)进行测试,以实现流畅的用户体验。

-

NVIDIA

+关注

关注

14文章

4970浏览量

102957 -

容器

+关注

关注

0文章

495浏览量

22060 -

深度学习

+关注

关注

73文章

5497浏览量

121092

原文标题:ISC18 | NVIDIA推出九款全新高性能计算容器

文章出处:【微信号:NVIDIA-Enterprise,微信公众号:NVIDIA英伟达企业解决方案】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

什么是大屏数据可视化?特点有哪些?

如何找到适合的大屏数据可视化系统

智慧能源可视化监管平台——助力可视化能源数据管理

智慧楼宇可视化的优点

大屏数据可视化 开源

如何实现园区大屏可视化?

态势数据可视化技术有哪些

智慧大屏是如何实现数据可视化的?

大屏数据可视化的作用和意义

数据可视化:企业数字化建设效果的呈现

态势数据可视化技术有哪些

NVIDIA和西门子为工业设计和制造带来沉浸式可视化和生成式AI

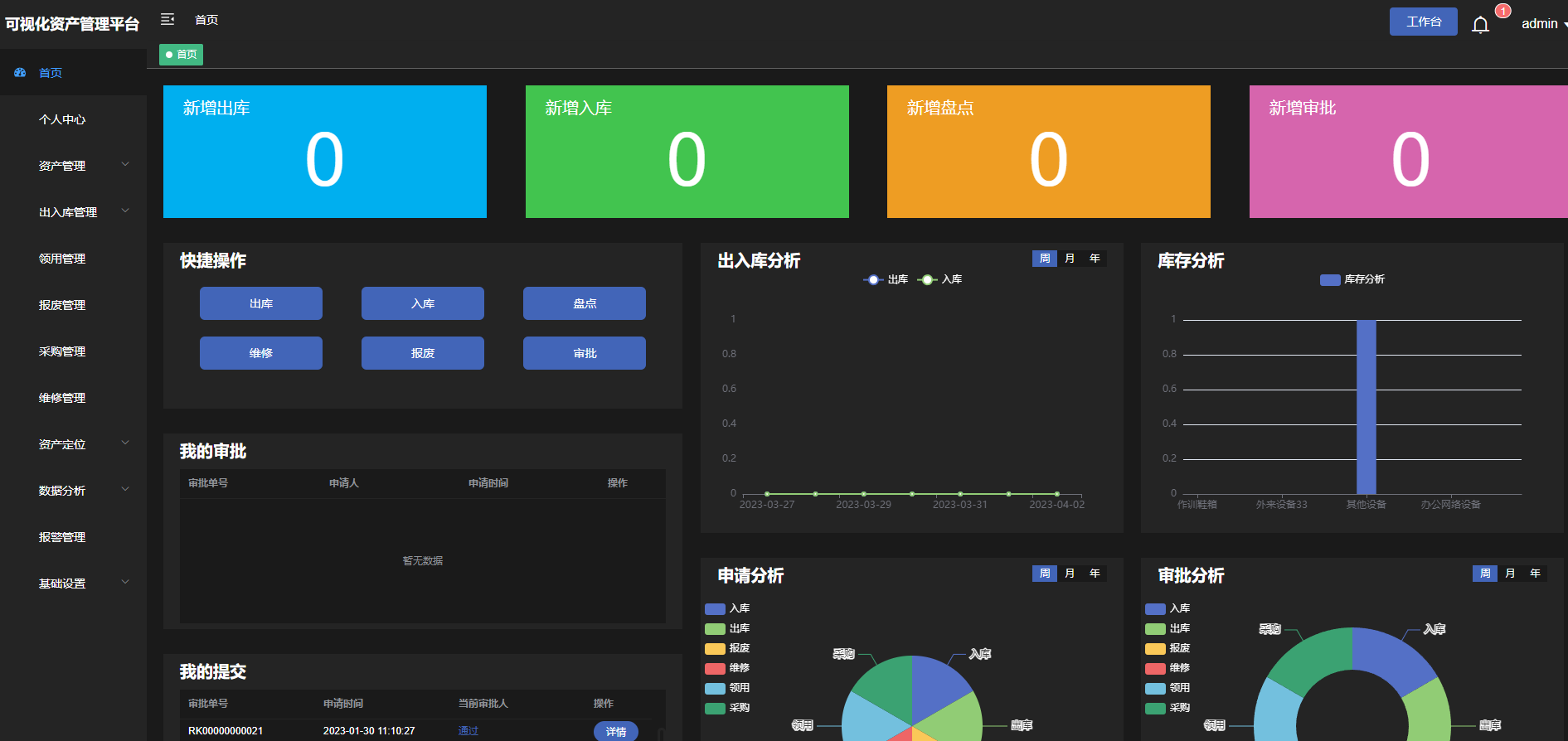

可视化全程追溯,可视化资产管理系统

一键生成可视化图表/大屏 这13款数据可视化工具很强大

NVIDIA推出9个新的HPC和可视化容器

NVIDIA推出9个新的HPC和可视化容器

评论