利用深度学习“换脸”合成假视频的技术发展之快令人惊叹,也令人深感不安。但是,道高一尺魔高一丈,研究人员已经研究出一种新方法来检测这些被操纵的换脸视频的“迹象”:这是普通人都会注意到的一个缺陷:缺少眨眼。

纽约州立大学奥尔巴尼分校计算机科学系的研究人员最近发表了一篇题为“In Ictu Oculi:通过检测眨眼来揭露AI产生的换脸假视频”。论文详细介绍了他们如何组合两个神经网络,从而更有效地揭露哪些视频是AI合成的。这些视频往往忽略了“自发的、无意识的生理活动,例如呼吸、脉搏和眼球运动”。

研究人员指出,人类静止时的眨眼频率平均为每分钟17次;当一个人说话时,眨眼频率增加到每分钟26次,阅读时则减少到每分钟4.5次。研究人员补充说,这些区别值得注意,“因为视频上正在说话的发言者,被拍摄时可能实际上正在阅读。”因此,当视频中某个正在说话的人完全不眨眼,很容易就能看出这段录像是假的。

深度学习技术产生的假视频(deepfake videos)中的主体不会眨眼,原因之一是:大多数提供给神经网络的训练数据集不包含闭眼的照片,因为人们在网上公开的照片通常都是睁眼的。这是必然的结果,因为创造deepfake视频需要手机大量的个人照片,而这个过程可以通过开源的照片抓取工具从网络上获取公开照片。

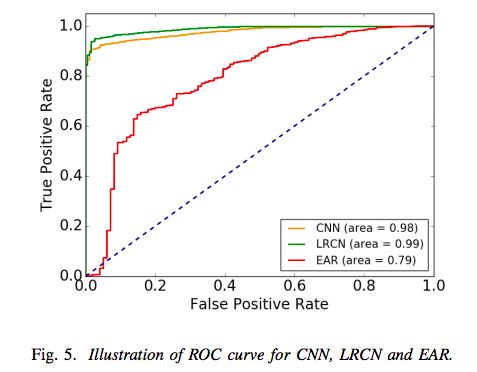

之前的论文已经指出,缺乏眨眼是检测deepfakes的一种方法,但奥尔巴尼大学的研究人员表示,他们的系统比之前提出的检测方法更准确。之前的研究使用眼睛长宽比(EAR)或卷积神经网络(CNN)分类器来检测眼睛是睁开着还是闭着。新的研究里,研究人员将基于CNN的方法与递归神经网络(RNN)结合起来,这种方法除了考虑单个视频帧之外,还考虑以前的眼睛的状态。

LRCN方法的概览

与单纯的CNN模型不同,研究人员表示,他们的长期递归卷积网络( Long-term Recurrent Convolutional Network ,LRCN)方法可以“有效地预测眼睛状态,从而可以更加准确。”根据论文,这种方法的准确率为0.99,相比之下,CNN的准确率为0.98,而EAR的准确率为0.79。

LRCN和CNN、EAR方法的结果比较

至少,研究人员的发现表明,我们有办法揭露机器学习技术创造出来的非常逼真假视频。例如,一个叫做Deep Video Portraits的新系统能给视频中的人物“换脸”,甚至可以再现脸部的动作、面部表情、说话口型和实现方向。

Deep Video Portraits

令人欣慰的是,研究人员正在寻找识别假视频的方法,特别是因为这项技术可能被滥用,以及可能促进假新闻的传播。但这些检测方法是否会超过deepfake技术的发展速度,还有待观察。

“在我个人看来,最重要的是,公众必须意识到现代技术在视频生成和编辑方面的有很大的能力,”斯坦福大学访问助理教授Michael Zollhofer在一篇博客文章中写道:“这将使他们更批判性地思考自己每天消费的视频内容,尤其是在视频内容没有来源证明的情况下。”

-

神经网络

+关注

关注

42文章

4769浏览量

100687 -

机器学习

+关注

关注

66文章

8401浏览量

132535 -

深度学习

+关注

关注

73文章

5497浏览量

121094

原文标题:反“换脸”魔高一丈:新方法识别假视频正确率达99%

文章出处:【微信号:AI_era,微信公众号:新智元】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

一种求解非线性约束优化全局最优的新方法

目前微通道面临的限制,突破硅技术的一种新方法

一种精确测量储能成本的新方法:LCUS

一种复制和粘贴URL的新方法

一种产生激光脉冲新方法

一种无透镜成像的新方法

一种新方法来检测这些被操纵的换脸视频的“迹象”

一种新方法来检测这些被操纵的换脸视频的“迹象”

评论