ICML ( International Conference on Machine Learning),国际机器学习大会如今已发展为由国际机器学习学会(IMLS)主办的年度机器学习国际顶级会议。今天,第35届 ICML 大会在瑞典的斯德哥尔摩正式召开,与大家一同分享这一领域在这一年里的突破。ICML 2018 共有 2473 篇论文投稿,共有 621 篇论文杀出重围入选获奖名单,接受率接近25%。其中 Google 强势领跑,Deep Mind 、FaceBook和微软也是精彩纷呈;而在高校中 UC Berkeley 和 Stanford 、CMU 以近 30 篇荣登 Top 榜。

而今年不得不说咱们国内的成绩,虽然清华被收录了 12 篇,相比之下还是有差距,不过相比往年的数量和今年如此激烈的竞争下,进步是不可忽视的,尤其是今年复旦大学的一篇论文与 DeepMind、斯坦福大学的两篇论文一同获得 Runner Up 奖,腾讯 AI Lab 也是有超十篇论文被收录,都让我们对国内研究抱有更多的期待,也相信国内的研究所与高校在人工智能领域的基础性研究方面会取得更骄人的成绩。

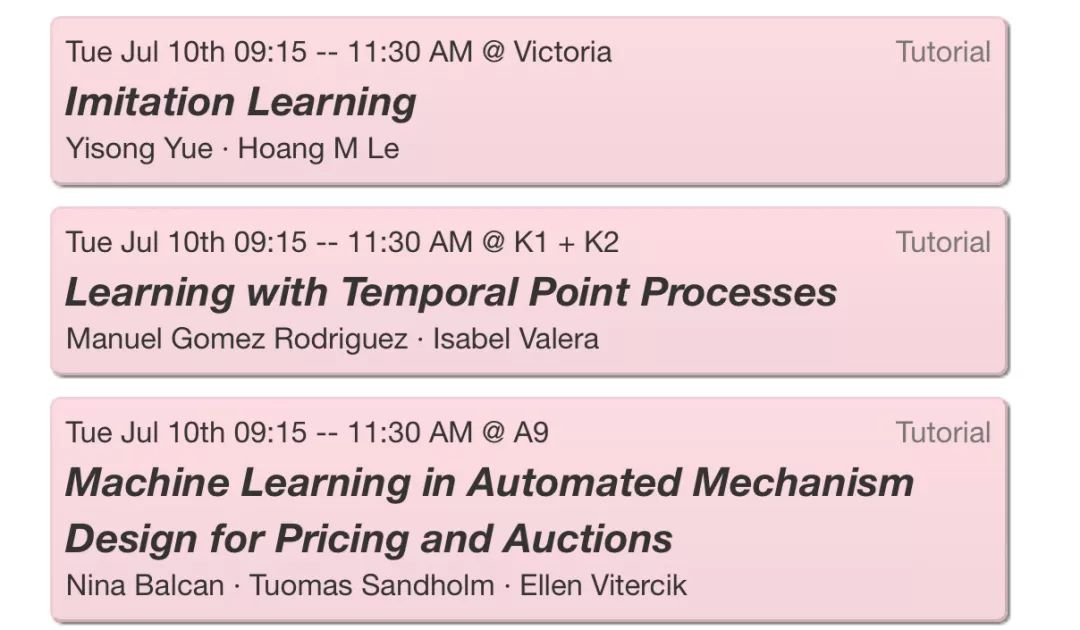

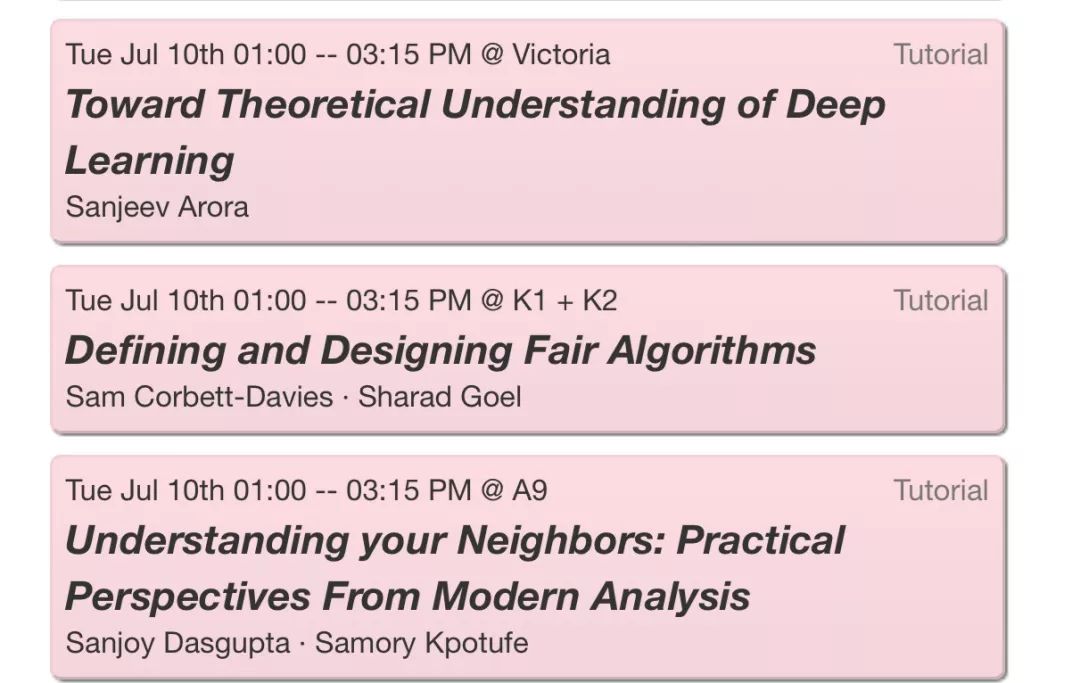

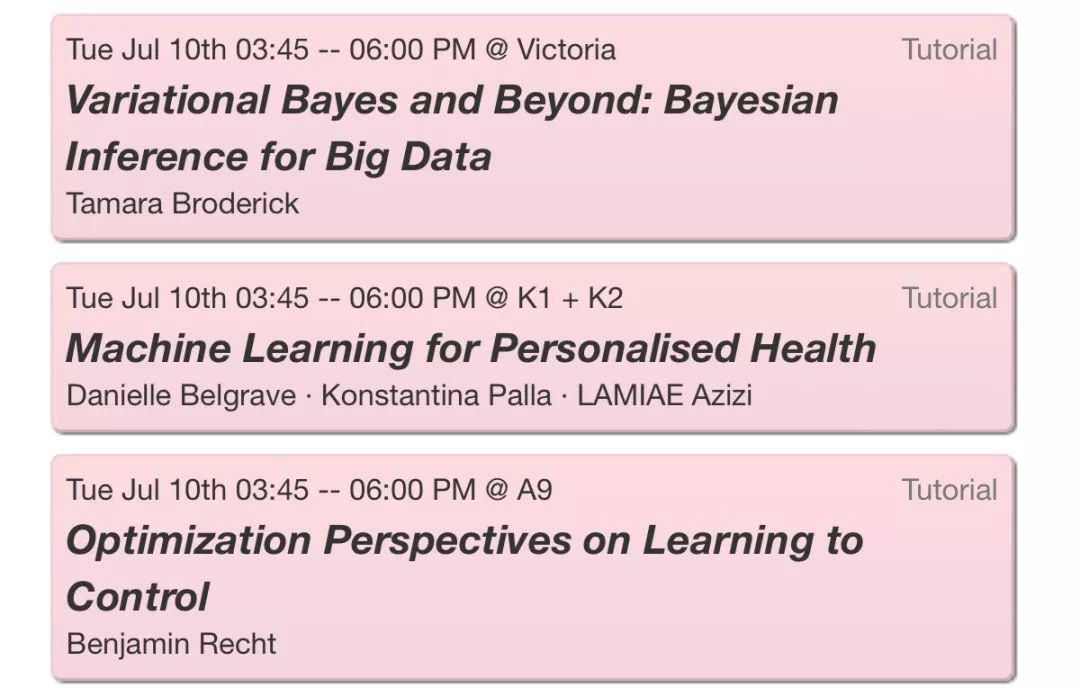

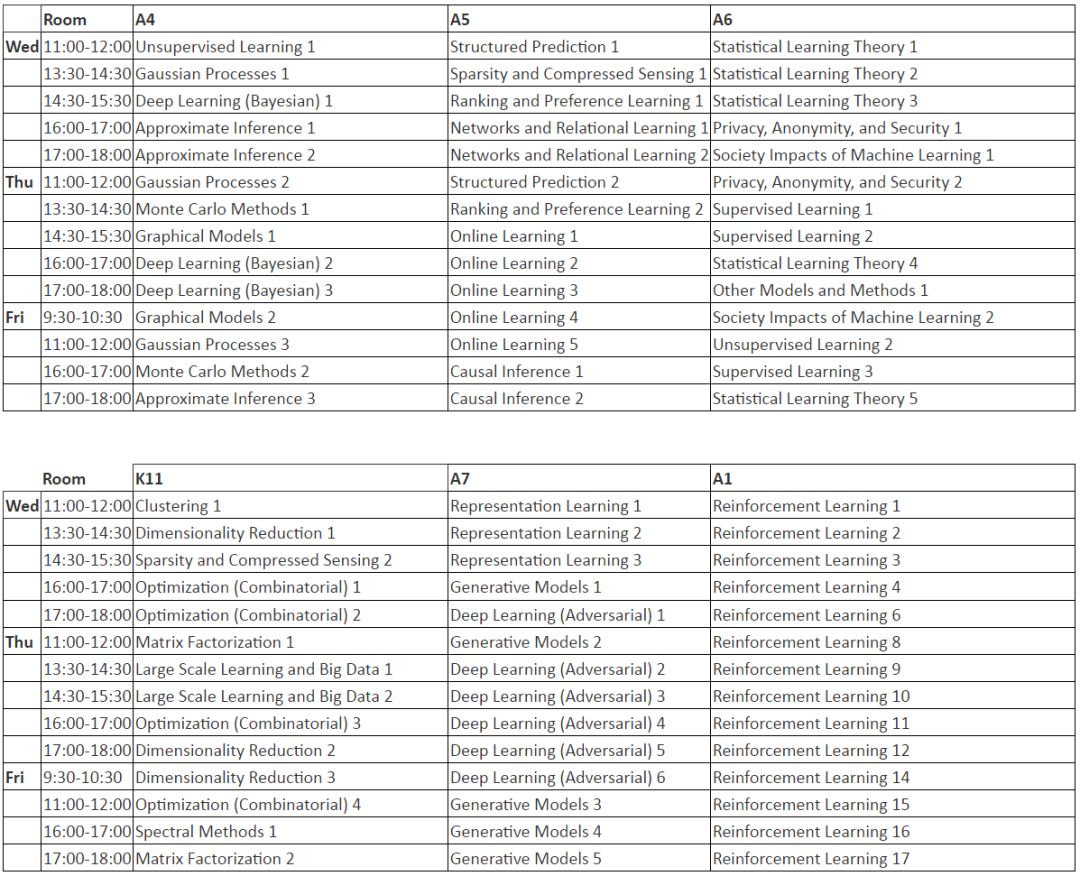

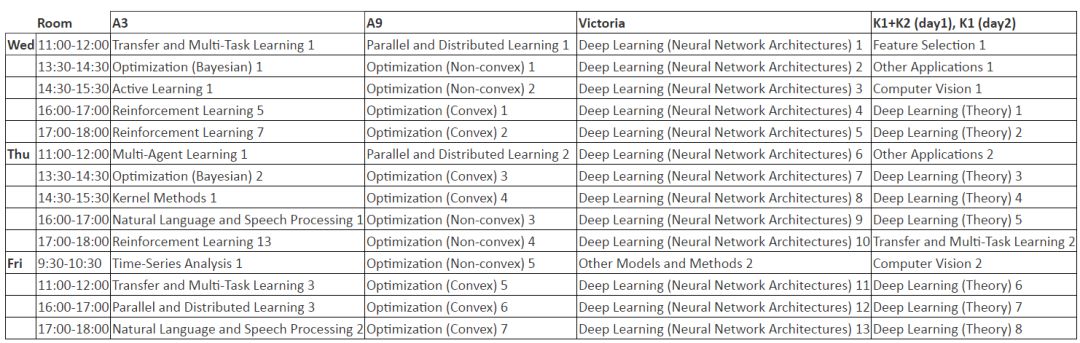

▌会议巡讲 Schedule

Tutorial Session 是后续主要技术开始前的教程日

后续三天就是主要技术的精彩纷呈,涉及了深度学习、强化学习、有限学习、变分贝叶斯、优化方法、自动机器学习等内容。

▌论文收集录

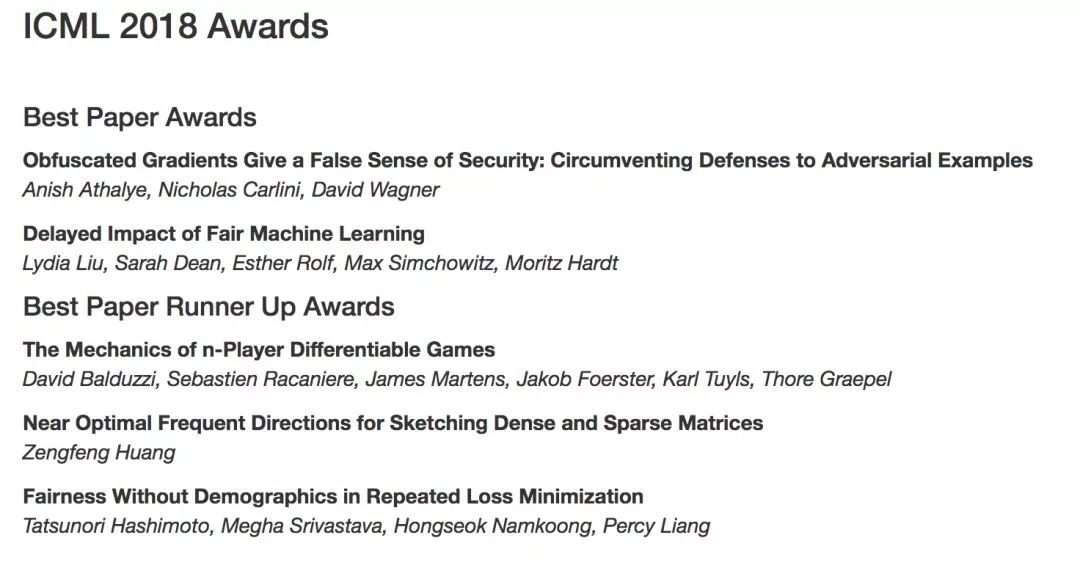

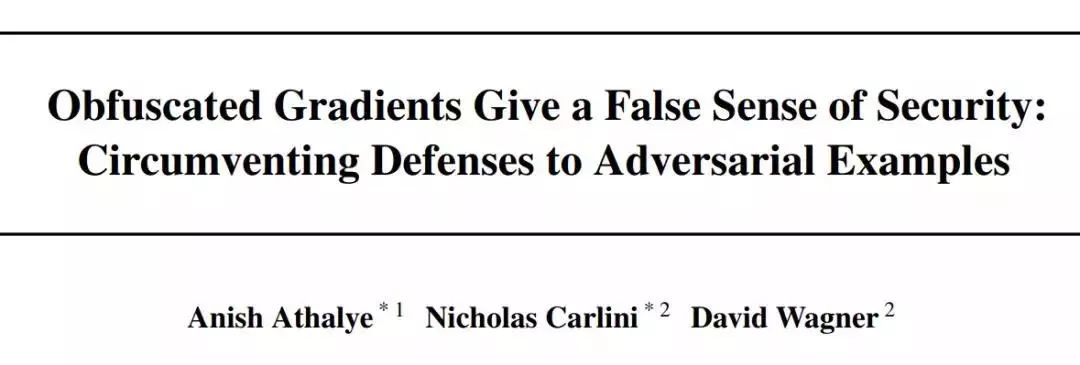

最佳论文1:来自 MIT 的 Anish Athalye 与来自 UC Berkely 的 Nicholas Carlini 和 David Wagner 获得了最佳论文。该研究定义了一种被称为「混淆梯度」(obfuscated gradients)的现象。在面对强大的基于优化的攻击之下,它可以实现对对抗样本的鲁棒性防御。早在今年 2 月,这项研究攻破了 ICLR 2018 七篇对抗样本防御论文的研究,曾一度引起了深度学习社区的热烈讨论。

论文链接:

https://arxiv.org/abs/1802.00420

项目链接:

https://github.com/anishathalye/obfuscated-gradients

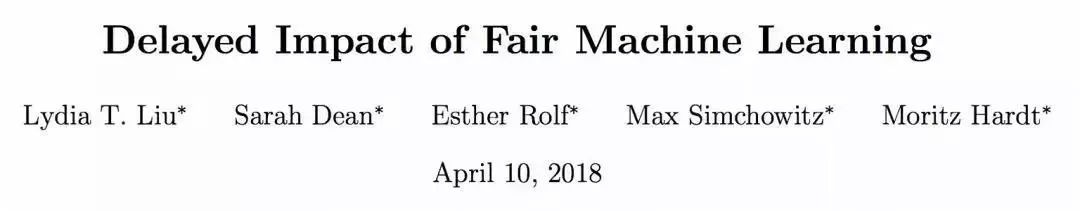

最佳论文2:来自 UC Berkeley EECS 的 Lydia T. Liu、Sarah Dean、Esther Rolf、Max Simchowitz 和 Moritz Hardt 的论文同样也获得了最佳论文奖。在这个研究中,关注机器学习公平性的静态分类标准如何与暂时的利益指标相互作用。总结了三个标准准则的延迟影响,强调评估公平性准则的度量和时序建模的重要性等一系列的新挑战和权衡问题。

论文链接:

https://arxiv.org/abs/1803.04383

▌Runner Up 论文

Runner UP 论文1:复旦大学数据科学学院副教授黄增峰完成的在线流(online streaming)算法与 DeepMind、斯坦福大学的两篇论文共同获得 Runner Up 奖。在该论文讨论的这种在线流算法可以在只有非常小的协方差误差的情况下,从大型矩阵抽取出最能近似它的小矩阵。

论文地址:

http://203.187.160.132:9011/www.cse.ust.hk/c3pr90ntc0td/~huang***/ICML18.pdf

Runner UP 论文2:来自 DeepMind 和牛津大学的研究者在研究中开发了新的技术来理解和控制一般博弈中的动态。主要的结果是将二阶动态分解为两个部分。第一个和潜博弈(potential game)相关;第二个和哈密顿博弈相关,这是一种新的博弈类型,遵循一种守恒定律——类似于经典力学系统中的守恒定律。

论文地址:

https://arxiv.org/abs/1802.05642

Runner UP 论文3:来自斯坦福大学的研究者在研究中首先展示了为解决经验风险最小化(ERM)使最初公平的模型也变得不公平了这一问题,提出了一种基于分布式鲁棒优化(distributionally robust optimization,DRO)的方法,可以最小化所有分布上的最大风险,使其接近经验分布。

论文地址:

https://arxiv.org/abs/1806.08010

颁发的两项最佳论文奖来表彰一些最有前途的论文技术方案的研究。最好的论文还将被邀请参加《机器学习杂志》。

▌国内未来可期

而今年腾讯 AI Lab也是取得了十余篇入选的好成绩,相比去年的 4 篇入选,这个成绩不仅是国内企业研究、高校研究的榜首,在国际排名上也是有了很大的进步。

在十余篇的研究中,主要分为三类:新模型与新框架、分布式与去中心化及机器学习的理论研究与优化方法。本次为大家介绍三种新模型与新框架。

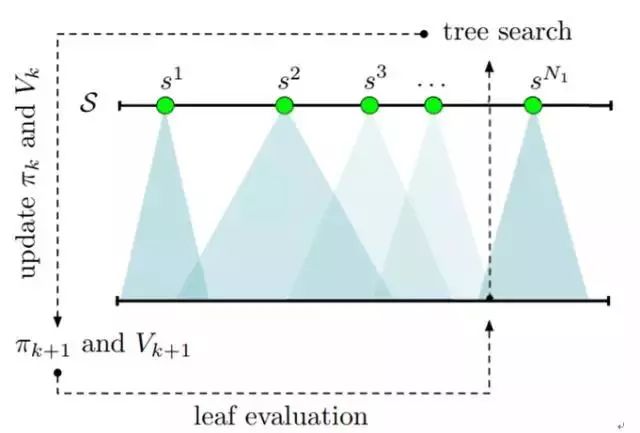

用于强化学习的基于反馈的树搜索

研究者还使用深度神经网络实现了这种基于反馈的树搜索算法并在《王者荣耀》1v1 模式上进行了测试。为了进行对比,研究者训练了 5 个操控英雄狄仁杰的智能体,结果他们提出的新方法显著优于其它方法。

论文链接:

https://arxiv.org/abs/1805.05935

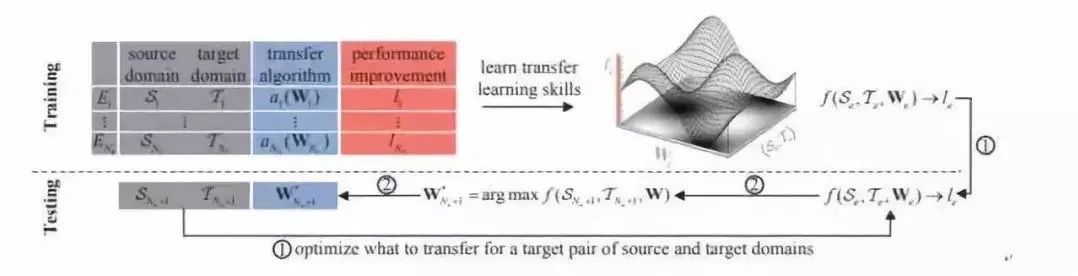

通过学习迁移实现迁移学习

迁移学习的三个核心研究问题是:何时迁移、如何迁移和迁移什么。为特定的迁移任务选择合适的迁移算法往往需要高成本的计算或相关领域的专业知识。为了能更有效地找到适合当前任务的迁移算法,研究者根据人类执行迁移学习的方式,设计了一种可根据之前的迁移学习经历提升新领域之间的迁移学习有效性的新框架:学习迁移(L2T:Learning to Transfer)。

论文地址:

https://ai.tencent.com/ailab/media/publications//icml/148_Transfer_Learning_via_Learning_to_Transfer.pdf

通过强化学习实现端到端的主动目标跟踪

目标跟踪的目标是根据视频的初始帧中的目标标注定位该目标在连续视频中的位置。对于移动机器人和无人机等视角会变动的平台或目标会离开当前拍摄场景的情况,跟踪目标时通常还需要对摄像头的拍摄角度进行持续调整。该论文提出了一种使用强化学习的端到端的主动目标跟踪方法,可直接根据画面情况调整摄像头角度。具体而言,研究者使用了一个 ConvNet-LSTM 网络,其输入为原始视频帧,输出为相机运动动作(前进、向左等)。

上图展示了这个 ConvNet-LSTM 网络的架构,其中的强化学习部分使用了一种当前最佳的强化学习算法 A3C。因为在现实场景上训练端到端的主动跟踪器还无法实现,所以研究者在 ViZDoom 和 Unreal Engine 进行了模拟训练。

论文地址:

https://arxiv.org/abs/1705.10561

更多详细论文解读可以参考学习:

https://ai.tencent.com/ailab/paper-list.html

https://mp.weixin.qq.com/s/xpX7eDG5ivk8ZYRjAEsH5g

▌国外大咖云集

Google AI & Deep Mind

这个数量多到不知道几时营长才能给大家推荐完,无论是机器学习理论,深度学习、强化学习、经典算法都有研究,利用架构与工具在语音、语言、翻译、音乐、视觉处理等领域也都有解决的的问题与挑战。只能说 Google 真是高度活跃在方方面面,有质有量,不愧是本届大会的白金赞助商。届时 Google 还将与大家分享 TensorFlow、Magenta等项目的最新工作,开展有关机器学习、强化学习等相关专题研讨会。DeepMind 于近日提出的多智能体的教程也将会在大会于大家进行分享,营长也在上周为大家介绍过这个最新研究。

Google 论文收录与研讨会:

https://ai.googleblog.com/2018/07/google-at-icml-2018.html?m=1

Deep Mind 论文收录与研讨会:

https://deepmind.com/blog/deepmind-papers-icml-2018

Microsoft

本届 ICML 大会微软通过26篇论文,一个个人健康机器学习的教程与两个研讨会;研究中涉及通过紧凑的潜在空间聚类进行半监督学习、提出 Katyusha X 的简单动量方法、GAN、SBEED(收敛强化学习)、探索加速 CNN 的隐藏维度、增强 CycleGAN等理论与算法的研究。两个研讨会的主题分别关于个性化AI 与 FAIM‘18 Causal ML。

Microsoft 论文收录与研讨会:

https://deepmind.com/blog/deepmind-papers-icml-2018

FaceBook 收录作品的数量与 Google、DeepMind 、微软相比较少,不过在神经机器翻译、人工智能代理、强化学习、语音、端到端的对话模型、GAN及多智能体的强化学习等领域也都有出色的研究。在强化学习中引入 SCAL 算法并证明显著优于现有的 UCRL、PSRL 等算法;在具有 Attention 机制的RNN网络中很多使用简单形式的编码器,Facebook 在研究中提出了一种聚焦 RNN 编码器的机制,用于序列建模任务,用于根据需要关注输入的关键部分,在合成任务上有更好的改进;在多智能体的强化学习中提出 SOM (Self Other-Modeling)的方法,在三个不同任务上评估此方法,表明代理能够在合作与对抗环境中使用它们对其他玩家隐藏状态的估计来学习更好的策略。除了理论研究、方法的创新,在本届大会,Facebook 也组织了一场研讨会,和大家一起一起探讨在强化学习中的预测模型与强化模型。

Facebook 论文收录与研讨会:

https://research.fb.com/facebook-research-at-icml-2018

▌结束语

直播已经开始,营长先去前方为大家收集情况,精彩内容后续为大家报道。点击阅读原文可获取直播链接。

最后为大家精心整理本次大会的时间表、收录论文地址及工作坊&研讨会概述,只需此一文在手,收尽 ICML 大会所有。

-

神经网络

+关注

关注

42文章

4765浏览量

100605 -

人工智能

+关注

关注

1791文章

46927浏览量

237783 -

机器学习

+关注

关注

66文章

8382浏览量

132464

原文标题:ICML进行时 | 一文看尽获奖论文及Google、Facebook、微软、腾讯的最新科研成果

文章出处:【微信号:rgznai100,微信公众号:rgznai100】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

祝贺!亿达科创荣获高交会“优秀科研成果创新奖”

中科曙光铸稳算力底座,赋能科研成果落地

Dell PowerScale数据湖助力医研一体化建设

海康微影DV式手持测温热像仪助力提升科研效率

逐际动力发布全尺寸人形机器人CL-2

激励科研人员使用中国自主量子计算机!“本源悟空”启动卓越论文奖励计划

Aigtek安泰电子论文奖励政策再升级,激励科研创新未来可期!

第三方软件测试机构-科技成果评价测试

南京大学团队首次观测到引力子激发现象

产学研深度融合,创新印刷电子未来|绿展科技团队阶段性科研成果介绍

一文看尽获奖论文及Google、Facebook、微软、腾讯的最新科研成果

一文看尽获奖论文及Google、Facebook、微软、腾讯的最新科研成果

评论