英特尔傲腾(Optane)既有消费级产品,也有企业级数据中心专用的产品,其实就是P4800X系列。

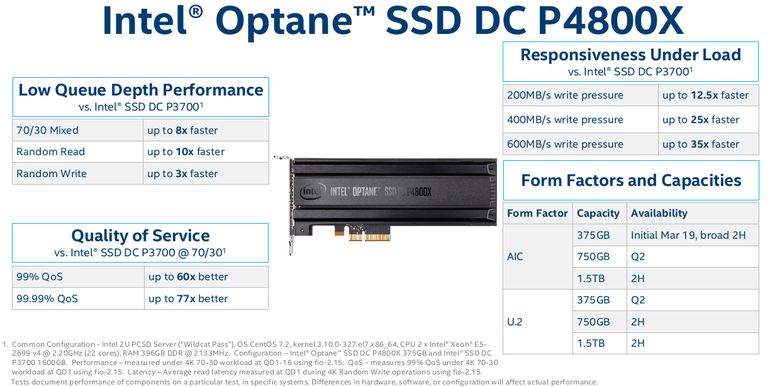

从官方介绍的数据来看,与3D NAND的DC P3700相比,DC P4800X在较低队列深度下的读写性能表现,读写响应时间,QoS等方面都有很大优势。

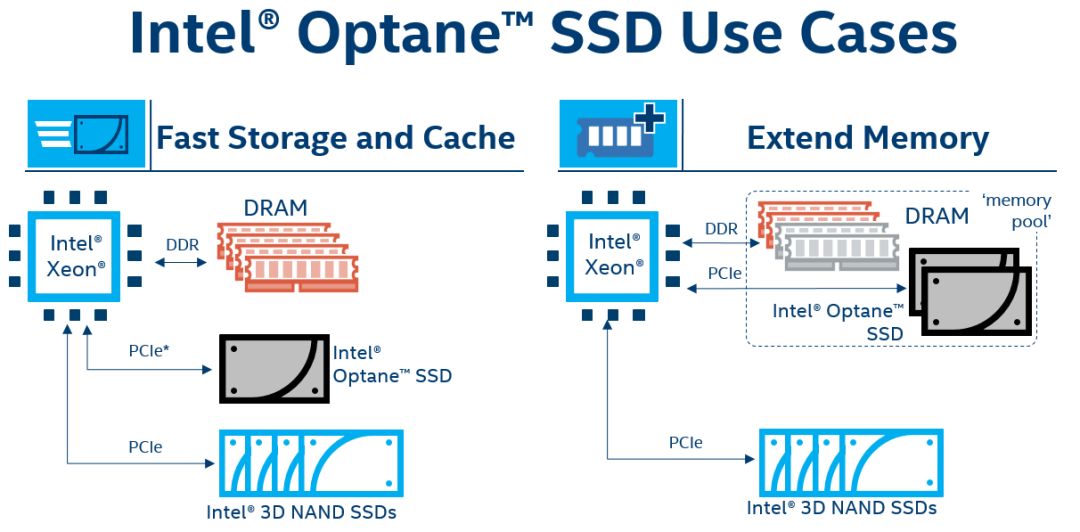

Optane的应用定位比较特殊:既能跟普通的3D NAND站在一个队伍,组成快存储和Cache方案。也能跟DRAM站在一块组成内存池,作为扩展内存。如下图所示:

Optane用作SSD

我们先来看Optane用作变异版的SSD的场景。之所以说是变异版,是因为Optane的一些特性能秒杀NAND SSD,其中以稳定性和低延迟最令人印象深刻,这点非常企业级。

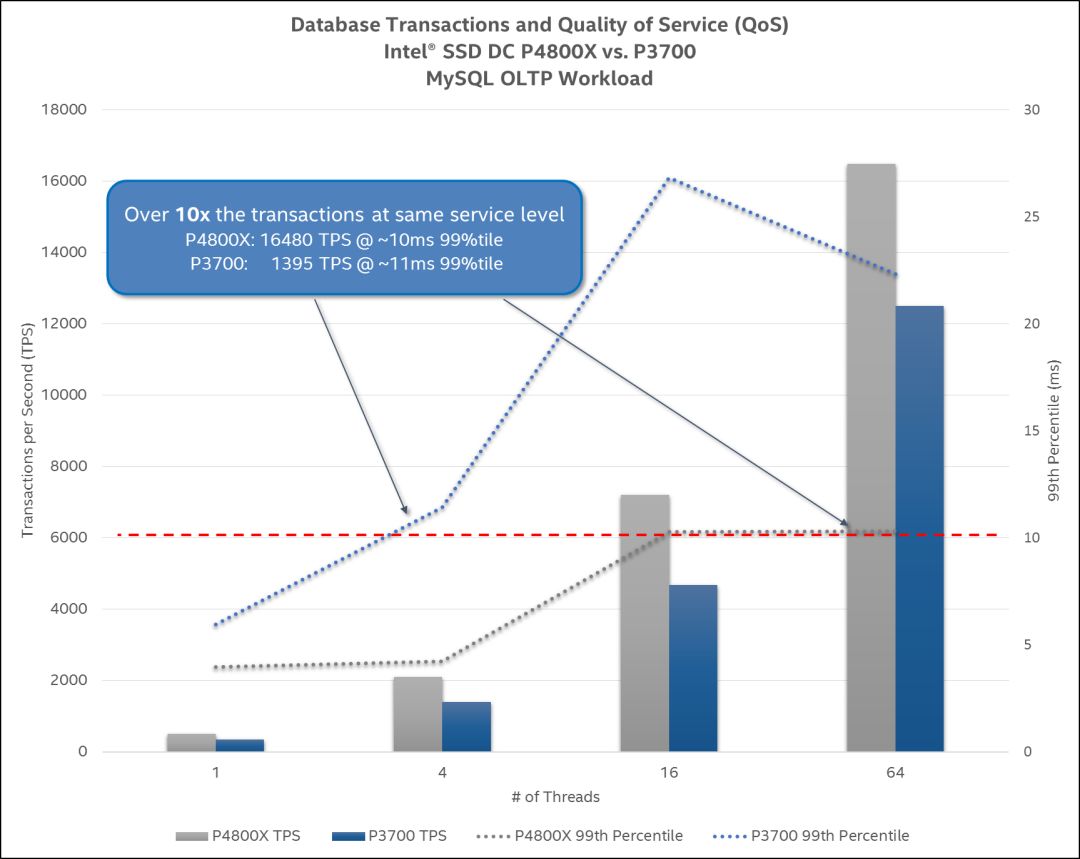

当用作快存储的时候,简单说就是加速。作为数据库,对性能最直接的要求就是TPM更高,多用户多线程下的高TPM是数据库的最基础的要求。英特尔用DC P3700和DC P4800X做了一个对比实验(除了硬盘以外,别的全一样),用Sysbench给出OLTP压力,做出的测试结果如下图。

横坐标是线程数,从单线程开始到64线程结束,左侧纵坐标是TPS(每秒的事务数),右侧纵坐标是延迟(时延)。随着线程数增长,TPS都在快速增长,当达到64线程的时候P4800X的TPS能达到16k以上,而P3700也有12kTPS,直观来看,差距是在不断拉大的,P4800X的优势不难发现。

这点展现出DC P4800X在多用户、高并发访问,OLTP的场景下的性能优势,比如淘宝双十一,证券金融行业的频繁事务处理,海量数据的实时数据分析等等场景,都需高负载下的稳定服务能力。

其实更值得注意的是P4800X的延迟时间,即使是到了16k(16480)TPS,64线程的时候也能控制在10ms,而P3700在4线程,1395TPS的时候就已经超了10ms了,性能延迟非常低,而且非常稳定,从图中可见,这点P4800X完全秒杀P3700。

如果是对可预测性能有要求的场景,对SLA有严格要求的场景的话,P4800X无疑将大放异彩。

在2018年的傲腾技术媒体分享会上,阿里的数据库专家介绍了Optane加速POLARDB的实践。据介绍,在傲腾的帮助下,阿里云POLARDB达到了开源的MySQL能力的6倍性能。因为傲腾技术创新的3D XPoint介质比NAND颗粒提供了更好的I/O延迟和I/O QoS稳定性,在数据库的整体QoS上阿里云在95%延迟的指标上提升了76%的性能。

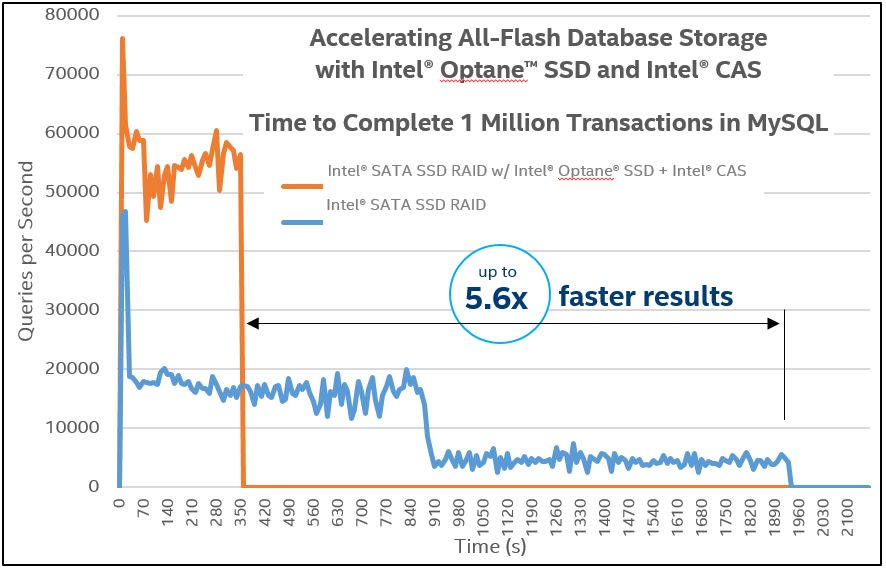

类似于Polardb这样的云数据库,对存储的要求既有性能,也有大容量,很多时候,一块SSD装不下一个完整的数据库,所以,需要把大的数据库存放在SSD组成的RAID上,SSD有普通SATA NAND SSD也有Optane,英特尔傲腾在CAS软件的帮助下实现智能的数据分层,而且会创建一些读写的Cache,不同的介质有不同的读写负载。

英特尔用Sysbench做了一组对比试验,搭配有Optane的一组测试数据比纯SATA组的数据完成1百万事务处理的速度快了5.6倍。有了傲腾之后的数据库查询速度明显提升。图中的蓝色曲线有几次大的变化主要是因为Sysbench改变了不同的测试复杂,比如开始是单行操作,连续多行操作,不连续多行操作等,即使是在不同负载下,有傲腾和CAS的一组测试数据也表现的非常稳定。

高稳定性、低延迟是基于3D Xpoint的Optane相对于普通3D NAND的绝对优势,那么对于所有关注稳定性、关注性能的关键业务领域,都应该考虑这种Optane创新存储方案,它适用于各种OLTP场景。

Optane用作扩展内存

Optane用作扩展内存,英特尔通过IMDT技术将Optane与DRAM组成内存池,而且不用系统做什么改变,更不需要应用做出多大改变,只需要安装操作系统之前安装一个底层软件即可,在IMDT的帮助下,Optane能突破系统识别的DRAM的空间限制,提供与DRAM相近的性能表现。

这一技术实现是一种突破,操作起来很难,但应用场景非常清楚,Optane用作内存目的就是为了部分替代昂贵的DRAM内存,花同样的钱能拥有更多内存。

大内存的好处毋庸置疑,操作系统运行加载程序需要大内存,一些内存型的应用也需要大内存,压缩解压缩也需要大内存,数据分析也需要大内存,机器学习也是内存越大越好,而且,Optane是非易失性的,掉电也不丢数据。

对于广大的超大规模数据中心用户,比如许多云厂商来说,Optane内存能显著降低这些企业在内存上的投入成本,这是广大云计算服务商所喜闻乐见的。在高性能计算领域,大的内存能提升科研和科学计算输出结果的速度,能更快地得到仿真结果。

-

英特尔

+关注

关注

61文章

9953浏览量

171700 -

3D

+关注

关注

9文章

2875浏览量

107490 -

云数据

+关注

关注

0文章

117浏览量

16617

原文标题:英特尔傲腾DC P4800X有哪些适用场景?

文章出处:【微信号:D1Net11,微信公众号:存储D1net】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

世纪大并购!传高通有意整体收购英特尔,英特尔最新回应

英特尔推出全新英特尔锐炫B系列显卡

英特尔12月或发布Battlemage GPU芯片

英特尔考虑出售Altera股权

英特尔至强品牌新战略发布

英特尔IT的发展现状和创新动向

英特尔是如何实现玻璃基板的?

英特尔CEO:AI时代英特尔动力不减

英特尔宣布代工亏损70亿美元

英特尔旗下FPGA公司Altera正式亮相

英特尔傲腾是什么?能在哪些场景下使用?

英特尔傲腾是什么?能在哪些场景下使用?

评论