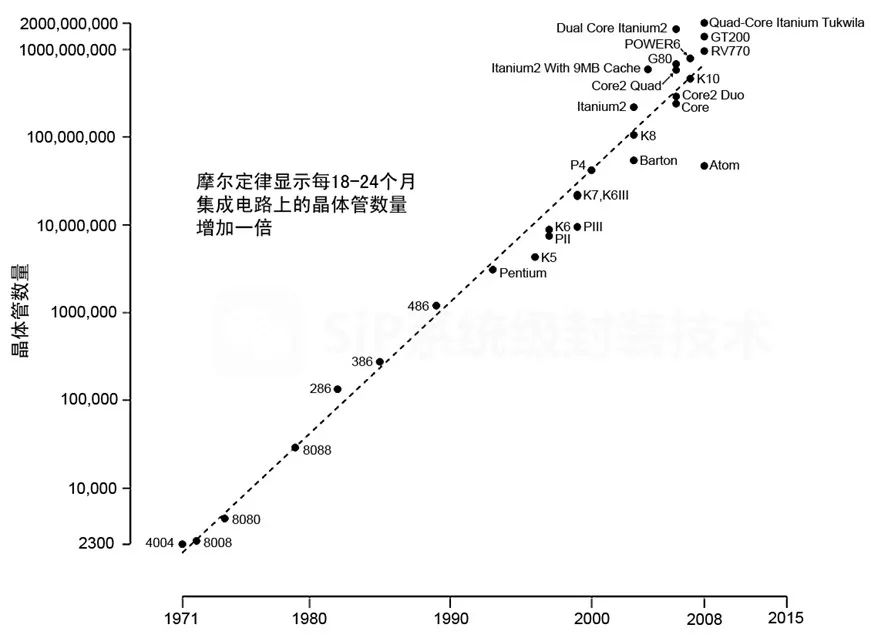

据SingularytyHub报道,到目前为止,我们大多数人都已经熟悉摩尔定律(Moore ‘s Law),这条著名的定律认为,计算能力的发展遵循指数曲线,每18个月左右性价比就会翻一番。然而,当涉及到将摩尔定律被应用到不同的商业策略中时,即使是远见卓识的思想家也经常受到被称为“人工智能盲点”(AI blind spot)的困扰。许多成功的、有战略头脑的商人能在自己的行业中找到捷径,但他们很难理解指数增长的真正含义,更不用说从曲线增长中获益匪浅的AI技术。

人们不理解AI发展有多快的一个原因很简单,甚至可以说是可笑的:当我们试图在纸上捕捉它们时,指数曲线表现得并不好。出于实际原因考虑,几乎不可能在狭小空间(如图表或幻灯片)中完全描述指数曲线的陡峭轨迹。直观地描绘指数曲线的早期阶段是很容易的。然而,随着曲线的陡峭部分开始显现,以及数字迅速增大,事情变得更加具有挑战性。

捕捉指数曲线

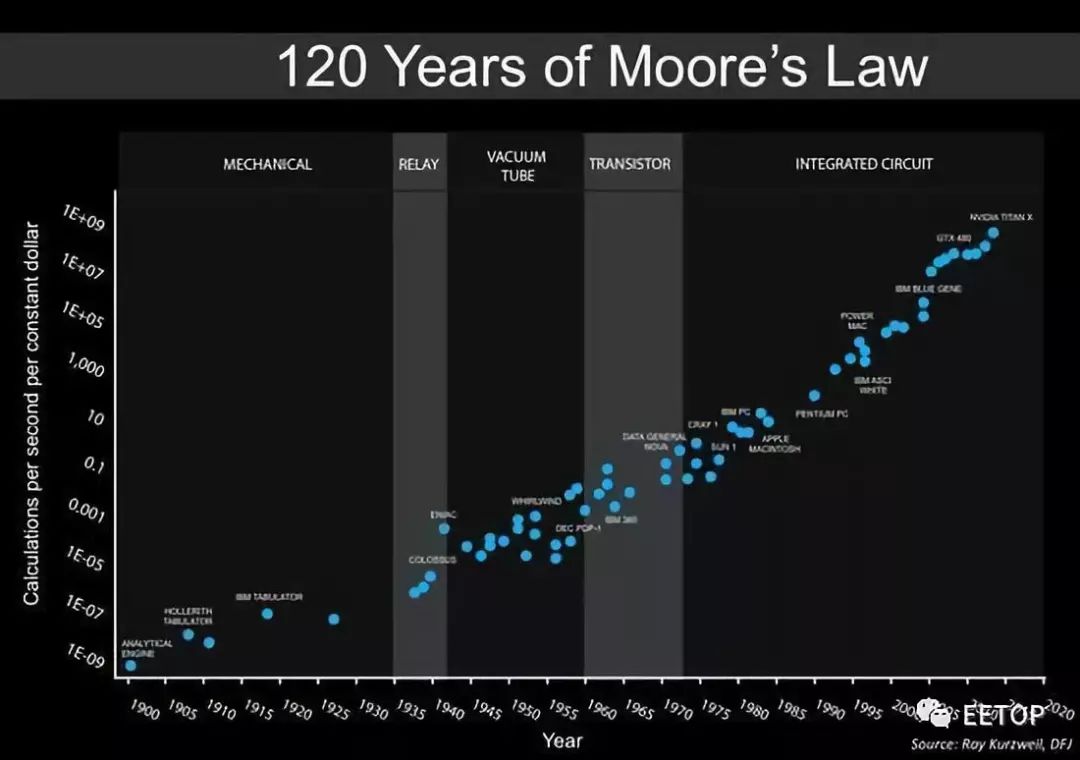

为了解决这个视觉空间不足的问题,我们使用了一个简单的数学技巧,叫做对数(logarithm)。使用所谓的“对数标度”(logarithmic scale),我们学会了将指数曲线进行压缩。不幸的是,“对数标度”的广泛使用也会导致短视的结果。对数标度的工作原理是,垂直y轴上的每一个刻度并非对应一个常数增量(如典型的线性标度),而是一个倍数,例如100倍。下面的经典摩尔定律图表使用“对数标度”来描述过去120年里计算能力的成本指数增长趋势,从1900年的机械设备到今天强大的硅基GPU。

▲图1:对数标度中显示过去120年间计算成本的指数变化情况

如今,对于那些意识到视觉失真的人来说,对数图已经成为非常有价值的速记形式。事实上,“对数标度”是一种简便而紧凑的方法,可以用来描述随着时间的推移以急速方式上升的任何曲线。然而,对数图却隐藏着巨大的代价:它们愚弄了人类的眼睛。通过数学上的大数字坍缩,对数图使得指数增长看起来是呈线性的。由于它们将不规则的指数增长曲线压缩成线性形状,对数图使人们很容易对未来计算能力的指数增长速度和规模感到满意,甚至产生自满。

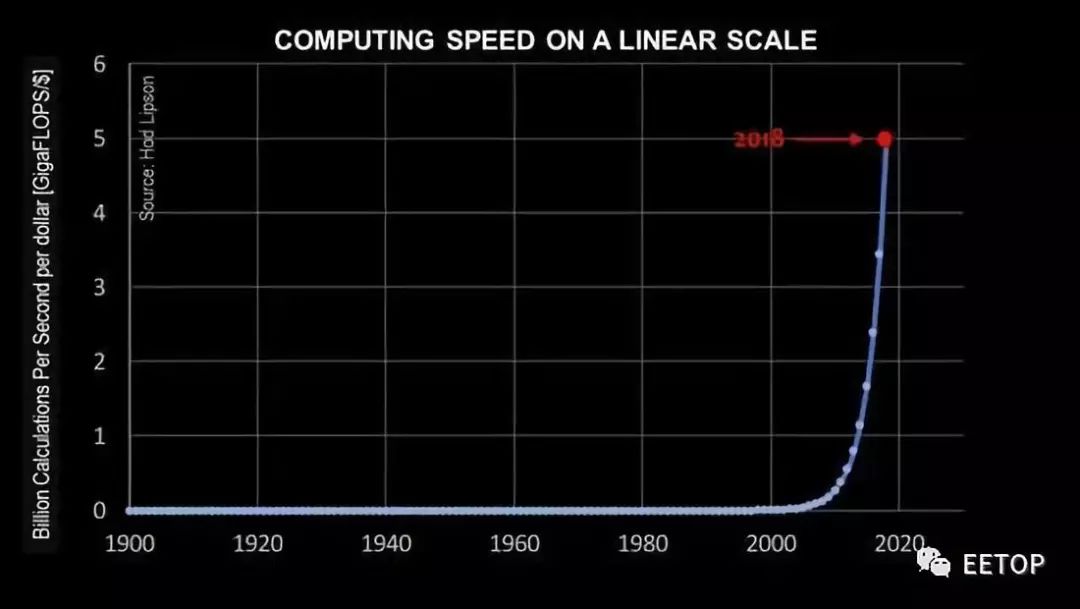

我们的逻辑大脑理解对数图。但是,我们的潜意识却看到了一条线性曲线,并选择对其缺陷视而不见。那么,如何有效地消除由对数图引起的战略短视呢?部分解决方法是回到原来的线性尺度。在下面的图2中,我们使用数据来拟合指数曲线,然后用垂直轴上的线性刻度绘制它。同样,纵轴表示一美元可以购买的处理速度(单位为gigaflops),横轴表示时间。

然而在图2中,纵轴上的每个刻度都对应于一个简单的线性增加趋势(相当于1gigaflops,而不是像图表1那样增加100倍)。“FLOP”这个词是测量计算速度的标准方法,代表着每秒进行的浮点操作,其他单位还包括megaFLOPS、gigaFLOPS以及teraFLOPS等。

▲图2:以线性标度描述的摩尔定律

图2显示了描述摩尔定律的真实指数曲线。这张图表的绘制方式,让我们的人眼很容易理解:在过去的十年里,计算性价比发生了多么快的变化。然而,图2中同样存在严重的错误。对于这张图表的天真读者来说,似乎在20世纪的整个过程中,计算机的性价比根本没有提高。很明显,这是错误的。

图2显示,使用线性标度来证明摩尔定律随时间变化而变化时,也存在相当大的盲目性。它可以让过去显得平淡无奇,就好像直到最近才取得进展一样。此外,同样的线性标度图也会导致人们错误地认为,他们目前的优势点代表了独特的、“几乎垂直”的技术进步时期。这一点让我想到了导致AI盲点的图表出现的下一个主要原因:线性标度图表可以欺骗人们,让他们相信自己的生活正处于变化高峰期。

活在当下的短视

让我们再看下表2:从2018年的情况来看,20世纪大部分时间里每十年就会出现的性价比翻倍似乎已经平淡无奇,甚至显得无关紧要。看了表2的人可能会对自己说:“孩子,我今天活得很幸运吗?我记得2009年,当时我认为自己的新iPhone很快!但实际上我不知道它有多慢,现在我终于到达了令人兴奋的垂直部分!”

我听人说过,我们刚刚通过了“曲棍球棒的肘部”。但还没有这样的过渡点。任何指数曲线自身都是相似的,也就是说,未来曲线的形状和过去的曲线几乎没有太大变化。下面的图3再次显示了摩尔定律在线性标度图表上的指数曲线,但这次是从2028年的角度来看。这条曲线假设,我们在过去100年里经历的增长至少还将持续10年。这张图表显示,在2028年,一美元将购买大约200gigaflop的计算能力。

▲图3:线性标度图上的摩尔定律

然而,图3也代表了一个潜在的分析困境。仔细看看图3所示曲线位置,它代表了今天的计算能力(2018年)。以生活和工作在2028年的人来看,即使在21世纪初,计算能力几乎没有任何实质性改善。看起来,2018年使用的计算设备只是比1950年使用的计算机稍强。观察人士还可以得出结论,2028年是摩尔定律的顶点,那一年计算能力的进步终于开始了。

每年,我都可以重新创建图表3,只改变时间范畴的描述。曲线的形状十分相似,只有垂直刻度上的刻度会改变。请注意,除了垂直标度之外,图2和图3的形状看起来是一样的。在每个这样的图表上,从未来的角度来看,过去的每个点都是扁平的,而未来的每个点看起来都是与过去截然不同的。这种错误的看法正被引入有缺陷的商业战略中,至少在AI方面是如此。

这代表着什么?

指数式的变化速度对人类的头脑和眼睛来说都是难以理解的。指数曲线是唯一的,因为从数学角度来看,它们在每个点上都是相似的。这就意味着,曾经不断加倍的曲线没有平坦部分可言,也没有上升的部分;同样没有许多商业人士习惯于谈论的“肘”和“曲棍球棒”弯曲。即使你放大过去或未来的任何部分,它的形状看起来都是一样的。

随着摩尔定律继续发挥作用,我们不禁会想,就在此刻,我们正处于AI(或任何其他依赖摩尔定律的技术)发展的独特时期。然而,只要处理能力继续遵循指数级的性价比曲线,未来的每一代人都可能会回顾过去,认为这是个进步相对较小的时代。反过来,情况也将是这样:每一代人都将展望未来10年,却无法预测到AI还有多少进步空间。

因此,对于任何计划由计算机指数增长驱动未来的人来说,挑战在于与他们大脑中的错误解释作斗争。虽然这听起来很难,但你需要同时记住这三张图——对数图的视觉一致性、戏剧性和线性图的欺骗性尺度,这样你才能真正领会指数增长的力.量。因为过去总是显得平淡无奇,而未来将永远充满了巨变。

-

摩尔定律

+关注

关注

4文章

634浏览量

79006 -

人工智能

+关注

关注

1791文章

47222浏览量

238307

原文标题:揭秘:为何大多数人都错估了计算机与AI的发展

文章出处:【微信号:eetop-1,微信公众号:EETOP】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

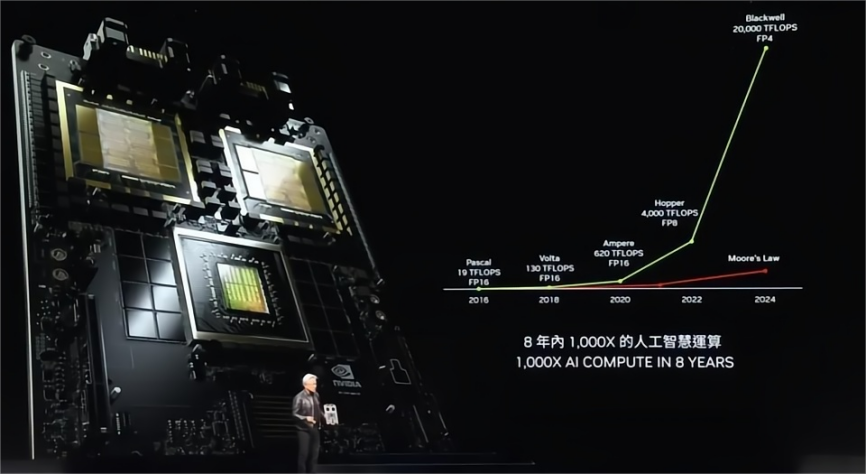

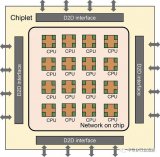

击碎摩尔定律!英伟达和AMD将一年一款新品,均提及HBM和先进封装

后摩尔定律时代,提升集成芯片系统化能力的有效途径有哪些?

CMOS 2.0:摩尔定律的新篇章

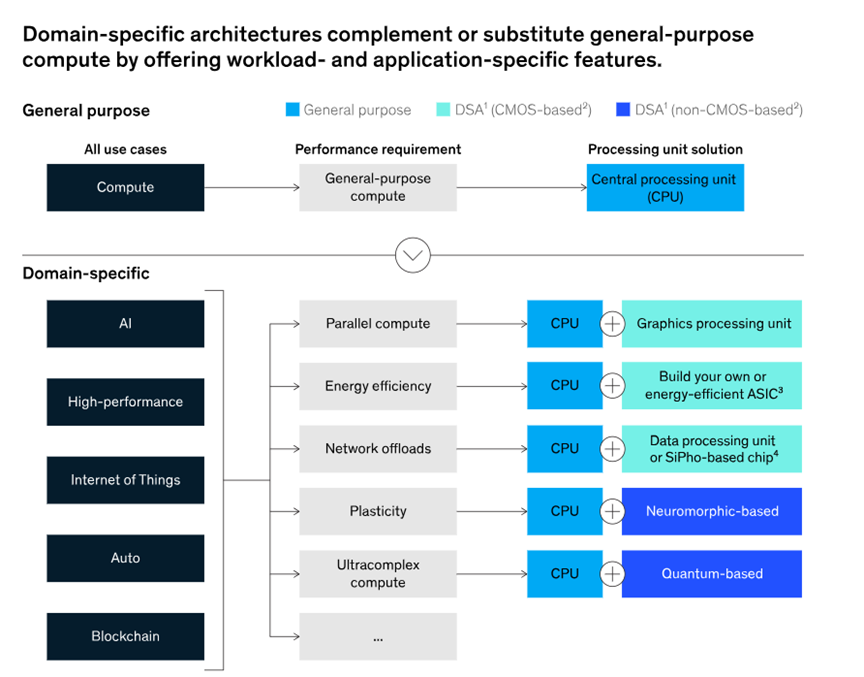

奇异摩尔专用DSA加速解决方案重塑人工智能与高性能计算

高算力AI芯片主张“超越摩尔”,Chiplet与先进封装技术迎百家争鸣时代

“自我实现的预言”摩尔定律,如何继续引领创新

人工智能需要强大的计算能力,光芯片有帮助吗?

新思科技斥资350亿美元收购ANSYS有何思量?

摩尔定律的终结:芯片产业的下一个胜者法则是什么?

摩尔定律的顶点将在2028年?计算能力正式开始进步?

摩尔定律的顶点将在2028年?计算能力正式开始进步?

评论