Ian Goodfellow 今天发推表示,他怀疑正是同行评议机制导致了如今AI会议论文下降,评审人质量参差不齐是主要原因,浮夸的论文被选中,真正的好论文反而被埋没。作为科学界一贯以来的双盲同行评议机制,正在遭遇一场前所未有的灾难。

如果你让一位科学家只选一个科学界引以为傲的标准,估计不少人都会说“同行评议”。

同行评议是大多数国际期刊和会议对投稿论文进行筛选的其中一个过程。很多时候,期刊编辑或学术会议会邀请某一特定研究领域的专家,对文章进行评价,帮助决定投稿论文是否值得发表。

更广泛地说,同行评议是专家学者对本专业领域的学术成果的评价,包括著述的发表出版、评论、评奖、评职称、论文引用、论文鉴定等等。

同行评议是科学界能够“自我纠正”“自我完善”的光荣传统:以同行评议为核心的科学评价体系旨在清除不同形式的欺骗、实验误差或研究者的失误,防止和发现自欺行为和偏见。

但是,今天谷歌研究员、GAN的发明人Ian Goodfellow 却发布一条推文:他怀疑,实际上正是同行评议造成了如今机器学习里的一些怪现象!

尤其是机器学习和AI会议论文的一些同行评议结果,不但没有保持科学界的优良传统,反而导致一些华而不实的论文被发表,而真知灼见则往往因为评审人自身水平低、没看懂而拒稿遭到埋没。

现在的顶会评审,真是出了大问题。

Goodfellow:同行评议才是现今AI会议论文水平下降的元凶!

Goodfellow在推文中表示,作为频繁出任会议领域主席并且管理一支小型科研团队的研究者,他经常能看到很多人(包括他自己团队在内)工作的评审意见。

对于实证研究来说,最多的(拒稿)意见是没有“理论”,但评审人并没有针对某个特定问题去要理论,而是将其当做一种轻松的拒稿理由——Goodfellow 这样形容,“他们扫了一遍论文,没看到炫酷的公式”,好,拒掉吧,原因?写“缺乏理论”就好。

而投稿人为了应对这样的评审,最简单的方法之一,就是在论文中加入许多无用的数学推理和公式。评审人一般不会认为这些公式没用,相反,这样做还通过他们心目中“我扫了一遍,看到了炫酷的公式或者不明觉厉的理论名称”这个测试标准。

类似地,Goodfellow 指出,对于那些提出一种新方法取得更好性能的论文,评审人往往读过一篇,然后拒稿,理由是论文没有阐释为什么这种方法表现更好。而当论文有解释的内容时,无论说得多不靠谱,甚至根本不被证据支持,心软一些的评审人也会让其通过。

此外,评审人看见通过实证观察去理解一个系统工作原理的论文时,往往反馈“没有新算法”。这时候怎么办?扔一个新方法进去就行了呗,管它相不相关呢。

评审人一般不怎么喜欢纯科学论文(science papers),那理论研究怎么投稿?好办,象征性地加点新的工程方法进去就行啦。

Goodfellow 指出,也有个别科学论文全凭实力得到高分,但通常也是被拒稿多次以后才有幸遇到了真正能看懂的评审人。

总之,Goodfellow 说:“机器学习如今的怪现象里,有一些可能不是同行评议造成的,但评审人要求增加数学(公式)、增加虚假的解释和虚假的原创性,我已经司空见惯了。”

Goodfellow 指出,同行评议作为一种机制是经过时间检验的科学评价标准,但具体实施仍然要谨慎。

NIPS 2018初审结果出炉,哀声遍野:评审人不专业!

Goodfellow 提到的“机器学习怪现象”,实际上就是 ICML 2018 的一场辩论。CMU 助理教授 Zachary C.Lipton 携手斯坦福研究员 Jacob Steinhardt,撰写了一篇《机器学习令人担忧的趋势》(Troubling Trends in Machine Learning Scholarship),引发了热烈的讨论。

Lipton 和 Steinhardt 在文中指出,如今的机器学习论文存在几大问题:

无法区分客观阐述和推测;

无法确定取得更好结果的原因,例如,当实际上是因为对超参数微调而获得好效果的时候,却强调不必要的修改神经网络结构;

数学公式堆积:使用令人混淆的数学术语而不加以澄清,例如混淆技术与非技术概念;

语言误用,例如使用带有口语的艺术术语,或者过多使用既定的技术术语。

如此看来,也难怪 Goodfellow 会怀疑,正是现今的同行评议,造成了AI和机器学习会议论文水平下降!

看到 Goodfellow 的推文后,Lipton 也表示赞同。他回复推文说,确实,如今同行评议水平下降,以及由此导致投稿人心态扭曲,也是造成机器学习怪现象的原因之一。

实际上,前几天正好 NIPS 2018 的初审结果公布,社交网络上哀鸿遍野。对评审结果的抱怨,很大程度上就是 Goodfellow 指出的那些:没有数学公式、缺乏结果解释……

其中,最严重的问题,或许是评审人本身不专业,根本没有看懂论文!

中科院计算所的一位博士生导师告诉新智元,他们组这次提交的一篇 NIPS 2018 论文,反馈意见还不算太差,6、6、8(6=marginal accept,8=accept)。

其中,认为该接受的那位评审,确实是看懂了论文,提出了很多有针对性的具体问题和意见。而其他两位认为拒也可收也可的评审,只给出了非常简略的反馈,讽刺的是,其中一位的理由恰好就是“没有解释结果原因”。

这位博士生导师说:“很明显,那两名评审要么就是没有细看论文,要么就是对领域不熟。”

“我告诉学生,好好rebuttal,还是有希望的。”

论文数量激增,ICML、NIPS等顶会评审陷入困境

NIPS 2017,微软亚洲研究院刘铁岩组中了 4 篇论文。新智元在采访现任微软亚洲研究院副院长的刘铁岩博士时,后者也曾提到,近年来机器学习和 AI 会议论文数量激增,是好事,也是坏事。

与 Goodfellow 一样,同样是机器学习顶会领域主席常客的刘铁岩博士说,由于很难在短时间内找到足够多的严谨合格的评审人,权威评审人/领域主席的时间和精力有限,也只能看那么多篇论文,剩下的就只能找稍微次一些的评审,这些评审人很可能因为自己的水平有限,无法觉察优秀论文的创新和意义而直接拒稿。

另一方面,这些评审往往会被一些包装得很华丽、结果很漂亮,但对领域发展并没有那么大作用的论文所吸引,因此现在 NIPS 整体论文水平参差不齐。

但是,论文整体质量下降也并非单纯由于近年来论文数量激增、评审人质量下降造成。

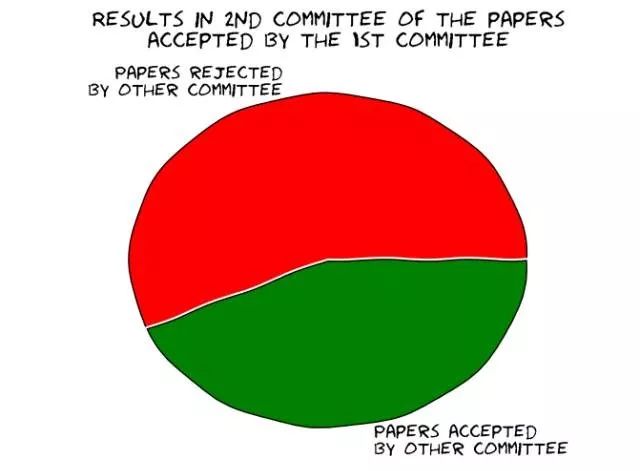

NIPS 2014 做了一个实验,将当年投稿的10%(共166篇论文)同时交给两个不同的评审委员会评审,每个委员会由大会组委会的一半成员构成。评审结果令人吃惊:两个评审委员会对其中 42 篇论文(约25%)的评审意见相左。由于两个委员会都把论文录用率控制在 22.5% 左右,委员会一录用的 21 篇论文会被组委会二拒稿,而组委会二录用的 22 篇论文被组委会一拒稿!

也就是说,被其中一个评审委员会录用的论文,其中大约 57%会被另一个评审委员会拒稿。这样,从理论上讲,如果重新审稿,NIPS2014年录用的一半以上的文章将被拒稿!

上述实验表明,当录用率很低时,质量居中的论文录用的随机性将大大提高。比如在上述例子中,约7.5%肯定被录用,50%以上的文章肯定被拒稿,其余中间 47% 左右的论文是否被录用则有很强的随机性。

相对而言,NIPS 2014 的投稿远没有 NIPS 2018 多,因此上述评审人问题至少不会那么严重。

论文录取这件事,本身就有很强的随机性。

成也Arxiv,败也Arxiv:AI会议论文未来该如何评审?

目前,期刊和会议会采取不同的同行评议方式,有单盲、双盲、公开同行评议和发表后再进行同行评议等方式。不论采取哪种模式,同行评议的主要目的都是为了验证研究结果,保证所发表的工作具有全球性的影响。

ACL 已经采用了双盲评审机制,而且规定研究人员不能在一定期限内将论文上传到 arXiv,很大一个原因便是以 arXiv 为代表的预印版论文库干扰了同行评议,尤其是双盲评议。

CVPR 2019 程序主席、微软研究院首席研究员华刚博士此前在接受新智元专访时表示,ArXiv 虽然是一个非同行评议论文库,但其活跃度让如今大多数研究人员都把它作为一个定期跟踪的信息源。

但是,身为多个学术会议的主席以及多本学术期刊的编委,华刚博士在肯定 arXiv 加速学术交流的同时,一针见血地指出,“arXiv让学术会议的双盲评审形同虚设”,arXiv上的论文质量也是“鱼龙混杂”。

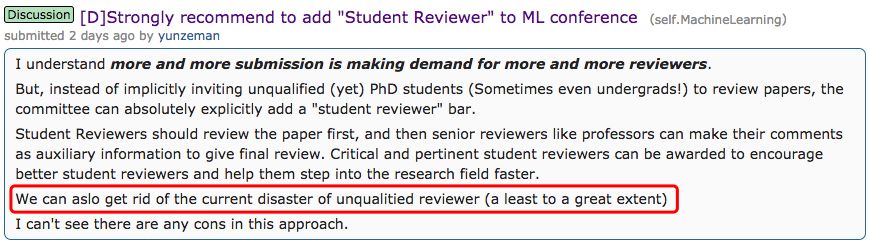

但如今,NIPS的双盲评审也暴露出种种问题。有人呼吁,强烈建议将“学生评审”加入到审稿人中来——与其邀请不合格的博士生甚至本科生,还不如明确地加入“学生评审”,让学生评审人先阅读论文,然后教授等高级评审人评论作为辅助信息,提供给最终评审,这在很大程度上可以摆脱目前审稿人质量参差不齐的灾难。

仅仅举办 5 年便被誉为“深度学习顶会”的ICLR,率先采用 Open Review 论文评审机制,评审和 rebuttal 全部公开,或许也是一种解决之道。

你认为呢?

-

AI

+关注

关注

87文章

30725浏览量

268863 -

机器学习

+关注

关注

66文章

8406浏览量

132547

原文标题:Goodfellow 炮轰同行评议!双盲评审导致AI顶会论文变水

文章出处:【微信号:AI_era,微信公众号:新智元】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

人类智慧水平AI即将到来,AI芯片已提前布局

MediaTek天玑移动平台赋能腾讯会议端侧AI人像分割模型

Ambarella SoC的 CVflow® 高级AI引擎驱动 360° 视频会议体验提升

11.11 云会议门槛再降低!华为云会议 Flexus 版 1 元天起

京东技术专家的修炼之道——成为一名“六边形战士”

Nullmax视觉感知能力再获国际顶级学术会议认可

Altair 宣布即将举办 ATCx AI for Engineers 2024 全球线上会议

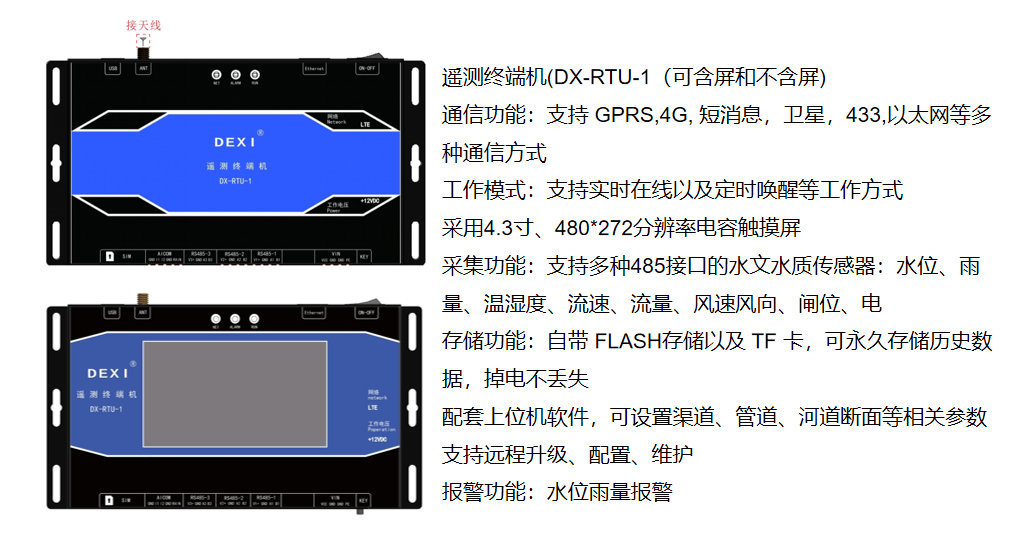

水文水位监测系统方案

飞利浦影音推出首款AI会议降噪耳机飞利浦“8号”

Microsoft Teams最新AI功能深化智慧协作,共创高效会议

聚焦AI,探析边缘智能新动向,研华AI on Arm合作伙伴会议开启报名!

OpenAI CEO称人类水平的AI即将出现

AI写作神器!搭载讯飞星火认知大模型,能够智能写作的键盘!

Goodfellow:同行评议才是现今AI会议论文水平下降的元凶!

Goodfellow:同行评议才是现今AI会议论文水平下降的元凶!

评论