一直以来,Google 就通过自研 AI 芯片以满足其神经网络日益增长的计算需求。北京时间昨日晚间,远在太平洋彼岸的 GoogleCloud Next 2018 大会上,Google正式对外宣布推出 Edge TPU,一款能使传感器和其他设备更快处理数据的 AI 专用芯片。

据了解,早在 2016 年,Google就发布了张量处理单元(Tensor Processing Unit,简称 TPU ),让大家首次认识到了 AI 专用芯片的能力。

从 TPU 的一路演进上可以发现,在 2015 年 Google 才刚开始内部投入使用,2016年初代TPU版本公布时还只能做些通过数据预测的事情,2017 年第二代版本则可被用来训练模型,甚至还能与英伟达显卡相媲美,到今年5月第三代版本推出时,由 TPU 3.0 组成的 TPU Pod 运算阵列,性能相比上一代提升了 8 倍,可提供 100 petaflops(千万亿次) 的机器学习硬件加速.

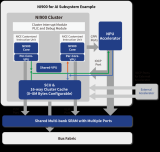

而此次 Edge TPU 的到来让我们看到,Google 又将目光转移到了网络终端的无数个物联网设备,并顺势推出了配套软件栈 Cloud IoT Edge。

相比来说,Edge TPU 是专门为在边缘运行TensorFlow Lite ML模型而设计,用来处理 ML 预测的微型芯片,要比训练模型的计算强度小很多。Edge TPU 可以自己进行运算,不需要与多台强大的计算机相连,因此应用程序可以更快、更可靠的工作。

Edge TPU开发套件:SOM和底板

在CNBC等多家外媒报道中透露,

Google 进军“定制芯片”市场,是其试图扩大云计算市场份额、与亚马逊和微软加强竞争的一种方式。自2015年以来,Google 始终在用 TPU 来加速自家数据中心的某些工作负载,而不是依赖英伟达等供应商提供的商用硬件。

接受CNBC采访中,三星前首席技术官 Injong Rhee 则表示,Google 并没有让Edge TPU 与传统芯片竞争,“这对所有硅芯片供应商和设备制造商是非常有利的”。

在他看来,Edge TPU 可能会“颠覆云计算竞争”,因为许多计算现在可以在设备上进行,而不是全部发送到数据中心。在成本和能耗方面,Google 芯片在某些类型的计算上比传统芯片更加高效。

那么回到国内,近段时间诸多AI领域的创业企业正暗暗打造自己的AI芯片,看到Google此举,是否有些许不安呢?

-

传感器

+关注

关注

2552文章

51325浏览量

755364 -

Google

+关注

关注

5文章

1769浏览量

57668 -

AI芯片

+关注

关注

17文章

1900浏览量

35134

原文标题:Google把AI芯片装进IoT设备,与国内造芯势力何干?

文章出处:【微信号:rgznai100,微信公众号:rgznai100】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

意法半导体推出面向下一代智能穿戴医疗设备的生物传感器芯片

ADS1230怎么处理才能使信号在芯片量程范围内?

求推荐一款处理24V的差分编码器信号的芯片

Orin芯片与其他芯片对比

在NVIDIA Holoscan SDK中使用OpenCV构建零拷贝AI传感器处理管线

纳芯微推出一款完全集成的高隔离电流传感器—NSM2311

智能家居、智慧工厂,AI传感器无处不在!国内外厂商积极布局

英飞凌和盛思锐合作推出一款支持Arduino的传感器扩展板

鼠害监测设备(传感器技术)

NanoEdge AI的技术原理、应用场景及优势

芯来科技正式发布首款专用处理器产品线Nuclei Intelligence系列

一款能使传感器和其他设备更快处理数据的AI专用芯片

一款能使传感器和其他设备更快处理数据的AI专用芯片

评论