人工智能的主流技术的发展大致经历了三个重要的历程。1956-1965年,人工智能的形成期,强调推理的作用。一般认为只要机器被赋予逻辑推理能力就可以实现人工智能。不过此后人们发现,只是具备了逻辑推理能力,机器还远远达不到智能化的水平。1965-1990年,人工智能的“知识期”。这一时期,人们认为要让机器变得有智能,就应该设法让机器具有知识。

后来人们发现,知识获取相当困难。1990年至今,人工智能进入“机器学习期”。随着各种机器学习算法的提出和应用,特别是深度学习技术的发展,人们希望机器能够通过大量数据分析,从而自动学习出知识并实现智能化水平。这一时期,随着计算机硬件水平的提升,大数据分析技术的发展,机器采集、存储、处理数据的水平有了大幅提高。特别是深度学习技术对知识的理解比之前浅层学习有了很大的进步,Alpha Go和中韩围棋高手过招大幅领先就是人工智能的高水平代表之一。

人工智能发展的62年中,有高潮,有低潮,呈现波浪式前进,螺旋式提升。1960年代,人工智能大发展,1970年代,人工智能处于低潮,特别是神经网路、机器翻译等的研究项目大量取消。1980年代,人工智能发展迎来了“日本五代机”大好时光。但是到1988年,“日本五代机”研究没有达到预期的目标,引起人们反思人工智能的研究。1991年,人工智能顶级刊物“Artificial Intelligence”第47卷发表了人工智能基础专辑,指出了人工智能研究的趋势。Kirsh在专辑中提出了人工智能的五个基本问题:

(1)知识与概念化是否是人工智能的核心?

(2)认知能力能否与载体分开来研究?

(3)认知的轨迹是否可用类自然语言来描述?

(4)学习能力能否与认知分开来研究?

(5)所有的认知是否有一种统一的结构?

这些问题都是与人工智能有关的认知问题,必须从认知科学的基础理论进行探讨。基础理论研究是为获得关于现象和可观察事实的基本原理及新知识而进行的实验性和理论性工作,它不以任何专门或特定的应用或使用为目的。

在过去的几年间,由于神经网络,或者“深度学习”方法的飞速发,人工智能已经发生了一场变革,这些人工智能方法的起源都直接来自神经科学。1943年,心理学家麦克洛奇(W S McCulloch) 和数理逻辑学家皮兹 (W Pitts) 在《数学生物物理公报 (Bulletin ofMathematical Biophysics)》上发表了关于神经网络的数学模型,提出了MP神经网络模型,开创了人工神经网络的研究。

神经计算的研究以建设人工的神经网络作为开端,这些神经网络能计算逻辑函数。不久之后,有人提出了另外的一些机制,认为神经网络中的神经元可能可以逐步地从监督式的回馈或者非监督方法中有效的编码环境统计下进行学习。这些机制打开了人工神经网络研究的另一扇大门,并且提供了当代对深度学习进行研究的基础。费尔德曼(Feldmann) 和 巴拉德(Ballard) 的连接网络模型指出了传统的人工智能计算与生物的“计算"的区别, 提出了并行分布处理的计算原则。

1985年,欣顿(Hinton)和塞杰诺斯基(Sejnowsky) 提出了一个可行的算法,称为玻耳兹曼(Boltzmann) 机模型。他们借用了统计物理学的概念和方法,首次提出了多层网络的学习算法。1986年,鲁梅尔哈特(Rumelhart) 和 麦克莱伦德(McClelland) 等人提出并行分布处理(Parallel Distributed Processing, 简称PDP) 的理论。一群神经科学和认知科学家意识到,他们的研究属于平行分布式处理(PDP)。

当时,大多数的人工智能研究都集中在基于序列计算建立逻辑处理系统,这一概念部分是受到这样一种思路的启发——人类的智能包含了对符号表征的处理。但是,在有一些领域,越来越多的人意识到,纯粹的符号方法可能过于脆弱,并且在解决人类习以为常的现实问题时,可能不够灵活。取而代之的是,关于大脑基础知识的不断增加,指出了一个非常不一样的方向,强调动态和高度平行信息处理的重要性。基于此,PDP兴起提出了一个思路:人类的认知和行为来自动态的、分布式交互,并且基于神经网络内单一类神经元的处理单元,通过学习进程来对交互进行调整,他们通过调整参数,以将误差最小化,将反馈最大化。在各个地方,神经科学为架构和算法的范围提供了初步指导,从而引导人工智能成功应用神经网络。

除了在深度学习发展中的神经科学发挥重要作用之外,神经科学还推动了强化学习(RL)的出现。强化学习方法解决了如何通过将环境中的状态映射到行动来最大化未来奖励的问题,并且是人工智能研究中使用最广泛的工具之一。深度 Q 网络(DQN)通过学习将图像像素的矢量转换为用于选择动作(例如操纵杆移动)的策略,在 Atari 2600 视频游戏中展现出专家级的水平。DQN 的一个关键因素是“体验重播”(experience replay),其中网络以基于实例的方式存储训练数据的一部分,然后“离线重播”,从过去新发现的成功或失败中学习。体验重播对于最大限度地提高数据效率至关重要,避免了从连续相关经验中学习的不稳定的影响,使网络即使在复杂、高度结构化的顺序环境中,也能学习可行的价值函数。

体验重播直接受理论的启发,这些理论旨在了解哺乳动物大脑中的多个记忆系统如何相互作用。动物的学习行为是由海马和新皮质中互补学习系统为基础。DQN 中的重播缓冲区可以被视为一个非常原始的海马,使计算机能够进行辅助学习,就像在生物大脑里发生的那样。后续工作表明,当具有高度奖励价值的事件重播被优先考虑时,DQN 中体验重播的好处得到了增长,正如海马重播似乎更偏好能够带来高水平强化的事件一样。

存储在内存缓冲区中的体验不仅可以用于逐渐将深度网络的参数调整为最佳策略(就像在 DQN 中那样),还可以根据个人经验支持快速的行为变化。事实上,理论神经科学已经证明了情景控制的潜在好处,在生物大脑的海马中,奖励动作序列能够在内部从快速可更新的记忆库中被重新激活。此外,当获得的环境经验有限时,情景控制特别优于其他的学习机制。最近的人工智能 研究已经吸取了这些想法来克服深度强化学习网络学习慢的特性,开发了实现情景控制的架构。这些网络存储特定的体验,并且基于当前情况输入和存储在存储器中的先前事件之间的相似性来选择新的动作,考虑与之前的事件相关联的奖励。

智能科学是由脑科学、认知科学、人工智能等构建的前沿交叉学科,研究智能的基本理论和实现技术。脑科学从分子水平、细胞水平、行为水平研究人脑智能机理,建立脑模型,揭示人脑的本质。认知科学是研究人类感知、学习、记忆、思维、意识等人脑心智活动过程的科学。人工智能研究用人工的方法和技术,模仿、延伸和扩展人的智能, 实现机器智能。智能科学是实现人类水平的人工智能的重要途径,引领新一代人工智能的发展。

-

人工智能

+关注

关注

1799文章

48047浏览量

241946 -

机器学习

+关注

关注

66文章

8459浏览量

133371

原文标题:基础理论研究是人工智能持续发展的保证

文章出处:【微信号:AItists,微信公众号:人工智能学家】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

安科瑞:以综合能效管理解决方案,赋能人工智能时代的数据中心可持续发展

嵌入式和人工智能究竟是什么关系?

智慧城市在可持续发展中的应用

《AI for Science:人工智能驱动科学创新》第6章人AI与能源科学读后感

AI for Science:人工智能驱动科学创新》第4章-AI与生命科学读后感

《AI for Science:人工智能驱动科学创新》第一章人工智能驱动的科学创新学习心得

risc-v在人工智能图像处理应用前景分析

简述边缘计算的持续发展

名单公布!【书籍评测活动NO.44】AI for Science:人工智能驱动科学创新

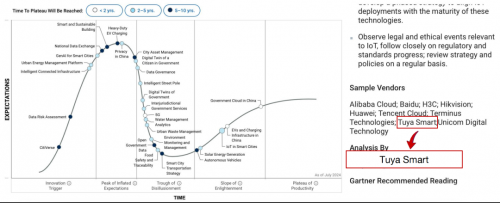

持续领跑 涂鸦智能再度入围Gartner《 中国智慧城市和可持续发展技术成熟度曲线》报告

FPGA在人工智能中的应用有哪些?

COP28主席呼吁全球努力利用人工智能的崛起、能源转型和全球南方的增长,加速所有人的可持续发展

首届"人工智能与可持续发展国际论坛"在京成功召开

人工智能如何才能持续发展?

人工智能如何才能持续发展?

评论