上个月,《哈佛商业评论》发表了一篇名为Want Less-Biased Decisions? Use Algorithms的文章,作者为Alex P. Miller。文中表示,虽然目前AI算法存在偏见,但是技术的进步如果有助于提高系统性能,这也是很重要的。即使有了偏见,也比人类的偏见小得多。

针对这篇文章,fast.ai的创始人之一Rachel Thomas有不同的看法。她认为算法偏见的影响实际上深远得多,我们关注的重点应该是如何解决这一问题。以下是论智对原文的编译:

最近,《哈佛商业评论》刊登了一篇文章,讲的是人类总是作出有偏见的决定(这确实没错),但文章忽视了许多相关问题,包括:

算法的实现通常没有适当的方法(因为很多人误解算法是客观、精准并且不会犯错的)

在很多情况下,算法的使用比人类决策规模大得多,所以也会产生和人类相同的偏见(通常是由于算法使用成本低)

算法的使用者也许不了解概率或置信区间(即使这些都已经标明了),而且如果让他们重写算法也会很困难

与其关注微不足道的选择,更重要的是思考怎样才能创造偏见更少的决策工具。

在《哈佛商业评论》的文章中,作者Miller认为,“算法革命”的批评者们担心“算法在运用时会不透明、带有偏见,成为无法解释的工具”,但是在文章中,他只针对“偏见”展开解释,对“不透明”和“无法解释”的特征没有解释。

人机结合才能真正进步

媒体总是通过人类和机器的对比来显示AI的进步,我们总是看到这样的标题:“在XX比赛中,机器战胜了人类”。如果考虑到大多数算法的使用方法,这种对比也是不准确的,这样评价AI也是非常狭隘的。在所有案例中,算法都有人类因素存在,尤其是数据的收集、决策的制定、实现方式、对结果的解读以及不同参与者的不同理解等方面,都会受人类的影响。

很多致力于研究医学领域AI产品的人并不打算用AI替代人类,他们只是在创造能够帮助医生做出更精确更高效的决策,从而提高医疗质量。能做到最佳水平的不是人类也不是电脑,而是二者的结合。

Miller在他的文章中指出,人类带有非常多的偏见,然后对比了目前的几种方法,来比较哪种更加糟糕。但是文章并未提出有什么方法可以让偏见更少,从而做出决策呢(也许用人类和算法的结合)?总之这才是更值得考虑的、重要的问题。

算法的使用通常和人类决策方式不同

算法在实际中运用范围很广,也因此会出现很多相同的偏见,甚至被认为是正确或客观的结果。Miller在文章中分享的研究将它们进行比较时,并没有发现实际使用中的区别。

Cathy O’Neil在Weapons of Math Destruction一书中写道,她所批评的那类算法对穷人更不友好。

这些算法专注于处理大型任务,并且使用成本低,这也是吸引人的部分原因。相反,富裕的人通常会选择个人定制的输入。大型公司或者贵族预科学校通常更倾向于内部推荐或者面对面的面试。有特权的人通常会由人来选拔,而普通人才靠机器选拔。

O’Neil书中的一个例子是有一位患有双向情感障碍的大学生想在暑假时在便利店打工。他应聘的每家店都用相同的心理测量软件来对面试者打分,所以每家店都拒绝了他。这表明了算法的另一个危险之处,虽然人类通常会有相似的偏见,但并不是每个人都会做出同样的决定。虽然他有精神障碍,但这位大学生也许最终会找到一个愿意雇用他的店。

很多人更愿意相信算法做出的决策,而不愿意相信人类的决定。而设计算法的研究者们可能对概率和置信区间有更好的了解,而一般人不会注意到这一点。

算法需要被解释

很多关于算法偏见的案例都没有有意义的解释或者有意义的处理过程。这看起来似乎是算法决策过程中的特殊趋势,也许是因为人们错误地认为算法就是客观的,所以没有必要进行客观分析。同时,如上面所解释的,算法决策系统通常是为了削减成本,重复检查就会增加成本。

Cathy O’Neil还写道一位老师非常受学生和家长的爱戴,但是莫名其妙就被算法开除了。她永远不会知道为什么会有这样的结果。如果我们能重新对算法进行检查或者了解其中的因素,就不会令人如此费解。

The Verge曾调查美国超过一半的州所使用的软件,统计人们接收到的医疗健康服务。当这种软件在阿肯色州使用后,很多有严重残疾的人们发现他们的医疗补助突然被大幅减少。例如,一位脑瘫患者Tammy Dobbs原本需要每天有人帮助她下床、去卫生间、吃饭等等,突然算法将医疗救助时间减少到了每周20个小时。她无法解释为什么会这样。最终,法院调查后发现是软件的算法出现了错误,影响了患有糖尿病或脑瘫的患者。然而,像Dobbs这样的很多人还是会担心某一天他们的医疗补助是否会再次被削减。

算法的创建者被问到能否有交流决策的方法,他说:“也许这是我们的责任。”但之后又称,这可能是其他人的原因。我们不能认为自己造出来的成果是别人的责任。

另一个在科罗拉多州使用的系统发现了系统中有超过900个错误规则,结果导致了很多问题,例如将怀孕的女性不算入需要医疗补助的计划之内。律师们很难发现算法中的错误,因为这些内部工作机制就像商业秘密一样受保护。所以,重要的是要创建一个能轻松发现错误的机制。

复杂的真实系统

当我们谈到AI,就需要想想现实世界中复杂的系统。《哈佛商业评论》中所提到的研究将决策看成孤立的行为,并没有考虑所处的环境。判断一个人是否会坦白其他罪行,这种决定并不是单独做出的,它还要结合复杂的法律系统。我们有必要了解研究领域所处的真实环境是如何运作的,同时不要忽略了可能受到影响的人们。

美国法庭中所用到的COMPAS算法是用在预审前保释、判刑和假释中的决策系统。ProPublica调查后发现,白人被告者的结果误报率是24%,而黑人被告的误报率高达45%(即被告被系统认定为“高风险”但结果却并未再次入狱)。之后的研究发现,COMPAS还不如一个简单的线性方程精确。

通过这些案例可以看出,算法也许会加剧潜在的社会问题。所以我们有责任了解系统以及它们可能带来的问题。

反偏见不等于反算法

大多数对算法偏见持反对意见的人,都会反对不公平的偏见,但他们不是讨厌算法的人。Miller表示,这些批评者“很少会问这些系统在没有算法的情况下运行得怎样”,这表明那些反对偏见算法的人可能并不知道人类有多少偏见,或者可能只是不喜欢算法。在我开始撰写有关机器学习偏见的文章之前,我花了大量时间研究和撰写有关人类的偏见。

当我发布或分享有关偏见的算法时,总有人认为我是反算法或者反科技的。而且我不是唯一受到质疑的人。所以我希望有关偏见算法的讨论重点不要仅仅局限于这种微不足道的地方,我们需要深入解决这个问题。

-

算法

+关注

关注

23文章

4666浏览量

94171 -

AI

+关注

关注

87文章

33169浏览量

273412 -

机器

+关注

关注

0文章

788浏览量

41023

原文标题:fast.ai创始人质疑《哈佛商业评论》文章:算法偏见的影响很严重!

文章出处:【微信号:jqr_AI,微信公众号:论智】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

高效的物联网——人类进步的动力

粒子群算法对决策变量和适应度函数的约束问题

机器能超越真正的人类吗?人工智能未来发展如何?

自动驾驶的目标:比最好的人类司机更快更及时地作出决策

掌握逆变电源的原理和运行方式

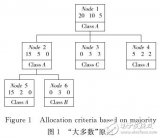

基于粗决策树的动态规则提取算法

AI+教育究竟该如何落地才能真正促进教育行业的进步?

真正的自动驾驶何时才能到来

人工智能技术使智能机器能够“思考”只有人类才能做到的方式行动

ADAS是否能取代人类决策?

基于智能决策理论的无人机集群认知干扰算法

人机结合才能真正进步!算法的使用通常和人类决策方式不同

人机结合才能真正进步!算法的使用通常和人类决策方式不同

评论