编者按:近日,影视后期特效网站FXGuide在文章中介绍了一种用机器学习进行3D实时渲染的新方法,在手机中安装相关软件后,用户可以实现脸部即时卡通化,或是把自己的动态表情转移到别人的脸上。这项技术来自AI创企Pinscreen,但不久前,它的首席执行官/联合创始人却陷入了一场颇为轰动的学术丑闻……

SIGGRAPH是计算图形学的年度顶级会议,发展至今,它已经成为全球最负盛名的的CG展示、学术研讨会——除了论文展示环节,以电影、游戏为代表的工业界也会争相展示最新技术,比如今年与会的暴雪娱乐和皮克斯,可想而知,它的热闹程度完全不亚于任何大型博览会。

今年的SIGGRAPH将在8月12日召开,为期5天。作为计算图形学最重要的会议,随着近年来AI热度的不断上升,和计算机视觉一样,SIGGRAPH的机器学习论文占比也屡破新高,这片图形学的圣域大有“沦陷”趋势。

而Pinscreen将在Real Time Live活动中展示的正是一项机器学习成果:paGAN。

学术造假丑闻

说到这家公司,就不得不提它的首席执行官/联合创始人——黎颢。这是个在南加州大学任教的华人教授,他是SIGGRAPH的常客,也曾被微软学术搜索评为“过去5年计算机图形学领域十大影响力学者”,在业内有相当的知名度和威望。

黎颢

但二十几天前,他的前雇员Iman Sadeghi博士却向他发起指控。在递交给法院的报告中,Iman Sadeghi列出了黎颢的几大罪状:1)用人工绘制图像假冒AI作品,并在SIGGRAPH上展示“成果”;2)用技术“成果”欺骗投资人;3)恶意解雇并殴打Sadeghi博士。

这个消息立即在学界引起轩然大波,毕竟如此恶劣的学术不端行为还是很少见的。但随着舆论持续发酵,一些关于Sadeghi博士的负面消息也出现了:1)入职后基本不工作,老是不见人影;2)试图抢夺公司财产,删除重要数据;3)殴打劝阻的女员工。

当然,以上只是他们的一面之词,最终结果还是要交给加州法院定夺。作为旁观者,我们无需也无法作出判断。综观此次Pinscreen的展示内容预告,我们发现它和诉讼报告中提到的很不一样,所以觉得有介绍的必要。至于这个成果是不是“造假”得来的,还有待时间检验。

用paGAN实现3D实时渲染

在介绍技术前,我们先来看看paGAN的具体效果。

下图的左侧是FXGuide编辑Mike Seymour用iPhone拍摄的源视频,右侧是实时渲染CGI。可以发现,Pinscreen的成果确实可以在同一源视频上进行数字化构图,为真实人脸生成3D数字掩模。除了混合边缘上的小调整,整个过程已经基本实现自动化。

在渲染过程中,皱纹等细节的处理通常比较困难。如上图所示,虽然软件没能准确重现每一条皱纹及其深浅程度,但右图中的皱纹还是非常连贯,没有出现参差错落的情况。根据Pinscreen的说法,这些都是自动生成的。

上图是Sadeghi博士在诉讼报告中展示的学术造假示例。据网友实验,Pinscreen当前版本的APP在处理肩部以下头发时效果很差,对比Haley Dunphy那一头金发(这是2017年提交给SIGGRAPH的成果),因此很多人认为他提出的“头发为人工制作”的说法是可信的。

但去年这个效果似乎和Mike Seymour的最新实验有很大差距,具体我们可以等新版软件发布再去验证。

1. 用单张jpeg构建面部

如果要生成卡通化的3D人脸,首先我们要构建3D模型。Pinscreen现在使用的技术是基于单张Jpeg图像构建3D脸部模型,具体方法是靠“猜”,也就是先制作合理的3D网格,然后对输入图像和3D形状执行形状匹配和角度变换。

事实上,除了Pinscreen,其他公司也用机器学习实现了这一技术,它们的商业模式也基于这种创新。但Pinscreen的优势是处理效果更好,目标更长远——开发直接面向用户的端到端解决方案。

2. 每秒1000帧的脸部跟踪

获得模型后,下一步就是追踪人脸位置和细节状态,保证模型的实时更新。据介绍,目前Pinscreen开发的最强大的脸部追踪器是VGPT(Veli Goodo Pace Tracka),这也是他们即将在SIGGRAPH上实时演示的重要内容。

VGPY是一个基于深度学习的轻量级网络,本身只有5M。不同于传统追踪器,它既不追踪特征,也不追踪标记,而是基于直接推断。具体而言,人类的脸部大同小异,以往我们使用的方法是在上面标记一些关键特征点,然后在统计的基础上利用特征点来定位对齐。但根据黎颢介绍,VGPY使用的是3D高精度头部模型、微表情测量工具FACS等工具,速度比AAM算法快很多。

这个追踪器的速度也十分惊人。如果是在显卡为1080P的PC上,VGPY的帧数高达1000;如果是在手机上,它的速度也有60到90 fps。虽然是快速无标记追踪,但VGPY可以始终保持高性能和高稳健性。当追踪对象经过遮挡物时,它会在短时间内重新获取面部并继续工作。

3D人脸是左侧图像的,但脸部的动态是黎颢的(6个月前的成果)

3. paGAN

paGAN的全称是Photoreal Avatar Generative Adversarial Network,它充当整个系统中的“渲染器”。

渲染通常是绘图的最后一步。就目前的传统方法来看,如果我们要对头像或人进行建模、添加纹理、调节明暗和图像渲染,大量高质量数据是必须的。这通常意味着准备多幅图像,测量各个角度,进行高质量扫描,等到一切都准备好,我们才能在3D网格上添加各种纹理、凹凸贴图,镜面反射贴图等。除了着色器,我们还需要一个高质量渲染算法。

虽然进程安排存在先后,但上述内容都息息相关,而现实中承担这些工作的通常是经验丰富的工作人员和艺术家。这也意味着谁投入资源多,谁就做得好,这种由技术门槛带来的不公平给电影、游戏工业带去了不少困扰。

为了解决这个问题,Pinscreen团队跳过传统方法,他们采取的第一种做法是不使用建模/纹理/照明和渲染管道,而是如下图所示,直接将面部采样点重新上色、复原、旋转并放置在模拟的3D环境中,就像3D CGI头一样。

但这种方法失败了,因为复原的头像无法正确定位,也不能完全动画化。由于实际上只是把照片投影在匹配的几何体上,它只能在静态时实现高保真。

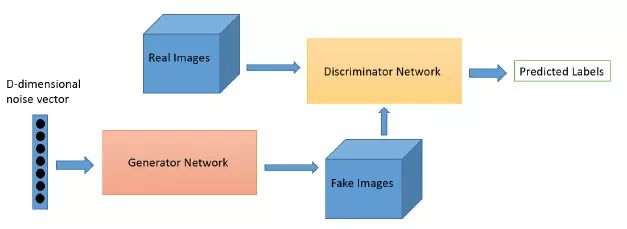

经历了失败后,Pinscreen把目光转向最先进的深度生成模型——GAN。这是一种非常特殊的深度学习网络,它已经被证明能生成逼真的2D图像。黎颢和他的团队希望能用GAN代替传统做法,实现正确角度“渲染”。

GAN是Ian Goofellow于2014年提出的一种神经网络,它包含一个生成器G和一个判定器D。其中G从潜在空间随机采样,把采样得到的样本作为输入,目标是输出类似真实数据的数据;而D的输入是G的输出,它负责鉴定这个生成的伪数据和真实数据像不像,然后把分类结果馈送给G,让它积累“作假”经验。

当用于面部时,原始GAN的问题在于输出的是个2D图像,而且非常难控制。最后,Pinscreen团队做出了取舍,他们为paGAN制定的目标是生成高度逼真的眼部和嘴部渲染。而根据最终结果,GAN确实在嘴部运动和舌头运动上表现出色。

4. 重新定位

之前提到了,Pinscreen的3D脸部模型来自单张jepg,而它的表情则完全来自另一人,所以最后生成的表情动画不会和jepg有什么外观上的出入,十分自然,十分逼真。

如上图所示,第一行是建模的图像,第一列是表情来源,中间生成的表情都很自然。这里需要注意一点,Pinscreen的人脸追踪器VGPY只检测了图中亚洲男子的微表情,它没有对静态图像jepg做任何扫描,这意味着这些富有表现力的表情都是直接从表情源直接转移到目标人脸上的。

其他细节

除了上文提到的内容,黎颢也用自己积累的经验做了不少优化工作,比如paGAN面不仅能够从任何角度“渲染”,也能根据所需的环境明暗条件进行渲染。

提起诉讼的Sadeghi博士是毛发渲染领域的专家,但如果本文演示图片属实,那么在他离职后,Pinscreen确实在头发上也进步明显。而根据黎颢的说法,他的团队这次使用的是一个端到端的神经网络新系统,可以始终根据训练数据生成合理的头发模型。

看到这里,相信很多人已经开始期待他们的新版APP。但大家请注意,以上图像都是在PC上生成的,如果是手机,效果会差那么一点儿。

这是软件在手机上的效果,考虑到硬件差距,这个效果其实完全可以接受。

生成3D手机视频聊天头像

具体效果

而开发了这项技术后,Pinscreen首先瞄准的目标是实现3D视频通讯。黎颢认为,现如今3D游戏越来越多,而人们在其中扮演的也都是3D的角色,这说明3D是发展趋势。未来,当技术发展得足够成熟后,也许打开手机,我们面对不再是一个2D小人,而是一个立体化的真人形象。

-

自动化

+关注

关注

29文章

5562浏览量

79239 -

计算机视觉

+关注

关注

8文章

1698浏览量

45970 -

机器学习

+关注

关注

66文章

8406浏览量

132557

原文标题:深陷官司丑闻,这个华人创业者要在SIGGRAPH上展示什么?

文章出处:【微信号:jqr_AI,微信公众号:论智】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

一种用机器学习进行3D实时渲染的新方法:用paGAN实现3D实时渲染

一种用机器学习进行3D实时渲染的新方法:用paGAN实现3D实时渲染

评论