如今有一种观点认为,GPU并非为深度学习而生,只是恰好并行计算满足大数据处理需求而已。那么,GPU会在深度学习领域失宠吗?NVIDIA全球副总裁、中国区总经理张建中在AI WORLD 2018世界人工智能峰会分享以《AI与自动驾驶》为主题的演讲时表示:GPU是做AI和深度学习最好的架构,它已不再只是单纯的图像处理器。张建中认为,在很多场景下,AI应用需要高精确度的推理平台,尤其是在自动驾驶场景下。

近年来,深度学习在很多行业得以广泛应用,这很大程度上得益于神经网络和硬件的飞速发展。

如今存在着这样一种论调:GPU并非为深度学习而生,只是恰好并行计算满足大数据处理需求而已。那么,GPU会在深度学习领域失宠吗?

9月20日,NVIDIA全球副总裁、中国区总经理张建中在AI WORLD 2018世界人工智能峰会上谈到了这一问题,他表示:GPU是做AI和深度学习最好的架构。从摩尔定律到AI摩尔定律,计算力为人工智能的飞速发展提供了强大支撑。

张建中说:“如果我们看今天的GPU,实际上它已经不再是传统的图形处理器了,而在图灵最新的技术当中,里面已经集成了很多不同的核心处理器。”

张建中以自动驾驶为例,着重介绍了GPU在推理(Inference)情况下的应用。NVIDIA不久前在日本GTC发布的AGX,可以作为极小的单芯片Xavier对接自动驾驶汽车的各种不同接口,也可以用两个Xavier芯片加上两个GPU(名为Drive Pegasus),用在L3~L5等不同的自动驾驶场景中。张建中提到很多人以为推理的模型是越小越好,对精确度的要求并不高。而事实上,AI的应用,尤其是在自动驾驶场景下,需要保证其推理平台的精确度越高越好,端侧推理也需要强大的计算平台。

国际AI企业TOP10:Amazon、Google、Microsoft、Apple、Facebook、DeepMind、NVIDIA、IBM、Boston Dynamics、Waymo

AI WORLD 2018世界人工智能峰会重磅发布了AI领域年度大奖——AI Era创新大奖,NVIDIA Drive Xavier成功入围「AI产品影响力TOP10」。NVIDIA凭借领先的技术成功登榜「国际AI企业TOP10」,NVIDIA联合创始人兼CEO黄仁勋也被评选为「华人AI人物TOP10」。

AI华人影响力TOP10:陈天石、胡郁、黄仁勋、李飞飞、刘庆峰、王海峰、王小川、吴恩达、颜水成、余凯

AI产品影响力TOP10:寒武纪智能芯片MLU100、华为麒麟980、旷视Brain++、讯飞翻译机2.0、百度Apollo3.0、阿里云ET城市大脑、英伟达Drive Xavier、百度大脑3.0、浪潮AI服务器、阿里量子计算云平台

NVIDIA全球副总裁、中国区总经理张建中也在此次峰会上分享了以《AI与自动驾驶》为主题的演讲,让人们看到更全面的英伟达,以下为演讲的主要内容:

张建中:尊敬的各位来宾,大家上午好!NVIDIA是一家AI Computing Company,过去我们每天的工作都在不停进步,把AI的基础架构和在每一个不同深度学习的模型架构(Framework)的加速作为我们的研究方向。

我相信如果你们参加我们的GTC( GPU Technology Conference,GPU 技术大会))就会发现,在过去的几年中,摩尔定律的发明者所讲述的CPU计算性能,随着每年每隔一代的制程,加上CPU的研发性能都在不停地提升,但随着最近几年的变化,摩尔定律遇到了一定的难度,因为物理极限导致CPU的性能无法像以前那么快地飞速成长。

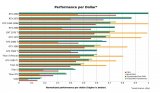

当然,在计算的过程中,我们发现浮点计算以及并行计算领域,GPU的性能还是能够保持持续的增长,其中的主要原因并不是由于制程的变化,大部分计算性能的提升是来自于几个方面的结果:首先要有一个很好的架构(Architecture),要把并行计算的架构设计能够适应新的计算的需要。其次,还要有一个很好的软件支持,这种Software SDK支持并行计算的速度成长,对整体GPU性能的提升是非常重要的。当然还涉及很多的应用层面,所以从SDK到芯片再到应用层面的结合,我们就可以看到GPU的性能在每一代的计算方面的提升是非常惊人的。

如果看一看过去每隔十年的发展,GPU本身的计算速度大概是呈现1000倍地成长,以这么快的成长速度才能支撑今天人工智能深度学习的计算力要求,也正是因为GPU计算力的提升,大概在今后的几年中,它的速度应该也会一直不停地增加。

GPU是做AI和深度学习最好的架构

近日,Jensen(黄仁勋)在日本GTC上了在推理(Inference)情况下,使用我们最新的架构图灵,这种GPU用在推理时,它的性能其实比帕斯卡架构提升差不多10倍数量级,这样的数量级在于图灵Architecture的变化。如果看这种AI Interflow Performance可以看到大概是260Tops,这样的速度可以帮助我们很快地、快速地处理大量人以前无法处理的信息,尤其是在、视频的管理、语音的翻译,大量的计算速度都可以在云端快速地透过T4帮助我们实现。

这个架构本身来自于新的架构(Architecture),有人说GPU是不是一个最好的架构来做AI呢?很多人都在争论这个问题,如果我们看今天的GPU,实际上它已经不再是传统的图形处理器了,而在图灵最新的技术当中,里面已经整合了多种不同的核心处理器,包括今天要跟大家分享的RTX。

RTX实现了在过去计算机图形当中最难做的一件事情,很多人以前在计算机图形领域的研究就会发现,RTX以前是要靠一个非常非常庞大的超级计算机帮助我们实现,但是如果要做到实时计算的话,工作量是巨大的。上次我们GTC Demo就实现了用实时去做光线追踪(Ray Tracing)的第一次成功,所用的正是NVIDIA的DGX,4个最新的处理器Volta架构实现实时光线追踪,但是用图灵架构的处理器就可以直接做到实时。这种RTX技术不光是帮助我们去做实时的光线追踪,同时可以去做很多AI的应用,其中包括里面集成的AI推理代码。

如果我们看整个RTX的重要性,可以发现其实RTX真正改变了我们今天所有的图形应用计算,今后你们所看到的电影没有必要再去等待很长时间去做后期的制作,导演用RTX就可以实时决定电影后期制作的效果,无需等待,以前的Rundown可以被一张显卡代替。当然,RTX带来的最大改变是内容制作的真实度,可以看到今后游戏行业的变化会是巨大的,如今的游戏在里面的每一桢画面要靠GPU做实时的渲染,但在今后可能不一定要再去靠GPU100%渲染,可以靠AI和光线追踪,得到的效果就会变成照片级的游戏画面效果,计算机制作的游戏和后期电影的效果和我们看到的每张大片都是一样的。

关于这些实时光线追踪达到的效果,可以看到无论是机理的表现方面,还是材质的反映方面都可以达到更加真实的性能。以前我们看到的材料,比如金属、皮质、木材,每种材料的表现是不一样的,今天在实时光线追踪的技术可以把这些材料通过技术描述出来,通过GPU渲染出想要的不同材质的效果。因为这是实时光线追踪,所有光线的阴影都是很Soft、很真实的。如果我们有机会去看RTX Demo的话,可以看到在多光源不同的环境下的渲染效果跟真实的场景是没有分别的。

当然,如果光线追踪带来的特效反映在不同的光影反射的情况中,其实在其它的方面可以增加更好的表现力,比如做人脸表情的模拟仿真,可以把它变得更加真实,例如,3D作出的人脸表情的模仿,和真人的效果基本上没有差别。

AI应用需要高精确度的推理平台

单看GPU的计算力在不同场景下的应用,实际上给我们带来的变化远远不止在服务器端。AI最大的应用其实是在两端的:一是训练,二是推理。既然有强大的计算力把训练的模型建好,那么在推理这一端是不是要强大的计算力平台让它去包括呢?

其实答案是肯定的,很多人以为推理的模型是越小越好,但是在很多的场景下面、很多的环境下,AI的应用要保证它的精确度越高越好,尤其是在自动驾驶场景下,安全几乎已经成为所有人关心的第一大问题。既然是这样,怎么提高它的安全性呢?除了此前周志华教授介绍的各种不同鲁棒性的研发之外,我们还可以建立很好的模型,但归根结底还是要有一个很强大的计算平台迅速地把你的结果算出来。

要想建立一个很强大的,或者是人工智能推理平台,NVIDIA推出的AGX芯片就是一个SoC,但是可以做到有强大的计算能力,最高可以达到300个Tops,所以可以看到AI推理速度有多快。如果只看这个芯片本身,可以看到它不只是一颗CPU,当然也不只是一颗GPU,里面有8个核心的CPU处理能力,同时里面还有视频处理器、图像处理器,接入各种不同的传感器,可以支持所有工业级的不同接口。

如果我们来看这个系统芯片,它的应用能力基本上可以应用在各种不同的机器自动应用产品,英伟达也在日本发布了NVIDIA AGX,AGX是专门用来处理自动智能工具的一个嵌入式(Embedded)平台,基本上可以变成单片应用或者是双片应用,加上一个独立的GPU应用,所以应用场景会非常广泛,可以看到AGX是一个非常小的单芯片接上汽车的自动驾驶各种不同的接口,也可以是双芯片独立的GPU,我们把它叫做 Drive Pegasus,可以在不同的场景使用,包括汽车驾驶的Level3,甚至Level5,也可以应用在其它不同的机器人场景当中。

如果我们看一看两种不同的应用场景,我们相信凡是能够运动或者移动的物体今后都将是智能化的,任何一部车无论是轿车、卡车、运货的小车,或者是农用的机械工具等等都可以使用AGX实现自动化。

NVIDIA推出汽车自动驾驶测试仿真系统,仿真成为重要一环

除了硬件本身的计算平台之外,它是不够的,怎样赋能一个100%或者能够全智能化的机器人?我们要给它提供一整套的软件,NVIDIA基本上把整个的定位、感知、决策和各种不同的传感器接口都设计得很好,所以我们有软件接口、硬件接口,软件架构方面NVIDIA可以提供所有的Drive全套的N2N Software集成。

所有的这些智能机器人当中,最核心的模块就是今后很多公司花了很多时间研发的感知系统,这种感知系统的研发核心的装置或者核心的系统还是要设计N2N的感知系统基础架构。首先要有一个很好的、很强大数据能力的数据中心,其中必须要有足够强大的计算力处理感知、前端、收集各种不同的标注数据,把这些数据在数据中心进行处理以后才可以得到想要的模型,应用在我们各个不同的智能机器人里面。

今后如果我们去看整个自动驾驶的研发,比如测试自动驾驶的模型,仿真(Simulation)是很重要的一环。NVIDIA推出的汽车自动驾驶测试仿真系统(DRIVE Constellation),运行NVIDIA DRIVE Sim软件 ,可以测试汽车上路之前研发的各种不同的算法在计算机当中、在云端和在(Data Center)进行测试模拟。当然,模拟的环境和真实的环境一样,我们可以做到各种不同环境的模拟测试。当然,最后的感知效果是的可以看见的:在不同的气候和路况下都能够使用我们自动驾驶的算法。

一个好的自动驾驶环境当中,NVIDIA Drive考虑的是从数据的感知到本身平台的系统模拟,再到最后真正在汽车上实际运行的NVIDIA Drive我们都有N2N的解决方案。如果只是我们自己去研发肯定不能完善,或者不能很快地让自动驾驶的产品和技术上市,我们在全球有超过450家的合作伙伴,这些合作伙伴每一个都在用NVIDIA Drive平台,无论是大大小小的AGX平台或者是在NVIDIA Drive Software上进行自动驾驶的研发。我们也希望今年在中国的GTC上面能够展示我们在中国本土的自动驾驶研发方面的科研成果,欢迎大家到时候去苏州参观!

-

gpu

+关注

关注

28文章

4754浏览量

129100 -

大数据

+关注

关注

64文章

8899浏览量

137560 -

深度学习

+关注

关注

73文章

5508浏览量

121315

原文标题:GPU是做AI和深度学习最好的架构?端侧推理也需要强大的计算平台!

文章出处:【微信号:AI_era,微信公众号:新智元】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

相比GPU和GPP,FPGA是深度学习的未来?

FPGA在深度学习应用中或将取代GPU

新手小白怎么学GPU云服务器跑深度学习?

Nanopi深度学习之路(1)深度学习框架分析

深度学习框架TensorFlow&TensorFlow-GPU详解

Mali GPU支持tensorflow或者caffe等深度学习模型吗

什么是深度学习?使用FPGA进行深度学习的好处?

深度学习方案ASIC、FPGA、GPU比较 哪种更有潜力

基于深度学习的ADAS系统,是GPU的主力市场

深度学习如何挑选GPU?

GPU会在深度学习领域失宠吗?

GPU会在深度学习领域失宠吗?

评论