自然语言处理(NLP)是一门集语言学、计算机科学、人工智能于一体的科学,解决的是“让机器可以理解自然语言”——这一到目前为止都还只是人类独有的特权,因此被誉为人工智能皇冠上的明珠。

近日,采访到了 NLP 领域的华人新星——加州大学圣巴巴拉分校助理教授王威廉,向他请教了 NLP 领域最前沿的研究问题,以及 NLP 研究方向的一些建议。

关于王威廉:2009 年毕业于深圳大学,随后赴美留学,并先后在哥伦比亚大学和卡耐基梅隆大学获得硕士和博士学位。他的研究范围包括统计关系学习、信息提取、社交媒体、语音和视觉等等。2016 年博士毕业之后,王威廉加盟加州大学圣巴巴拉分校。如今,王威廉已经是该校 NLP 小组的负责人,同时也是计算机科学系的助理教授。近几年来,王威廉在一些重要的 NLP/AI/ ML 等会议和期刊上发表了 60 多篇论文,并多次获得知名学术会议的最佳论文奖及提名。

1)您现在的主要研究领域是什么?有哪些最新进展?

王威廉:我的主要研究领域现在有三个:自然语言处理、机器学习、人工智能。

在自然语言处理领域,我们实验室主要关注的方向是信息抽取,社交媒体,语音、语言处理,以及语言与视觉方面的研究;

在机器学习领域,我们比较关注的是强化学习、对抗学习以及深度学习技术的突破;

在人工智能总体领域,我们对知识的表示、推理、知识图谱非常关注。

我们最近的一些突破,比如发表在 EMNLP 2017 上 DeepPath 首先提出了用强化学习的方法去做知识图谱上的推断,这项工作取得了很大的关注。我们还有一些相关的工作,比如用变分推理的方法去进一步提高知识图谱路径找寻的效率。

此外,我们还有不少在语言与视觉方面的尝试,包括 video captioning,video storytelling,以及如何把深度强化学习技术与这些复杂的语言与视觉的技术相结合。我们尝试了逆向的强化学习,去学习生成文本描述的多样性,主动学习它的一些奖励函数。我们最近也做了一些 language grounding 的工作,比如教机器人根据语言与视觉的信息来完成路径的找寻,到达目的地。同时我们也在社交媒体领域做了不少关于假新闻、仇恨言论检测的工作。

2)NLP 领域目前有哪些突破?未来的研究难点有哪些?

王威廉:在 NLP 领域,实体标注等工作的结果都非常好了,基本上都超过 90% 的准确率。现在的一些工作,包括大家很关心的阅读理解,在 SQuAD 上面第一版的结果已经非常好了。在未来,我认为语言的生成还是一个很难的问题,就是如何去做一些可以控制的生成,如何保证语义的连贯性以及语法的正确性,这些都是在神经网络框架下难以做到的。

还有一个是推理的问题。我们如何进一步地在分类、在序列标注等任务的基础上设计一些算法以及机器学习的模型,然后让机器能够在一些复杂的任务上,尤其是一些推理的相关的任务上取得一些突破,这些还是相当难的问题。

3)NLP 领域里比较流行的 SQuAD 数据集的局限性在哪?NLP 领域需要怎样的数据集?以及怎样的评价标准?

王威廉:它的局限性有几个,第一是数据量还不大,第二是机器做阅读理解的时候其实并不需要完全理解这个问题,也不需要完全理解这个篇章,它可以用很简单的模式识别的方法去找 pattern。比如说这个问题里面的哪个词和篇章里面的哪个词比较匹配,然后来回答答案。所以它并不能真正地理解语言,不能很好地理解问题,遇到复杂的问题就回答不了。

NLP 领域需要更加复杂的数据集,比如说多个文本,需要在知识图谱里做一些推断,需要根据上下文不同的假设去做一些推测,这样的数据集可能会有更多的帮助。

评价标准是很多人在讨论的一个话题,像 BLEU 等已经用了一二十年了,它局限性非常大,比如说它不是通过语义的方法来做评价,而是是通过词之间的 overlap(重叠)做的一个评价标准,所以它不能代替人类的评价。

4)Salesforce 开发了一个针对十大自然语言常见任务(问答、机器翻译、摘要、自然语言推理、情感分析、语义角色标注、关系抽取、任务驱动多轮对话、数据库查询生成器和代词消解)通用模型 decaNLP,这种通用模型有哪些优缺点?

王威廉:个人认为多任务学习、是非常有意思的一个方向。你可以看一下 decaNLP 的单项结果,确实是比各个单项的 SOTA 还是有一些距离的。总体来说,这是非常有意思的一个研究方向,但是在实际应用中,每一个单项的成绩比单项的 SOTA 还是有不小的距离。

5)基于 Attention 的网络真的可以取代 RNN 及其变种吗?为什么?

王威廉:不一定。RNN 及其变种确实有一些优势,比如它能够把握 非常准确的本地语义关系,像LSTM 在 sequence tagging 等任务上还是能取得非常不错的结果。总体来说,Transformer 还是很有意思的研究角度,但是实际情况是,它并没有在除了机器翻译之外的 NLP 任务上面取得最好的结果。

6)强化学习和 GAN 现在非常热门,但在 NLP 任务中又有很多限制,面对这种现状,科研人员应该怎么做?

王威廉:我觉得首先你要搞清楚为什么要用强化学习。在我看来,强化学习在 NLP 中可以做三件事情。第一件事情,你可以用它去做 learning to search,learning to rank,然后用强化学习作为解决传统方法解决不了的问题的一种手段。第二件,我们发现在 reinforcedco-training 这个工作中,强化学习可以学习选择数据,然后我们可以用强化学习去做 denoiser(去噪)。此外,还可以用强化学习去优化 BLEU Score,ROUGE Score,我们最近发表在 ACL 2018 上的工作也有用逆向强化学习去学它的评价标准。总之,还是有不少值得研究的空间。

GAN 更是一个很有意思的方向。GAN 在 CV 领域取得了很好的结果,在 NLP 领域,由于语言是离散的,所以大家还在研究如何通过更好地设计对抗网络,让判别器可以去反向传播错误,从而更好地更新生成器。我们在负例生成与远程监督去噪上也做了一些尝试,包括今年的 KBGAN 和 DSGAN 。

总体来说,首先要搞清楚你为什么要做这个事情?你到底要做什么事情?强化学习跟 GAN 适不适合这个任务?搞清楚了这几点,然后才有可能使得你的 NLP 的结果得到提升。如果搞不清楚就盲目应用 GAN 和强化学习,是是很难在你的任务中取得很好的结果的。

7)对于科研人员来说,NLP 里哪些研究方向更容易取得突破?

王威廉:自然语言研究有两块,一个是生成,一个是理解。生成和理解这两块其实都非常重要,比较难说哪一块更容易取得突破。

但是生成的任务肯定是非常难的,因为首先词汇量是无穷无尽的,然后 latent space 和词的映射关系也是非常难做的,所以生成会是比较难一点。

至于理解任务,要看你做到哪一步了。如果你是做文本分类这些简单一点的 任务,当然也有难一点的,比如说结构化预测,sequence tagging 会更难一点,那最难的可能就是比如说句法树的生成,比如依存句法分析或者是语义分析。

8)面对目前 NLP 领域的研究困境,以往我们会在数据、ML 或 DL 等方法上做创新或改变,现在是否依然是这个思路?是否需要懂得语言学知识或者融合其他学科知识?

王威廉:在早些年,大家做 NLP 研究可能是研究计算语言学,就是怎样用计算的方法去更好地理解语言学。现在基本上已经变了,过去 10-15年,NLP 基本上是计算机科学家为主,他们可能会关心一些更加实用的任务,比如说机器翻译,对话系统。大家可以看到,很多的 NAACL 、EMNLP 论文,往往是在数据、任务或者是机器学习的方法上做一些创新。

这其实也跟计算机学科有关,因为计算机学科本身喜欢在算法层面上做创新。至于需不需要语言学知识?在深度学习之前,大家觉得是需要的,有了深度学习之后,大家觉得可能不需要。但是现在大家又发现,像 Seq2Seq 模型的结果非常差,语义连贯性、语法正确性也都没有保证,而大家又想把结构融合到深度学习模型里。所以我个人认为还是需要掌握一些语言学知识,至少对你学习和研究的语言要有一些基本的知识,而其他学科的知识,根据你不同的应用也是非常重要的。比如说你做计算社会科学,你当然是需要知道一些社会科学,包括心理学、社会学一些相关的知识,然后才能更好地让你的研究取得突破。

9)近几年中国在 NLP 领域的发展状况?

王威廉:最近几年中国在 NLP 领域的发展是非常迅猛的,主要体现在下以下几个方面。第一,大家可以看到,在 NLP领域的 ACL、NAACL、EMNLP 这三大会议上,中国人基本上已经撑起了半边天。现在有一半的论文至少都是来自于国内的高校,然如果看第一作者,华人作者的比例可能会更高。国内工业界的发展也非常迅猛,尤其在自然语言处理领域。另外,现在国内是百花齐放,不光是传统的清华、北大、中科院、哈工大,很多其他的学校都陆陆续续有很多的优秀的教授以及一些非常优秀的研究。相比美国,中国的增速肯定是快很多的。总体来说,中美已经是 NLP 领域的两个强国了,接下来就希望更多的中国论文能够获得最佳论文奖。

10)中文 NLP 和英文 NLP 的区别在哪?

王威廉:中文 NLP 难点在于它的处理单元不是词,而是字符。不管是做强化学习,还是做 Seq2Seq ,在词级别来做和字符级别还是差很远的。如果是做字符级别的话,你的 sequence 可能会变得非常长,并不太容易做。所以中文的挑战在于语言本身比较难。除了汉语,也有其他少数民族的语言非常值得关注和留意。

-

人工智能

+关注

关注

1791文章

46881浏览量

237619 -

机器学习

+关注

关注

66文章

8381浏览量

132428 -

nlp

+关注

关注

1文章

487浏览量

22015

原文标题:专访王威廉:NLP哪些研究方向更容易取得突破?

文章出处:【微信号:rgznai100,微信公众号:rgznai100】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

NLP技术在人工智能领域的重要性

一款柔软且高度可拉伸的电子设备诞生

南加州大学研发AI系统:智能药丸助力家庭肠道健康监测

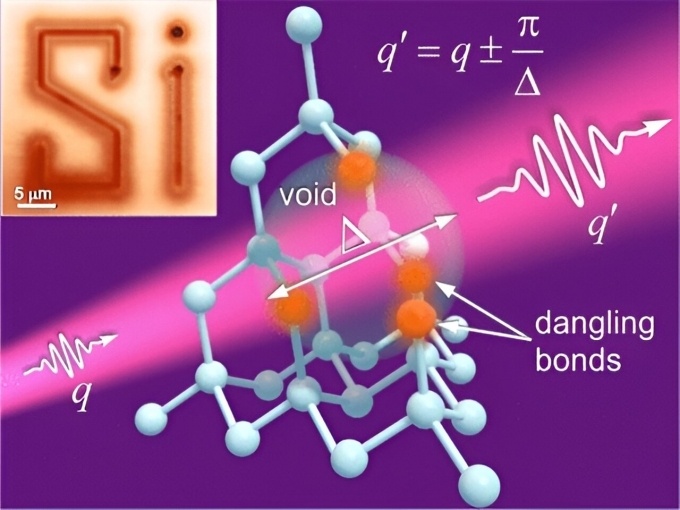

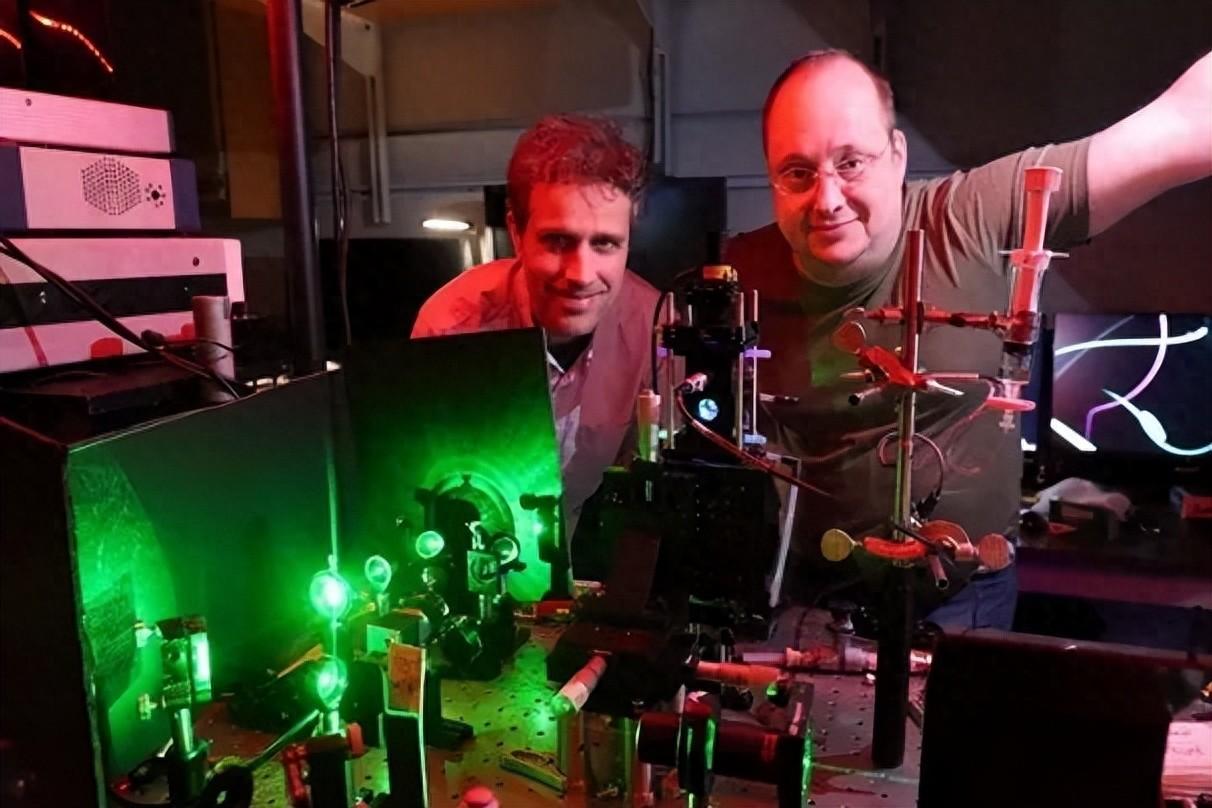

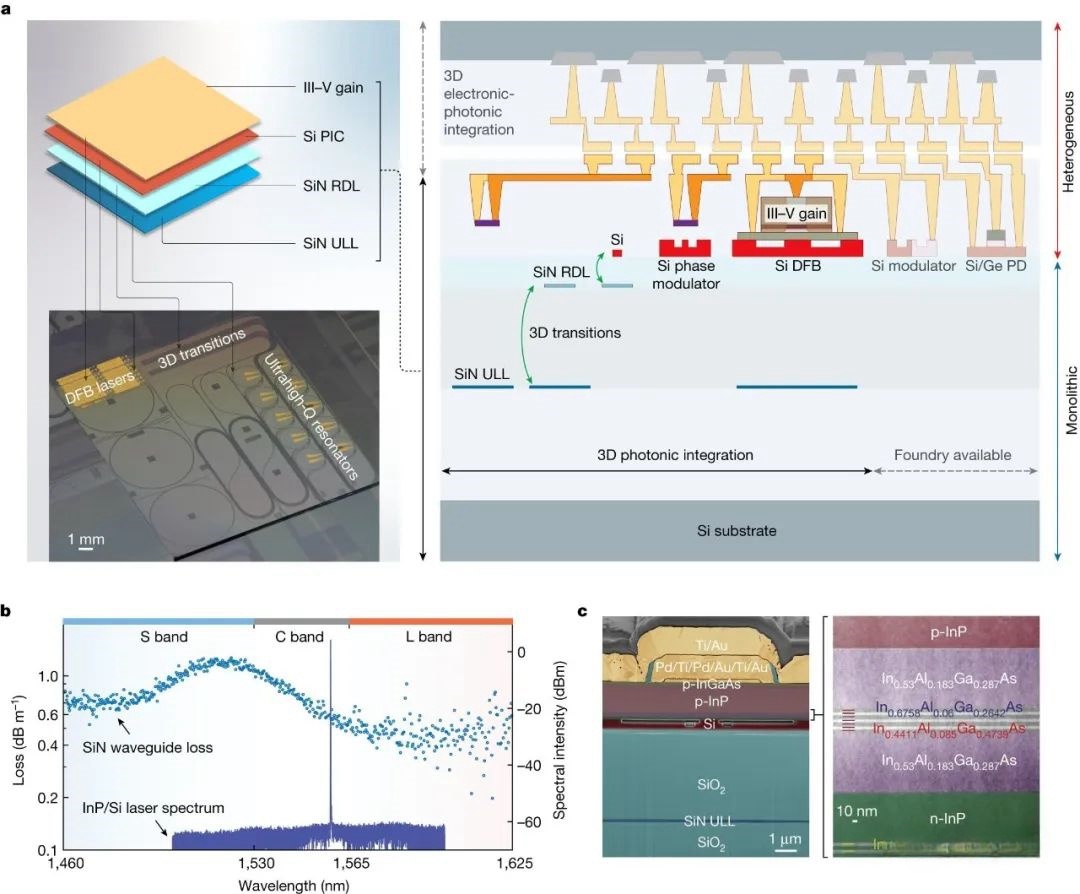

研究团队发现光的新特性

教授们为适应生成式AI改写编程教学,注重代码测试与调试

研究人员开发出新型AI辅助发音系统,让人没有声带也能说话

一种有效降低损耗的压电式DC-DC转换器开发案例

美国加州大学河滨分校教授引领计算机体系结构范式变革

2024年人工智能在职场发展的五大趋势

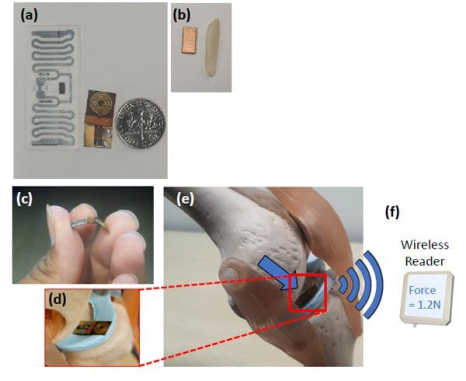

加州大学研发出RFID测力“贴纸”,重新定义精准测量

名单公布!【书籍评测活动NO.26】图灵奖得主亲自撰写!RISC-V开放架构设计之道

基于汗液的非侵入式血糖监测公司Persperion获400万美元种子轮投资

专访NLP领域的华人新星——加州大学圣巴巴拉分校助理教授王威廉

专访NLP领域的华人新星——加州大学圣巴巴拉分校助理教授王威廉

评论