- Load:0 second

- Duration:0 second

- Size:0x0

- Volume:0%

- Fps:60fps

- Sudio decoded:0 Byte

- Video decoded:0 Byte

HBM高带宽内存是什么

高带宽存储器(High Bandwidth Memory,HBM)是超微半导体和SK Hynix发起的一种基于3D堆栈工艺的高性能DRAM,适用于高存储器带宽需求的应用场合,像是图形处理器、网络交换及转发设备(如路由器、交换器)等。首个使用HBM的设备是AMD Radeon Fury系列显示核心。2013年10月HBM成为了JEDEC通过的工业标准,第二代HBM —— HBM2,也于2016年1月成为工业标准,NVIDIA在该年发表的新款旗舰型Tesla运算加速卡 —— Tesla P100、AMD的Radeon RX Vega系列、Intel的Knight Landing也采用了HBM2。

存储器是存储指令和数据的计算机部件。有多种类型。中央处理器从存储器中取出指令,按指令的地址从存储器中读出数据,执行指令的操作。存储容量和存储器读写数据周期是存储器的两个基本技术的指标。

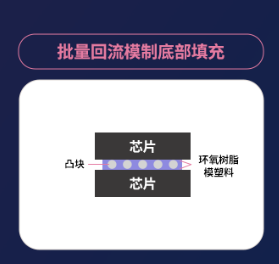

高带宽存储器是一种CPU/GPU 内存芯片(即 “RAM”),其实就是将很多个DDR芯片堆叠在一起后和GPU封装在一起,实现大容量,高位宽的DDR组合阵列。HBM 堆栈没有以物理方式与 CPU 或 GPU 集成,而是通过中介层紧凑而快速地连接,HBM 具备的特性几乎和芯片集成的 RAM一样,因此,具有更高速,更高带宽。

高带宽存储器发展

第一,早期,AI处理器架构的探讨源于学术界的半导体和体系架构领域,此时模型层数较少,计算规模较小,算力较低。

第二,模型逐渐加深,对算力需求相应增加,导致了带宽瓶颈,即IO问题,此时可通过增大片内缓存、优化调度模型来增加数据复用率等方式解决

第三,云端AI处理需求多用户、高吞吐、低延迟、高密度部署。计算单元剧增使IO瓶颈愈加严重,要解决需要付出较高代价(如增加DDR接口通道数量、片内缓存容量、多芯片互联)

此时,片上HBM(High Bandwidth Memory,高带宽存储器)的出现使AI/深度学习完全放到片上成为可能,集成度提升的同时,使带宽不再受制于芯片引脚的互联数量,从而在一定程度上解决了IO瓶颈。

-

存储器

+关注

关注

38文章

7550浏览量

164674 -

HBM

+关注

关注

0文章

392浏览量

14881

发布评论请先 登录

相关推荐

特斯拉或向SK海力士下1万亿韩元eSSD订单

三星预测HBM需求至2025年翻倍增长

SK海力士将开发性能高30倍HBM

SK海力士M16晶圆厂扩产,DRAM产能将增18%

2025年英伟达HBM市场采购比重将超70%

英伟达2025年计划发布Blackwell Ultra与B200A,或大幅提升HBM消耗量

DRAM与NAND市场迎高增长,2024年收入飙升

SK海力士与Amkor共同推动HBM与2.5D封装技术的融合应用

SK海力士加大1b DRAM产能以满足市场需求

SK海力士创新下一代HBM,融入计算与通信功能

SK海力士与台积电携手量产下一代HBM

消息称三星组建百人工程师团队

SK海力士签署先进芯片封装协议

受困于良率?三星否认HBM芯片生产采用MR-MUF工艺

HBM高带宽内存是什么

HBM高带宽内存是什么

评论